Inicio » Artículos publicados por Evaluación y Desarrollo (Página 9)

Archivo del Autor: Evaluación y Desarrollo

Ramas y campos de la Evaluación

En la extensión de esta cultura evaluadora, la práctica profesional de la evaluación ha dado lugar a numerosas ramas y campos. Algunas de estas ramas comienzan a tener ya una larga experiencia en el desarrollo de metodologías de evaluación y en su aplicación práctica. Scriven destaca siete de estas ramas (las siete grandes, Big Seven):

- Evaluación de productos, como los de consumo.

- Evaluación de rendimientos, como los exámenes a estudiantes.

- Evaluación de propuestas, para elegir la mejor alternativa entre las posibles.

- Evalaución de personal, para escoger los mejores candidatos para determinadas funciones.

- Evalaución de carteras.

- Evaluación de políticas.

- Evaluación de programas y proyectos, para analizar el impacto de las intervenciones, su aplicación y lógica de intervención.

En algunas de estas ramas se lleva trabajando en evaluación desde tiempos inmemoriales dando lugar a prácticas experimentadas y especialistas, luego a gremios, y ya en el siglo XX profesiones que dan lugar al actual campo profesional de la evaluación. Hay también muchas actividades pseudoevaluativas que, aunque con mucha tradición, carecen de requerimientos básicos como la validación de estándares. Es el caso de mucha de la crítica literaria y artística y otras áreas que no han caído en la cuenta de que la evaluación ha evolucionado independientemente de sus ramas de origen y tiene mucho que aportarles. Cada una de estas ramas comentadas se aplica en campos diversos desde la salud pública al trabajo social, pasando por la física o el campo de la cooperación al desarrollo. En cada uno de estos campos es más tradicional un tipo de evaluación u otra, siendo común en el campo del desarrollo y la cooperación la evaluación de carteras, políticas y programas, y también suele hablarse de evaluación de proyectos.

Referencias citadas:

Scriven, M. (2005b). Logic of evaluation. En: S. Mathison (Ed.), Encyclopedia of evaluation (pp. 235-238). Thousand Oaks: Sage Publications. Bajado de la red el 13 de Mayo de 2015 de http://www.sagepub.com/chambliss4e/study/chapter/encyc_pdfs/11.2_Logic%20of%20Evaluation.pdf

About Carlos Plaza

Seis dimensiones de evaluación

De acuerdo con Scriven (2007) existen cinco dimensiones de evaluación o aspectos susceptibles de ser evaluados: el proceso, los resultados, los costes, comparativas y generalizaciones, al que conviene añadir la lógica de intervención. En todas estas dimensiones es necesario estudiar los hechos acontecidos y combinarlos adecuadamente con los valores aplicables a cada situación para determinar el mérito, valor e importancia de esos hechos. Las dimensiones de la lógica de intervención, el proceso y los resultados son los que principalmente determinan el mérito derivado de las características intrínsecas de lo que evaluamos. El resto de dimensiones (costes, comparativas y generalizaciones) se definen en relación a valores específicos de gran importancia general que les da el nombre a estas dimensiones. Los costes y comparativas son especialmente relevantes a la hora de determinar el valor referencial a una moneda u otro referente que se considere adecuado, y las comparativas y generalizaciones son las que llevan el peso a la hora de determinar la importancia en relación al contexto y las personas que rodean lo que evaluamos.

En la evaluación de intervenciones de desarrollo no es necesario emplear siempre todas ellas, y en función de cada caso habrá que escoger las que resulten de mayor utilidad.

Lógica de intervención

Una dimensión importante es la evaluación de la lógica de intervención. Ésta se centra en analizar la visión, diseño y planificación realizada: su calidad, necesidad, pertinencia y coherencia con la realidad del territorio.

La lógica de una intervención explica cómo las actividades a implementar van a conducir a los resultados en el contexto de una intervención. Esta lógica ha de estar descrita en los documentos de planificación donde han de concretarse los objetivos esperados. Es importante tener en cuenta que se trata de una simplificación útil de la realidad y ser consciente de la complejidad del mundo real. Las explicaciones causales reales a menudo se revelan más complejas que los supuestos establecidos al inicio. No es bueno hacer depender la evaluación de la resolución del misterio de la causalidad, que no siempre es fácil y a veces absorbe un esfuerzo grande y de poca utilidad. Al reconstruir la lógica de intervención en el momento de la evaluación pueden tenerse en cuenta además otros resultados y factores externos que no fueron evocados en los documentos de planficación iniciales, pues además de la complejidad, con frecuencia la lógica de intervención evoluciona a través del tiempo.

Las representaciones más comunes de una lógica de intervención son:

- Marco lógico: Esta técnica consiste en producir una presentación en forma de matriz que especifique los objetivos (primera columna), cómo se los deberá verificar (segunda columna: indicadores, y tercera columna: fuentes) y los principales supuestos acerca de los factores externos (cuarta columna). Las líneas del marco lógico retoman una presentación simplificada de la lógica de intervención, en sólo cuatro líneas: actividades, resultados, finalidad y objetivo global. Esta representación es conveniente para una intervención simple sin excesiva complejidad.

- Diagrama de objetivos: Esta técnica funciona por medio de la identificación de los objetivos de una intervención y una presentación gráfica que muestre las cadenas lógicas entre objetivos, desde los más operativos hasta los más globales. La lógica de intervención está representada en forma de casillas y de flechas y es útil en los casos de intervenciones más complejas. Contrariamente al marco lógico, el diagrama puede tener cadenas de objetivos tan largas como sea necesario y representar sinergias y relaciones complejas entre objetivos. Una forma particular y sencilla de representación consiste en el árbol de objetivos que se aplica cuando cada objetivo de rango inferior contribuye a un solo objetivo de rango superior.

- Diagrama de resultados esperados: Esta técnica se asemeja al diagrama de objetivos ya que se apoya en los objetivos planificados para una intervención. Sin embargo, los objetivos se traducen en resultados esperados antes de ser presentados en un diagrama. La traducción de los objetivos en resultados esperados permite trabajar con conceptos más concretos y más fáciles de verificar.

Proceso

En unos casos las actividades de evaluación pueden centrarse en el estudio de los procesos de desarrollo, analizando la aplicación y gestión de la intervención, lo cual suele ser más interesante que el mero análisis de los resultados de cara a plantear mejoras. Hay una tendencia bastante extendida en el mundo de la evaluación de centrarse en los resultados e impactos, sin embargo poner énfasis en el estudio del proceso suele resultar de gran interés.

Se trata de evaluar el mérito, valor e importancia de todo lo que ocurre antes de darse los resultados (outcomes): la aplicación y gestión del programa, la fidelidad de la implementación al diseño de programación realizado (alineamiento), el seguimiento o monitoreo y el aprendizaje originado de su retroalimentación (errores subsanados, soluciones diseñadas). Se trata de examinar todas las actividades y procedimientos, los procesos generales de aprendizaje para lidiar con los cambios. Analizar las realizaciones más inmediatas y materiales (resultados inmediatos, outputs) antes de darse los verdaderos resultados e impactos.

Resultados

Muy communmente la evaluación puede centrarse en los resultados de la intervención mediante el análisis de sus diversos efectos: positivos y negativos, directos e indirectos, intencionales o no, y a corto (output), medio (outcome) y largo plazo (impact); efectos en los beneficiarios, en otras personas o en el medioambiente; efectos a nivel individual, organizacional o a nivel del capital social; efectos en las capacidades y potencial de las personas, que aunque no son necesariamente logros o productos observables, es importante tenerlos en cuenta.

En ocasiones es útil proporcionar explicaciones sobe el éxito o fracaso en relación a las decisiones tomadas, el contexto, las medidas…, identificar las claves del éxito de determinados programas o medidas. Y dado que los resultados más importantes puede ser que no sean intencionados ni anticipados, merece la pena distinguir entre efectos secundarios (side effects, que afectan a la población objetivo y a otros) e impactos secundarios (side impacts, impactos de cualquier tipo entre la población no objetivo del programa).

El mayor problema metodológico de la evaluación concerniente a esta dimensión está en establecer la conexión causal, especialmente cuando hay muchas posibles causas y posibles atribuciones de partes del efecto a cada de ellas. Otro problema es la frecuencia con la que las evaluaciones han de hacerse y terminarse antes de que los verdaderos resultados lleguen a darse, lo que hace que se dependa de predicciones basadas en pequeñas muestras y de las conjeturas y suposiciones que acompañan a estas siempre arriesgadas predicciones.

Costes

Muy relacionada con esta dimensión de resultados está la evaluación de costes donde se pueden analizar costes monetarios y no monetarios, directos e indirectos y costes actuales y de oportunidad. Esta dimensión es crucial a la hora de determinar el valor (worth).

Cuando sea posible estos costes han de ser pormenorizados por estados de desarrollo y periodos de calendario, tipos de coste en los que se ha incurrido (renta, equipamiento, personal…) y destinatarios de los pagos. Han de incluirse los costes no monetarios como son el espacio, el tiempo, la experiencia; así como los costes menos medibles como el estrés, capital personal o social (e.g. reputación o buena voluntad) o impactos medioambientales

Comparativas

En esta dimensión se compara la intervención evaluada con otras intervenciones con las que se buscan unos beneficios similares partiendo de recursos parecidos. Se entra aquí a la búsqueda de entidades que supongan formas alternativas para lograr beneficios iguales o similares con los mismos o menos recursos (competidores críticos). Merece la pena buscar y describir al menos una alternativa que es mucho más barata pero no mucho menos efectiva, y otra alternativa mucho más efectiva aunque más cara (siempre dentro de los límites de los recursos disponibles). A veces es útil comparar la intervención evaluada con un enfoque ampliamente extendido y admirado que sea percibido como alternativa (e.g. un icono local), o con una alternativa virtual factible en la teoría (competidor virtual) que pueda ser diseñado a partir de componentes existentes o fácilmente construidos. Esta última alternativa puede crear un conflicto de intereses al entrar el evaluador en un papel de planificador y poder perder objetividad a la hora de evaluar su propio diseño frente a la intervención evaluada.

En cualquier caso las comparativas con las alternativas que estén disponibles son a menudo esclarecedoras y algunas veces incluso esenciales. Suele ser tentador reunir en un mismo análisis las dimensiones de coste y comparativa en una comparativa de coste-eficacia pero es mejor mantener ambas dimensiones separadas por el interés de tener los resultados por separado. No todas las alternativas son comparables en costes y el coste no es muchas veces el elemento más importante de las comparativas.

Generalizaciones

Bajo esta dimensión la evaluación busca analizar hasta qué punto la intervención evaluada o alguno de sus componentes puede generalizarse en otras condiciones con resultados similares. Las generalizaciones pueden hacerse para otras situaciones (físicas, políticas, etc.), otro personal, otra escala territorial o temporal (ampliarla o también reducirla), otros beneficiarios, etc. Son las llamadas dimensiones de generalización y son importantes de cara a señalar el mérito e importancia del programa evaluado pues aquí se responde a si el programa puede usarse con éxito al aplicar cambios en estas dimensiones. Este tipo de planteamientos son típicamente usados a la hora de analizar si un programa aplicado a un pequeño grupo de beneficiarios podría tener éxito a una mayor escala. También se usan las generalizaciones en el tiempo para analizar la longevidad, durabilidad (ante condiciones adversas) o la sostenibilidad.

Para realizar este tipo de evaluación es necesario hacer predicciones sobre los resultados de una intervención en distintos escenarios. A pesar del riesgo de este tipo de predicciones, este tipo de evaluación es en ocasiones el que más potencial tiene para contribuir a la mejora de los programas. Muestra además que la evaluación no es siempre un ejercicio reactivo sino también creativo.

Referencias citadas:

Scriven, M. (2007). Key evaluation checklist. Retrieved May 12, 2015, from http://www.wmich.edu/evalctr/archive_checklists/kec_feb07.pdf

About Carlos Plaza

Principales aportes de la Evaluación que han motivado su expansión

La utilidad de la evaluación está en función de la corriente en la que nos posicionemos: ayudar a interpretar los resultados obtenidos con la aplicación de una determinada política, programa o proyecto (corriente de la teoría); obtener evidencias de que esa política, programa o proyecto funciona (corriente de las evidencias); o aprender y sacar lecciones de experiencia de su implementación (corriente del aprendizaje), si bien estas corrientes no son independientes y la mayoría de las veces la utilidad de una evaluación puede hallarse a caballo entre varios de estos beneficios.

La evaluación como fuente de valores

Como ya se ha mencionado, la evaluación consiste en llegar a un juicio sobre el mérito valor o importancia de unos hechos. Por ello el evaluador necesita un sistema de valores con el que aproximarse a la realidad que se debe juzgar, un sistema que el evaluador ha de descubrir y precisar su aplicación conjuntamente con los involucrados. De este modo, la evaluación se basa en teorías del valor que ayudan a juzgar los hechos; y en teorías de la práctica que aportan métodos y herramientas de evaluación.

No se trata solo de juzgar los resultados esperados y planificados sino también las consencuencias inesperadas de una intervención, pues los efectos secundarios son muchas veces importantes. También es importante fijarse no solo en el corto plazo sino pensar en el largo plazo y la sustentabilidad de los impactos logrados. Otros dos aspectos importantes a la hora de dirimir el juicio son los procesos por los que se consiguen los resultados (implementación ética) y los costes (que sean razonables). No se pueden juzgar los resultados con independiencia del proceso que los ha originado y los costes que han implicado.

La evaluación como fuente de evidencias para la toma de decisiones y sus implicaciones políticas

Una cuestión importante de la evaluación está en diferenciar lo que es bueno y aportar evidencias sobre lo que funciona y merece la pena seguir apoyando. Por ello todo trabajo de evaluación tiene implicaciones políticas en la manera de enfocar los temas, en la toma de decisiones, en la percepción de la intervención por la población y sobre todo, en los intereses que se toman en consideración. Es importante que los evaluadores comprendan la implicación de sus acciones y mantengan un diálogo continuo con todos los grupos de interés implicados.

Las evidencias aportadas por la evaluación permiten abrir un proceso de reflexión —tanto de lo que funciona como de lo que no—, y así mejorar las intervenciones y cumplir los objetivos planteados. De esta forma, la evaluación tiene un papel destacado en la toma de decisiones y en la justificación de las mismas, buscando metodologías adecuadas para comparar, elegir y descartar proyectos alternativos en un escenario de escasez de recursos. Se trata de justificar donde localizar los recursos que son siempre escasos.

En cualquier caso la evaluación está resultando clave para la transparencia política, la obligación de rendir cuentas con responsabilidad (accountability) de los gastos realizados y para la demostración de la eficacia de la gestión pública. La cuarta conferencia de la Sociedad Europea de evaluación, en octubre de 2000, trató sobre el papel de la evaluación en el mantenimiento de los sistemas democráticos, un tema que invitaba a pensar sobre el importante papel de esta disciplina hoy en día.

La evaluación como fuente de aprendizaje y capacitación

En las actividades de evaluación suelen distinguirse dos usos: el uso de los resultados —normalmente plasmados en un informe final de evaluación— y el uso del proceso, entendiéndose por éste todas las actividades de evaluación que llevan a obtener los resultados. En la evaluación de intervenciones en desarrollo es especialmente interesante el uso del proceso de evaluación, frente al uso exclusivo que muchas veces se hace de los resultados para demostrar que las inversiones funcionan. Un adecuado uso del proceso —mediante el fomento de la participación de los agentes— vincula el conocimiento y los resultados generados en la evaluación con procesos de adquisición de capacidades en la población. Estas capacidades permiten a la población servirse de las herramientas de la evaluación para gestionar su desarrollo, conducirlo en la línea de la mejora continua y obtener evidencias que sustenten la toma de decisiones. Además, también puede ayudar a superar la resistencia natural que, en ocasiones aparece ante el cambio. El uso del proceso es, en sí mismo, un impacto en forma de adquisición de capacidades.

En la evaluación del desarrollo, es bueno que además de la elaboración de un juicio, haya una preocupación seria por desencadenar procesos de aprendizaje ya que los resultados e informes finalizan, pero los aprendizajes y capacidades adquiridas por los implicados permanecen. Sin embargo no se puede olvidar la importancia del uso de los resultados. El reto para los evaluadores está en adaptar ambos usos a cada contexto concreto.

Planteamiento actual

Hay que reconocer que después de más de 50 años de asistencia internacional, han sido muchos los avances que se han dado en los enfoques, técnicas, procesos y resultados de evaluación. Hoy en día existen profesionales de evaluación en todas las regiones del mundo. Se ha creado una masa crítica de profesionales que está en capacidad de responder a la demanda creciente de estas actividades.

Además el S&E se está beneficiando de un intercambio general de experiencias, lecciones extraídas y técnicas innovadoras de análisis comparativo. Potenciados por las facilidades de comunicación electrónica, en casi todas las regiones del mundo se están constituyendo asociaciones de profesionales de la evaluación. Estas asociaciones a su vez están impulsando el intercambio de experiencias, escritos, publicaciones; y, están facilitando el establecimiento de alianzas estratégicas entre sus miembros.

Hasta ahora, la evaluación se había dado solamente en el ámbito técnico, con metodologías e instrumentos que dependían y tenían su origen en la esfera de la investigación científica. Hoy esto está cambiando y se está diferenciando más y más del control contable y la investigación. La evaluación está evolucionando y se propone hoy en día como instrumento de manejo ejecutivo en apoyo de la ejecución, evaluación de impactos y transparencia administrativa.

About Carlos Plaza

Glosario de términos técnicos de evaluación

Dentro del contexto de los planes y programas de desarrollo se encuentran frecuentemente problemas de vocabulario porque el S&E se ha efectuado en un contexto internacional e intersectorial, entre personas que no comparten la misma lengua materna ni las mismas referencias profesionales. Además, debido al reciente desarrollo de estas actividades, a muchos actores les es desconocido el vocabulario estándar que no está siempre estabilizado. Los problemas de comunicación resultantes pueden hacer perder tiempo y energía, e incluso comprometer la calidad o la utilidad de los trabajos.

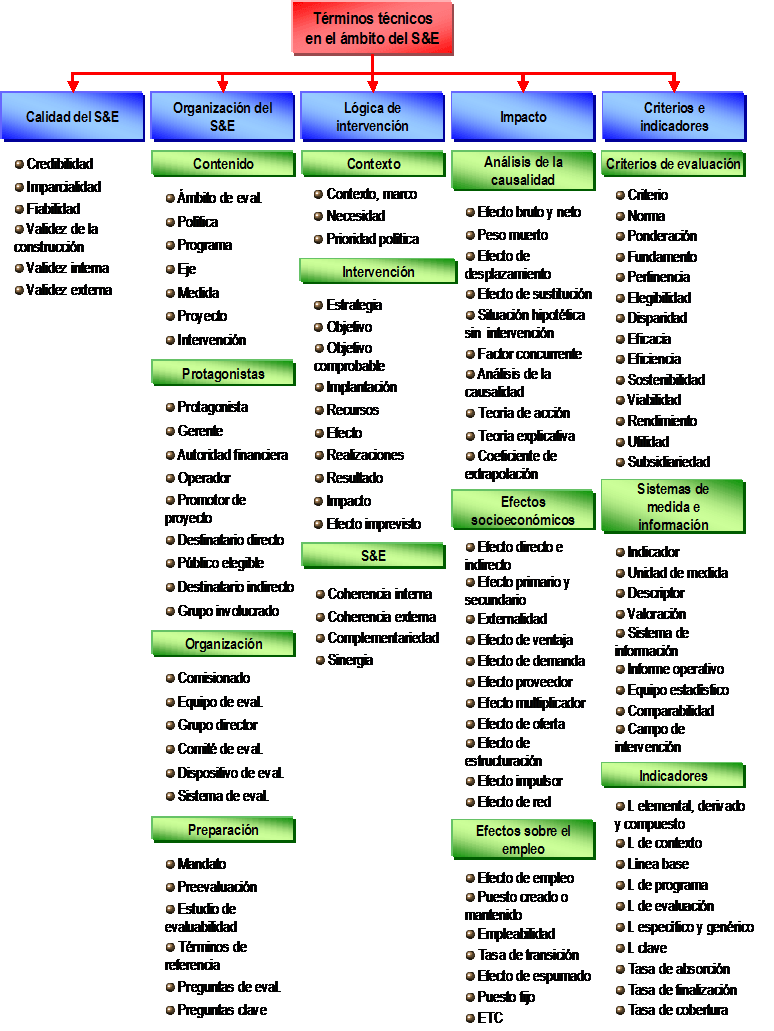

Términos técnicos en el ámbito del seguimiento y evaluación del desarrollo.

Fuente: Elaboración propia.

El propósito de este anexo es contribuir hacia la estabilización y clarificación del vocabulario – principalmente en los países de habla española – partiendo del glosario de términos elaborado en el tomo VI de la colección MEANS actualmente en inglés y francés . Los términos estudiados se refieren principalmente al S&E de un programa de desarrollo, pero también puede interesar a los lectores que dirijan o realicen evaluaciones temáticas o evaluaciones en profundidad en dominios más limitados. Es por ello por lo que el término ‘intervención’ es utilizado numerosas veces, en sentido genérico, para denotar cualquier objeto de seguimiento y evaluación.

About Carlos Plaza

La evaluación: origen y desarrollo de un nuevo campo profesional

Estudiar el comienzo de la evaluación es importante para comprender sus pilares fundamentales. Éstos tienden a perderse en el diseño de una evaluación concreta, en un momento determinado y con una serie de recursos.

La evaluación tiene su origen en la misma forma de ser del hombre, se asienta en la curiosidad humana y el deseo de hacer mejor las cosas. La evaluación nació cuando alguien preguntó: ¿cómo sabemos qué es bueno?, ¿cómo sabemos que lo que hemos hecho está bien y bajo qué criterios? Siempre hemos mirado el mundo con espíritu crítico y lo importante es hacer un uso constructivo de ese espíritu para mejorar el mundo en que vivimos.

Los comienzos de la evaluación y la pérdida del planteamiento inicial

Al estudiar el origen y evolución de la evaluación se pone de manifiesto que tratamos con una disciplina de muy reciente creación en la que todavía queda mucho por hacer. Aunque los seres humanos han tratado de resolver los problemas sociales usando razonamientos y pruebas desde hace siglos, la evaluación como medio de mejorar y asistir la calidad de los programas nació en la segunda mitad de la década de los 60.

Una lección aprendida de las importantes inversiones realizadas durante las décadas de los 60 y 70 es la imposibilidad de tener recursos para resolver todos los problemas y aprovechar todas las oportunidades. Es necesario priorizar las inversiones y para hacerlo eficazmente hace falta una base para decidir dónde y cómo invertir. Como no todo puede ser hecho, debe haber una base para decidir qué cosas merece la pena hacer.

En el caso de los Estados Unidos —que puede considerarse como el país con una tradición más rica y una institucionalización más temprana de las prácticas de evaluación en el seno de las administraciones públicas— la evaluación comenzó con los ambiciosos programas sociales financiados federalmente de la iniciativa Great Society en la segunda mitad de los años 60. Se hicieron grandes inversiones en estos programas pero los complejos problemas que se intentaban resolver con ellos no desaparecieron. Comenzaron los recelos y comenzó una creciente presión para que se demostrase la eficacia de las distintas intervenciones para proceder después al reparto de los limitados recursos.

Esta presión se ha extendido a todos los países donde se ha ido adoptando la evaluación, primeramente Canadá y norte de Europa y actualmente la influencia de esta presión se extiende globalmente como vía de asegurar la eficacia de las inversiones por parte de gobiernos y organismos financiadores.

De esta forma el objetivo inicial de la evaluación de mejorar los programas se ha ido transformando en demostrar que éstos funcionan, con el empobrecimiento que ello supone. A esta situación ha contribuido decisivamente, además de la presión mencionada, la influencia del método científico en la realización de la mayor parte de las evaluaciones. Este método se basa en una metodología hipotético-deductiva para la medición del impacto usando técnicas rigurosas de análisis estadístico. Quizá es adecuado para el análisis de la eficacia pero es muy limitado para ayudar a comprender el complejo mundo que vivimos actualmente.

Como resultado de ambos factores —el histórico crecimiento de la presión por demostrar la eficacia y el dominio de un modelo basado en la medición del cambio— muchas evaluaciones no han tratado temas tan importantes como el proceso, la implementación o mejora de los programas, y se han centrado en el impacto y la medición del cambio. Se apartan así otras cuestiones igual de importantes y se ponen en peligro enriquecedoras iniciativas participativas por no poder ser evaluadas dentro de este esquema.

En la actualidad, se está haciendo hincapié en la importancia de los procesos de evaluación (no solo los resultados), las metodologías participativas y contenidos de evaluación más allá del impacto. Sin embargo, es importante conocer la evolución de este campo profesional para conocer los peligros y presiones que influyen en ella y que siempre tienden a volver, y dar paso a sus inmensas posibilidades para mejorar la vida en nuestras sociedades.

Expansión de la cultura de la evaluación

Michael Quin Patton (1999) afirmó que la evaluación es una cultura. Entendiendo el término cultura como un sistema compartido de creencias, valores, normas, costumbres, comportamientos, conocimiento y lenguaje que los miembros de una sociedad usan para afrontar el mundo que les rodea y crear modos de pensar y comprenderse mutuamente. En este sentido, la evaluación es una cultura compartida por los evaluadores y todos aquellos que entran en contacto con su trabajo.

Esta cultura de la evaluación ha ido ganando un creciente reconocimiento (Díaz-Puente, Cazorla, and Dorrego, 2007) y una notable influencia a la hora de impulsar procesos de cambio (Kirkhart, 2000), promover nuevas capacidades y generar aprendizaje (Taut, 2007), así como mejorar la toma de decisión política.

Varios indicadores ilustran la progresiva adopción de la cultura evaluadora: el uso cada vez mayor de la evaluación para sustentar la toma de decisiones en políticas locales, nacionales o internacionales; el crecimiento exponencial de organizaciones profesionales de evaluación; y la creciente diversidad internacional de los asistentes a las conferencias que se organizan en todo el mundo sobre evaluación.

En relación al primer indicador es claro que en el campo de las políticas públicas la práctica de la evaluación se ha ido extendiendo enormemente y está ayudando a dar base científica a la toma de decisiones. Países pioneros en la adopción de esta cultura evaluadora fueron los países norteamericanos y del norte de Europa entre los años 60 y 70. De ahí se ha ido extendiendo enormemente al sur y centro de Europa y demás continentes: Australia, África, Asia y Latinoamérica. En esta expansión de la cultura de la evaluación han jugado un papel importante los principales organismos internacionales, especialmente en los países en vías de desarrollo. Organizaciones como el Banco Mundial o la OCDE han trabajado con numerosos gobiernos de estos países para lograr el reconocimiento y aplicación de la evaluación. En estas organizaciones los componentes de seguimiento y evaluación se han ido proporcionando desde que a mediados del decenio de 1970 se prestó atención especial al desarrollo rural y al alivio de la pobreza.

Otro indicador claro del crecimiento de la cultura de la evaluación es el crecimiento exponencial de las asociaciones y redes de evaluación en éstos últimos años. Comenzando su creación en Canadá (en 1981 se creó la Canadian Evaluation Society, CES) y los Estados Unidos (en 1986 se creó la American Evaluation Association, AEA), actualmente existen alrededor de unas 100 organizaciones nacionales y regionales de evaluación en todo el mundo. Muchas de ellas organizan conferencias y eventos que ayudan al intercambio de experiencias y a seguir extendiendo la cultura de la evaluación a nivel internacional.

Esta internacionalización ha sido acompañada de esfuerzos para construir una comunidad evaluadora a nivel global con el objetivo de compartir experiencias y ayudarse mutuamente. Un importante hito aquí fue el lanzamiento de la Asociación Internacional para la Evaluación del Desarrollo (International Development Evaluation Association, IDEAS) en el 2002 y la Organización Internacional para la Cooperación en Evaluación (International Organization for Cooperation in Evaluation, IOCE) in 2003. La asociación IDEAS proporciona cooperación profesional entre los evaluadores que trabajan en el campo del desarrollo y la organización IOCE proporciona cooperación entre las organizaciones de evaluación nacionales y regionales que existen en el mundo, además de fomentar la demanda de evaluación y apoyar la organización de las diferentes asociaciones que la componen.

Referencias citadas:

Díaz-Puente, J.M., A. Cazorla, A. Dorrego. (2007). Crossing National, Continental, and Linguistic Boundaries: Toward a Worldwide Evaluation Research Community in Journals of Evaluation. American Journal of Evaluation, 28 (4), 399-415.

Kirkhart, K. (2000). Reconceptualizing evaluation use: An integrated theory of influence. In The expanding scope of evaluation use, New Directions for Evaluation, Vol. 88, edited by V. Caracelli and H. Preskill, 5-24. San Francisco, CA: Jossey-Bass.

Patton, M. Q. (1999). Utilization- Focused Evaluation in Africa: Evaluation Training Lectures delivered to the Inaugural Conference of the African Evaluation Association. Ed. P.N. Chaiban and M. Patel.

Taut, S. (2007). Studying self-evaluation capacity building in a large international development organization. American Journal of Evaluation 28 (1): 45-59.

About Carlos Plaza

La expansión de la cultura de la evaluación en las políticas públicas

La Administración Pública, en su modelo más tradicional, no estaba concebida para organizarse como un sistema de prestación de servicios eficaz y eficiente, sino que su criterio fundamental de actuación consistía, inicialmente, en velar por el cumplimiento del principio de legalidad. Por ello, sus mecanismos de control se focalizaban, en mayor medida, hacia la conformidad administrativa de sus actuaciones.

En este orden de cosas, se pueden constatar ritmos diferenciados en el desarrollo, institucionalización e innovación en la evaluación de políticas y programas públicos. Tras la implantación de la evaluación en los EE.UU., en el resto de países se han venido apreciando ritmos diversos y un proceso de institucionalización acorde a su tradición y a su propio modelo de Administración Pública.

EE.UU. se ha caracterizado desde los años 60 por una constante innovación metodológica y un elevado nivel de institucionalización de la evaluación de las políticas y los programas públicos. El éxito de la implementación en el Departamento de Defensa del Sistema de Presupuestación y Gestión por Programas (Programing, Planning And Budgeting System), uno de cuyos componentes esenciales era la evaluación previa de la eficacia y eficiencia de programas alternativos, llevó a extender su implantación a todas las agencias del gobierno federal.

La definitiva institucionalización de la evaluación en EE.UU. se produce con la creación de las unidades de evaluación de las oficinas federales y la promulgación de leyes que requerían a la Oficina General de Cuentas (General Accounting Office, GAO) la realización de análisis de la eficacia de los programas públicos. En el ámbito del desarrollo e innovación metodológica, se creó en 1980 un instituto propio de evaluación dentro de la GAO denominado División de Evaluación de Programas y Metodología.

De esta forma, a lo largo de las tres últimas décadas, la evaluación de programas en ámbitos de actuación pública tan cruciales como la educación o la salud ha sido una referencia clave en el marco de los debates públicos en EE.UU., generando información valiosa tanto para los detractores de la intervención pública como para los partidarios de la misma.

Saliendo del caso norteamericano, en los demás países desarrollados la adopción de prácticas evaluativas está también directamente vinculada a la introducción de reformas presupuestarias y al desarrollo de las políticas de bienestar y cohesión social, planes sanitarios, educativos, etc. o más recientemente en el caso específico europeo, por el desarrollo de la Administración Comunitaria. En los países menos desarrollados esta adopción normalmente ha venido ligada a la participación en programas financiados por organizaciones internacionales como la ONU, el Banco Mundial o la FAO.

En estos países en desarrollo todavía falta poner en valor las actividades de evaluación, lo que impide la utilización eficiente de los escasos recursos públicos y dificulta la rendición de cuentas. Los gobiernos de estos países han de proporcionar apoyo político y económico al desarrollo de sistemas de evaluación nacionales que permitan crear y consolidar capacidades para la evaluación de programas y proyectos, a nivel regional y local. En este sentido pueden coordinar esfuerzos con los organismos internacionales, que han sido activos promotores de la evaluación y el monitoreo.

Oleadas de expansión

La evaluación se ha extendido internacionalmente de una manera sorprendente en las últimas décadas llevando consigo grandes oportunidades y retos. Hace una década el alemán Hans-Ullrich Derlien describió el desarrollo de la evaluación en las políticas públicas de los países occidentales industrializados. En su estudio comparativo, Derlien (1990) identificó una serie de factores para caracterizar un conjunto de países que constituían lo que llamó la primera expansión (first wave). Países que fueron pioneros en la adopción de la evaluación en los años 70: Estados Unidos, Canadá, Suecia, Alemania y Reino Unido. Un segundo conjunto de países europeos constituían la segunda expansión (second wave) en los años 80: Dinamarca, Holanda, Noruega y Suiza.

Desde que se realizó este estudio se ha producido una extensión sin precedentes de la cultura de la evaluación en las políticas públicas. En el seno europeo a países con menor tradición evaluadora del sur y centro de Europa, y en el resto del mundo, en Australia, Rusia y países de la antigua URSS, África, Asia y países de Latinoamérica. Para satisfacer estos crecientes requerimientos el número de consultorías o equipos universitarios dedicados a la evaluación se ha multiplicado en todos los países.

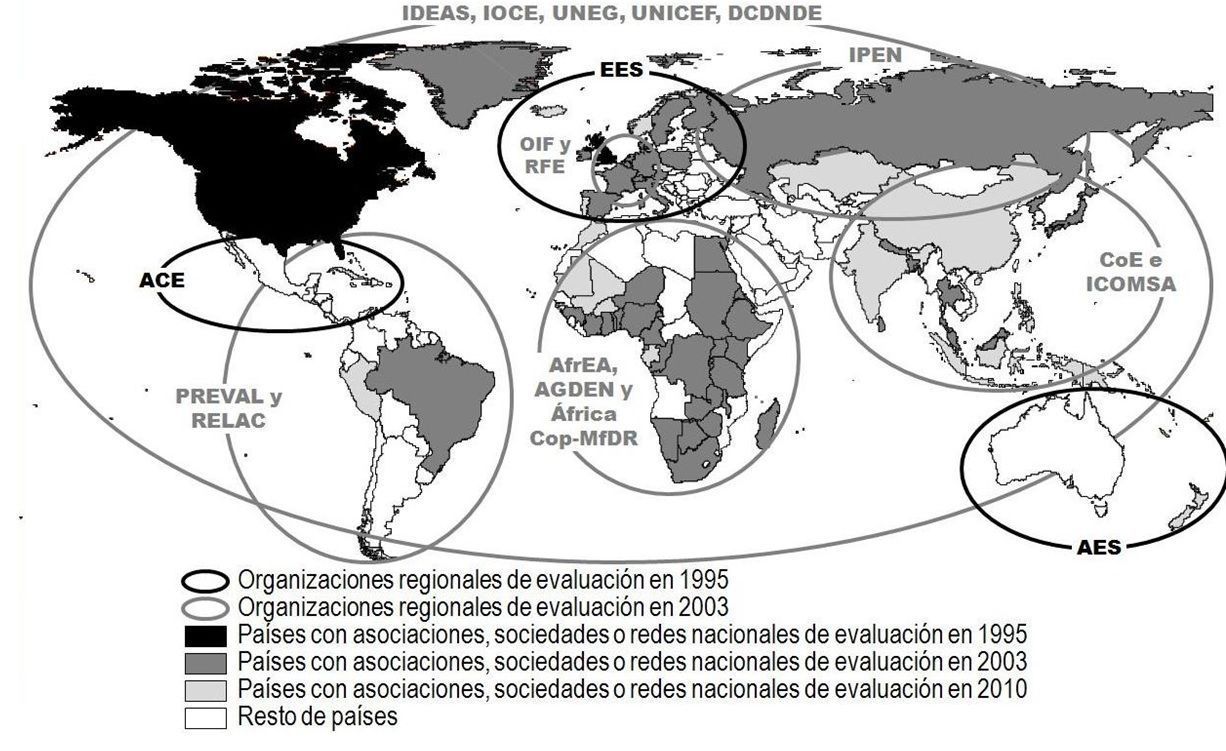

Expansión de la cultura de la evaluación en las políticas públicas.

La importante contribución de los principales organismos internacionales

Los principales organismos internacionales establecieron sus primeros departamentos y unidades de evaluación en los años 60 del siglo XX. Sin embargo, no es hasta los primeros años 80 cuando empiezan a diseñarse sistemas eficaces de seguimiento y evaluación. Es entonces cuando varios organismos internacionales reaccionan ante la dificultad de seguir y evaluar sus intervenciones y elaboran los primeros manuales y principios guía.

Entre esos organismos pioneros figuraron el Banco Mundial, el Fondo Internacional de Desarrollo Agrícola (FIDA) y la Organización de las Naciones Unidas para la Agricultura y la Alimentación (FAO). Desafortunadamente, no hubo acuerdo acerca del uso de palabras técnicas ni con respecto a distinciones entre las funciones de seguimiento y evaluación y la prioridad apropiada para cada una.

Desde entonces se ha hecho un gran acopio de pruebas documentales y se han llevado adelante con prontitud discusiones acerca de los conceptos apropiados y de las metodologías recomendadas. Dentro del sistema de las Naciones Unidas esas discusiones se han sostenido en el foro del Panel de Seguimiento y Evaluación establecido en 1981 por el Grupo de Estudio sobre Desarrollo Rural del Comité Administrativo de Coordinación (CAC) de las Naciones Unidas. En 1984 ese Grupo de Estudio publicó el Guiding Principles (U.N., 1984) donde se reflejaba el progreso logrado hacia un consenso sobre conceptos, definiciones y métodos.

Desde 1980 se ha conseguido avanzar en cuanto a establecer y poner en práctica sistemas eficaces de seguimiento y evaluación. En una encuesta realizada por el Banco Mundial en 1990, se calificó de adecuados, por lo menos, tres cuartos de los sistemas de seguimiento. Sin embargo, incluso en lo que se refiere a esos sistemas satisfactorios, se encontró que el ámbito del seguimiento era limitado, ya que cubría la información física y financiera, pero era deficiente a menudo en la información sobre la vinculación vital del programa con los beneficiarios a los que pretendía llegar.

En lo que concierne a los sistemas de evaluación la encuesta reveló que los deseos en cuanto a medir el efecto de un programa en un lapso limitado de años seguían siendo elevadas y universales, pero esos deseos no eran igualados por los logros de los estudios de los efectos de los programas. Casi ningún estudio había proporcionado una base firme de datos, y menos aún permitía hacer un análisis que satisficiera las elevadas expectaciones de los diseñadores. En general, no se conocían suficientemente las limitaciones de la metodología de evaluación ni se conocía la necesidad de que los diseñadores, directores y evaluadores de programas adaptasen técnicas adecuadas.

Actualmente los organismos internacionales consideran prioritario el desarrollo de capacidades para evaluar y seguir programas, un elemento clave para fortalecer la gestión de los programas, medir sus resultados e impacto, extraer lecciones de experiencia y rendir cuentas. Entre los organismos más activos a la hora de apoyar el desarrollo de sistemas de evaluación y seguimiento en los países en desarrollo han estado el Banco Mundial, la FAO y el UNDP (United Nations Development Program, el Programa de Naciones Unidas para el Desarrollo).

La acumulación cada vez mayor de experiencia y el creciente consenso con respecto a conceptos y metodologías indujo a estas organizaciones a extender la cultura de la evaluación principalmente en los países en vías de desarrollo. Esta labor ha sido muy amplia a través de la imposición de requisitos de evaluación de los proyectos financiados por estas organizaciones en Latinoamérica, África y sudeste asiático. Destacan algunos hechos como:

- La organización por parte del Banco Interamericano de Desarrollo y el Fondo Internacional de Desarrollo Agrícola (FIDA) del primer Seminario de Evaluación de Centroamérica, Panamá y República Dominicana, que tuvo lugar en San José, Costa Rica, en 1994. Dando lugar a una de las primeras asociaciones de evaluación: la Asociación Centroamericana de Evaluación (ACE).

- El auspicio por parte de Naciones Unidas (a través del FIDA) de PREVAL en 1996, un programa para el fortalecimiento de la capacidad regional de seguimiento y evaluación en América Latina y el Caribe (Programme for Strengthening the Regional Capacity for Evaluation of Rural Poverty Alleviation Projects in Latin America and the Caribbean). El PREVAL I se estableció para el periodo 1996-1999, tuvo su continuación en el PREVAL II (2000-2004), III (2004-2007) y que hoy continúa como Plataforma Regional de Desarrollo de Capacidades en Evaluación y Sistematización de América Latina y el Caribe.

- La creación por la Oficina Regional del Este y Sur de África de UNICEF (ESARO) de una red informal de evaluación que ha dado lugar a la Asociación Africana de Evaluación (AfrEA) en 1999, que a su vez ha servido de impulso para la creación de numerosas asociaciones y redes nacionales de evaluación en el continente africano. En el ámbito latinoamericano cabe mencionar también el papel crucial de la Oficina de Evaluación de UNICEF en el establecimiento y funcionamiento de redes regionales como la Red Latinoamericana de Evaluación (ReLAC).

- La colaboración entre el PNUD y el Banco Mundial para la creación de una Asociación Internacional para la evaluación del desarrollo (IDEAS: International Development Evaluation Association). Una red de profesionales de la evaluación enfocada a las necesidades de los evaluadores en los países en vías de desarrollo y con especial sensibilidad por el desarrollo de capacidades de evaluación.

Referencias citadas:

Derlien, H.-U. (1990). Genesis and structure of evaluation efforts in comparative perspective. R.C. Rist, Program evaluation and the management of government. London: Transaction Publishers.

U.N. (1984). Guiding principles for the design and use of monitoring and evaluation in rural development projects and programmes. ACC Task Force on Rural Development. Panel on monitoring and evaluation. United Nations. Roma.

About Carlos Plaza

El incremento de las asociaciones y redes de evaluación

Un indicador claro del crecimiento de la cultura de la evaluación en el contexto internacional es el crecimiento exponencial de las asociaciones y redes de evaluación en estos últimos años. Actualmente existen más de 100 organizaciones nacionales y regionales de evaluación y se está consolidando la creación de una comunidad internacional de evaluación.

Parte del trabajo de estas asociaciones consiste en el desarrollo de estándares, valores y principios que guíen la evaluación, y en la orientación a sus miembros en la definición de estos valores. También existen asociaciones que no tienen este objetivo y se centran más en la difusión de la cultura de la evaluación y en el desarrollo de capacidades, prácticas y métodos. Las directrices desarrolladas por las sociedades de evaluación no tienen carácter normativo, más bien son recomendaciones de distintos profesionales sobre lo que la evaluación debe aportar a la sociedad, respetando a la población con la que se trabaja.

En 1975 se inició en Estados Unidos un proyecto pionero para el desarrollo de estándares profesionales para la evaluación de programas (Joint Committee on Standards for Educational Evaluation). Su objetivo era mejorar la evaluación de los programas de formación. Se constituyó un comité compuesto por 16 asociaciones profesionales entre las que se encontraba la Sociedad Americana de Evaluación. El resultado fue el Programa de Estándares de Evaluación (Programme Evaluation Standards, PES), una lista de control de la calidad de los trabajos de evaluación, formada por 30 criterios reunidos en cuatro categorías: utilidad, factibilidad, honorabilidad y precisión; que son los cuatros grupos de estándares exigibles a una evaluación.

En 1989, el PES fue aprobado por el American National Standards Institute, y actualmente se emplea en la mayor parte de las evaluaciones. En algunas zonas con marcadas diferencias culturales (como Asia o África) existen grupos de trabajo para adaptar el PES a sus propios contextos. Organismos donantes han empleado también el PES para comprobar la calidad de las evaluaciones de proyectos implementados en los países en desarrollo.

Mapa de la evolución de las organizaciones regionales y nacionales de evaluación.

Mapa de la evolución de las organizaciones regionales y nacionales de evaluación.

Desde la fundación de la Canadian Evaluation Society (CES) en 1981 y la American Evaluation Association (AEA) en 1986, el ritmo de nuevas fundaciones se ha ido incrementando progresivamente. En 1995 había 6 organizaciones regionales y nacionales de evaluación ; en 1998 pasaron a ser 12 y en 1999 eran ya más de 20 (contando no solo asociaciones sino también nuevas formas de organización como redes y foros). Desde 2003 hasta la actualidad el número de asociaciones regionales de evaluación se ha mantenido constante, si bien el número de organizaciones nacionales ha crecido muy significativamente, pasando de 20 en 2003 a más de 100 en la actualidad.

La Sociedad Europea de Evaluación SEE (European Evaluation Society, EES), se fundó en 1994. Desde entonces ha tenido un papel fundamental en la promoción y creación de las diversas sociedades nacionales que existen en la práctica totalidad de los países europeos . Únicamente la United Kingdom Evaluation Society existía antes de la creación de la Sociedad Europea de Evaluación.

En 1999, se creó la Asociación Africana de Evaluación (African Evaluation Association, AfrEA) como una red informal de evaluación bajo el auspicio de UNICEF. Posteriormente varios países africanos se propusieron crear sus propias asociaciones o redes nacionales de evaluación. El número de asociaciones pasó de 6 en 1999 a 16 en el 2001, y llega a 44 en la actualidad. Además, existen redes de profesionales de evaluación en 27 países, aunque algunas de ellas están todavía en periodo de formación. Otros trece países más participan (sin sociedades propias de evaluación) en las actividades de la AfrEA. También cabe destacar que África es el continente con mayor número de organizaciones regionales de evaluación con un total de cuatro : African Evaluation Association (AfrEA), Africa Gender and Development Evaluation Network (AGDEN), African Community of Practice on Managing for Development Results (AfricaCop-MfDR) y Monitoring and Evaluation East Africa Network (Mandeea).

En el área asiática, las primeras asociaciones en establecerse fueron las de Israel en 1998, Malasia en 1999 y Sri Lanka también en 1999. En 2003 surgieron tres nuevas asociaciones y dos foros, y en la actualidad, la evaluación se ha extendido a 23 países asiáticos, algunos de ellos de especial relevancia como China o India. También se ha avanzado en la creación de asociaciones formales de evaluación en países en los que solo existían foros o redes .

En Oceanía tenemos la Australasian Evaluation Society (AES) y en el 2000 se creó la International Program Evaluation Network (IPEN) que incluye a nueve antiguos países de la URSS: Armenia, Azerbaiján, Bielorrusia, Georgia, Kazajstán, Kyrgyzstan, Rusia, Tayikistán, Ucrania.

En Latinoamérica, al igual que en África, las organizaciones internacionales han tenido un papel destacado en la creación de asociaciones de evaluación. Los dos elementos más importantes en este sentido han sido la creación de la Asociación Centroamericana de Evaluación (ACE) en 1994, y PREVAL en 1996, una plataforma para el fortalecimiento de las capacidades de evaluación en el ámbito de los proyectos para el alivio de la pobreza de zonas rurales de América Latina y el Caribe, ambas bajo los auspicios del Fondo Internacional de Desarrollo Agrícola (FIDA).

En la actualidad, el apoyo de organismos internacionales, ha posibilitado la creación en Latinoamérica de más sociedades de evaluación. En los últimos años se han creado asociaciones de ámbito, tanto regional ─como la Red de Seguimiento, Evaluación y Sistematización en América Latina y el Caribe (RELAC)─ como nacional ─la Agencia Brasileña de Evaluación, la Asociación Brasileña para la Evaluación de la Educación, la Red Cubana de Evaluación o la Red Peruana para el Monitoreo y la Evaluación─.

About Carlos Plaza

La internacionalización de la evaluación

La construcción de una comunidad internacional de evaluación supone una gran oportunidad para todos de aprender de los demás y llegar más lejos en la profesión de la evaluación. En esta línea, en noviembre de 1995 las sociedades canadiense y americana de evaluación promovieron una conferencia en Vancouver, British Columbia, en colaboración con las otras tres grandes sociedades existentes en esa fecha en Centroamérica, Australasia y Europa. El tema de la conferencia fue: La evaluación para un nuevo siglo. Una perspectiva global. Fue la primera conferencia realmente internacional con 1600 evaluadores de 65 países de los cinco continentes y supuso un momento decisivo para la historia de la evaluación y la creación de una comunidad internacional de evaluación.

En 1997, la Sociedad Europea de Evaluación (EES) organizó una conferencia en Estocolmo. De entre los 280 profesionales de 30 países que asistieron a la conferencia surgieron los objetivos de aumentar los afiliados de la sociedad y extender las redes profesionales de trabajo (Furubo, 1997).

Por otro lado, también en 1997, una discusión sobre el carácter internacional de la evaluación tuvo lugar en EVALTALK, una lista de discusión (listserv) de la Sociedad Americana de Evaluación (AEA). Uno de los temas discutidos fue la creación de una federación de organizaciones nacionales de evaluación. Poco después, el International & Cross-Cultural Topical Interest Group (I&CCE TIG)[1] invitó a los presidentes de nueve organizaciones nacionales y regionales de evaluación para debatir las ventajas de esta futura federación durante la conferencia de la AEA de 1998. En esta conferencia se discutieron varias ideas y posiciones respecto del desarrollo de un foro internacional para la cooperación entre las organizaciones de evaluación. Como seguimiento, se reunieron nuevamente durante la conferencia de la AEA de Orlando, Florida, en 1999.

Una donación otorgada por la W.K. Kellogg Foundation permitió a los presidentes o representantes de 15 asociaciones nacionales y regionales de evaluación que sostuvieran una reunión en Barbados, Indias Occidentales, en febrero del 2000. Asistieron como observadores la W.K. Kellog Foundation, la Universidad de Indias Occidentales, el Banco de Desarrollo del Caribe y el Capital Development Fund de Naciones Unidas. Esta reunión produjo una propuesta para una Organización Internacional para la Cooperación en Evaluación OICE (IOCE por sus siglas en inglés: International Organization for Cooperation in Evaluation), la que fue circulada en la lista de discusión EVALPRES para los presidentes de organizaciones de evaluación y endosada formalmente por los participantes en la reunión de Barbados. Los principios y acuerdos registrados en dicho documento se consideraron como no negociables y como la plataforma para la planificación de la asamblea inaugural de la IOCE. En marzo del 2002 tuvo lugar una reunión en la República Dominicana como continuación a la de Barbados, donde se realizó el planeamiento explícito para una Asamblea Inaugural de la IOCE en marzo de 2003 en Lima.

La IOCE quedó así constituida como una organización flexible formada por entidades de evaluación nacionales y regionales que actúa a nivel mundial, dedicada al fortalecimiento del liderazgo y la capacidad de evaluación en países en desarrollo, al fomento de la interrelación entre teoría y práctica de la evaluación por todo el mundo así como a potenciar la evaluación como profesión, con la finalidad de disponer de una visión global en un intento de contribuir a la identificación y propuesta de soluciones en la problemática del desarrollo en el mundo.

La creación de esta organización internacional y las discusiones tenidas a través de EVALPRES termina de confirmar la importancia de internet en la internacionalización de la evaluación, permitiendo trabajar en red y contar con la participación desde distintos puntos del planeta. A través de internet se ha ido fomentando el discurso sobre la construcción de una comunidad internacional de evaluación y se ha ido contando con el apoyo de las asociaciones de evaluación. La web de la AEA ha servido de soporte en todo el proceso.

A día de hoy, internet es también la herramienta más utilizada por los evaluadores a la hora de adquirir, compartir y enseñar sus conocimientos. Y así los evaluadores dedicados a determinados temas están constituyendo redes que les permita realizar un efectivo intercambio profesional. Es el caso de la International Development Evaluation Association (IDEAS) una iniciativa surgida en 2001 donde el PNUD y el Banco Mundial se unieron para crear una red internacional de profesionales con especial preocupación por las necesidades de los evaluadores en los países en vías de desarrollo. El PNUD y el Banco Mundial en colaboración con el UK Departament for International Development (DFID) patrocinaron una reunión en mayo del 2001 en Londres que culminó con la llamada London Declaration on the Stablishment of IDEAS con cinco principios básicos: estará enfocada al desarrollo de la capacidad de evaluación, pluralidad, subsidiariedad, peso dominante de los países en vías de desarrollo en su gobierno y eficiencia.

Actualmente existen numerosas asociaciones internacionales, algunas de ellas especializadas en intervenciones de desarrollo rural: Network of Networks on Impact Evaluation (NONIE), Active Learning Networkfor Accountability and Performance in Humanitarian Action (ALNAP), International Organization for Collaborative Outcome Management (IOCOM), Evaluation Cooperation Group (ECGnet), DAC Network on Development Evaluation (OECD/DAC EvalNet), United Nations Evaluation Group (UNEG) y UNICEF. Otras están especializadas en evaluaciones de impacto ambiental: Climate-Eval (GEF) and Environmental Evaluators Network (EEN).

Además, la IOCE junto con UNICEF y otras organizaciones más, pusieron en marcha una asociación innovadora, EvalPartners, para mejorar las capacidades de las organizaciones voluntarias para la evaluación profesional (VOPEs del inglés Voluntary Organizations for Professional Evaluation), un término que agrupa todo tipo de grupos interesados en hacer avanzar la profesión de la evaluación, grupos de la sociedad civil que pueden funcionar a niveles regionales o nacionales y que reúnen evaluadores de diversos campos. El objetivo es influir en los responsables políticos, en la opinión pública y en otros actores para que las políticas públicas, basándose en la evidencias, tomen decisiones equitativas y eficaces.

Destacar también como hito la Tercera Conferencia Internacional sobre la capacidad nacional de evaluación organizada en São Paulo (Brasil) en septiembre de 2013, donde se designó el año 2015 como el Año Internacional de Evaluación. Una de las razones por las cuales se designó este año fue que los Objetivos del Milenio serían reemplazados por un nuevo conjunto de objetivos acordados a nivel internacional llamados Objetivos de Desarrollo Sostenible. La agenda del año internacional de la evaluación se puede encontrar en http://mymande.org/evalyear/evaluationtorch2015, un conjunto de eventos donde los temas elegidos para su discusión fueron:

- La identificación de las prioridades clave de la comunidad de evaluación global para poner en marcha el Programa de Evaluación Global 2016-2020.

- El cierre de la brecha entre la comunidad de evaluación (oferta) y la comunidad de políticos (demanda), para asegurar una buena calidad, igualdad y la evaluación con perspectiva de género.

- La incorporación de las evaluaciones centradas en la igualdad y perspectiva de género en los Objetivos de Desarrollo Sostenible a nivel internacional, y en las estrategias nacionales de desarrollo a nivel nacional.

- El desarrollo centrado en la igualdad de género en políticas de evaluación nacional.

La antorcha de la evaluación del Evalyear fue encendida en el edificio de la ONU en Nueva York en diciembre de 2014 con el objetivo de viajar por todo el mundo a través de 28 países y terminar en el Foro Global EvalPartners donde culminar la celebración del Año Internacional de Evaluación y lanzar las siguientes iniciativas:

- Celebración el Año Internacional de Evaluación en un parlamento nacional.

- Lanzamiento de la Agenda Global de Evaluación 2016-2020.

- Lanzamiento del Foro Mundial de Parlamentarios para la evaluación.

- Lanzamiento de la EvalGender+ , la alianza mundial para las evaluaciones centradas en la igualdad y perspectiva de género.

- Lanzamiento de la EvalYouth, la alianza mundial para evaluadores jóvenes.

About Carlos Plaza

Desarrollo de la Evaluación en Europa

La década de 1990 estuvo marcada en Europa por el inicio de una nueva política regional con una fuerte dimensión comunitaria. A medida que las diversas autoridades de la Unión Europea (UE) comenzaron a aumentar su poder, influenciaron cada vez más el desarrollo y la difusión de la cultura de la evaluación entre los estados miembros. Esto fue particularmente el caso en las naciones meridionales y centrales de la UE con menor tradición evaluadora. Los Fondos Estructurales Europeos ─los principales instrumentos para apoyar el desarrollo socio-económico en toda la UE─ eran de gran importancia durante este período. Ellos representan más de un tercio del presupuesto de la UE (aproximadamente 110 millones de euros) y casi la mitad de todos los proyectos de evaluación de la UE. La reforma legislativa de los Fondos Estructurales en 1988 introdujo la evaluación. La evaluación no estaba ausente antes de 1988, pero esta reforma la hizo obligatoria para todos los programas que buscan el apoyo de los Fondos Estructurales. Esto llevó a la institucionalización de la evaluación, en particular en los países del sur y centro de la UE.

Los esfuerzos de la Comisión Europea, a través de las distintas direcciones generales, contribuyeron en gran medida a esta difusión. Desde 1995, la Comisión ha organizado una conferencia bianual sobre las técnicas y prácticas para la evaluación de los programas financiados por los Fondos Estructurales. También comenzó a publicar directivas metodologícas de evaluación, que eran específicos para cada programa en muchos casos. En 1994, la Comisión puso en marcha su programa llamado “Medios para la evaluación de acciones de carácter estructural” (Means for Evaluating Actions of a Structural Nature (MEANS)) para apoyar a los Estados Miembros en sus actividades de evaluación. El enfoque pragmático de este programa buscaba fomentar el desarrollo de un enfoque de evaluación coherente, a escala europea y uniforme mediante la recopilación de los métodos más comúnmente utilizados en los Estados miembros, y a través de la difusión de buenas prácticas. Esta línea de trabajo, por lo tanto, trató de aprovechar y adaptar los enfoques que ya se estaban utilizando.

Esta cultura de la evaluación se enmarca así dentro de las obligaciones del Tratado de la Unión Europea y la regulación financiera, que exigen que la Comisión de la UE contemple los principios para una buena gestión. En función de estas obligaciones, la Comisión de la UE identificó como una prioridad, en el marco del programa SEM 2000 (Sound and Efficient Management) la evaluación sistemática, puntual y rigurosa de los programas.

En muchos Estados miembros, apenas se realizaban evaluaciones finales antes de la reforma de los Fondos Estructurales de 1988. La principal excepción era el Reino Unido y, en menor medida, los países nórdicos, los Países Bajos, Alemania e Irlanda. La acumulación de conocimientos y experiencia en este área y la cultura ligada a ellos es un proceso a largo plazo, pero en todos los Estados miembros se han detectado considerables mejoras. Podemos distinguir distintas etapas en el estudio de la evaluación en Europa.

- Años 70: Desde los años setenta se han llevado a cabo evaluaciones de algunas políticas regionales nacionales, sobretodo en Reino Unido, países nórdicos, Países Bajos, Alemania e Irlanda. Se trataba de evaluaciones que seguían modelos económicos y cuantitativos para valorar el impacto de los programas. Supusieron un relativo fracaso de unos enfoques cuantitativos sofisticados en exceso y de difícil implantación.

- Años 80: Los estudios de evaluación siguen mostrando gran preocupación por los términos económicos. Aunque comienzan a realizarse los primeros estudios a niveles locales y regionales de beneficiarios y grupos de interés, fracasa el análisis de los diferentes contextos políticos, así como el tener en cuenta otros efectos que no fuesen los económicos. Comienza el desarrollo de enfoques alternativos de evaluación como el participativo en países como Reino Unido, Noruega y Suecia. Pero su definitiva difusión no se produce hasta la década de los 90.

- Años 90: Esta etapa está marcada por el comienzo de una nueva política regional con una fuerte dimensión comunitaria. La reforma de 1988 impuso obligatoriamente las evaluaciones y las introdujo de manera sistemática y generalizada. Se produce un desarrollo considerable de las actividades de seguimiento y evaluación, especialmente en los países y regiones menos desarrollados, mediante un incremento de la profesionalización, desarrollo de metodologías y capacidades y un aumento de la institucionalización de estas actividades.

- Siglo XX: Se constituye el seguimiento y evaluación (S&E) como herramienta fundamental de la gestión en el período 2000-2006, donde la normativa comunitaria referida al S&E sufre cambios importantes produciéndose un refuerzo y una mayor precisión de obligaciones, responsabilidades y objetivos. Esta etapa se caracteriza por la capacidad de obtener información y la creación de asociaciones internacionales que han dado una perspectiva global al mundo de la evaluación. Internet ha sido la herramienta que ha facilitado que todo evaluador pueda adquirir con los conocimientos necesarios para su profesión.

About Carlos Plaza

Principales corrientes de Evaluación: El aprendizaje, la teoría y las pruebas

La conferencia de la Sociedad Europea de Evaluación celebrada del 10 al 12 de octubre del 2002 tuvo como título: Corrientes de evaluación en la actualidad: Aprendizaje, teoría y pruebas (Learning, theory and evidence). Una reflexión sobre las principales corrientes existentes a la hora de abordar la evaluación: la evaluación basada en la teoría, la evaluación basada en las pruebas y la evaluación basada en el aprendizaje.

El aprendizaje es considerado sin duda como un objetivo global de la evaluación. Es necesario aprender de la evaluación. En un mundo donde el Estado ya no intenta ocuparse de todo, sino que a menudo se asocia con la sociedad civil, el aprendizaje a través de la evaluación deja de ser el coto privado de las autoridades políticas. Las comunidades, las asociaciones y los ciudadanos también se sirven de la evaluación para aprender y mejorar. Procedente de los campos de la gestión del conocimiento y del aprendizaje organizacional, está surgiendo con fuerza un movimiento que está redefiniendo el aprendizaje para convertirlo en una corriente dominante de la evaluación actual. Los evaluadores se interesan cada vez más por atesorar lo que hemos aprendido para que no se pierdan los frutos de las evaluaciones pasadas y que haya acceso a ellos y puedan recuperarse cuando se necesiten más adelante.

La evaluación basada en la teoría explora y trata de comprender el cómo y el porqué de los éxitos y fracasos de un programa. Intenta examinar las condiciones de implementación de un programa, así como los mecanismos que vinculan los procesos y los resultados. Esta corriente ha tenido un largo pasado (Chen & Rossi, 1983; Chen, 1990; Coryn et al., 2011; Rogers, 2007; Weiss, 1972a; 1972b, 1995; 1997a; 1997b), y recibió nuevos impulsos tras el surgimiento de escuelas realistas y la teoría del cambio, y a merced de la naturaleza retadora de las políticas públicas contemporáneas. Estas políticas a menudo se han plasmado en programas complejos que, al ser evaluados, no siempre ofrecen resultados claros. Si se desea sacar una conclusión general a partir de los resultados de la evaluación, debemos interpretar con cautela los datos obtenidos dentro de un marco teórico dado.

La corriente basada en las pruebas se ha convertido en un tópico en ciertos países europeos y se ha difundido con gran rapidez. Nace del deseo de los responsables políticos de obtener los mejores resultados a partir de los escasos recursos públicos disponibles. Éstos se preguntan ¿qué pruebas hay de que esto funciona? . Los defensores de la evaluación basada en las pruebas abogan a favor del rigor y de normas estrictas a la hora de proceder al análisis de todas las pruebas, sea cual sea la modalidad y el método empleados para obtenerlas. Muestras de esta corriente a nivel internacional ha sido la creación de organizaciones como la Cochrane Collaboration y la Campbell Collaboration.

- La Cochrane Collaboration es una organización sin ánimo de lucro creada para preparar, mantener y promocionar la accesibilidad de las evaluaciones de los efectos de las intervenciones en el campo de la atención sanitaria. Facilitar el acceso a pruebas de lo que realmente funciona en este campo ante la enorme cantidad de información existente.

- La misión de la organización Campbell Collaboration es la de preparar, mantener y diseminar las evaluaciones sistemáticas de los efectos sociales de la mayor parte de las actuaciones públicas. Recopilar pruebas de lo que realmente funciona en estos campos y ayudar así a la toma de decisiones en base a pruebas de calidad.

Obviamente, en el mundo real, estas corrientes no son autónomas. Muchos son los que argumentan que es la evaluación basada en la teoría la que genera las pruebas más convincentes, y que son las pruebas apropiadas las que hacen que las esferas políticas y la sociedad civil aprendan de verdad. Para los especialistas de la evaluación actualmente existen muchos enfoques alternativos, métodos y herramientas que veremos más adelante.

Referencias citadas:

Chen, H. T. (1990). Theory driven evaluations. Sage Publications. Newbury Park. California.

Chen, H. T. & Rossi, P. (1983). Evaluating with sense: the theory-driven approach. Evaluation Review 7(3): 283-302.

Coryn, C. L. S., Noakes, L. A., Westine, C. D., & Schro¨ter, D. C. (2011). A systematic review of theory-driven evaluation practice From 1990 to 2009. American Journal of Evaluation, 32, 199–225.

Rogers, P.J. (2007). Theory-based evaluation: Reflections ten years on. In S. Mathison (Ed.), Enduring issues in evaluation: The 20th anniversary of the collaboration between NDE and AEA (pp. 63-67). New Directions for Evaluation, No. 114. San Francisco, CA: Jossey-Bass.

Weiss, C. H. (1972a). Evaluating Action Programs: Readings in Social Action and Education. Allyn & Bacon. Boston.

Weiss, C. H. (1972b). Evaluation Research: Methods for Assessing Program Effectiveness. Prentice-Hall. Englewood Cliffs. New Jersey.

Weiss, C.H. (1995). Nothing as practical as good theory: Exploring theory-based evaluation for comprehensive community initiatives for children and families. In J. Connell, A. Kubisch, L. B. Schorr, & C. H. Weiss (Eds.), New approaches to evaluating community initiatives: Volume 1, concepts, methods, and contexts (pp. 65-92). New York, NY: Aspen Institute.

Weiss, C. H. (1997a). How can theory-based evaluation make greater headway? Evaluation Review 21(4): 501-524.

Weiss, C.H (1997b). Theory-based evaluation: Past, present and future. In D. J. Rog & D. Fournier (Eds.), Progress and future directions in evaluation: Perspectives on theory, practice and methods (pp. 55-41). New Directions for Evaluation, No. 76. San Francisco, CA: Jossey-Bass.