Inicio » Entradas etiquetadas como «evaluación» (Página 5)

Archivos de la etiqueta: evaluación

Estándares de evaluación

Un proyecto pionero para el desarrollo de estándares profesionales para la evaluación de programas fue iniciado en Estados Unidos en 1975. Su objetivo era el de mejorar la evaluación de la educación y programas de formación. Se estableció un comité compuesto por 16 asociaciones profesionales de la educación, la Sociedad Americana de Evaluación (American Evaluation Association o AEA) y la Asociación Americana de Psicología. El resultado fue un conjunto de 30 criterios, el Programme Evaluation Standards (PES) organizados en torno a cuatro principios principales: utilidad, viabilidad, propiedad y precisión. Se describen a continuación estos principios que actualmente sirven de guía para asegurar la calidad de las actividades de evaluación.

Utilidad (Utilitity)

Como punto de partida es preciso destacar la utilidad de la evaluación, en la que ha de buscarse un uso concreto para agentes concretos. El resultado de una evaluación no puede considerarse satisfactorio si se limita únicamente a la exposición de los resultados alcanzados sin contribuir a que dicha exposición redunde en una mejora del desempeño general de las funciones propias de los actores involucrados en el objeto a evaluar. Por ello la metodología a emplear procurará hacer un uso adecuado del proceso de evaluación, así como de los resultados de evaluación (Patton, 1998; 2008). El objetivo es que la evaluación ayude a las personas o grupos interesados a: (1) tener acceso a las informaciones que necesitan para el desempeño de su actividad, (2) identificar los defectos y virtudes de lo evaluado y, (3) proponer soluciones a fin de mejorar el objeto que se evalúa. Este aspecto de utilidad comprende identificar las personas afectadas por la evaluación para poder dar respuesta a sus necesidades; dar credibilidad a los resultados para que tengan una máxima aceptación; seleccionar la información que permita responder a cuestiones pertinentes; describir cuidadosamente los enfoques, procedimientos y fundamentos utilizados para interpretar los resultados de modo que queden claras las bases de los juicios de valor; proporcionar información esencial y que se entienda fácilmente; y divulgar los resultados significativos y los informes de evaluación de manera que puedan utilizarse en el momento oportuno.

Unidos a este principio principal están otros principios como la credibilidad, claridad, puntualidad, diseminación de resultados, y la identificación de necesidades y valores.

Viabilidad (Feasibility)

Los procedimientos para llevar a cabo la evaluación no deben ser excesivamente complicados y sí eficientes. Han de garantizar que la evaluación se lleve a cabo de un modo realista, prudente y diplomático, que se hayan ponderado todos los puntos y tenido en cuenta los costes. Este aspecto de viabilidad comprende diseñar procedimientos prácticos de evaluación que permitan reducir al mínimo las interrupciones y molestias mientras que se obtiene la información necesaria; anticiparse a las diferentes posiciones de los diversos grupos de interés, de manera que pueda lograrse su cooperación y puedan evitarse o contrarrestarse los posibles intentos de cualquiera de estos grupos para limitar las actividades de evaluación o para sesgar o usar indebidamente los resultados; y producir informaciones con el suficiente valor, de modo que puedan justificarse los recursos empleados. Este principio comprende así fundamentalmente la viabilidad en términos políticos, prácticos y de coste-eficacia.

Propiedad (Propriety)

La evaluación debe estar basada en compromisos explícitos que aseguren la necesaria cooperación, la protección de los derechos de las partes implicadas y la honradez de los resultados, además debe proporcionar un informe equilibrado que ponga de manifiesto tanto aciertos como errores del objeto que se evalúa. Este aspecto de propiedad comprende diseñar la evaluación para ayudar a las organizaciones a atender y responder con eficacia a las necesidades de toda la variedad de participantes destinatarios; acordar las obligaciones de las partes formales de una evaluación (qué debe hacerse, cómo, por parte de quién, cuándo); diseñar la evaluación respetando y protegiendo los derechos y el bienestar de las personas; realizar una evaluación completa y justa; asegurar que los resultados de la evaluación resulten accesibles a personas afectadas por la evaluación; y llevar a cabo el gasto de recursos mediante procedimientos de rendición de cuentas acertadas y de un modo éticamente responsable. Bajo este principio por tanto, la evaluación ha de conducirse legalmente, éticamente y bajo la consideración de aquellas personas involucradas en la evaluación así como los afectados por sus resultados.

Precisión (Accuracy)

El objeto, su evolución y su contexto deben estar claramente descritos. Han de garantizar que la evaluación presente y transmita las informaciones técnicas adecuadas referentes al programa objeto de evaluación, resaltando tanto los aspectos positivos como negativos. Este aspecto de precisión comprende describir y documentar con claridad y precisión el programa evaluado y su contexto, así como los propósitos y procedimientos de la evaluación; describir las fuentes de información utilizadas en la evaluación de un programa, de modo que pueda valorarse la adecuación de la información; elegir e implementar procedimientos de recogida de información válidos y fiables; procesar y revisar sistemáticamente la información recogida; analizar de modo apropiado y sistemático tanto la información cuantitativa como cualitativa, de modo que se responda eficazmente a las preguntas de evaluación; justificar las conclusiones a las que se llegue de modo que los interesados puedan valorarlas; y elaborar informes imparciales.

Unidos a este principio están otros como la adecuación técnica, el análisis del contexto, el uso de fuentes de información defendibles e información válida y confiable, llegar a conclusiones justifidas y la imparcialidad.

Un principio extra: la flexibilidad

En muchas ocasiones el objeto a evaluar se encuentra indisolublemente unido a la acción de las personas y evolución en el tiempo. Esto implica un grado de incertidumbre a la hora de acometer la evaluación, en función del comportamiento de los individuos, grupos, y el conjunto de las instituciones y organizaciones en respuesta a cada nuevo paso que se da. Por consiguiente uno de los requisitos que se deben tener en cuenta es el grado de flexibilidad para adaptar la evaluación a la receptividad de los actores y a sus dinámicas internas. En el caso de los proyectos de desarrollo el camino elegido para la ejecución de una intervención es un elemento determinante de su calidad, puesto que es el propio proceso de desarrollo apoyado o impulsado el objetivo principal de la intervención. Esta visión, que pone el énfasis en la calidad del proceso de desarrollo como base para su sostenibilidad, más que en los resultados directos y a corto plazo, exige poner la atención de la evaluación en los procesos que se ponen en marcha a través de cada proyecto y los aprendizajes que genera.

Referencias citadas:

Patton, M. Q. (1998). Discovering process use. Evaluation, 4(2), 225-233.

Patton, M. Q. (2008). Utilization-Focused Evaluation (4ª Ed.). Thousand Oaks: Sage Publications.

About Carlos Plaza

Ramas y campos de la Evaluación

En la extensión de esta cultura evaluadora, la práctica profesional de la evaluación ha dado lugar a numerosas ramas y campos. Algunas de estas ramas comienzan a tener ya una larga experiencia en el desarrollo de metodologías de evaluación y en su aplicación práctica. Scriven destaca siete de estas ramas (las siete grandes, Big Seven):

- Evaluación de productos, como los de consumo.

- Evaluación de rendimientos, como los exámenes a estudiantes.

- Evaluación de propuestas, para elegir la mejor alternativa entre las posibles.

- Evalaución de personal, para escoger los mejores candidatos para determinadas funciones.

- Evalaución de carteras.

- Evaluación de políticas.

- Evaluación de programas y proyectos, para analizar el impacto de las intervenciones, su aplicación y lógica de intervención.

En algunas de estas ramas se lleva trabajando en evaluación desde tiempos inmemoriales dando lugar a prácticas experimentadas y especialistas, luego a gremios, y ya en el siglo XX profesiones que dan lugar al actual campo profesional de la evaluación. Hay también muchas actividades pseudoevaluativas que, aunque con mucha tradición, carecen de requerimientos básicos como la validación de estándares. Es el caso de mucha de la crítica literaria y artística y otras áreas que no han caído en la cuenta de que la evaluación ha evolucionado independientemente de sus ramas de origen y tiene mucho que aportarles. Cada una de estas ramas comentadas se aplica en campos diversos desde la salud pública al trabajo social, pasando por la física o el campo de la cooperación al desarrollo. En cada uno de estos campos es más tradicional un tipo de evaluación u otra, siendo común en el campo del desarrollo y la cooperación la evaluación de carteras, políticas y programas, y también suele hablarse de evaluación de proyectos.

Referencias citadas:

Scriven, M. (2005b). Logic of evaluation. En: S. Mathison (Ed.), Encyclopedia of evaluation (pp. 235-238). Thousand Oaks: Sage Publications. Bajado de la red el 13 de Mayo de 2015 de http://www.sagepub.com/chambliss4e/study/chapter/encyc_pdfs/11.2_Logic%20of%20Evaluation.pdf

About Carlos Plaza

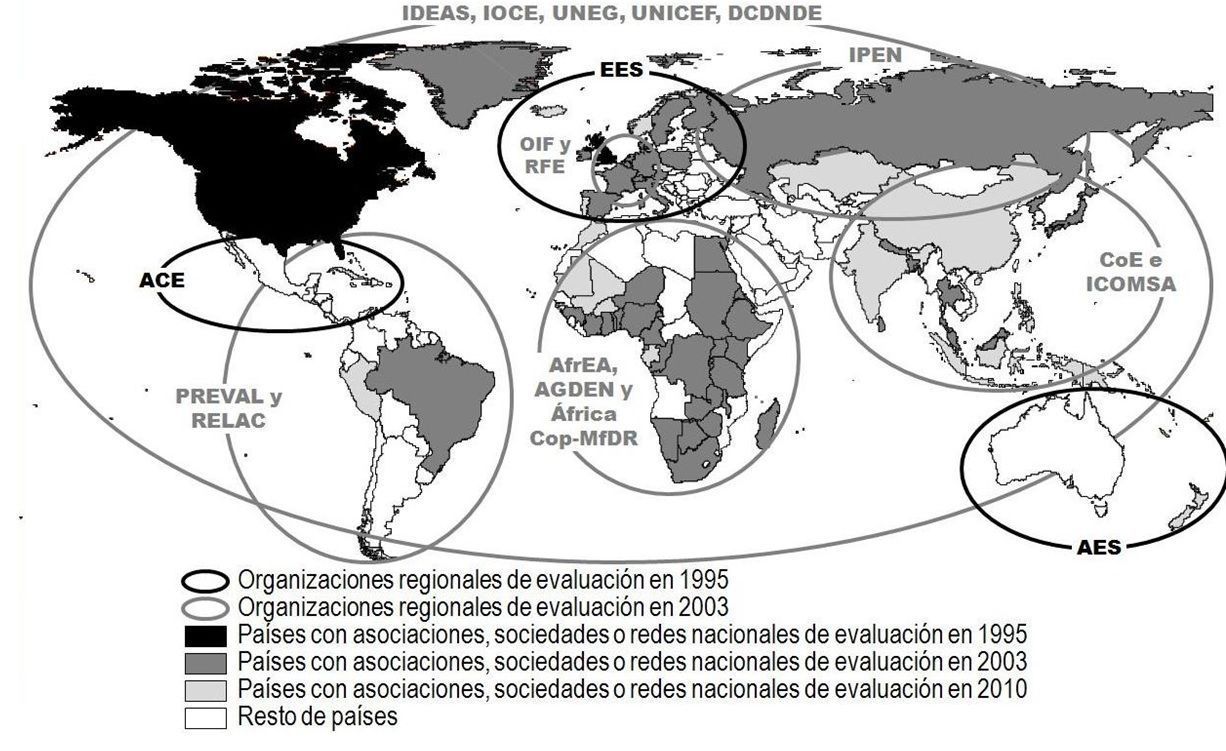

El incremento de las asociaciones y redes de evaluación

Un indicador claro del crecimiento de la cultura de la evaluación en el contexto internacional es el crecimiento exponencial de las asociaciones y redes de evaluación en estos últimos años. Actualmente existen más de 100 organizaciones nacionales y regionales de evaluación y se está consolidando la creación de una comunidad internacional de evaluación.

Parte del trabajo de estas asociaciones consiste en el desarrollo de estándares, valores y principios que guíen la evaluación, y en la orientación a sus miembros en la definición de estos valores. También existen asociaciones que no tienen este objetivo y se centran más en la difusión de la cultura de la evaluación y en el desarrollo de capacidades, prácticas y métodos. Las directrices desarrolladas por las sociedades de evaluación no tienen carácter normativo, más bien son recomendaciones de distintos profesionales sobre lo que la evaluación debe aportar a la sociedad, respetando a la población con la que se trabaja.

En 1975 se inició en Estados Unidos un proyecto pionero para el desarrollo de estándares profesionales para la evaluación de programas (Joint Committee on Standards for Educational Evaluation). Su objetivo era mejorar la evaluación de los programas de formación. Se constituyó un comité compuesto por 16 asociaciones profesionales entre las que se encontraba la Sociedad Americana de Evaluación. El resultado fue el Programa de Estándares de Evaluación (Programme Evaluation Standards, PES), una lista de control de la calidad de los trabajos de evaluación, formada por 30 criterios reunidos en cuatro categorías: utilidad, factibilidad, honorabilidad y precisión; que son los cuatros grupos de estándares exigibles a una evaluación.

En 1989, el PES fue aprobado por el American National Standards Institute, y actualmente se emplea en la mayor parte de las evaluaciones. En algunas zonas con marcadas diferencias culturales (como Asia o África) existen grupos de trabajo para adaptar el PES a sus propios contextos. Organismos donantes han empleado también el PES para comprobar la calidad de las evaluaciones de proyectos implementados en los países en desarrollo.

Mapa de la evolución de las organizaciones regionales y nacionales de evaluación.

Mapa de la evolución de las organizaciones regionales y nacionales de evaluación.

Desde la fundación de la Canadian Evaluation Society (CES) en 1981 y la American Evaluation Association (AEA) en 1986, el ritmo de nuevas fundaciones se ha ido incrementando progresivamente. En 1995 había 6 organizaciones regionales y nacionales de evaluación ; en 1998 pasaron a ser 12 y en 1999 eran ya más de 20 (contando no solo asociaciones sino también nuevas formas de organización como redes y foros). Desde 2003 hasta la actualidad el número de asociaciones regionales de evaluación se ha mantenido constante, si bien el número de organizaciones nacionales ha crecido muy significativamente, pasando de 20 en 2003 a más de 100 en la actualidad.

La Sociedad Europea de Evaluación SEE (European Evaluation Society, EES), se fundó en 1994. Desde entonces ha tenido un papel fundamental en la promoción y creación de las diversas sociedades nacionales que existen en la práctica totalidad de los países europeos . Únicamente la United Kingdom Evaluation Society existía antes de la creación de la Sociedad Europea de Evaluación.

En 1999, se creó la Asociación Africana de Evaluación (African Evaluation Association, AfrEA) como una red informal de evaluación bajo el auspicio de UNICEF. Posteriormente varios países africanos se propusieron crear sus propias asociaciones o redes nacionales de evaluación. El número de asociaciones pasó de 6 en 1999 a 16 en el 2001, y llega a 44 en la actualidad. Además, existen redes de profesionales de evaluación en 27 países, aunque algunas de ellas están todavía en periodo de formación. Otros trece países más participan (sin sociedades propias de evaluación) en las actividades de la AfrEA. También cabe destacar que África es el continente con mayor número de organizaciones regionales de evaluación con un total de cuatro : African Evaluation Association (AfrEA), Africa Gender and Development Evaluation Network (AGDEN), African Community of Practice on Managing for Development Results (AfricaCop-MfDR) y Monitoring and Evaluation East Africa Network (Mandeea).

En el área asiática, las primeras asociaciones en establecerse fueron las de Israel en 1998, Malasia en 1999 y Sri Lanka también en 1999. En 2003 surgieron tres nuevas asociaciones y dos foros, y en la actualidad, la evaluación se ha extendido a 23 países asiáticos, algunos de ellos de especial relevancia como China o India. También se ha avanzado en la creación de asociaciones formales de evaluación en países en los que solo existían foros o redes .

En Oceanía tenemos la Australasian Evaluation Society (AES) y en el 2000 se creó la International Program Evaluation Network (IPEN) que incluye a nueve antiguos países de la URSS: Armenia, Azerbaiján, Bielorrusia, Georgia, Kazajstán, Kyrgyzstan, Rusia, Tayikistán, Ucrania.

En Latinoamérica, al igual que en África, las organizaciones internacionales han tenido un papel destacado en la creación de asociaciones de evaluación. Los dos elementos más importantes en este sentido han sido la creación de la Asociación Centroamericana de Evaluación (ACE) en 1994, y PREVAL en 1996, una plataforma para el fortalecimiento de las capacidades de evaluación en el ámbito de los proyectos para el alivio de la pobreza de zonas rurales de América Latina y el Caribe, ambas bajo los auspicios del Fondo Internacional de Desarrollo Agrícola (FIDA).

En la actualidad, el apoyo de organismos internacionales, ha posibilitado la creación en Latinoamérica de más sociedades de evaluación. En los últimos años se han creado asociaciones de ámbito, tanto regional ─como la Red de Seguimiento, Evaluación y Sistematización en América Latina y el Caribe (RELAC)─ como nacional ─la Agencia Brasileña de Evaluación, la Asociación Brasileña para la Evaluación de la Educación, la Red Cubana de Evaluación o la Red Peruana para el Monitoreo y la Evaluación─.

About Carlos Plaza

La internacionalización de la evaluación

La construcción de una comunidad internacional de evaluación supone una gran oportunidad para todos de aprender de los demás y llegar más lejos en la profesión de la evaluación. En esta línea, en noviembre de 1995 las sociedades canadiense y americana de evaluación promovieron una conferencia en Vancouver, British Columbia, en colaboración con las otras tres grandes sociedades existentes en esa fecha en Centroamérica, Australasia y Europa. El tema de la conferencia fue: La evaluación para un nuevo siglo. Una perspectiva global. Fue la primera conferencia realmente internacional con 1600 evaluadores de 65 países de los cinco continentes y supuso un momento decisivo para la historia de la evaluación y la creación de una comunidad internacional de evaluación.

En 1997, la Sociedad Europea de Evaluación (EES) organizó una conferencia en Estocolmo. De entre los 280 profesionales de 30 países que asistieron a la conferencia surgieron los objetivos de aumentar los afiliados de la sociedad y extender las redes profesionales de trabajo (Furubo, 1997).

Por otro lado, también en 1997, una discusión sobre el carácter internacional de la evaluación tuvo lugar en EVALTALK, una lista de discusión (listserv) de la Sociedad Americana de Evaluación (AEA). Uno de los temas discutidos fue la creación de una federación de organizaciones nacionales de evaluación. Poco después, el International & Cross-Cultural Topical Interest Group (I&CCE TIG)[1] invitó a los presidentes de nueve organizaciones nacionales y regionales de evaluación para debatir las ventajas de esta futura federación durante la conferencia de la AEA de 1998. En esta conferencia se discutieron varias ideas y posiciones respecto del desarrollo de un foro internacional para la cooperación entre las organizaciones de evaluación. Como seguimiento, se reunieron nuevamente durante la conferencia de la AEA de Orlando, Florida, en 1999.

Una donación otorgada por la W.K. Kellogg Foundation permitió a los presidentes o representantes de 15 asociaciones nacionales y regionales de evaluación que sostuvieran una reunión en Barbados, Indias Occidentales, en febrero del 2000. Asistieron como observadores la W.K. Kellog Foundation, la Universidad de Indias Occidentales, el Banco de Desarrollo del Caribe y el Capital Development Fund de Naciones Unidas. Esta reunión produjo una propuesta para una Organización Internacional para la Cooperación en Evaluación OICE (IOCE por sus siglas en inglés: International Organization for Cooperation in Evaluation), la que fue circulada en la lista de discusión EVALPRES para los presidentes de organizaciones de evaluación y endosada formalmente por los participantes en la reunión de Barbados. Los principios y acuerdos registrados en dicho documento se consideraron como no negociables y como la plataforma para la planificación de la asamblea inaugural de la IOCE. En marzo del 2002 tuvo lugar una reunión en la República Dominicana como continuación a la de Barbados, donde se realizó el planeamiento explícito para una Asamblea Inaugural de la IOCE en marzo de 2003 en Lima.

La IOCE quedó así constituida como una organización flexible formada por entidades de evaluación nacionales y regionales que actúa a nivel mundial, dedicada al fortalecimiento del liderazgo y la capacidad de evaluación en países en desarrollo, al fomento de la interrelación entre teoría y práctica de la evaluación por todo el mundo así como a potenciar la evaluación como profesión, con la finalidad de disponer de una visión global en un intento de contribuir a la identificación y propuesta de soluciones en la problemática del desarrollo en el mundo.

La creación de esta organización internacional y las discusiones tenidas a través de EVALPRES termina de confirmar la importancia de internet en la internacionalización de la evaluación, permitiendo trabajar en red y contar con la participación desde distintos puntos del planeta. A través de internet se ha ido fomentando el discurso sobre la construcción de una comunidad internacional de evaluación y se ha ido contando con el apoyo de las asociaciones de evaluación. La web de la AEA ha servido de soporte en todo el proceso.

A día de hoy, internet es también la herramienta más utilizada por los evaluadores a la hora de adquirir, compartir y enseñar sus conocimientos. Y así los evaluadores dedicados a determinados temas están constituyendo redes que les permita realizar un efectivo intercambio profesional. Es el caso de la International Development Evaluation Association (IDEAS) una iniciativa surgida en 2001 donde el PNUD y el Banco Mundial se unieron para crear una red internacional de profesionales con especial preocupación por las necesidades de los evaluadores en los países en vías de desarrollo. El PNUD y el Banco Mundial en colaboración con el UK Departament for International Development (DFID) patrocinaron una reunión en mayo del 2001 en Londres que culminó con la llamada London Declaration on the Stablishment of IDEAS con cinco principios básicos: estará enfocada al desarrollo de la capacidad de evaluación, pluralidad, subsidiariedad, peso dominante de los países en vías de desarrollo en su gobierno y eficiencia.

Actualmente existen numerosas asociaciones internacionales, algunas de ellas especializadas en intervenciones de desarrollo rural: Network of Networks on Impact Evaluation (NONIE), Active Learning Networkfor Accountability and Performance in Humanitarian Action (ALNAP), International Organization for Collaborative Outcome Management (IOCOM), Evaluation Cooperation Group (ECGnet), DAC Network on Development Evaluation (OECD/DAC EvalNet), United Nations Evaluation Group (UNEG) y UNICEF. Otras están especializadas en evaluaciones de impacto ambiental: Climate-Eval (GEF) and Environmental Evaluators Network (EEN).

Además, la IOCE junto con UNICEF y otras organizaciones más, pusieron en marcha una asociación innovadora, EvalPartners, para mejorar las capacidades de las organizaciones voluntarias para la evaluación profesional (VOPEs del inglés Voluntary Organizations for Professional Evaluation), un término que agrupa todo tipo de grupos interesados en hacer avanzar la profesión de la evaluación, grupos de la sociedad civil que pueden funcionar a niveles regionales o nacionales y que reúnen evaluadores de diversos campos. El objetivo es influir en los responsables políticos, en la opinión pública y en otros actores para que las políticas públicas, basándose en la evidencias, tomen decisiones equitativas y eficaces.

Destacar también como hito la Tercera Conferencia Internacional sobre la capacidad nacional de evaluación organizada en São Paulo (Brasil) en septiembre de 2013, donde se designó el año 2015 como el Año Internacional de Evaluación. Una de las razones por las cuales se designó este año fue que los Objetivos del Milenio serían reemplazados por un nuevo conjunto de objetivos acordados a nivel internacional llamados Objetivos de Desarrollo Sostenible. La agenda del año internacional de la evaluación se puede encontrar en http://mymande.org/evalyear/evaluationtorch2015, un conjunto de eventos donde los temas elegidos para su discusión fueron:

- La identificación de las prioridades clave de la comunidad de evaluación global para poner en marcha el Programa de Evaluación Global 2016-2020.

- El cierre de la brecha entre la comunidad de evaluación (oferta) y la comunidad de políticos (demanda), para asegurar una buena calidad, igualdad y la evaluación con perspectiva de género.

- La incorporación de las evaluaciones centradas en la igualdad y perspectiva de género en los Objetivos de Desarrollo Sostenible a nivel internacional, y en las estrategias nacionales de desarrollo a nivel nacional.

- El desarrollo centrado en la igualdad de género en políticas de evaluación nacional.

La antorcha de la evaluación del Evalyear fue encendida en el edificio de la ONU en Nueva York en diciembre de 2014 con el objetivo de viajar por todo el mundo a través de 28 países y terminar en el Foro Global EvalPartners donde culminar la celebración del Año Internacional de Evaluación y lanzar las siguientes iniciativas:

- Celebración el Año Internacional de Evaluación en un parlamento nacional.

- Lanzamiento de la Agenda Global de Evaluación 2016-2020.

- Lanzamiento del Foro Mundial de Parlamentarios para la evaluación.

- Lanzamiento de la EvalGender+ , la alianza mundial para las evaluaciones centradas en la igualdad y perspectiva de género.

- Lanzamiento de la EvalYouth, la alianza mundial para evaluadores jóvenes.

About Carlos Plaza

Principales corrientes de Evaluación: El aprendizaje, la teoría y las pruebas

La conferencia de la Sociedad Europea de Evaluación celebrada del 10 al 12 de octubre del 2002 tuvo como título: Corrientes de evaluación en la actualidad: Aprendizaje, teoría y pruebas (Learning, theory and evidence). Una reflexión sobre las principales corrientes existentes a la hora de abordar la evaluación: la evaluación basada en la teoría, la evaluación basada en las pruebas y la evaluación basada en el aprendizaje.

El aprendizaje es considerado sin duda como un objetivo global de la evaluación. Es necesario aprender de la evaluación. En un mundo donde el Estado ya no intenta ocuparse de todo, sino que a menudo se asocia con la sociedad civil, el aprendizaje a través de la evaluación deja de ser el coto privado de las autoridades políticas. Las comunidades, las asociaciones y los ciudadanos también se sirven de la evaluación para aprender y mejorar. Procedente de los campos de la gestión del conocimiento y del aprendizaje organizacional, está surgiendo con fuerza un movimiento que está redefiniendo el aprendizaje para convertirlo en una corriente dominante de la evaluación actual. Los evaluadores se interesan cada vez más por atesorar lo que hemos aprendido para que no se pierdan los frutos de las evaluaciones pasadas y que haya acceso a ellos y puedan recuperarse cuando se necesiten más adelante.

La evaluación basada en la teoría explora y trata de comprender el cómo y el porqué de los éxitos y fracasos de un programa. Intenta examinar las condiciones de implementación de un programa, así como los mecanismos que vinculan los procesos y los resultados. Esta corriente ha tenido un largo pasado (Chen & Rossi, 1983; Chen, 1990; Coryn et al., 2011; Rogers, 2007; Weiss, 1972a; 1972b, 1995; 1997a; 1997b), y recibió nuevos impulsos tras el surgimiento de escuelas realistas y la teoría del cambio, y a merced de la naturaleza retadora de las políticas públicas contemporáneas. Estas políticas a menudo se han plasmado en programas complejos que, al ser evaluados, no siempre ofrecen resultados claros. Si se desea sacar una conclusión general a partir de los resultados de la evaluación, debemos interpretar con cautela los datos obtenidos dentro de un marco teórico dado.

La corriente basada en las pruebas se ha convertido en un tópico en ciertos países europeos y se ha difundido con gran rapidez. Nace del deseo de los responsables políticos de obtener los mejores resultados a partir de los escasos recursos públicos disponibles. Éstos se preguntan ¿qué pruebas hay de que esto funciona? . Los defensores de la evaluación basada en las pruebas abogan a favor del rigor y de normas estrictas a la hora de proceder al análisis de todas las pruebas, sea cual sea la modalidad y el método empleados para obtenerlas. Muestras de esta corriente a nivel internacional ha sido la creación de organizaciones como la Cochrane Collaboration y la Campbell Collaboration.

- La Cochrane Collaboration es una organización sin ánimo de lucro creada para preparar, mantener y promocionar la accesibilidad de las evaluaciones de los efectos de las intervenciones en el campo de la atención sanitaria. Facilitar el acceso a pruebas de lo que realmente funciona en este campo ante la enorme cantidad de información existente.

- La misión de la organización Campbell Collaboration es la de preparar, mantener y diseminar las evaluaciones sistemáticas de los efectos sociales de la mayor parte de las actuaciones públicas. Recopilar pruebas de lo que realmente funciona en estos campos y ayudar así a la toma de decisiones en base a pruebas de calidad.

Obviamente, en el mundo real, estas corrientes no son autónomas. Muchos son los que argumentan que es la evaluación basada en la teoría la que genera las pruebas más convincentes, y que son las pruebas apropiadas las que hacen que las esferas políticas y la sociedad civil aprendan de verdad. Para los especialistas de la evaluación actualmente existen muchos enfoques alternativos, métodos y herramientas que veremos más adelante.

Referencias citadas:

Chen, H. T. (1990). Theory driven evaluations. Sage Publications. Newbury Park. California.

Chen, H. T. & Rossi, P. (1983). Evaluating with sense: the theory-driven approach. Evaluation Review 7(3): 283-302.

Coryn, C. L. S., Noakes, L. A., Westine, C. D., & Schro¨ter, D. C. (2011). A systematic review of theory-driven evaluation practice From 1990 to 2009. American Journal of Evaluation, 32, 199–225.

Rogers, P.J. (2007). Theory-based evaluation: Reflections ten years on. In S. Mathison (Ed.), Enduring issues in evaluation: The 20th anniversary of the collaboration between NDE and AEA (pp. 63-67). New Directions for Evaluation, No. 114. San Francisco, CA: Jossey-Bass.

Weiss, C. H. (1972a). Evaluating Action Programs: Readings in Social Action and Education. Allyn & Bacon. Boston.

Weiss, C. H. (1972b). Evaluation Research: Methods for Assessing Program Effectiveness. Prentice-Hall. Englewood Cliffs. New Jersey.

Weiss, C.H. (1995). Nothing as practical as good theory: Exploring theory-based evaluation for comprehensive community initiatives for children and families. In J. Connell, A. Kubisch, L. B. Schorr, & C. H. Weiss (Eds.), New approaches to evaluating community initiatives: Volume 1, concepts, methods, and contexts (pp. 65-92). New York, NY: Aspen Institute.

Weiss, C. H. (1997a). How can theory-based evaluation make greater headway? Evaluation Review 21(4): 501-524.

Weiss, C.H (1997b). Theory-based evaluation: Past, present and future. In D. J. Rog & D. Fournier (Eds.), Progress and future directions in evaluation: Perspectives on theory, practice and methods (pp. 55-41). New Directions for Evaluation, No. 76. San Francisco, CA: Jossey-Bass.

About Carlos Plaza

La evaluación en la Sociedad del Conocimiento

Con el desarrollo de la informática y las telecomunicaciones los sistemas de información han ido ido evolucionando en los últimos años, ganando en eficacia y almacenando mayor cantidad de información en el menor espacio posible. Actualmente existen enormes sistemas de información gestionados por ordenadores para la recogida de datos sobre cualquier cosa que pase en el mundo. Cientos de satélites recogen cantidades masivas de información de todo tipo, climática, geográfica, ambiental, social, etc.

Nuestra sociedad —la Sociedad del Conocimiento y las comunicaciones— ha desarrollado la capacidad de generar, almacenar, transmitir, e instantáneamente comunicar información. Diferentes organizaciones han comenzado a construir sistemas para la gestión de esta ingente cantidad de información. Según la web whois source actualmente hay 142 millones de dominios activos en internet, y en torno a mil millones de páginas. También se ha estimado que se han publicado más de 50 millones de artículos científicos y la producción científica se duplica cada nueve años.

El reto está en discriminar, saber qué información merece la pena. Existen respuestas pero no preguntas, las empresas tienen datos sobre todos los aspectos de sus clientes pero no saben qué necesitan saber sobre ellos. “¿Qué merece la pena saber? Esta es la pregunta clave de la Sociedad del Conocimiento. La importancia de esta situación para la evaluación es el hecho de que nunca como hasta ahora en la historia de la humanidad, ha sido tan verdad la afirmación de que el conocimiento es poder”.

El poder ha sido definido de diferentes modos a lo largo de los años. De acuerdo con los historiadores, los seres humanos aparecieron hace 3-5 millones de años en el Este de África. Durante mucho tiempo los hombres vivieron de la caza constituyendo pequeñas sociedades. Después vino la revolución de la agricultura hace unos 10.000 años y la revolución industrial hace 300. En el último cuarto del siglo XX hemos visto emerger la era de la información. En la era de la agricultura el poder estaba en la tierra, en la era industrial el poder estaba en el capital. En la era de la información el conocimiento es poder, con el conocimiento acertado se puede conseguir tierra y capital.

La evaluación —como actividad para la mejora, fortalecimiento y adquisición de capacidades y no como simple generación de resultados e informes— aborda las preguntas fundamentales de nuestro tiempo: ¿En qué información merece la pena fijar la atención?; ¿cómo juntar la información de cara a convertirla en conocimiento?; ¿cómo sabemos qué es real? (Patton, 1999). A estas cuestiones señaladas por Patton podemos añadir una cuarta: ¿cómo discriminar la información buena de la mala?

Ante las innumerables cuestiones a las que puede responder un evaluador ante una evaluación concreta, el gran reto está en resolver qué merece la pena saber y hacer para obtener información útil en un momento adecuado para la toma de decisiones. En definitiva, averiguar qué es lo que crea la diferencia entre lo que la gente hace.

La evaluación se ha convertido en una profesión clave para la eficacia. Los evaluadores no son sólo consultados para la evaluación sino también para el diseño de programas, especialmente en Norteamérica. Los evaluadores han analizado muchos programas y pueden ayudar a mejorar su eficacia. En esta línea se ha creado todo un campo de investigación para el estudio de los expertos de evaluación para averiguar qué es lo que les capacita como tales expertos. Parte de esta investigación es el desarrollo de la inteligencia artificial en la evaluación, sistemas expertos que puedan ayudar a la evaluación.

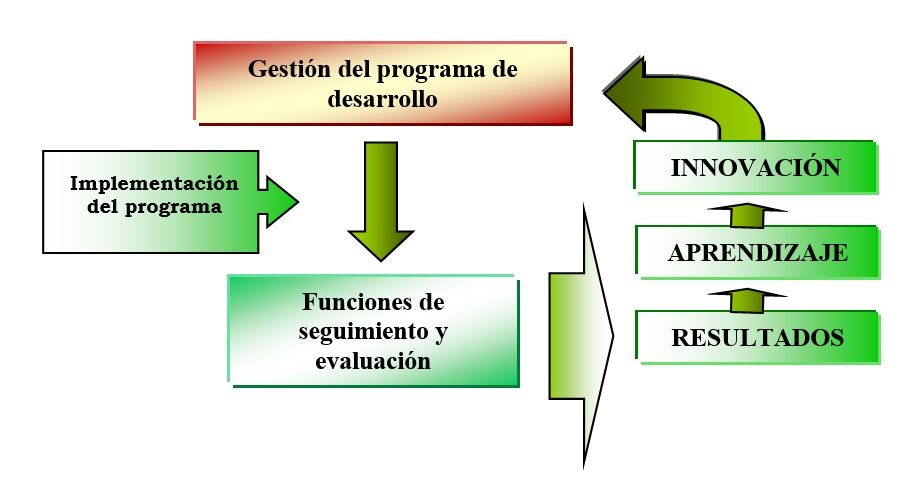

El papel clave de la evaluación para mejorar la programación a través de una adecuada retroalimentación y mejorar la gestión de los programas a través de un adecuado seguimiento o monitoreo, es en la actualidad ampliamente reconocido. A través de la evaluación se pueden determinar los efectos socioeconómicos de las acciones emprendidas, compararlos con los recursos invertidos, analizar su coste y mejorar las futuras políticas, programas y proyectos a través de la retroalimentación y lecciones aprendidas, y proporcionar así una base para la responsabilidad y la fundamentación a los encargados de tomar decisiones en acciones futuras. Se trata en definitiva de comprender mejor para actuar mejor, resolver mejor los problemas y lograr mejor los objetivos buscando el perfeccionamiento de los resultados.

El potencial pleno de las actividades evaluativas de seguimiento o monitoreo se pueden comprender sólo cuando se ven como parte integral del proceso de gestión y los directores de los programas aceptan su importancia y utilidad. La buena gestión necesita y demanda un buen sistema de información, pero este sistema, por muy robusto que sea conceptualmente, no puede sobrevivir a una gestión ineficaz o a estructuras de gestión mal diseñadas. La finalidad del seguimiento o monitoreo es ayudar a la gestión a establecer y mantener un sistema de información y a utilizarlo con oportunidad. El seguimiento comprende también la confrontación de los datos registrados del programa y la recopilación de datos suplementarios para el análisis y la interpretación que se precisan a fin de adoptar decisiones relacionadas con el funcionamiento del programa.

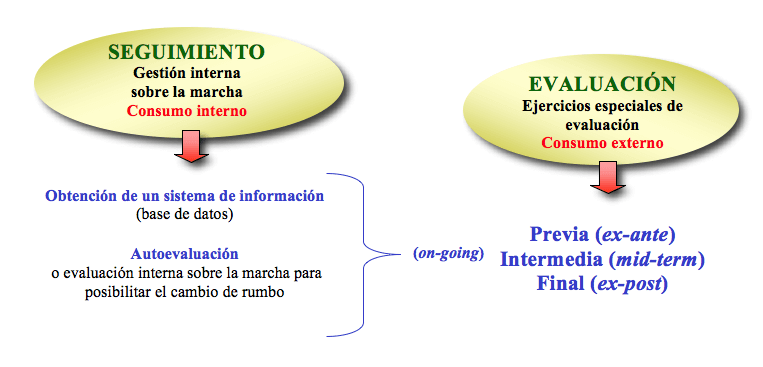

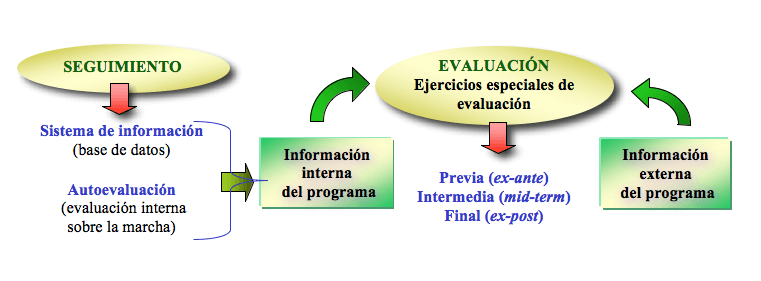

Retroalimentación y capacidad de aprendizaje en las funciones de seguimiento y evaluación.

Retroalimentación y capacidad de aprendizaje en las funciones de seguimiento y evaluación.

Referencias citadas:

Patton, M. Q. (1999). Utilization- Focused Evaluation in Africa: Evaluation Training Lectures delivered to the Inaugural Conference of the African Evaluation Association. Ed. P.N. Chaiban and M. Patel.

About Carlos Plaza

Relación entre seguimiento y evaluación

El seguimiento y la evaluación están íntimamente vinculados. Ambos constituyen instrumentos necesarios para aportar elementos de juicio al proceso de toma de decisiones y demostrar la rendición de cuentas. Ninguno de los dos reemplaza al otro. La evaluación aprovecha la base de datos creada durante el proceso de seguimiento, suplementándola según sea necesario con datos sobre el efecto causado por el programa y repasando la información combinada en el curso de un período prolongado a fin de juzgar lo realizado.

Las funciones de seguimiento y evaluación de un programa de desarrollo. Fuente: Elaboración propia.

Las características y diferencias de una y otra actividad se definen en la siguiente tabla:

Características y diferencias entre seguimiento y evaluación |

|

Seguimiento |

Evaluación |

| Continuo | Periódica, en etapas importantes: a mitad del período de implementación del programa, al final o al cabo de un período sustancial después de finalizado el programa |

| Análisis poco profundo, supervisa, analiza y documenta los progresos registrados | Análisis a fondo; compara la planificación con los logros reales |

| Se centra en el seguimiento del beneficiario y en las realizaciones físicas y financieras | Se centra en el análisis del planteamiento y lógica de intervención, aplicación y gestión, y en el impacto |

| Responde qué actividades se realizaron y qué resultados se obtuvieron | Responde por qué y cómo se obtuvieron los resultados al contar con una mayor profundidad en el análisis. |

| Alerta a los administradores acerca de los problemas y brinda opciones para la adopción de medidas correctivas | Brinda a los administradores opciones de estrategia y de política |

| Análisis interno (autoevaluación) de los gestores y los interesados locales | Análisis externo a cargo de los evaluadores externos |

| Consumo interno del que se benefician los gestores y los interesados locales de la intervención | Consumo interno y externo del que se benefician los gestores, los interesados locales y los encargados del control externo de la intervención |

El seguimiento debe ser integrado a la estructura de gestión del programa, pero la evaluación, con sus horizontes más amplios, no es necesariamente un componente tan integral. Debemos considerar el seguimiento y la evaluación como funciones independientes una de la otra. Se encuentran separadas por sus objetivos, períodos de referencia, necesidades de análisis y usuarios. Pero una vez destacadas las diferencias, es necesario hacer constatar que hay características comunes que realzan la relación existente entre las dos actividades.

El seguimiento del programa y la evaluación deben colaborar con objeto de utilizar los recursos de manera eficiente sin perder de vista la finalidad primaria de acopiar recursos para información interna del programa, esto es, el suministro de un sistema de información diseñado para satisfacer las necesidades de gestión del programa.

Relación entre las funciones de seguimiento y evaluación

Buscando una definición de evaluación

La evaluación no debe ser vista ante todo como una actividad técnica o metodológica. Tampoco ha de ser entendida como la elaboración de informes. Es una actividad que principalmente implica pensar. La evaluación es en su sentido más profundo una vía para reflexionar sobre lo que está pasando. Muy íntimamente unida a esta apertura de un ámbito para reflexión, está el potencial de la evaluación para hacer repensar y analizar, generar capacidades entre la población afectada por un proceso de evaluación, y la mejora de las intervenciones que modifican la realidad que les rodea.

La evaluación como práctica profesional se ha venido definiendo como “el proceso de determinar el mérito, interés e importancia de las cosas” (Scriven, 2005, p. 235). Pero veamos cada uno de estos tres términos.

El mérito (merit) está relacionado con las propiedades intrínsecas, características o atributos de lo que estamos evaluando en comparación con los criterios de calidad utilizados. Por ejemplo, en el caso de una manzana estaríamos hablando de su sabor, apariencia, color, estado de madurez… En la evaluación de programas decimos que un programa tiene mérito cuando: 1) cumple con lo que estaba llamado a hacer, logrando los resultados esperados, y 2) supone una diferencia significativa en la realidad como consecuencia de su implementación.

El interés (worth) es la estimación de lo que vale lo que estamos evaluando en comparación o equivalencia a otra cosa, típicamente el dinero. Así que mientras el mérito puede ser difícil de medir, el valor suele expresarse en un valor monetario fácilmente medible. En el caso de la manzana estaríamos hablando de su precio. En el caso de la evaluación de programas podemos estar hablando de la comparación de dos programas (uno más barato que otro y por tanto con más valor) o la comparación de un mismo programa en dos sitios distintos (uno con más impacto que otro y por tanto con más valor).

La importancia (significance) se refiere a los valores y significación que asociamos a aquello que estamos evaluando. Es preguntarse por lo que lo hace especial o significativo para unos individuos concretos. En el caso de la manzana podríamos estar hablando de su importancia por quién me la ha regalado o por el hecho de que es lo único que tengo para comer; su mérito y valor pueden ser pequeños pero su importancia mucha. En el caso de la evaluación de programas podemos hablar de programa ineficaces, con impacto muy limitado, pero con una alta importancia por su valor simbólico por ser el único que cubre una determinada necesidad de un sector vulnerable de la población.

La evaluación supone así la emisión de un juicio por parte de un sujeto sobre el mérito derivado de las características intrínsecas de lo que evaluamos, el interés en referencia a una determinada moneda (u otro referente que se considere adecuado) y la importancia en relación a características adheridas por el contexto y las personas que rodean lo que evaluamos. Pero es fundamental que ese juicio sobre el mérito, interés e importancia que se emite se fundamente en hechos objetivos y concretos. La evaluación es una actividad en la que partiendo de los hechos (objetivos) llegamos a un juicio (realizado por un sujeto) sobre esos hechos. Este juicio es subjetivo por naturaleza, pero deberá tratar de aproximarse a la realidad y objetividad de los hechos lo máximo posible.

En la evaluación de programas, podemos decir que una evaluación es una valoración, tan sistemática y objetiva como sea posible, de un proyecto, programa o política en marcha o terminado, su diseño, aplicación y resultados (Comisión de la UE, 2002). Evaluar una acción, una operación, un proyecto, un programa, significa examinarlo en su contexto de aplicación, para poder apreciar los efectos en relación con una situación de referencia, y juzgar su impacto en relación con los objetivos perseguidos: impacto global, utilidad social, interés económico… En este sentido, la evaluación es una valoración periódica del programa en el contexto de sus objetivos declarados (Casley & Kumar, 1990).

Una evaluación debe proporcionar unas informaciones creíbles y útiles, que permitan integrar las enseñanzas sacadas en la toma de decisiones. Para ello es importante preservar la independencia y objetividad de los evaluadores con respecto a los gestores y autoridades financieras, y que la evaluación constituya una actividad externa del programa realizada por profesionales ajenos a la gestión y control del programa.

La evaluación aplicada a un programa de desarrollo, examina de que manera el programa, y las diversas operaciones que lo integran, aporta soluciones a los problemas identificados, alcanza los objetivos fijados, crea nuevos valores económicos, sociales y culturales, así como las condiciones de una dinámica sostenible de desarrollo. En definitiva podemos intentar definir la evaluación de programas como: La actividad externa de una intervención, tan sistemática y objetiva como sea posible, que lleva a cabo de forma periódica el análisis y valoración a fondo de la intervención o aspectos concretos de ella, su diseño, aplicación y resultados, con referencia a unos criterios y estándares explícitos; lo que lleva a un juicio de valor sobre el mérito, interés e importancia y a una oportunidad para el aprendizaje y mejora continua de la intervención y la toma de decisiones sobre futuras intervenciones.

Referencias citadas:

CASLEY, D. J. & KUMAR, K. (1990). Seguimiento y evaluación de proyectos en agricultura. Banco Mundial. Madrid: Mundi Prensa.

COMISIÓN DE LA UNIÓN EUROPEA (2002). Project Cycle Management Handbook. Evaluation Unit of the EuropeAid Co-operation Office. March 2002. Version 2.0. Freiburg, Germany.

SCRIVEN, M. (2005). Logic of evaluation. In S. Mathison (Ed.), Encyclopedia of evaluation (pp. 235-238). Thousand Oaks, CA: Sage.