Inicio » Entradas etiquetadas como «evaluación de proyectos» (Página 4)

Archivos de la etiqueta: evaluación de proyectos

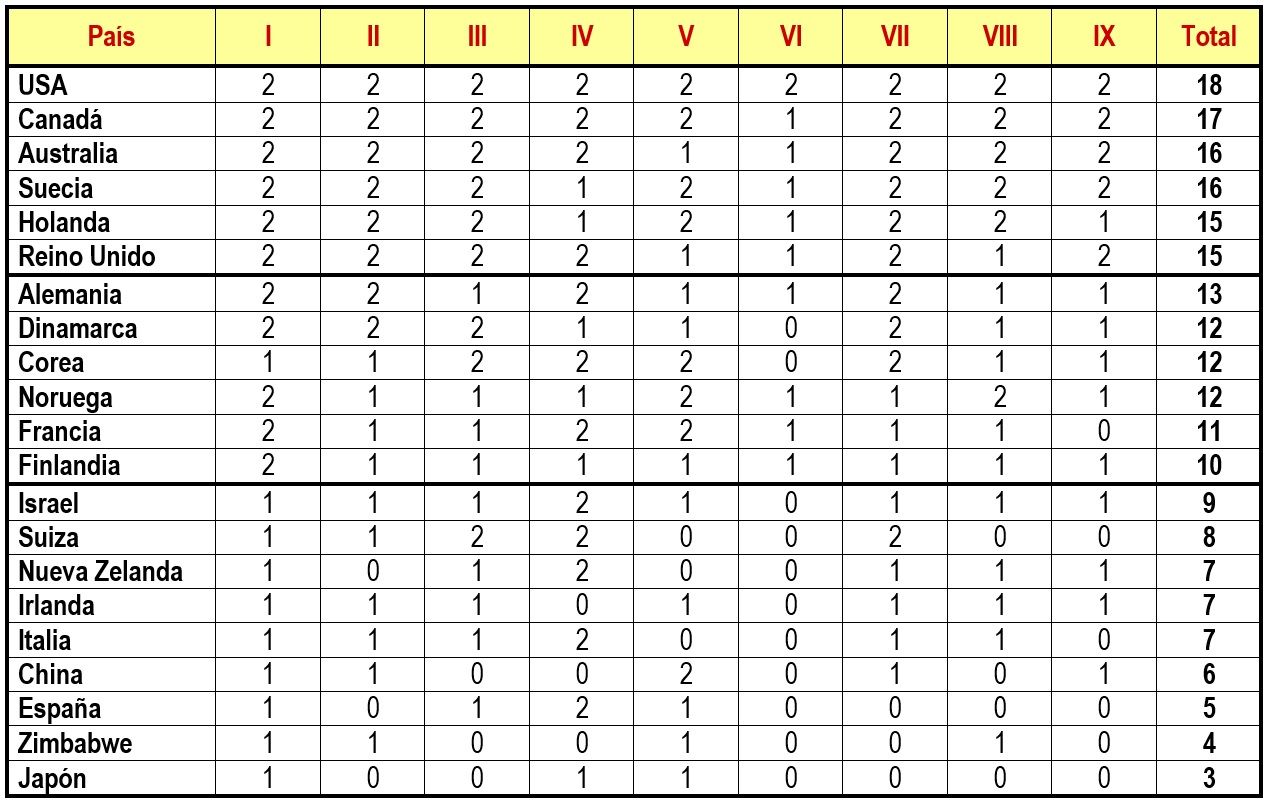

Contenidos de un sistema de S&E

Como se puede ver en la figura, que se irá explicando a lo largo de esta entrada, el seguimiento y evaluación (S&E) distingue tres principales aspectos clave a evaluar: el planteamiento y lógica de intervención, la aplicación y gestión y los resultados e impacto (ver parte superior de la figura).

El conjunto de encadenamientos entre los diferentes objetivos, medidas y proyectos constituye la estructura misma de un programa de desarrollo, un modelo lógico que queda dibujado en la figura. A partir de esta estructura se procede a evaluar por un lado el programa en sí mismo y por otro, sus efectos.

Aspectos clave del contenido de un sistema de seguimiento y evaluación

Aspectos clave del contenido de un sistema de seguimiento y evaluación

En la evaluación del programa en sí se analizan por un lado el planteamiento y lógica de la intervención (de color azul en la figura) y por otro, su aplicación —puesta en funcionamiento y gestión— analizando si las medidas fijadas han conseguido sus objetivos y si los encadenamientos entre objetivos y medidas se han desarrollado según las previsiones (de color rojo en la figura). En la evaluación de los efectos y resultados se analizan éstos, especialmente en lo que se refiere a los objetivos que el programa se proponía (de color verde en la figura).

El planteamiento y lógica de intervención

Las actividades de S&E comienzan con el ejercicio de evaluación previa que ha de centrarse en el primero de los aspectos: el planteamiento y lógica de intervención (ver parte inferior de la figura). Su misión consiste en asegurar un adecuado planteamiento del programa que se está diseñando (cuadros de color azul en la figura). Ha de analizar el fundamento, la pertinencia, la claridad y coherencia y hacer una estimación sobre la futura utilidad y sostenibilidad de la intervención. Es por ello que esta primera evaluación ha de mirar hacia el futuro y avanzar algo sobre los otros dos aspectos clave de modo que analice la adecuación y calidad de los mecanismos de ejecución y se haga una estimación de los resultados del programa (flecha roja y verde que acompaña a la evaluación ex-ante en la parte inferior de la figura).

Una evaluación intermedia o final ha de buscar una perspectiva general de cómo está funcionando o ha funcionado el planteamiento del programa. Por ello el primer paso de estas evaluaciones también puede estar dedicado a la lógica del programa. Esto es claramente necesario si la lógica inicial contiene puntos oscuros o escasamente justificados, es decir, si la evaluación previa no se hizo correctamente o si sus conclusiones no se tomaron en cuenta. Puede ocurrir además que los objetivos fueran modificados a medio camino, por lo que sería necesario presentar una nueva lógica de programa al principio del informe de evaluación y comprobar si la coherencia general del programa se ha mantenido a pesar de estas modificaciones. Más a menudo, las necesidades a satisfacer o los problemas a resolver han cambiado durante la ejecución del programa. Si es necesario, la evaluación intermedia y final deben revisar la lógica de programa en vista de este nuevo contexto.

En cualquier caso, el estudio de la lógica de intervención en estas evaluaciones intermedias o finales se suele abordar como un ejercicio puntual, muy diferente a los trabajos de la evaluación previa donde las labores de análisis de la lógica de intervención constituyen un trabajo continuo durante toda la etapa de diseño. En una evaluación intermedia, conduce a recomendaciones para mejorar el sistema de control y los métodos de gestión. En una evaluación final, este análisis se utiliza para aclarar los objetivos cuando éstos no se han expresado de forma clara.

La aplicación y gestión

Iniciado el programa, comienza el seguimiento con el objetivo fundamental de analizar —y reorientar en caso necesario— el segundo aspecto clave, la aplicación y gestión del programa (color rojo en la figura). Un seguimiento físico, financiero y de los beneficiarios de la intervención junto con una adecuada autoevaluación han de ser instrumentos suficientes para asegurar la buena gestión del programa. Un adecuado sistema de seguimiento ha de ir valorando también los resultados que se vayan produciendo y facilitar cualquier rectificación que se vea necesaria en el planteamiento del programa. De ahí que partiendo de la aplicación se dirija hacia los resultados y vuelva al planteamiento inicial de la intervención con ánimo de mejorarla (ciclo que rodea al seguimiento en la parte inferior de la figura).

Durante el diseño, la evaluación previa se ha de hacer un análisis de la adecuación y calidad de los instrumentos de gestión. En la etapa de ejecución encontramos la evaluación intermedia que se centra en este aspecto de evaluación. Centrada en la gestión, supone un primer análisis profundo de la marcha del programa hasta la fecha y una oportunidad de cambiar el rumbo de los posibles planteamientos de la intervención que no terminen de funcionar correctamente. La evaluación final ha de sacar conclusiones sobre los resultados de la aplicación y gestión con vista a la mejora de futuras programaciones.

Resultados e impacto

Ya en la etapa de terminación nos encontramos con la evaluación final centrada en el análisis del tercer aspecto clave: los resultados e impacto del programa (de color verde en la figura). Esta evaluación ha de permitir descubrir cual ha sido la incidencia real del programa en su ámbito de aplicación. Ha de abordar también los otros dos aspectos clave (flecha azul y roja que acompaña a la evaluación final en la parte inferior de la figura). No sólo a modo de recopilación de todos los datos y conclusiones obtenidas en las actividades de S&E precedentes, sino como un análisis profundo y final que permita extraer las mejores conclusiones y enseñanzas posibles.

Si bien el proceso de aprendizaje es continuo desde el inicio de la intervención (flechas en la parte inferior de la figura), la evaluación final constituye un punto de referencia fundamental a la hora de extraer el conjunto de enseñanzas que pudiesen derivarse del sistema de S&E implementado.

En la evaluación previa se ha de hacer una estimación de los resultados que se esperan alcanzar, del impacto previsto. En la evaluación intermedia el estudio del impacto hace referencia al estado en que éste se encuentra en el momento de su realización. La evaluación final se apoya en los resultados y respuestas de la evaluación intermedia precisándolas si fuese necesario.

About Carlos Plaza

El aprendizaje en un sistema de seguimiento y evaluación: Generación y gestión de la innovación

Muy relacionada con la gestión del conocimiento está la gestión del cambio y la innovación que éste genera. Entendiendo esta innovación como el arte de transformar el conocimiento en calidad de vida, en un sentido amplio que abarca todos los conceptos de desarrollo: estrategia, procesos de gestión o coordinación, productos/servicios, resultados… Un proceso de aprendizaje social que requiere de esfuerzo más que de genialidad, y de una estrategia para la gestión del cambio.

Una estrategia para la gestión del cambio tiene como punto de partida la creación de un clima que cuide los siguientes puntos como caldo de cultivo para la generación de innovación:

- Respeto de la autonomía, el permitir a todos los individuos actuar con libertad supone una posible fuente de innovación. Los individuos han de poder actuar con el mayor grado de libertad posible para aprovechar el potencial de ideas que representen nuevas oportunidades.

- Generación de un estado de tensión, de retos elevados dentro de un límite adecuado que no lleva a la frustración, que dirija a todos los implicados hacia la búsqueda del cambio y no hacia la mera adaptación al entorno. Este estado de tensión y caos creativo supone un caldo de cultivo que impulsa la innovación.

- El diálogo como proceso para la transformación que posibilita a sus participantes el abandono de sus propias perspectivas y formulación de nuevos escenarios de entendimiento.

- La visión compartida que permita a los individuos compartir e integrar aspectos de sus conocimientos que no son comunes entre ellos y construya nuevas experiencias a través del desarrollo de trabajos o proyectos conjuntos.

- El desaprendizaje implica desechar aquellos conocimientos que se han quedado obsoletos venciendo la resistencia que en muchos casos se presenta. Esta actividad es fundamental para una correcta interpretación compartida, pues el esfuerzo por mantener las visiones anteriores, puede conducir a que la información se interprete dentro de un ámbito muy limitado, obteniendo como resultado una miopía colectiva que impida detectar nuevas oportunidades [1].

Al igual que en la gestión del conocimiento, la documentación es una actividad importante en la gestión de la innovación para hacer explícitas, fáciles de entender y accesibles a todos las potenciales innovaciones que se puedan introducir. También es importante la vigilancia del entorno introduciendo actividades de medición y diagnóstico a través del seguimiento o monitero para realizar una búsqueda sistemática de información. Todos los que lo realizan deben convertirse en escaneadores del entorno, es decir, en recopiladores y transmisores de información.

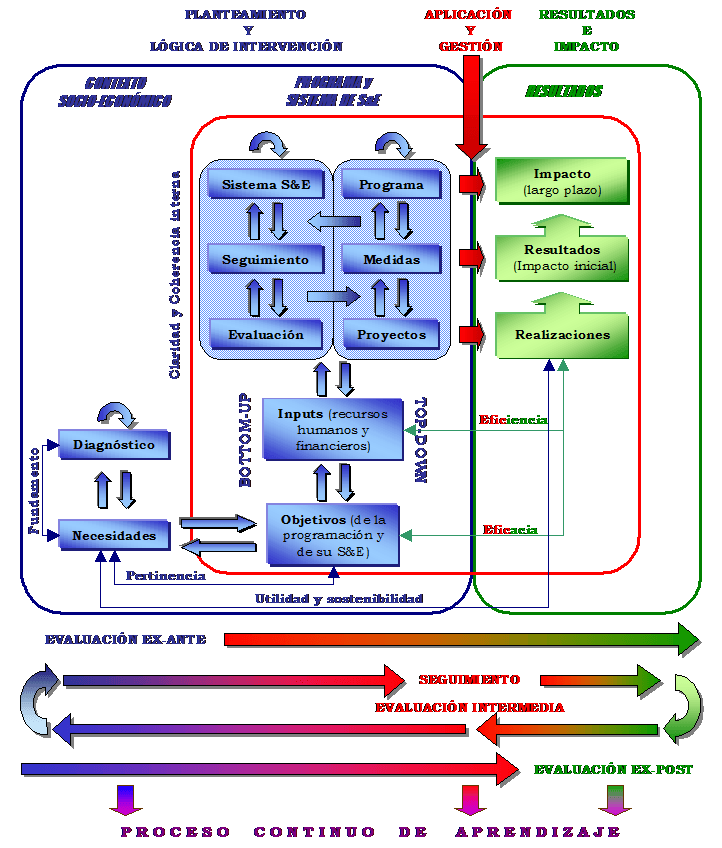

Gestión de la innovación

Estas actividades han de permitir focalizar la atención y los esfuerzos en alguna estrategia concreta de innovación. Una vez lograda esta focalización, los esfuerzos pueden orientarse a la capacitación de la estrategia elegida dedicando los recursos necesarios para implantarla. La reflexión sobre todos los elementos anteriores y la revisión de las experiencias tanto de éxito como de fracaso ha de llevar al aprendizaje y mejora continua entre la población, en definitiva, a su fortalecimiento desde el punto de vista del desarrollo.

La innovación puede ser gestionada si se sabe dónde y cómo mirar (Drucker, 1991). La gestión del cambio y la innovación suponen un auténtico reto organizativo. Elaborar una auténtica estrategia del cambio, donde en primer lugar se identifican las necesidades de cambio y las resistencias a éste junto con las propuestas concretas de innovación. Posteriormente —a través de un modelo de actuación que incentiva la innovación— se realiza el desplazamiento deseado y consensuado con la participación.

En este sentido, destaca la dificultad que encuentran las comunidades con experiencia en programas de desarrollo para desechar las formas de actuar que en el pasado dieron resultado. Esta resistencia probablemente tiene su origen en las reticencias de las personas con experiencia a abandonar parte de los conocimientos y formas de actuar adquiridos a lo largo de los años y que constituyen su único capital.

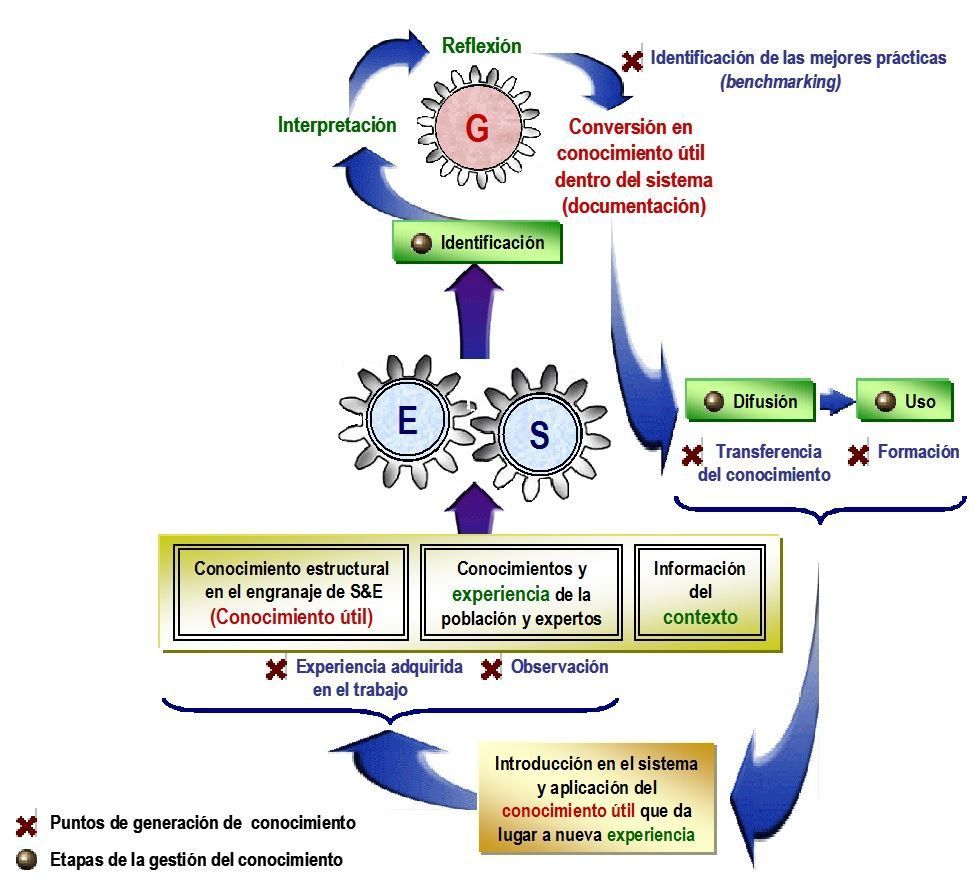

Mecanismo de aprendizaje para la generación y gestión de la innovación en el modelo de S&E

Mecanismo de aprendizaje para la generación y gestión de la innovación en el modelo de S&E

Cinco son los elementos clave para gestión del cambio y la innovación en el modelo:

- Identificación del liderazgo local como proceso interpersonal mediante el cual influir en el comportamiento para que logren metas de innovación. Sin un líder comprometido con el aprendizaje y la innovación, difícilmente se logrará el cambio.

- Implantación de una cultura que incentive la innovación, la experimentación y el riesgo y motive a la población a desarrollar su capacidad de aprendizaje. Hacer a todos los implicados responsables de la intervención —que se identifiquen más intensamente con ella— y vean sus posibles beneficios, aumenta su motivación.

- Selección de personal con un elevado grado de profesionalización en cuanto a técnicas de negociación y comunicación, que permita potenciar las actitudes cooperativas de los trabajadores y facilitar la confianza y el trabajo en equipo. Es importante su formación de cara al éxito en la gestión del cambio.

- Estrategia que articule la orientación futura de acuerdo con el capital territorial y con una combinación óptima entre la explotación de los recursos y capacidades existentes y la exploración de nuevas alternativas.

- Estructura organizativa, elemento que da soporte a los anteriores especificando las interacciones entre los individuos y grupos dentro del sistema de S&E. El desafío para lograr una gestión eficiente de la innovación pasa por la combinación de los conocimientos, las comunicaciones laterales y formas organizativas flexibles y autónomas que permitan la experimentación y la integración de nuevos conocimientos.

Referencias citadas:

Davenport, TH., DeLong, DW. and Beers, MC. (1998). Succesful knowledge management projects. Sloan Management Review, 39 (2), 43‐57.

Drucker, P. (1991). La innovación y el empresario innovador. Barcelona: Edhasa.

About Carlos Plaza

El aprendizaje en un sistema de seguimiento y evaluación: Generación y gestión del conocimiento

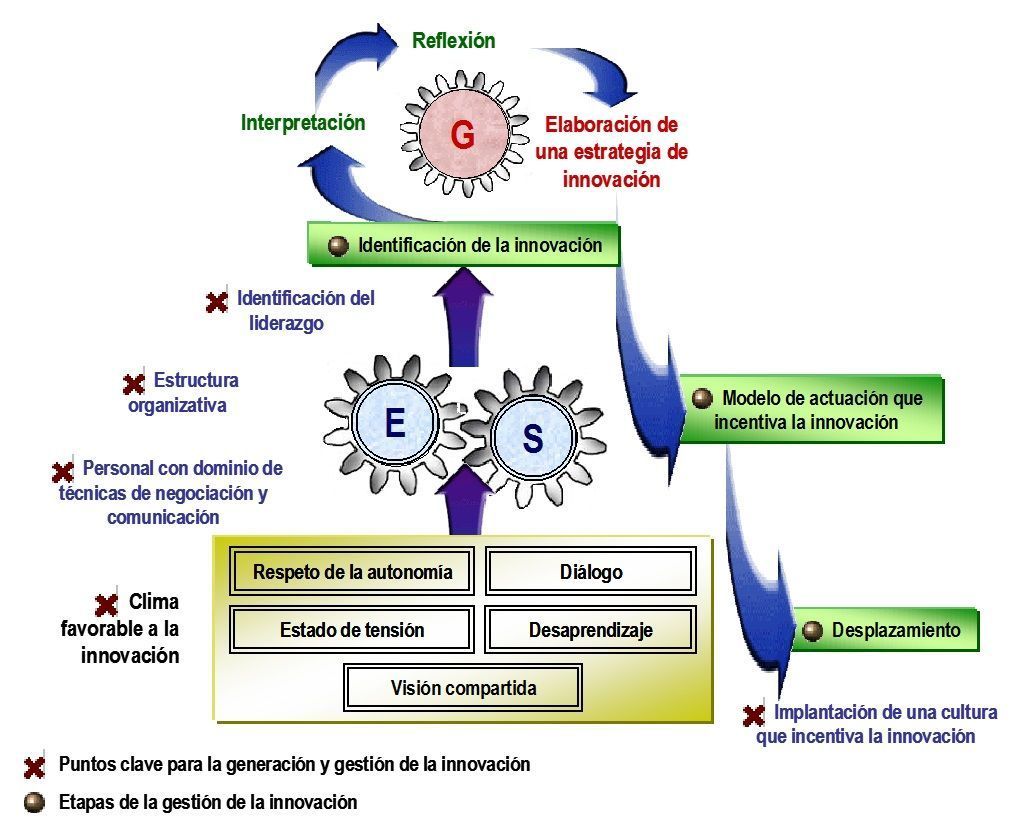

La concepción de las actividades de seguimiento y evaluación (S&E) como un proceso sistemático de aprendizaje que activa un ciclo de retroalimentación es el medio para para la construcción de capacidades locales y la creación de un capital que genere un verdadero desarrollo.

Como hemos visto, el mecanismo de participación activa un proceso de aprendizaje sobre la marcha entre todos los participantes, población local y expertos. Pero el aprendizaje que se propone no es un simple aprendizaje pasivo —como si se tratara de una ósmosis— sino un aprendizaje activo. Además del aprendizaje que genera la participación hay que encauzar y fomentar el aprendizaje mediante una adecuada gestión del conocimiento e innovación donde deberá indicarse cómo se “destilará” y se transmitirá la experiencia adquirida.

Esta gestión ha de derivar en el mejor aprovechamiento de los resultados obtenidos para la identificación de las mejores prácticas y lecciones más interesantes y guiar así el futuro del programa y las futuras programaciones.

El aprendizaje activo dentro del modelo se genera mediante dos ciclos que se han de gestionar adecuadamente. Un ciclo continuo dentro del sistema de seguimiento y otro —puntual y más profundo— dentro del sistema de evaluación. Los ejercicios especiales de evaluación suponen ejercicios especiales de aprendizaje con mayores medios y mayor profundidad en el análisis.

Ciclos de gestión del conocimiento en el modelo de S&E

Ciclos de gestión del conocimiento en el modelo de S&E

Generación de conocimiento

Davenport, DeLong y Beers (1998) definieron el conocimiento como “la información combinada con experiencia, contexto, interpretación y reflexión”. Nuestra propuesta es que la generación del conocimiento se base en estos cuatro elementos del conocimiento definidos por Davenport:

- Experiencia: Conocimiento que se adquiere mediante la práctica. Es aportado por la población en cuanto a conocimiento del contexto y por los profesionales en cuanto a la aplicación de técnicas de S&E. Es importante garantizar ─mediante la selección de líderes en el proceso de participación y mediante la selección de los equipos profesionales que han de realizar el S&E─ la presencia de la necesaria experiencia por ambas partes.

- Contexto: Unión de informaciones que se entrelazan y son dependientes entre sí. Cualquier información del programa se complementa con toda la información relativa al entorno o los factores que afectan a esa información. Una contextualización adecuada requiere de información precisa en determinados momentos, para lo que se ha de disponer de un sistema de información apropiado que permita el acceso a la información rápido y eficaz.

- Interpretación: Explicación adecuada de la información. Una adecuada interpretación requiere unas normas explícitas sobre la codificación, el sentido y el alcance de los términos empleados. Además, estas normas deben ser utilizadas y entendidas por todos, lo que supone que debe de realizarse una formación adecuada en este aspecto.

- Reflexión: Considerar detenidamente la información y todo su contexto. Se trata de la última etapa de tratamiento de la información que culmina con el aprendizaje y la toma de decisiones y acciones.

Por otro lado, Kerzner (2001) propone hasta cuatro fuentes de generación de conocimientos: la transferencia de conocimiento, la formación, la experiencia adquirida en el trabajo y una cuarta denominada como la identificación de las mejores prácticas (benchmarking) y mejora continua. En el caso de los trabajos de S&E conviene añadir una quinta que es la observación atenta y directa de la realidad, que en Kerzner estaría incluida en la experiencia adquirida en el trabajo. Tendríamos así cinco fuentes:

- Transferencia de conocimiento: el conocimiento generado ha de difundirse entrando en el ciclo de retroalimentación del S&E para la generación de nuevos conocimientos.

- Formación: la formación ha de ser considerada como una de las inversiones más importantes de cara al desarrollo.

- Experiencia adquirida en el trabajo: pieza clave para generación de nuevos conocimientos a través de la aplicación práctica de los nuevos conocimientos que se van generando.

- Benchmarking y mejora continua: principal punto de atención de las actividades de gestión del conocimiento.

- Observación atenta: generación de conocimiento directa sobre el terreno.

Gestión del conocimiento

La experiencia en trabajos de evaluación pone de manifiesto la importancia de la diseminación y transferencia del conocimiento adquirido en las actividades que han dado buenos resultados. En el momento actual existe un creciente convencimiento de que el conocimiento constituye un activo cada vez más importante. No es de extrañar que haya un progresivo interés por su gestión que en la práctica no resulta nada fácil.

Para poder gestionar el conocimiento es necesario hacerlo visible, explícito en la medida de lo posible. Podemos considerar que el conocimiento en el desarrollo de un programa tiene tres fuentes: los conocimientos y saber hacer de los implicados —población y expertos—, toda la información que proporciona el entorno y por último, el conocimiento estructural que se encuentra ya explicitado dentro del engranaje que constituyen el programa y su S&E (conocimiento generado).

El arte de la gestión del conocimiento reside fundamentalmente en convertir, tanto como sea posible, los dos primeros tipos en el tercero que es, en definitiva, el conocimiento útil dentro del sistema. Un conocimiento que posibilita el acceso y la recuperación del mismo y facilita su desarrollo y utilización.

Generación y gestión del conocimiento en el modelo de S&E

Generación y gestión del conocimiento en el modelo de S&E

La generación de conocimiento útil constituye la base para convertir el aprendizaje individual —de cada persona implicada— y grupal —de cada uno de los equipos— en aprendizaje de todos. Se trata de la construcción de una comunidad, una cultura y un lenguaje con un enfoque común, unos objetivos compartidos poniendo el énfasis en la creación de significado local. El programa no tiene sentido sin este tipo de significado.

La documentación es un paso esencial en este proceso. Confiere al conocimiento un cierto grado de permanencia que evita que éste solo exista en la mente de las personas o en el entorno. Su objeto es hacer el conocimiento explícito, fácil de entender y accesible a todos los que lo necesitan. Para ello, al conocimiento hay que darle una estructura, un formato en el que se pueda almacenar, compartir, combinar de formas muy diversas. La principal dificultad de este proceso es evitar la pérdida de propiedades distintivas que conviertan el conocimiento en información poco relevante o en simples datos.

Para gestionar el conocimiento de manera eficaz y eficiente, primero hay que identificar el conocimiento útil en cada programa y en cada circunstancia, para luego difundirlo y favorecer su utilización. Estos tres pasos —identificación, difusión y uso— constituyen la base para la gestión del conocimiento en un sistema de S&E. La difusión ha de conllevar una socialización del conocimiento que ha de poder difundirse entre las diversas personas que lo pueden necesitar. El uso ha de suponer una previa detección de las oportunidades que dé el conocimiento para darle la mejor utilidad posible.

El modelo supone la incorporación de métodos para asegurar la adecuada interpretación de la información, la disponibilidad de un sistema eficaz para su contextualización y la presencia de la experiencia necesaria. En estas condiciones, la utilización sistemática de un proceso definido y estructurado de reflexión, garantiza el aprendizaje en el S&E.

Uno de los objetivos finales de la gestión del conocimiento propuesta está en la construcción de capacidades de S&E local. El fortalecimiento de la capacidad de evaluación asegura que se disponga de datos sobre evaluación y el éxito del sistema de S&E, ya que éste no puede imponerse efectivamente en donde no se desea su puesta en práctica. El fortalecimiento de la capacidad de evaluación es una tarea larga y compleja que exige un compromiso importante y sostenido por parte de todos los implicados.

About Carlos Plaza

Factores que afectan al uso de la evaluación

El primer requisito de las actividades de evaluación es el de producir evaluaciones que sean útiles (Patton, 2008). Sin embargo, la utilidad de las evaluaciones es un aspecto que ha quedado relegado en muchos ejercicios de evaluación a favor del rigor metodológico, sofisticados análisis estadísticos, o dimensiones como la validez o la credibilidad que no resuelven el problema de que las evaluaciones no se usen. La actividad profesional se enfrenta así a un doble reto: fomentar usos apropiados de las evaluaciones y trabajar por eliminar usos inapropiados.

Las evaluaciones deben juzgase por su utilidad, y se usarán siempre que el fundamento para su uso sea cuidado apropiadamente. Para ello es necesario identificar los grupos afectados por la evaluación, sus necesidades y valores; realizar diseños de evaluación adecuados; así como cuidar la oportunidad del momento en que se realiza la evaluación y la diseminación de sus resultados.

Los evaluadores deben diseñar sus evaluaciones con atenta consideración a cómo todo lo que se hace, desde el comienzo hasta el final, afectará a la utilidad de la evaluación. Destacan aquí cinco factores a tener en cuenta (Patton, 2008).

-

El factor personal

El tema de la utilidad y uso de las evaluaciones no es una abstracción, se trata de un uso intencionado y concreto llevado a cabo por personas concretas. Es fundamental localizar a estas personas, reales y específicas, e interaccionar adecuadamente con ellas para determinar el tipo de evaluación que necesitan (en cuanto contenidos, métodos y usos). Son estas personas las que tendrán la responsabilidad de aplicar los resultados de la evaluación y poner en marcha sus recomendaciones. Y lo harán con mayor probabilidad si sienten que la evaluación en suya y se han visto envueltos en las actividades de evaluación. Es por ello que el primer reto de un evaluador es generar compromiso con la evaluación y su uso, que se valoren las actividades de evaluación y se comparta la visión de lo que se va a realizar.

-

Cultura de la organización

Todo lo dicho sobre el factor personal es aplicable a la organización en la que trabajan las personas implicadas en la evaluación. Las actividades de evaluación son parte de un proceso de aprendizaje más amplio que promueve la apropiación y establecimiento de procedimientos que permitan mejorar los programas y proyectos promovidos por la organización.

-

Consideraciones políticas

Es importante dar la información más oportuna a la gente más apropiada para fomentar el uso de la evaluación. Para ello hay que establecer los vínculos de relaciones adecuados durante el proceso de evaluación, entender cómo piensa la clase política e identifcar venatas de oportunidad para los resultados de las actividades de evaluación.

-

Evidencia

Proveer de buenas y creíbles evidencias es fundamental para el uso de los resultados de una evaluación. Estas evidencias contribuirán a reforzar creencias que ya existían o cambiar modos de pensar que contribuyan a la mejora continua.

-

Estrategia de comunicación y difusión de resultados

Es importante contar con una estrategia de comunicación y difusión de resultados que sea eficaz. Para ello es necesario preguntarse quién es el público al que va dirigida, cuáles son los intereses de ese público (contenido a difundir), cuál el momento más oportuno para hacerles llegar la información, y cómo hacerlo. Este cómo, el formato de comunicación, puede hacerse de muchas formas y bajo diferentes enfoques y herramientas. Para ello hay que tener en cuenta los diferentes intereses de las diferentes audiencias para diseñar productos diferenciados en nuestra estrategia: informes, resúmenes, pdfs interactivos en la red, informes visuales hechos con diapositivas, folletos, boletines, presentaciones orales, discusiones, exposiciones de fotos y posters, artículos periodísticos, escenas teatralizadas…

Referencias citadas:

Patton, M. Q. (2008). Utilization-Focused Evaluation (4ª Ed.). Thousand Oaks: Sage Publications.

About Carlos Plaza

Hacer evaluaciones útiles: El uso del proceso y los resultados

“Producir datos es una cosa. Conseguir que se usen es otra bien distinta” (House, 1972). Un problema actual es la clasificación, absorción y utilización de la cantidad de información que se genera. Conseguir que la gente haga uso de los conocimientos que existen se ha convertido en una de las principales preocupaciones entre los diferentes sectores de la sociedad. Conseguir que la gente aplique los conocimientos que se generan en una evaluación, o incluso lo que ellos mismos ya saben, es un reto que hay que afrontar.

En ocasiones se ha denunciado un vacío entre el mundo de la evaluación y el mundo del trabajo práctico diario. Sin embargo, lo que prueba la eficacia y éxito de una evaluación es su uso e impacto a la hora de mejorar la realidad que evaluan. En una evaluación se ha de vincular la generación de conocimientos y resultados con su efectiva utilización para la toma de decisiones y la mejora continua. Se ha de luchar por superar la resistencia que muchas veces presentamos ante los nuevos conocimientos, ante el cambio.

Es importante evitar que los frutos de una evaluación se queden en un conjunto de informes que muchas veces ni se leen, ni se usan. La cuestión del uso de la evaluación surge de la necesidad de vincular el conocimiento y la acción (Patton, 2008), y plantea preguntas fundamentales sobre la toma de decisiones y la aplicación del conocimiento para la creación de un mundo mejor.

Siguiendo a Patton (2008) una de las cuestiones más importantes es la construcción de capacidades que aseguren el uso del proceso y de los resultados de la evaluación. Se trata de poner el acento en el aprendizaje en el contexto de una comunidad que aprende (learning organizations), de modo que la evaluación no se centre en generar unos resultados, sino que esos resultados se usen y se use también el proceso que ha llevado a obtener esos resultados, de modo que den lugar a cambios que mejoren las realidades evaluadas.

El uso de los resultados de evaluación está íntimamente unido al planteamiento que esta tenga dentro de las corrientes del aprendizaje, la teoría o las pruebas. Y así, los resultados de evaluación pueden utilizarse principalmente para mejorar los programas, generar conocimiento o juzgar el valor de una intervención. El reto para los evaluadores está en adaptar estos usos a cada contexto concreto, con unos usuarios concretos. Han de adaptar sus conocimientos y experiencia a los factores y circunstancias que puedan afectar al uso de la evaluación.

El uso del proceso está íntimamente unido a la participación. Participar en el proceso de evaluación puede ser más útil para los implicados que el simple conocimiento de los resultados. Gran parte del aprendizaje descansa en el proceso al que da lugar una evaluación, cuanto más gente participe en él mayores serán los beneficios de este proceso. Los resultados e informes finalizan, pero lo que permanece es la capacidad de los implicados de pensar en términos de evaluación y de mejora continua. “El uso del proceso es en sí mismo un impacto en forma de adquisición de capacidades” (Patton, 1999). En aquellas evaluaciones donde es importante la participación es necesario apostar por un adecuado uso del proceso como vía para el fortalecimiento y adquisición de capacidades, sin olvidar la importancia del uso de los resultados.

Referencias citadas:

House, E.R. (1972). The conscience of educational evaluation. Teachers College Record, 73(3), 405-414.

Patton, M. Q. (1999). Utilization- Focused Evaluation in Africa: Evaluation Training Lectures delivered to the Inaugural Conference of the African Evaluation Association. Ed. P.N. Chaiban and M. Patel.

Patton, M. Q. (2008). Utilization-Focused Evaluation (4ª Ed.). Thousand Oaks: Sage Publications.

About Carlos Plaza

Estándares de evaluación

Un proyecto pionero para el desarrollo de estándares profesionales para la evaluación de programas fue iniciado en Estados Unidos en 1975. Su objetivo era el de mejorar la evaluación de la educación y programas de formación. Se estableció un comité compuesto por 16 asociaciones profesionales de la educación, la Sociedad Americana de Evaluación (American Evaluation Association o AEA) y la Asociación Americana de Psicología. El resultado fue un conjunto de 30 criterios, el Programme Evaluation Standards (PES) organizados en torno a cuatro principios principales: utilidad, viabilidad, propiedad y precisión. Se describen a continuación estos principios que actualmente sirven de guía para asegurar la calidad de las actividades de evaluación.

Utilidad (Utilitity)

Como punto de partida es preciso destacar la utilidad de la evaluación, en la que ha de buscarse un uso concreto para agentes concretos. El resultado de una evaluación no puede considerarse satisfactorio si se limita únicamente a la exposición de los resultados alcanzados sin contribuir a que dicha exposición redunde en una mejora del desempeño general de las funciones propias de los actores involucrados en el objeto a evaluar. Por ello la metodología a emplear procurará hacer un uso adecuado del proceso de evaluación, así como de los resultados de evaluación (Patton, 1998; 2008). El objetivo es que la evaluación ayude a las personas o grupos interesados a: (1) tener acceso a las informaciones que necesitan para el desempeño de su actividad, (2) identificar los defectos y virtudes de lo evaluado y, (3) proponer soluciones a fin de mejorar el objeto que se evalúa. Este aspecto de utilidad comprende identificar las personas afectadas por la evaluación para poder dar respuesta a sus necesidades; dar credibilidad a los resultados para que tengan una máxima aceptación; seleccionar la información que permita responder a cuestiones pertinentes; describir cuidadosamente los enfoques, procedimientos y fundamentos utilizados para interpretar los resultados de modo que queden claras las bases de los juicios de valor; proporcionar información esencial y que se entienda fácilmente; y divulgar los resultados significativos y los informes de evaluación de manera que puedan utilizarse en el momento oportuno.

Unidos a este principio principal están otros principios como la credibilidad, claridad, puntualidad, diseminación de resultados, y la identificación de necesidades y valores.

Viabilidad (Feasibility)

Los procedimientos para llevar a cabo la evaluación no deben ser excesivamente complicados y sí eficientes. Han de garantizar que la evaluación se lleve a cabo de un modo realista, prudente y diplomático, que se hayan ponderado todos los puntos y tenido en cuenta los costes. Este aspecto de viabilidad comprende diseñar procedimientos prácticos de evaluación que permitan reducir al mínimo las interrupciones y molestias mientras que se obtiene la información necesaria; anticiparse a las diferentes posiciones de los diversos grupos de interés, de manera que pueda lograrse su cooperación y puedan evitarse o contrarrestarse los posibles intentos de cualquiera de estos grupos para limitar las actividades de evaluación o para sesgar o usar indebidamente los resultados; y producir informaciones con el suficiente valor, de modo que puedan justificarse los recursos empleados. Este principio comprende así fundamentalmente la viabilidad en términos políticos, prácticos y de coste-eficacia.

Propiedad (Propriety)

La evaluación debe estar basada en compromisos explícitos que aseguren la necesaria cooperación, la protección de los derechos de las partes implicadas y la honradez de los resultados, además debe proporcionar un informe equilibrado que ponga de manifiesto tanto aciertos como errores del objeto que se evalúa. Este aspecto de propiedad comprende diseñar la evaluación para ayudar a las organizaciones a atender y responder con eficacia a las necesidades de toda la variedad de participantes destinatarios; acordar las obligaciones de las partes formales de una evaluación (qué debe hacerse, cómo, por parte de quién, cuándo); diseñar la evaluación respetando y protegiendo los derechos y el bienestar de las personas; realizar una evaluación completa y justa; asegurar que los resultados de la evaluación resulten accesibles a personas afectadas por la evaluación; y llevar a cabo el gasto de recursos mediante procedimientos de rendición de cuentas acertadas y de un modo éticamente responsable. Bajo este principio por tanto, la evaluación ha de conducirse legalmente, éticamente y bajo la consideración de aquellas personas involucradas en la evaluación así como los afectados por sus resultados.

Precisión (Accuracy)

El objeto, su evolución y su contexto deben estar claramente descritos. Han de garantizar que la evaluación presente y transmita las informaciones técnicas adecuadas referentes al programa objeto de evaluación, resaltando tanto los aspectos positivos como negativos. Este aspecto de precisión comprende describir y documentar con claridad y precisión el programa evaluado y su contexto, así como los propósitos y procedimientos de la evaluación; describir las fuentes de información utilizadas en la evaluación de un programa, de modo que pueda valorarse la adecuación de la información; elegir e implementar procedimientos de recogida de información válidos y fiables; procesar y revisar sistemáticamente la información recogida; analizar de modo apropiado y sistemático tanto la información cuantitativa como cualitativa, de modo que se responda eficazmente a las preguntas de evaluación; justificar las conclusiones a las que se llegue de modo que los interesados puedan valorarlas; y elaborar informes imparciales.

Unidos a este principio están otros como la adecuación técnica, el análisis del contexto, el uso de fuentes de información defendibles e información válida y confiable, llegar a conclusiones justifidas y la imparcialidad.

Un principio extra: la flexibilidad

En muchas ocasiones el objeto a evaluar se encuentra indisolublemente unido a la acción de las personas y evolución en el tiempo. Esto implica un grado de incertidumbre a la hora de acometer la evaluación, en función del comportamiento de los individuos, grupos, y el conjunto de las instituciones y organizaciones en respuesta a cada nuevo paso que se da. Por consiguiente uno de los requisitos que se deben tener en cuenta es el grado de flexibilidad para adaptar la evaluación a la receptividad de los actores y a sus dinámicas internas. En el caso de los proyectos de desarrollo el camino elegido para la ejecución de una intervención es un elemento determinante de su calidad, puesto que es el propio proceso de desarrollo apoyado o impulsado el objetivo principal de la intervención. Esta visión, que pone el énfasis en la calidad del proceso de desarrollo como base para su sostenibilidad, más que en los resultados directos y a corto plazo, exige poner la atención de la evaluación en los procesos que se ponen en marcha a través de cada proyecto y los aprendizajes que genera.

Referencias citadas:

Patton, M. Q. (1998). Discovering process use. Evaluation, 4(2), 225-233.

Patton, M. Q. (2008). Utilization-Focused Evaluation (4ª Ed.). Thousand Oaks: Sage Publications.

About Carlos Plaza

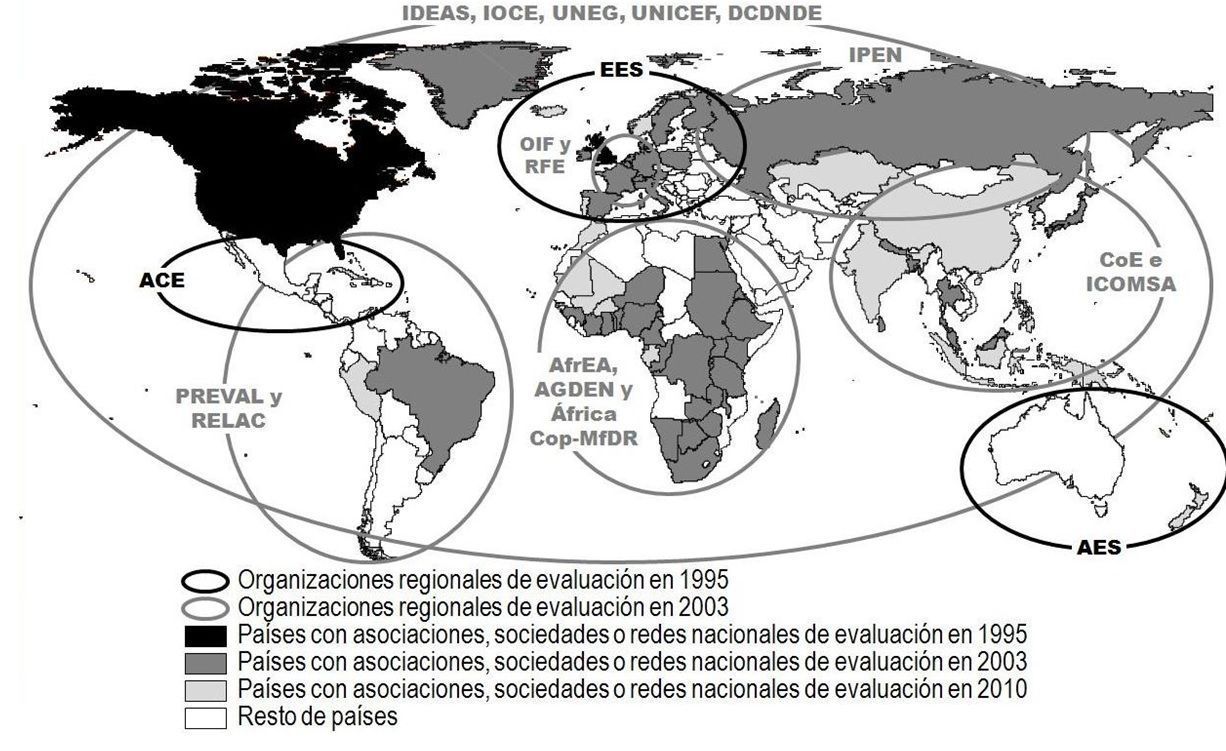

El incremento de las asociaciones y redes de evaluación

Un indicador claro del crecimiento de la cultura de la evaluación en el contexto internacional es el crecimiento exponencial de las asociaciones y redes de evaluación en estos últimos años. Actualmente existen más de 100 organizaciones nacionales y regionales de evaluación y se está consolidando la creación de una comunidad internacional de evaluación.

Parte del trabajo de estas asociaciones consiste en el desarrollo de estándares, valores y principios que guíen la evaluación, y en la orientación a sus miembros en la definición de estos valores. También existen asociaciones que no tienen este objetivo y se centran más en la difusión de la cultura de la evaluación y en el desarrollo de capacidades, prácticas y métodos. Las directrices desarrolladas por las sociedades de evaluación no tienen carácter normativo, más bien son recomendaciones de distintos profesionales sobre lo que la evaluación debe aportar a la sociedad, respetando a la población con la que se trabaja.

En 1975 se inició en Estados Unidos un proyecto pionero para el desarrollo de estándares profesionales para la evaluación de programas (Joint Committee on Standards for Educational Evaluation). Su objetivo era mejorar la evaluación de los programas de formación. Se constituyó un comité compuesto por 16 asociaciones profesionales entre las que se encontraba la Sociedad Americana de Evaluación. El resultado fue el Programa de Estándares de Evaluación (Programme Evaluation Standards, PES), una lista de control de la calidad de los trabajos de evaluación, formada por 30 criterios reunidos en cuatro categorías: utilidad, factibilidad, honorabilidad y precisión; que son los cuatros grupos de estándares exigibles a una evaluación.

En 1989, el PES fue aprobado por el American National Standards Institute, y actualmente se emplea en la mayor parte de las evaluaciones. En algunas zonas con marcadas diferencias culturales (como Asia o África) existen grupos de trabajo para adaptar el PES a sus propios contextos. Organismos donantes han empleado también el PES para comprobar la calidad de las evaluaciones de proyectos implementados en los países en desarrollo.

Mapa de la evolución de las organizaciones regionales y nacionales de evaluación.

Mapa de la evolución de las organizaciones regionales y nacionales de evaluación.

Desde la fundación de la Canadian Evaluation Society (CES) en 1981 y la American Evaluation Association (AEA) en 1986, el ritmo de nuevas fundaciones se ha ido incrementando progresivamente. En 1995 había 6 organizaciones regionales y nacionales de evaluación ; en 1998 pasaron a ser 12 y en 1999 eran ya más de 20 (contando no solo asociaciones sino también nuevas formas de organización como redes y foros). Desde 2003 hasta la actualidad el número de asociaciones regionales de evaluación se ha mantenido constante, si bien el número de organizaciones nacionales ha crecido muy significativamente, pasando de 20 en 2003 a más de 100 en la actualidad.

La Sociedad Europea de Evaluación SEE (European Evaluation Society, EES), se fundó en 1994. Desde entonces ha tenido un papel fundamental en la promoción y creación de las diversas sociedades nacionales que existen en la práctica totalidad de los países europeos . Únicamente la United Kingdom Evaluation Society existía antes de la creación de la Sociedad Europea de Evaluación.

En 1999, se creó la Asociación Africana de Evaluación (African Evaluation Association, AfrEA) como una red informal de evaluación bajo el auspicio de UNICEF. Posteriormente varios países africanos se propusieron crear sus propias asociaciones o redes nacionales de evaluación. El número de asociaciones pasó de 6 en 1999 a 16 en el 2001, y llega a 44 en la actualidad. Además, existen redes de profesionales de evaluación en 27 países, aunque algunas de ellas están todavía en periodo de formación. Otros trece países más participan (sin sociedades propias de evaluación) en las actividades de la AfrEA. También cabe destacar que África es el continente con mayor número de organizaciones regionales de evaluación con un total de cuatro : African Evaluation Association (AfrEA), Africa Gender and Development Evaluation Network (AGDEN), African Community of Practice on Managing for Development Results (AfricaCop-MfDR) y Monitoring and Evaluation East Africa Network (Mandeea).

En el área asiática, las primeras asociaciones en establecerse fueron las de Israel en 1998, Malasia en 1999 y Sri Lanka también en 1999. En 2003 surgieron tres nuevas asociaciones y dos foros, y en la actualidad, la evaluación se ha extendido a 23 países asiáticos, algunos de ellos de especial relevancia como China o India. También se ha avanzado en la creación de asociaciones formales de evaluación en países en los que solo existían foros o redes .

En Oceanía tenemos la Australasian Evaluation Society (AES) y en el 2000 se creó la International Program Evaluation Network (IPEN) que incluye a nueve antiguos países de la URSS: Armenia, Azerbaiján, Bielorrusia, Georgia, Kazajstán, Kyrgyzstan, Rusia, Tayikistán, Ucrania.

En Latinoamérica, al igual que en África, las organizaciones internacionales han tenido un papel destacado en la creación de asociaciones de evaluación. Los dos elementos más importantes en este sentido han sido la creación de la Asociación Centroamericana de Evaluación (ACE) en 1994, y PREVAL en 1996, una plataforma para el fortalecimiento de las capacidades de evaluación en el ámbito de los proyectos para el alivio de la pobreza de zonas rurales de América Latina y el Caribe, ambas bajo los auspicios del Fondo Internacional de Desarrollo Agrícola (FIDA).

En la actualidad, el apoyo de organismos internacionales, ha posibilitado la creación en Latinoamérica de más sociedades de evaluación. En los últimos años se han creado asociaciones de ámbito, tanto regional ─como la Red de Seguimiento, Evaluación y Sistematización en América Latina y el Caribe (RELAC)─ como nacional ─la Agencia Brasileña de Evaluación, la Asociación Brasileña para la Evaluación de la Educación, la Red Cubana de Evaluación o la Red Peruana para el Monitoreo y la Evaluación─.

About Carlos Plaza

La internacionalización de la evaluación

La construcción de una comunidad internacional de evaluación supone una gran oportunidad para todos de aprender de los demás y llegar más lejos en la profesión de la evaluación. En esta línea, en noviembre de 1995 las sociedades canadiense y americana de evaluación promovieron una conferencia en Vancouver, British Columbia, en colaboración con las otras tres grandes sociedades existentes en esa fecha en Centroamérica, Australasia y Europa. El tema de la conferencia fue: La evaluación para un nuevo siglo. Una perspectiva global. Fue la primera conferencia realmente internacional con 1600 evaluadores de 65 países de los cinco continentes y supuso un momento decisivo para la historia de la evaluación y la creación de una comunidad internacional de evaluación.

En 1997, la Sociedad Europea de Evaluación (EES) organizó una conferencia en Estocolmo. De entre los 280 profesionales de 30 países que asistieron a la conferencia surgieron los objetivos de aumentar los afiliados de la sociedad y extender las redes profesionales de trabajo (Furubo, 1997).

Por otro lado, también en 1997, una discusión sobre el carácter internacional de la evaluación tuvo lugar en EVALTALK, una lista de discusión (listserv) de la Sociedad Americana de Evaluación (AEA). Uno de los temas discutidos fue la creación de una federación de organizaciones nacionales de evaluación. Poco después, el International & Cross-Cultural Topical Interest Group (I&CCE TIG)[1] invitó a los presidentes de nueve organizaciones nacionales y regionales de evaluación para debatir las ventajas de esta futura federación durante la conferencia de la AEA de 1998. En esta conferencia se discutieron varias ideas y posiciones respecto del desarrollo de un foro internacional para la cooperación entre las organizaciones de evaluación. Como seguimiento, se reunieron nuevamente durante la conferencia de la AEA de Orlando, Florida, en 1999.

Una donación otorgada por la W.K. Kellogg Foundation permitió a los presidentes o representantes de 15 asociaciones nacionales y regionales de evaluación que sostuvieran una reunión en Barbados, Indias Occidentales, en febrero del 2000. Asistieron como observadores la W.K. Kellog Foundation, la Universidad de Indias Occidentales, el Banco de Desarrollo del Caribe y el Capital Development Fund de Naciones Unidas. Esta reunión produjo una propuesta para una Organización Internacional para la Cooperación en Evaluación OICE (IOCE por sus siglas en inglés: International Organization for Cooperation in Evaluation), la que fue circulada en la lista de discusión EVALPRES para los presidentes de organizaciones de evaluación y endosada formalmente por los participantes en la reunión de Barbados. Los principios y acuerdos registrados en dicho documento se consideraron como no negociables y como la plataforma para la planificación de la asamblea inaugural de la IOCE. En marzo del 2002 tuvo lugar una reunión en la República Dominicana como continuación a la de Barbados, donde se realizó el planeamiento explícito para una Asamblea Inaugural de la IOCE en marzo de 2003 en Lima.

La IOCE quedó así constituida como una organización flexible formada por entidades de evaluación nacionales y regionales que actúa a nivel mundial, dedicada al fortalecimiento del liderazgo y la capacidad de evaluación en países en desarrollo, al fomento de la interrelación entre teoría y práctica de la evaluación por todo el mundo así como a potenciar la evaluación como profesión, con la finalidad de disponer de una visión global en un intento de contribuir a la identificación y propuesta de soluciones en la problemática del desarrollo en el mundo.

La creación de esta organización internacional y las discusiones tenidas a través de EVALPRES termina de confirmar la importancia de internet en la internacionalización de la evaluación, permitiendo trabajar en red y contar con la participación desde distintos puntos del planeta. A través de internet se ha ido fomentando el discurso sobre la construcción de una comunidad internacional de evaluación y se ha ido contando con el apoyo de las asociaciones de evaluación. La web de la AEA ha servido de soporte en todo el proceso.

A día de hoy, internet es también la herramienta más utilizada por los evaluadores a la hora de adquirir, compartir y enseñar sus conocimientos. Y así los evaluadores dedicados a determinados temas están constituyendo redes que les permita realizar un efectivo intercambio profesional. Es el caso de la International Development Evaluation Association (IDEAS) una iniciativa surgida en 2001 donde el PNUD y el Banco Mundial se unieron para crear una red internacional de profesionales con especial preocupación por las necesidades de los evaluadores en los países en vías de desarrollo. El PNUD y el Banco Mundial en colaboración con el UK Departament for International Development (DFID) patrocinaron una reunión en mayo del 2001 en Londres que culminó con la llamada London Declaration on the Stablishment of IDEAS con cinco principios básicos: estará enfocada al desarrollo de la capacidad de evaluación, pluralidad, subsidiariedad, peso dominante de los países en vías de desarrollo en su gobierno y eficiencia.

Actualmente existen numerosas asociaciones internacionales, algunas de ellas especializadas en intervenciones de desarrollo rural: Network of Networks on Impact Evaluation (NONIE), Active Learning Networkfor Accountability and Performance in Humanitarian Action (ALNAP), International Organization for Collaborative Outcome Management (IOCOM), Evaluation Cooperation Group (ECGnet), DAC Network on Development Evaluation (OECD/DAC EvalNet), United Nations Evaluation Group (UNEG) y UNICEF. Otras están especializadas en evaluaciones de impacto ambiental: Climate-Eval (GEF) and Environmental Evaluators Network (EEN).

Además, la IOCE junto con UNICEF y otras organizaciones más, pusieron en marcha una asociación innovadora, EvalPartners, para mejorar las capacidades de las organizaciones voluntarias para la evaluación profesional (VOPEs del inglés Voluntary Organizations for Professional Evaluation), un término que agrupa todo tipo de grupos interesados en hacer avanzar la profesión de la evaluación, grupos de la sociedad civil que pueden funcionar a niveles regionales o nacionales y que reúnen evaluadores de diversos campos. El objetivo es influir en los responsables políticos, en la opinión pública y en otros actores para que las políticas públicas, basándose en la evidencias, tomen decisiones equitativas y eficaces.

Destacar también como hito la Tercera Conferencia Internacional sobre la capacidad nacional de evaluación organizada en São Paulo (Brasil) en septiembre de 2013, donde se designó el año 2015 como el Año Internacional de Evaluación. Una de las razones por las cuales se designó este año fue que los Objetivos del Milenio serían reemplazados por un nuevo conjunto de objetivos acordados a nivel internacional llamados Objetivos de Desarrollo Sostenible. La agenda del año internacional de la evaluación se puede encontrar en http://mymande.org/evalyear/evaluationtorch2015, un conjunto de eventos donde los temas elegidos para su discusión fueron:

- La identificación de las prioridades clave de la comunidad de evaluación global para poner en marcha el Programa de Evaluación Global 2016-2020.

- El cierre de la brecha entre la comunidad de evaluación (oferta) y la comunidad de políticos (demanda), para asegurar una buena calidad, igualdad y la evaluación con perspectiva de género.

- La incorporación de las evaluaciones centradas en la igualdad y perspectiva de género en los Objetivos de Desarrollo Sostenible a nivel internacional, y en las estrategias nacionales de desarrollo a nivel nacional.

- El desarrollo centrado en la igualdad de género en políticas de evaluación nacional.

La antorcha de la evaluación del Evalyear fue encendida en el edificio de la ONU en Nueva York en diciembre de 2014 con el objetivo de viajar por todo el mundo a través de 28 países y terminar en el Foro Global EvalPartners donde culminar la celebración del Año Internacional de Evaluación y lanzar las siguientes iniciativas:

- Celebración el Año Internacional de Evaluación en un parlamento nacional.

- Lanzamiento de la Agenda Global de Evaluación 2016-2020.

- Lanzamiento del Foro Mundial de Parlamentarios para la evaluación.

- Lanzamiento de la EvalGender+ , la alianza mundial para las evaluaciones centradas en la igualdad y perspectiva de género.

- Lanzamiento de la EvalYouth, la alianza mundial para evaluadores jóvenes.

About Carlos Plaza

Principales aportes de la Evaluación que han motivado su expansión

La utilidad de la evaluación está en función de la corriente en la que nos posicionemos: ayudar a interpretar los resultados obtenidos con la aplicación de una determinada política, programa o proyecto (corriente de la teoría); obtener evidencias de que esa política, programa o proyecto funciona (corriente de las evidencias); o aprender y sacar lecciones de experiencia de su implementación (corriente del aprendizaje), si bien estas corrientes no son independientes y la mayoría de las veces la utilidad de una evaluación puede hallarse a caballo entre varios de estos beneficios.

La evaluación como fuente de valores

Como ya se ha mencionado, la evaluación consiste en llegar a un juicio sobre el mérito valor o importancia de unos hechos. Por ello el evaluador necesita un sistema de valores con el que aproximarse a la realidad que se debe juzgar, un sistema que el evaluador ha de descubrir y precisar su aplicación conjuntamente con los involucrados. De este modo, la evaluación se basa en teorías del valor que ayudan a juzgar los hechos; y en teorías de la práctica que aportan métodos y herramientas de evaluación.

No se trata solo de juzgar los resultados esperados y planificados sino también las consencuencias inesperadas de una intervención, pues los efectos secundarios son muchas veces importantes. También es importante fijarse no solo en el corto plazo sino pensar en el largo plazo y la sustentabilidad de los impactos logrados. Otros dos aspectos importantes a la hora de dirimir el juicio son los procesos por los que se consiguen los resultados (implementación ética) y los costes (que sean razonables). No se pueden juzgar los resultados con independiencia del proceso que los ha originado y los costes que han implicado.

La evaluación como fuente de evidencias para la toma de decisiones y sus implicaciones políticas

Una cuestión importante de la evaluación está en diferenciar lo que es bueno y aportar evidencias sobre lo que funciona y merece la pena seguir apoyando. Por ello todo trabajo de evaluación tiene implicaciones políticas en la manera de enfocar los temas, en la toma de decisiones, en la percepción de la intervención por la población y sobre todo, en los intereses que se toman en consideración. Es importante que los evaluadores comprendan la implicación de sus acciones y mantengan un diálogo continuo con todos los grupos de interés implicados.

Las evidencias aportadas por la evaluación permiten abrir un proceso de reflexión —tanto de lo que funciona como de lo que no—, y así mejorar las intervenciones y cumplir los objetivos planteados. De esta forma, la evaluación tiene un papel destacado en la toma de decisiones y en la justificación de las mismas, buscando metodologías adecuadas para comparar, elegir y descartar proyectos alternativos en un escenario de escasez de recursos. Se trata de justificar donde localizar los recursos que son siempre escasos.

En cualquier caso la evaluación está resultando clave para la transparencia política, la obligación de rendir cuentas con responsabilidad (accountability) de los gastos realizados y para la demostración de la eficacia de la gestión pública. La cuarta conferencia de la Sociedad Europea de evaluación, en octubre de 2000, trató sobre el papel de la evaluación en el mantenimiento de los sistemas democráticos, un tema que invitaba a pensar sobre el importante papel de esta disciplina hoy en día.

La evaluación como fuente de aprendizaje y capacitación

En las actividades de evaluación suelen distinguirse dos usos: el uso de los resultados —normalmente plasmados en un informe final de evaluación— y el uso del proceso, entendiéndose por éste todas las actividades de evaluación que llevan a obtener los resultados. En la evaluación de intervenciones en desarrollo es especialmente interesante el uso del proceso de evaluación, frente al uso exclusivo que muchas veces se hace de los resultados para demostrar que las inversiones funcionan. Un adecuado uso del proceso —mediante el fomento de la participación de los agentes— vincula el conocimiento y los resultados generados en la evaluación con procesos de adquisición de capacidades en la población. Estas capacidades permiten a la población servirse de las herramientas de la evaluación para gestionar su desarrollo, conducirlo en la línea de la mejora continua y obtener evidencias que sustenten la toma de decisiones. Además, también puede ayudar a superar la resistencia natural que, en ocasiones aparece ante el cambio. El uso del proceso es, en sí mismo, un impacto en forma de adquisición de capacidades.

En la evaluación del desarrollo, es bueno que además de la elaboración de un juicio, haya una preocupación seria por desencadenar procesos de aprendizaje ya que los resultados e informes finalizan, pero los aprendizajes y capacidades adquiridas por los implicados permanecen. Sin embargo no se puede olvidar la importancia del uso de los resultados. El reto para los evaluadores está en adaptar ambos usos a cada contexto concreto.

Planteamiento actual

Hay que reconocer que después de más de 50 años de asistencia internacional, han sido muchos los avances que se han dado en los enfoques, técnicas, procesos y resultados de evaluación. Hoy en día existen profesionales de evaluación en todas las regiones del mundo. Se ha creado una masa crítica de profesionales que está en capacidad de responder a la demanda creciente de estas actividades.

Además el S&E se está beneficiando de un intercambio general de experiencias, lecciones extraídas y técnicas innovadoras de análisis comparativo. Potenciados por las facilidades de comunicación electrónica, en casi todas las regiones del mundo se están constituyendo asociaciones de profesionales de la evaluación. Estas asociaciones a su vez están impulsando el intercambio de experiencias, escritos, publicaciones; y, están facilitando el establecimiento de alianzas estratégicas entre sus miembros.

Hasta ahora, la evaluación se había dado solamente en el ámbito técnico, con metodologías e instrumentos que dependían y tenían su origen en la esfera de la investigación científica. Hoy esto está cambiando y se está diferenciando más y más del control contable y la investigación. La evaluación está evolucionando y se propone hoy en día como instrumento de manejo ejecutivo en apoyo de la ejecución, evaluación de impactos y transparencia administrativa.

About Carlos Plaza

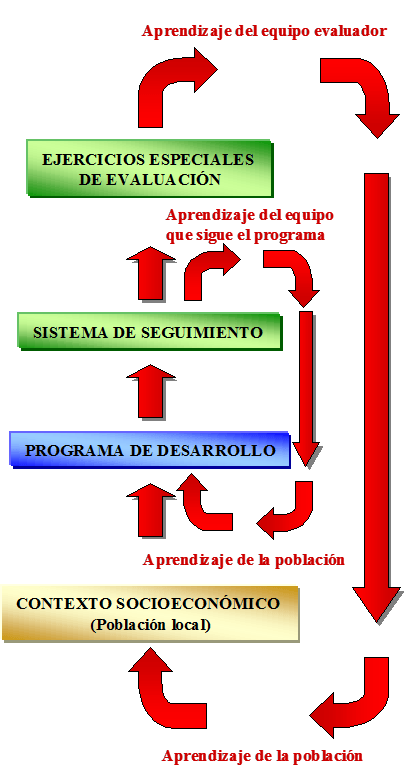

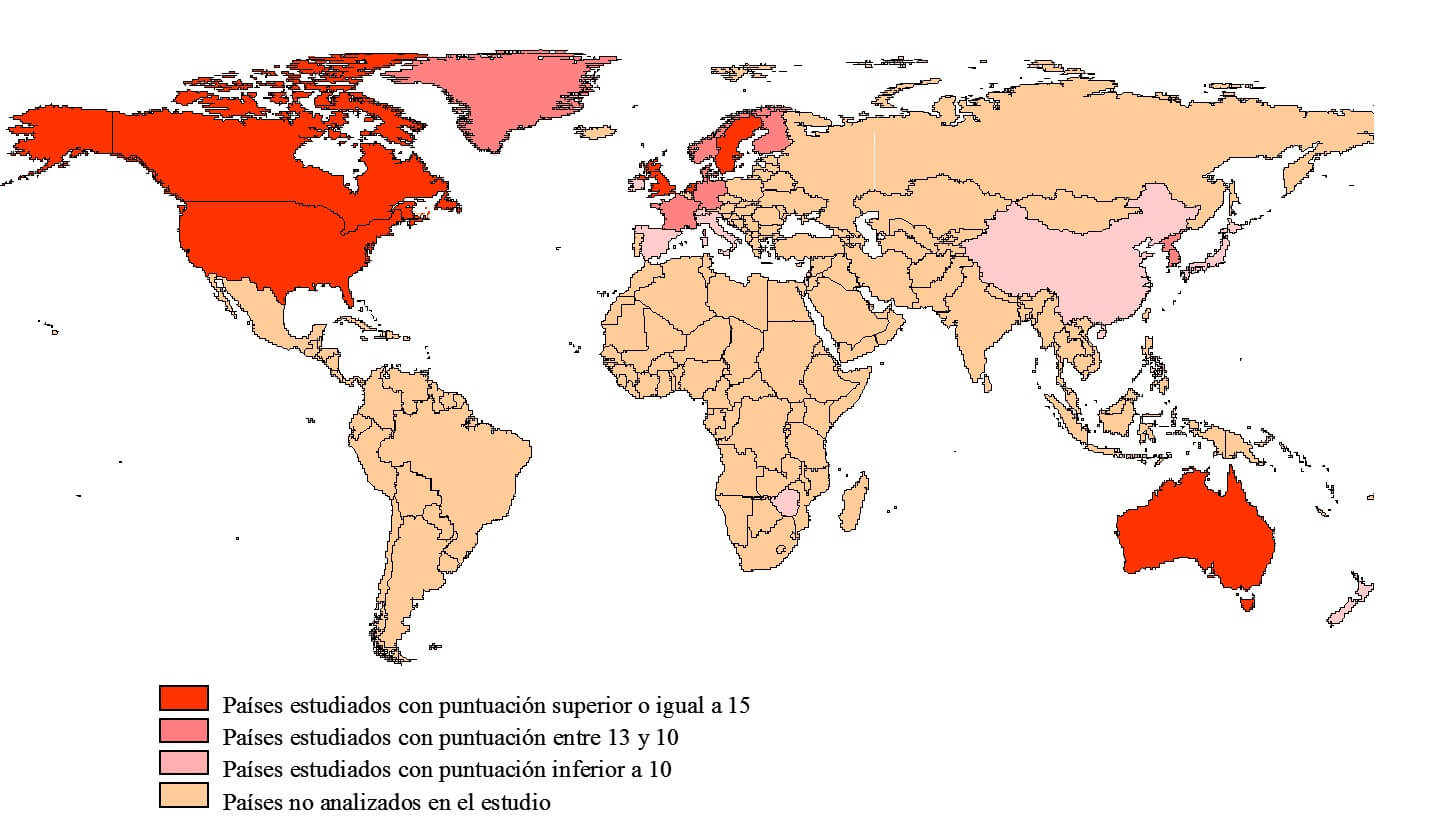

¿Se puede medir la cultura de evaluación de un país?

Aunque el proceso de adopción de prácticas evaluativas atienda a las mismas razones en los diversos países, su grado de utilización e institucionalización, así como la cultura de evaluación alcanzada, es muy diferente.

Estas diferencias se relacionan, por un lado, con el hecho de que sean los parlamentos quienes cuenten con competencias en el ámbito de la evaluación o, por el contrario, éstas recaigan únicamente sobre los niveles ejecutivos. Por otro lado, también está relacionado con los distintos niveles de centralización o descentralización existentes. Países como Canadá y Suecia, desde mediados de los años setenta, y Gran Bretaña en 1983, han llegado a constituir Unidades Especializadas en el Control y la Evaluación de las Políticas Públicas siguiendo el modelo de la GAO Norteamericana.

La pregunta que podríamos formularnos es si es posible medir la cultura de la evaluación de un país, y si alguien ha intentado medirla. La respuesta es que sí. Un estudio realizado sobre la evaluación de las políticas públicas en 21 países de los cinco continentes que lleva por título International Atlas of Evaluation (Furubo et al., 2002) concluye con la elaboración de un ranking sobre el estado de la cultura de la evaluación entre esos 21 países. Los indicadores utilizados fueron:

- Campos de la política donde se realiza evaluación.

- Suministro de evaluadores nacionales en distintas disciplinas.

- Discurso nacional referente a la evaluación.

- Organizaciones profesionales.

- Grado de institucionalización en el Gobierno.

- Grado de institucionalización en el Parlamento.

- Pluralismo de las instituciones o de los evaluadores que llevan a cabo las evaluaciones en cada campo de la política.

- Evaluación en el Tribunal General de Cuentas

- Proporción de evaluaciones resultantes en relación con los resultados y procesos de evaluación.

El resultado de aplicar esos indicadores podemos verlo en el siguiente mapa donde se ve que los países con mayor cultura evaluadora se sitúan en norteamérica y norte de Europa, además de Australia:

Mapa del estado actual de la cultura de la evaluación en 21 países. Fuente: Elaboración propia a partir de Furubo et al., 2002

Sobre un total de 18 puntos los resultados se reflejan en la siguiente tabla:

Resultados del estudio del estado actual de la cultura de la evaluación en 21 países. Fuente: Elaboración propia a partir de Furubo et al., 2002

En el caso de la Unión Europea, donde se aprecia una alta cultura de evaluación, es en 1988 cuando la evaluación queda institucionalizada. La reglamentación europea introduce la obligatoriedad de evaluar los programas cofinanciados por sus fondos que cubren una gran variedad de ámbitos de actuación. Desde entonces, se han llevado a cabo un gran número de evaluaciones en todos los países miembros. En Europa la institucionalización de las prácticas está requiriendo de un cuerpo común más unificado y un direccionamiento adecuado, siempre desde un planteamiento flexible que ayude a la mejora generalizada en la concepción de los procesos evaluativos y, por extensión, en la obtención de resultados útiles y en la aplicación/integración de los mismos.

Referencias citadas:

Furubo, J.E., Rist, R.C. & Sandahl, R. (2002). International Atlas of Evaluation. Comparative Policy Analysis Series. New Brunswick: Transaction Publishers.