Inicio » Entradas etiquetadas como «evaluación de proyectos» (Página 3)

Archivos de la etiqueta: evaluación de proyectos

Redacción de documentos de evaluación

Los informes de evaluación constituyen el principal flujo de información del programa hacia su exterior y han de suponer el resultado de todos los trabajos de seguimiento y evaluación realizados sobre un determinado programa hasta la fecha en que se está evaluando. Es cierto que están los informes de seguimiento y control pero ninguno de ellos tiene la profundidad y alcance de un ejercicio especial de evaluación. Es por ello que, junto con el informe de programación, son los documentos de elaboración más cuidada. Los resultados de la evaluación deben ser presentados de modo que puedan ser entendidos y utilizados.

En muchas ocasiones las evaluaciones trascienden el nivel de análisis de un simple proyecto o programa y pasan a formar parte normalmente de ejercicios de evaluación realizados a otros niveles como planes regionales, nacionales… y por ello es necesaria su homogeneidad. Homogeneidad que no es sólo de metodología y análisis sino que también de redacción, contenido y estructura de los informes.

Estructura de los informes de evaluación

Con la mente puesta en estos casos, la estructura de los informes de evaluación debe ser tal que garantice el tratamiento de todos los aspectos esenciales y unos resultados comparables que permita su síntesis. La estructura puede consistir en un resumen, un informe principal y unos anejos. El conjunto, y desglosando el contenido del informe principal se debe contar con:

- Resumen: Con un máximo de 10 páginas, una breve descripción del trabajo realizado, la metodología aplicada y una síntesis de las conclusiones y recomendaciones del estudio, en forma de respuestas a las preguntas de evaluación.

- Introducción: Incluye una descripción del contexto del programa, características de la aplicación y finalidad de la evaluación.

- Explicación del enfoque metodológico: descripción de la concepción y análisis, recopilación de datos y fuentes utilizadas, así como la fiabilidad de los datos y las conclusiones.

- Presentación y análisis de la información recopilada: información financiera y realizaciones, información sobre los beneficiarios utilizada, respuestas a las preguntas comunes, constataciones en relación con las preguntas específicas del programa, etc.

- Conclusiones y recomendaciones en relación con los objetivos de las políticas implementadas, los objetivos específicos del programa, la eficacia, eficiencia, utilidad y sostenibilidad de los resultados.

- Anexos.

Calidad de los informes de evaluación

Los informes de evaluación deben tener una calidad adecuada. Para ello podemos analizar el cumplimiento de los siguientes criterios extraídos del volumen I de la colección MEANS (Comisión de la UE, 1999):

- Satisfacción de necesidades: ¿Satisface apropiadamente la evaluación las necesidades de información? ¿se ajusta al pliego de condiciones?

- Alcance pertinente: ¿Se analiza plenamente la motivación del programa, sus realizaciones, resultados e impacto, incluida la interacción entre las diversas medidas y sus consecuencias, previstas o imprevistas?

- Concepción adecuada: ¿Está concebida la evaluación de forma apropiada para garantizar que queden recogidas la totalidad de las constataciones, así como las limitaciones metodológicas, para responder a las preguntas de evaluación?

- Datos fiables: ¿En qué medida los datos primarios y secundarios recopilados o seleccionados son apropiados, esto es, ofrecen un grado de fiabilidad adecuado para el uso a que se destinan?

- Análisis sólido: ¿Se analiza la información cuantitativa y cualitativa apropiada y sistemáticamente, conforme a las técnicas más avanzadas, de modo que sea posible responder a las preguntas de evaluación de forma válida?

- Constataciones fiables: ¿Las constataciones hechas son la consecuencia lógica de un análisis de datos y una interpretación, basados en hipótesis racionales y cuidadosamente descritas, que constituyen su justificación?

- Conclusiones imparciales: ¿Son las recomendaciones justas, sin que en ellas se interfieran opiniones personales o intereses particulares, y lo suficientemente detalladas, de manera que puedan ponerse en práctica?

- Informe claro: ¿Se describe claramente el programa evaluado, incluidos el contexto y finalidad del mismo, así como los procedimientos y constataciones de la evaluación, de modo que la información aportada pueda comprenderse fácilmente?

Informe principal

El informe principal ha de contener los aspectos esenciales que describen el programa que se evalúa, la metodología empleada y los resultados de la evaluación realizada: sus conclusiones y recomendaciones.

La descripción del programa ha de abarcar de modo breve la descripción del programa ─estrategias, medidas, objetivos, modos de gestión y financiación─ y su contexto. Dentro de este contexto, hacer un escueto repaso del contexto territorial (el capital con el que cuenta el territorio), del contexto legal e institucional. Esta descripción enmarca la evaluación y facilita la interpretación de los resultados en el caso de una persona ajena al territorio. Se proporciona así una herramienta para comprender mejor las circunstancias que rodean la intervención.

La descripción de la metodología empleada debe ceñirse a lo escuetamente necesario para comprender los pasos seguidos con la evaluación. Marco legal de referencia, aspectos principales que se evalúan, definición de preguntas clave de evaluación, metodología de respuesta, nivel de análisis escogido y fuentes de información. Se trata de introducir lo que constituye el grueso del documento: los resultados de la evaluación llevada a cabo. Una vez familiarizado con la metodología empleada la lectura de este tercer bloque ha de resultar más fácil y comprensible.

Los resultados de la evaluación realizada pueden comenzar con un repaso de las actividades de control, seguimiento y evaluación desarrolladas hasta la fecha. Las conclusiones de este repaso nos llevan a la descripción de los resultados obtenidos. Primero con respecto al planteamiento y lógica de intervención respondiendo a la pregunta sobre si la programación ha sido la adecuada: finalidad, criterio, análisis, respuesta y limitaciones a la respuesta.

El segundo bloque los constituye la aplicación del programa y su gestión respondiendo a la pregunta de si se ha seguido la programación prevista y de si esto se consiguió con una gestión adecuada: finalidad, criterio, análisis, respuesta y limitaciones a la respuesta.

El tercer bloque resume las respuestas a las preguntas sobre los resultados e impacto del programa. Comenzando con las preguntas específicas el bloque termina con el análisis de las preguntas globales. Todas las preguntas estructuradas por su finalidad, criterio, análisis, respuesta y limitaciones encontradas.

El documento debe finalizar con una serie de conclusiones y recomendaciones que extraigan todo el aprendizaje que se pueda concluir tras la realización de la evaluación. Esto facilita el aprendizaje de quién se propone la mejora del programa evaluado (evaluación intermedia) o la mejora de una posterior programación (evaluación final).

Resumen

El informe principal ha de estar acompañado por un breve resumen con los datos básicos sobre el programa, la metodología de evaluación y sobre todo, sobre los resultados de la evaluación: conclusiones y resultados. El resumen facilitará la difusión de estas conclusiones y recomendaciones y posibilitará su puesta en práctica así como su difusión a todas las instituciones implicadas en el programa. También resulta fundamental para la agregación de resultados en posibles evaluaciones a niveles superiores de análisis.

Anejos

El informe principal también ha de ir acompañado de una serie de anejos. La función de estos anejos es la de descargar al informe principal de información que no es básica y se facilite así su lectura. Tablas de datos, información excesivamente desagregada o especializada, encuestas realizadas, datos financieros, explicaciones más detalladas de algunos aspectos… Es información valiosa pero su inclusión en el informe principal dificultaría su lectura más que ilustrar los resultados obtenidos. Cualquier persona interesada en profundizar en algún aspecto concreto de la evaluación puede acudir a los anejos y encontrarla allí.

Pueden incluirse anejos que describan con mayor precisión y especialización la metodología empleada, la participación social realizada o la gestión interna de los programas. Otros anejos pueden condensar toda la información obtenida, fuentes y datos estadísticos, datos financieros del programa, fuentes documentales e informáticas consultadas. Otros pueden tratar con más extensión los informes y controles realizados con anterioridad al programa o desarrollar con más extensión toda la normativa aplicable.

Referencias citadas:

COMISIÓN DE LA UNIÓN EUROPEA (1999). The MEANS collection: Evaluating socio-economic programes. From the programme entitled MEANS: Means for Evaluating Actions of a Structural Nature. Directorate General XVI for Regional Policy and Cohesion. Office for Official Publications of the European Communities. Luxembourg.

About Carlos Plaza

Decidir el contenido de una evaluación a través de preguntas clave

Al diseñar y elaborar una evaluación comenzamos con la necesidad de determinar el nivel de análisis con que se van a abordar –junto con el cuidado de la homogeneidad para la comparación de resultados y organización de los flujos de información– y terminamos con la elaboración del documento final. Por el camino hemos de definir el contenido de la evaluación (por ejemplo a través de preguntas clave) y el modo de tratar cada uno de esos contenidos.

Toda evaluación comienza con el estudio del programa que se va a evaluar, de su contexto y política que lo enmarca. Este estudio permite comprender lo que se puede esperar del trabajo de evaluación que se va a llevar a cabo. A partir de entonces, se pueden definir las necesidades de información y comenzar a trabajar.

Definir el contenido de evaluación a través de preguntas clave

Decidido el nivel de análisis (local, regional, nacional o internacional) con el que se va a trabajar, es necesario realizar las evaluaciones de forma que pueda agregarse su información con otros trabajos de evaluación realizados bajo el mismo modelo. Un modo sencillo de conseguirlo lo constituyen las preguntas clave de evaluación. Junto a ellas se encuentra un conjunto de indicadores clave que se ha de definir representando parte de las respuestas y conclusiones a las que llega la evaluación.

El tratamiento de cada una de las preguntas clave –y en especial la respuesta, conclusiones y recomendaciones– ha de dar respuestas cualitativas concisas acompañadas de indicadores clave que permiten una agregación cómoda y sencilla. Es claro que la agregación a niveles superiores necesita de datos y métodos cuantitativos que faciliten esta agregación. Sin embargo no son suficientes y han de ir acompañados de datos y comentarios cualitativos que impidan que la información cuantitativa se desvirtúe en su flujo hacia niveles superiores.

La experiencia adquirida nos muestra que el fracaso que se obtiene en el campo de la evaluación es muchas veces consecuencia de no comprender y definir adecuadamente que se busca con una determinada evaluación. Para evitar esta primera desorientación, es interesante tener como guía la formulación de una serie de preguntas clave de evaluación, elaboradas específicamente para cada actuación de manera que permitan determinar cual es el objetivo y utilidad esperada de la evaluación que se emprende.

La definición de estas preguntas presupone un proceso previo de estructuración y es conveniente que vengan formuladas en los términos de referencia de la evaluación, con lo que desde el principio el cliente que encarga la evaluación deja claro que es lo que desea saber de la actuación que se puso en marcha.

Si es así, han de venir definidas de tal manera que al evaluador le ha de quedar claro que se espera de la evaluación y que aspectos son los que se han de tratar, pues como venimos viendo son muchos los aspectos que de un mismo programa podemos evaluar. Pero en muchos casos estas preguntas no vienen definidas y es el mismo evaluador el que ha de determinar un conjunto de preguntas clave que le permitan, a través de una metodología de respuesta, recoger adecuadamente la realidad del programa.

Las preguntas han de centrarse en los aspectos esenciales del programa sin descuidar con ello aspectos tradicionales como la importancia de las diferentes medidas previstas en el programa, el volumen de la financiación… Esto supone que, salvo en casos excepcionales, el modelo puede concentrarse en aquellas preguntas que respondan realmente a los aspectos clave y específicos del programa sin olvidar de tratar aspectos más generales. Esa especial dedicación no debe, de ningún modo, mermar el alcance y calidad de la evaluación.

En el caso de programas con un amplio ámbito de aplicación es especialmente delicado delimitar el interés de las preguntas. Por regla general, consideramos que se ha de hacer lo posible por no limitarlo a los beneficiarios del programa, sino que se ha de extender a los diferentes ámbitos administrativos que impliquen al programa (sectorial, regional, nacional, …). De este modo se garantiza la determinación de los resultados del programa en los diferentes niveles de intervención, aunque todo depende de cuales sean los objetivos de la evaluación que se está llevando a cabo. En definitiva se trata de establecer qué puedo evaluar para luego determinar qué quiero evaluar.

Tratamiento de cada pregunta: metodología de respuesta

En un modelo de evaluación basado en un conjunto de preguntas clave, es fundamental contar con una buena metodología de respuesta que permita tratar adecuadamente las cuestiones planteadas y sacar todo el provecho posible de cada una de ellas. Se establecen así para cada pregunta un conjunto de criterios e indicadores adaptados al programa, que permiten recopilar de forma coherente la información obtenida y evaluar los resultados conseguidos. También facilitan la agregación y comparación de los resultados.

Es recomendable aportar, en la medida de lo posible respuestas cuantitativas a las preguntas de evaluación, usando los indicadores apropiados. En cualquier caso siempre es necesario proporcionar una respuesta cualitativa bien justificada. Los pasos a seguir para el tratamiento de cada pregunta una vez formulada se señalan a continuación.

Finalidad y comprensión de la pregunta

Explicación de la pregunta haciendo una pequeña descripción de lo que se busca con ella. Es un punto donde se matiza, dentro de la amplitud de cada pregunta, lo que se va a estudiar en concreto y los aspectos en que se hará más hincapié. También se centra la aportación de la respuesta al contexto global de la evaluación y se da razón de su importancia para la evaluación.

Criterios para la evaluación

En este punto se especifican los criterios que ayudan a formular un juicio de valor sobre el éxito de los objetivos planteados a la vista de los resultados arrojados por los indicadores y demás información obtenida. Se trata de constatar los aspectos en los que nos vamos a fijar y el grado de exigencia con el que vamos a medirlos, para dar una respuesta a la pregunta.

El criterio sirve para evaluar el éxito de la ayuda examinada, al poner en relación el indicador con el resultado o impacto previsto. Dentro del criterio podemos distinguir lo que propiamente se llama criterio (aumento, disminución…) y el llamado nivel de objetivo, esto es, el nivel que ha de alcanzarse para satisfacer el criterio y concluir que se ha tenido éxito. Habitualmente, ese nivel se corresponderá con un objetivo cuantificado. Esta división es conveniente desde el momento en que los programas se crean en muchos casos para el logro de objetivos específicos de carácter regional, local o sectorial, en el marco de los objetivos fijados en una legislación más amplia. Por ello, para un determinado criterio puede ser necesario fijar diferentes niveles de objetivo en diversos programas.

El nivel de objetivo buscado (los niveles a los que el programa aspira) puede definirse en relación con un punto o línea básica de referencia, que normalmente será la situación de los beneficiarios al iniciarse el programa aunque puede venir dado por normas existentes o por el conocimiento de cuál es la mejor práctica en el sector, lo que se habrá determinado, por ejemplo, en la evaluación posterior de un programa anterior.

En la medida de lo posible es importante huir de una formulación genérica del nivel de objetivo dando simplemente una línea básica con un punto de referencia. Atendiendo a las características del programa y a las circunstancias locales hay que delimitarlo con mayor precisión.

Los niveles de objetivo buscados tendrían que venir expresados en el documento de programación a través de la evaluación previa. Pero no siempre el equipo evaluador se encuentra en esta situación. En muchas ocasiones no están definidos y es necesario hacerlo. Para ello se puede acudir a un nivel de objetivo expresado en forma más bien genérica dando una línea básica con un punto de referencia. En estos casos, corresponde al equipo evaluador, cuando proceda y atendiendo a las características del programa o a las circunstancias locales, delimitar el objetivo con mayor precisión.

Análisis para la respuesta

Se realiza aquí el análisis de toda la información obtenida para lograr una respuesta a la pregunta planteada lo más precisa posible. Son varias las tareas a realizar dependiendo de cada caso. Tras la recopilación y análisis de los datos y la posible necesidad de tener que reconstruir la situación de referencia es necesario tratar de definir algunos indicadores que permitan extraer algunas conclusiones y así responder a la pregunta.

Las preguntas pueden referirse a la eficacia, la eficiencia, la utilidad, etc., lo que hay que tener presente a la hora de recopilar información. Al mismo tiempo, para evaluar los efectos netos y lograr así que los resultados de la evaluación sean más fiables es necesario tener en cuenta factores exógenos, el efecto de desplazamiento, etc.

Una vez recopilados los datos, se efectúa la evaluación, analizándolos y determinando los efectos del programa concernientes a la pregunta que se esté respondiendo. Para analizar los datos y llegar a conclusiones que permitan formular un juicio, se pueden utilizar diversos instrumentos. La elección del instrumento depende del tipo de programa evaluado, su complejidad o el tipo de información que se busque. Así, por ejemplo, para formular un juicio en relación con aspectos específicos y bien delimitados del programa como son las realizaciones materiales, se puede recurrir al análisis coste-eficacia. En el caso de aspectos más complejos es más apropiada una técnica multicriterio.

Análisis de efectos

En algunos casos, deben analizarse los efectos de sustitución y de desplazamiento. Las entrevistas son útiles para determinar estos efectos. Posteriormente, puede determinarse el efecto neto del programa deduciendo del efecto bruto los efectos ajenos a la intervención, el efecto de sustitución y el de desplazamiento. Cuando proceda, deben analizarse también los efectos imprevistos, incluidos los negativos, y la influencia de factores exógenos significativos.

Con el fin de apreciar los efectos de complementariedad y de sinergia, hay que analizar la relación con otros programas y/o entre diversas medidas de un mismo programa. Distintas medidas o programas pueden generar un mismo impacto o reforzarse mutuamente.

También ha de plantearse el problema de los objetivos explícitos y de los objetivos implícitos, los primeros representan lo que se ha programado, anunciado y por ende, lo que debería llevarse a cabo normalmente. Los objetivos implícitos, por el contrario, corresponden a aquello que los agentes esperan del programa. Los agentes dominantes procuran, necesariamente, reorientar implícitamente el programa, en el sentido de sus propios intereses.

Obtención de indicadores

Es importante concluir el análisis con la búsqueda de indicadores que mejor recojan el análisis de la información realizado y preparen la respuesta a la pregunta. Como norma general, se eligen indicadores que puedan medir los progresos en la consecución de los objetivos del programa. Los indicadores relacionan las medidas implementadas con los resultados e impactos del programa. Sea cuál sea la fase de aplicación del programa, los indicadores se refieren a una realización, un resultado o un determinado impacto.

Así como una misma pregunta puede contener varios criterios, también puede tener varios indicadores. Los indicadores se cuantifican a través de los sistemas de seguimiento o basándose en los datos recogidos ex profeso para la evaluación. En principio deben referirse al mismo ámbito geográfico que el programa de desarrollo. Sin embargo se debe contemplar la posibilidad de que algunas medidas no sean aplicadas en la totalidad de la zona abarcada por el programa, o que persigan objetivos específicos adaptados a la zona cubierta.

Los indicadores son importantes para llegar a conocer los hechos, pero, a menudo, ni abarcan en su totalidad ni explican las causas que motivan esos hechos. Por tanto, deben ser considerados instrumentos que ayudan a responder a las preguntas de evaluación, pero no constituyen la respuesta completa. En la búsqueda de la respuesta se recomienda acudir a otras fuentes de información diferentes de los indicadores, tales como evaluaciones anteriores, estudios o investigaciones y en general cualquier tipo de información cualitativa.

Se deben elegir indicadores que puedan ofrecer información útil con relación a la lógica de intervención del programa, de manera que puedan utilizarse en las diferentes fases de la lógica de intervención. Dependiendo de cuál sea el nivel de evaluación tendremos: indicadores de realizaciones cuando se evalúan las realizaciones, de resultados cuando se evalúan los resultados y de impacto cuando se evalúe el impacto. Es importante apreciar también la interrelación existente entre los elementos de la lógica de intervención y detectar cuando una determinada realización puede producir varios impactos a la vez.

Es importante no perderse en interminables baterías de indicadores y concentrarse en los indicadores más significativos potencialmente. No es necesario definir demasiados indicadores, un buen sistema de indicadores deberá limitarse a los más pertinentes.

Respuesta: Conclusiones y recomendaciones

Basándose en toda la información recogida y analizada, tanto cuantitativa como cualitativa, se da una respuesta concisa fundamentada en los apartados anteriores. Como la evaluación es considerada esencialmente un análisis de lo que se ha hecho, estas respuestas deben permitir saber como ocurrieron las cosas y por qué.

Por otro lado se considera que la evaluación ha de estudiar especialmente los impactos logrados tanto a corto como a largo plazo, deteniéndose en los aspectos sociales, culturales, medioambientales… según corresponda a la pregunta en cuestión. Además se han de considerar aspectos como la utilidad y sostenibilidad de los impactos conseguidos, para sacar finalmente unas conclusiones y recomendaciones.

Evaluar para reprogramar de otra manera, este es considerado un objetivo de la evaluación. De aquí la idea de sustituir una programación que se ocupa de los programas uno tras otro, teniendo cuidado de comenzar el siguiente sólo cuando se ha terminado con el anterior. Esta procede por evaluaciones continuas, lo que le permite modificar permanentemente las intervenciones y la estructuración de las mismas. De esta manera se crea un proceso que pasaría por las siguientes secuencias: evaluación en curso, nueva elaboración, nueva programación, ejecución, evaluación, etc.

En la búsqueda de la respuesta se recomienda acudir a indicadores y contrastar su información con comentarios de tipo cualitativo. Todas las recomendaciones y conclusiones que se hagan han de venir justificadas por esta información y han de expresarse de manera clara y sencilla.

Limitaciones de la respuesta

Indicar aquí las posibles limitaciones de la respuesta dada en el apartado anterior, de manera que ésta se pueda valorar adecuadamente. Como limitaciones se pueden entender informaciones que hubieran sido valiosas pero no pudieron conseguirse, la relativa fiabilidad de algunos datos, la imposibilidad de resolver determinadas situaciones, la poca colaboración obtenida, la mala programación realizada con anterioridad… y en definitiva todo lo que constituya un obstáculo a la buena realización de la evaluación.

About Carlos Plaza

El estudio de la aplicación y gestión en la evaluación de los programas

Cuando un programa ofrece incentivos a los agentes económicos para llevar a cabo determinadas actuaciones, la evaluación conlleva interesarse por la adecuación de la difusión (grado de conocimiento, idoneidad de los canales empleados, calidad de la información transmitida,…), de los trámites necesarios para acceder a las ayudas, de los requerimientos, de la asistencia técnica prestada, etc. y en definitiva cómo se ha aplicado y gestionado el programa.

Análisis de la aplicación del programa

Para responder a la pregunta sobre el cumplimiento de la programación prevista se han de examinar las medidas y verificar si éstas se han desarrollado y según qué modalidades. Sólo a este nivel se puede apreciar la conformidad en términos de “volumen” o de objetivos físicos de las medidas previstas. Se debe analizar cada medida del programa, por una parte, con relación al eje en el que se sitúe (análisis en su contexto) y, por otra, en relación con un cierto número de criterios de desarrollo provenientes de experiencias anteriores y difundidos ampliamente.

En los ejercicios especiales de evaluación a mitad o final del programa, se puede ir mucho más allá y examinar los detalles de las medidas administrativas, la distribución de responsabilidades entre gestores y operadores, los documentos de ejecución entregados a los operadores, los criterios de selección de proyectos, etc.

Análisis económico y financiero

En el trabajo de evaluación, son particularmente relevantes tres clases de análisis económico y financiero. Estos son la viabilidad financiera, el análisis coste-beneficio y el análisis coste-eficacia.

- La viabilidad financiera es normalmente muy simple, ya nos encontremos en actividades de producción o de desarrollo social. Se trata de estimar los costes reales en relación con los recursos financieros que están o estarán disponibles a lo largo del tiempo. Situarse estrictamente en el nivel financiero permite determinar la factibilidad financiera de las actuaciones, su autonomía en relación con la factibilidad económica. La estructura de la financiación (importancia relativa de la autofinanciación, de los empréstitos y de las subvenciones) puede dificultar la factibilidad de la acción en el plano financiero, cuando ésta es factible en el plano económico.

- El análisis coste-beneficio se utiliza principalmente cuando la utilidad de un programa puede medirse en términos monetarios. Esto puede hacerse en programas con un enfoque puramente productivo; pero es bastante más complicado, si no imposible, cuando se trate de programas que tienen un enfoque social u otro de carácter no productivo. Con el análisis coste-beneficio la pregunta que hay que responder es si el valor de rentabilidad del programa, su beneficio, justifica los costes en los que se incurre.

- El coste-eficacia puede estimarse después de transcurrido cierto tiempo. Se trata de enfrentar los recursos (costes) del programa con los resultados obtenidos (beneficios) y analizarlos en relación con el número de usuarios, con programas similares en otra parte, etc. para valorar si los resultados son aceptables para la inversión realizada. Aquí el evaluador debe preguntarse si podrían haberse alcanzado resultados similares a un coste menor; por ejemplo, utilizando otros medios o formulando el programa de manera diferente. Debe asimismo considerarse si podrían haberse reducido los costes sin un impacto demasiado negativo sobre los resultados.

Para obtener los costes basta recurrir a los gastos de las medidas encaminadas al mantenimiento de la administración del programa, su gestión, seguimiento y evaluación. La suma de estos gastos nos da el coste total del programa. El estudio de los beneficios es más complicado. Es necesario recurrir al estudio del impacto y hacer un análisis global que nos lleve a los principales logros del programa. Solución de problemas como el empleo, la contaminación ambiental, la desigualdad entre hombres y mujeres, la dificultad al acceso laboral de los jóvenes, la falta de capital territorial, la falta de iniciativa local… u otros problemas coyunturales formarán parte de estos principales logros. Finalmente, es importante ilustrar este análisis con indicadores cuantitativos como el coste de gestión por proyecto, o por nuevo puesto de trabajo fijo creado… Indicadores que ilustran las magnitudes que se manejan y que constituyen tan sólo un apoyo a todo el análisis realizado.

Al final de este análisis económico-financiero se conoce el nivel de realización de cada uno de los objetivos operacionales señalando cual ha sido el funcionamiento de cada una de las medidas aplicadas. Nos permite hacer una primera estimación de cómo y porqué las operaciones y acciones han permitido o no alcanzar los objetivos propuestos.

Realizaciones

Los ejercicios especiales de evaluación comprueban la realización efectiva de la actividad determinando el grado de cumplimiento del programa (retrasos sobre la programación). También estudian el grado de acogida o aceptación y las razones que explican su éxito o fracaso de acogida.

Estas evaluaciones realizan un análisis de porcentajes de realización según volumen de medios utilizados, del alcance (beneficiarios), plazos y duración prevista con la ayuda de indicadores. Esto permite medir la eficacia del programa en este ámbito más inmediato (efectos directos o inmediatos), examinando, a través del análisis de los indicadores, el grado de consecución de los objetivos más inmediatos propuestos. Este análisis determina la aportación de cada medida aplicada permitiendo formar un juicio sobre la calidad y rendimiento de cada una de ellas.

Para formular un juicio en relación a estos primeros aspectos específicos y bien delimitados de un programa puede recurrirse al análisis coste-eficacia.

Desviaciones encontradas

Se ha de terminar con el análisis de las desviaciones encontradas. Se trata de identificar las desviaciones observadas entre los objetivos, por un lado y las medidas por otro, con el fin de determinar las relaciones entre los dos. Toma un papel importante en este caso la participación social para valorar qué agentes han causado la desviación, externos o internos, y de que manera lo han hecho. Se hace necesario responder a la razón de estas desviaciones: las medidas pueden no ser eficientes, pueden no ser pertinentes o coherentes con los objetivos, los objetivos operacionales pueden no ser suficientes para poner en práctica el eje en cuestión… También es importante considerar si las capacidades humanas y materiales movilizadas son las adecuadas y si existe suficiente coordinación institucional para asegurar el buen funcionamiento. Habría que determinar si para la solución de estas desviaciones bastaría con las financiaciones obtenidas o, si al contrario, habría que emprender acciones a una escala mucho más grande.

Valoración de la gestión y seguimiento

En la valoración de la gestión y seguimiento se valoran numerosos aspectos tales como la correcta gestión interna del equipo administrador del programa –en cuanto a procedimientos establecidos, criterios de valorización y selección, y requisitos exigidos–; el adecuado control por parte de las instancias superiores al programa –verificaciones iniciales, apoyo técnico, plan de controles e informes realizados–; y la existencia de una correcta coordinación entre las diferentes instituciones implicadas en la gestión a nivel local, regional y demás niveles superiores, así como el grado de autonomía y flexibilidad alcanzados.

Resultados de los controles de aplicación

Como primer paso conviene analizar los resultados de las verificaciones iniciales y controles realizados por las instituciones implicadas en el programa. En los informes de control deben haberse recogido los resultados sobre el cumplimiento de los procedimientos establecidos, de las normas legales y principios que rigen el programa. Una vez comprobado que estos controles fueron bien realizados, que las comprobaciones se hicieron de la manera idónea y que, en definitiva, su información es fiable, esta información puede utilizarse como punto de partida para la evaluación de la gestión del programa.

Organización interna y toma de decisiones

Estos resultados han de complementarse con el estudio de la gestión interna y el sistema de seguimiento (realizaciones y beneficiarios) implementado. Se analiza la comunicación con los beneficiarios potenciales de forma que éstos conozcan los procedimientos para la concesión de las ayudas, los criterios de subvencionabilidad, los requisitos exigibles y la documentación a aportar así como las características generales del programa. Se aborda también el estudio del modelo de toma de decisiones –su estructura y adecuación– los requisitos exigidos a los beneficiarios y los criterios de subvencionabilidad.

Los ejercicios especiales de evaluación estudian el vínculo entre los criterios de selección de proyectos y los objetivos del programa En ese caso de detección de anomalías, la evaluación debe contribuir a la elección de criterios que sean más acertados a los objetivos que se plantean (sobre todo en el caso de evaluación intermedia). Estos criterios constituyen un factor clave para el éxito del programa, por el tipo de proyecto que se selecciona o por la asignación de prioridades.

Coordinación y retrasos

La administración interna de un programa nunca es un ente aislado, sino que forma parte de un engranaje administrativo diferente según el país donde nos encontremos. Por ello es importante analizar la coordinación existente entre la administración del programa y el resto de instituciones que de alguna manera están implicadas en el programa, bien en su control, bien en su financiación, bien en su apoyo técnico.

Es posible que el estudio de esta coordinación detecte fallos que hayan llevado a numerosos retrasos en la aplicación del programa, en la llegada de las ayudas, en la realización de los controles… En estos casos es necesario analizar las causas e intentar facilitar vías de solución para mejorar la coordinación del programa (evaluación intermedia) o bien pensando en futuras programaciones (evaluación final).

Es importante también el estudio de aspectos como la flexibilidad (aparición de rigideces) y el grado de autonomía alcanzado por la administración interna del programa. En ambos casos valorar si se trata de una flexibilidad y autonomía adecuadas a las circunstancias que se presentan.

Otro aspecto a estudiar es la existencia en la modulación de gastos, sueldos, viajes, alquiler de locales, teléfono, fax, internet… de forma que no aparezcan gastos y sueldos de programas similares con diferencias difíciles de justificar.

About Carlos Plaza

El estudio de la lógica de intervención en la evaluación de los programas

En los ejercicios especiales de evaluación se ha de estudiar la lógica de intervención y hacer una reconstrucción de la cadena de relaciones que conduce de las medidas a los resultados más inmediatos y al impacto más a largo plazo del programa y esquematizarla de una manera sencilla. No se trata únicamente de describir el programa sino de determinar las relaciones existentes entre los objetivos que se persiguen con la intervención, las medidas aplicadas para alcanzar dichos objetivos y los resultados obtenidos. Se trata de realizar un análisis crítico que permita dar respuesta a la pregunta de cómo las medidas contribuyen al logro de los objetivos.

Para responder a la primera pregunta sobre lo adecuado de la programación planteada es necesario reconstruir la estructura del programa. Esta estructura debe existir puesto que ha servido de base para la construcción del programa. Sin embargo, muchas veces no está bien definida y faltan pasos intermedios que conviene clarificar. En estos casos, es necesario precisar los objetivos del programa en sus diferentes niveles. Esto se hace en general identificando los grupos de acciones concretas que persiguen una meta análoga. Se define esta meta y se expresa en términos de objetivo determinando en que se desea modificar la situación de referencia.

Una vez tenemos la estructura del programa se realiza el análisis de su lógica de intervención. Este análisis debe haber sido realizado en la programación a la vez que revisado en las primeras etapas de evaluación (evaluación previa) y corroborado en etapas posteriores. Por tanto no debe ser necesario más que un pequeño análisis crítico que permita dar respuesta a los criterios de evaluación de pertinencia y coherencia.

Pertinencia

En el caso de una evaluación de fase intermedia, el equipo de evaluación debe examinar hasta qué punto están evolucionando las necesidades socio económicas y los problemas de desarrollo, si empeoran o mejoran, e intentar explicar por qué. El objetivo es examinar si la estrategia establecida mantiene su pertinencia en vista de las nuevas circunstancias que puedan darse. En caso de no ser así la evaluación intermedia debe permitir adecuar el programa al nuevo contexto territorial.

El objeto de este cuestionamiento en la evaluación final es sobre todo el de conocer si el programa bajo estudio es el medio para resolver los problemas que se están abordando, o por el contrario debe apostarse por otras vías de solución.

Una buena herramienta para analizar este criterio es la realización de una matriz donde se crucen las matrices DAFO con los objetivos del programa que se estén desarrollando. De este modo se evalúan si quedan cubiertas las principales debilidades, amenazas, fortalezas y oportunidades con los objetivos propuestos.

Claridad y coherencia de los objetivos: Coordinación con otros programas

Es importante la reconstrucción de los objetivos que realmente se han seguido si éstos no coincidieran con los inicialmente planteados. Esto nos debe servir para estudiar su coherencia interna y la claridad con que fueron definidos.

En el caso de la coherencia externa, el principal riesgo es la aparición, a medio camino, de otras intervenciones que duplican o contradicen el programa evaluado. Si fuera necesario, la evaluación intermedia debe revisar las políticas similares y estudiar si prolongan, complementan, solapan o contradicen el programa en marcha. Este estudio consiste en entrevistas con los gestores y operadores de programas y con cualquier otra persona en situación de proporcionar información fiable.

En el caso de la evaluación intermedia la posible detección de estos cambios en las políticas e intervenciones relacionadas con el programa deben llevar a un replanteamiento de la intervención en caso de que se vea necesario. En el caso de la evaluación final el objetivo es el de verificar la efectiva coordinación de la lógica de intervención con el resto de intervenciones a lo largo del programa.

Coherencia interna entre los objetivos y medidas

La búsqueda de la coherencia interna entre las medidas y los objetivos del programa tendrá una gran importancia en el caso de la evaluación de fase intermedia, cuando el programa aún puede mejorarse. En ese caso, la evaluación debe contribuir al reorientación de las medidas hacia los objetivos en caso de que sea necesario: bien porque los objetivos hayan cambiado, bien porque las medidas no hayan sido correctamente orientadas.

En la evaluación final el estudio de esta coherencia busca la comprobación de que ésta se haya dado a lo largo de la aplicación del programa. En caso negativo, el estudio debe llevar a comprender las razones de la falta de coherencia detectada y así contribuir al aprendizaje para próximas programaciones.

La herramienta que se aconseja es la realización de una matriz que enfrente las medidas aplicadas con los objetivos que se persiguen. Esta matriz permite verificar que las medidas cubren todos los objetivos y lo hacen de una manera adecuada.

Calidad del documento de programación

Así como la evaluación previa vela por el logro de un documento de programación con una calidad adecuada, la evaluación intermedia y sobretodo la final, comprueban que efectivamente se da esa calidad. Las perspectivas son distintas, cuando se realizan estas dos últimas evaluaciones el programa está en marcha o ya ha terminado con lo que ya existe una experiencia práctica del programa. Con ella se detectan posibles desajustes, faltas de claridad, incoherencias… que antes de poner en práctica el programa son difíciles de identificar.

El objetivo es analizar si los defectos detectados en el documento de programación son justificables por las circunstancias y medios empleados en su momento, o por el contrario responden a una falta de profesionalidad o de buen hacer. Los criterios de calidad que se proponen son los siguientes:

- Satisfacción de las necesidades: ¿Aporta la evaluación la información suficiente para preparar un plan y se ajusta a las condiciones establecidas?

- Alcance: ¿Incluye el fundamento del programa y los resultados e impactos esperados?

- Concepción: ¿La concepción de la evaluación es apropiada para responder a preguntas clave en el momento preciso?

- Datos: ¿Son adecuados los datos útiles recabados y se tiene suficientemente en cuenta su fiabilidad?

- Validez del análisis: ¿Se somete la información disponible a los análisis oportunos?

- Credibilidad de los resultados: ¿Se derivan lógicamente del análisis los resultados y están justificados por el mismo?

- Imparcialidad de las conclusiones: ¿Son las conclusiones objetivas y operativas y están libres de la influencia de las opiniones de los interesados?

- Claridad: ¿Está el informe escrito de una forma fácil de comprender?

About Carlos Plaza

Puesta en marcha de un sistema de información para el seguimiento

Para la puesta en marcha de un sistema de seguimiento es necesario poner en funcionamiento un sistema de información y un sistema de autoevaluación.

Desarrollo del sistema de S&E durante la etapa de ejecución con la puesta en práctica del seguimiento

Desarrollo del sistema de S&E durante la etapa de ejecución con la puesta en práctica del seguimiento

El sistema de información se constituye como pieza clave del mecanismo de integración en la etapa de ejecución. Ya desde el inicio del programa empieza el intercambio de información del programa al sistema de seguimiento. Se da continuidad así a la integración de las actividades de S&E en el programa.

El proyecto constituye la unidad de recogida de información por excelencia del sistema de información. Aunque luego haya varios niveles de reflexión a nivel actuación, medida, eje… es necesario recoger la máxima información de utilidad que a nivel proyecto se pueda conseguir. La principal ventaja de este sistema de información a nivel proyecto está en la cercanía del gestor a éste a la hora de aportar información. Cuando se realiza un ejercicio especial de evaluación es difícil contar con que los expertos evaluadores lleguen a conocer todos los proyectos. El que mejor los conoce es el encargado de gestionarlos y seguirlos, y es importante que llegue a sistematizar la recogida de los aspectos clave de los proyectos implementados.

Las tareas preparatorias para establecer el sistema de seguimiento servirán para detectar las deficiencias del sistema de información. Podrá ser necesario recurrir a asistencia técnica o a expertos independientes para solventar las posibles deficiencias y carencias, mejorar las condiciones generales de aplicación y aumentar la eficacia del seguimiento.

A su vez el mecanismo de aprendizaje a través de la autoevaluación produce continuas recomendaciones, como resultado de las reflexiones a nivel proyecto, medida, eje…una vez se ha ido agregando la información de los proyectos (o aportando nueva información en cada uno de estos niveles). Las recomendaciones han de ser asimiladas por el programa y garantizar así su contribución a un verdadero desarrollo de las potencialidades del territorio sobre el que actúa. Este flujo de recomendaciones garantiza la integración del programa en las actividades de seguimiento.

Exponemos a continuación el desarrollo del sistema de información que caracteriza parte de esta integración. Posteriormente, al hablar del aprendizaje, desarrollamos el segundo elemento clave del sistema de seguimiento: la autoevaluación.

Definición de las necesidades de información

El primer paso para la creación del sistema de información del seguimiento es definir la información mínima esencial que se recogerá a nivel de cada uno de los proyectos. Como se explicará más adelante en el apartado sobre el contenido del seguimiento, este sistema de información habrá de centrarse en el seguimiento físico y financiero y en el seguimiento del contacto con los beneficiarios.

Es difícil determinar estas necesidades de información debido, en parte, a que con mucha frecuencia los propios usuarios no han decidido lo que necesitan realmente. La experiencia habida en muchos programas muestra que los administradores describen los temas o cuestiones sólo en términos generales. Por lo tanto, los diseñadores del sistema de información deben tratar de ayudar a los gestores e identificar partidas específicas de información siguiendo los siguientes pasos:

- Examen del programa y su contexto: El diseño del sistema de información debe incluir un examen del programa y de su contexto. Ha de hacerse un análisis del diagnóstico y de la jerarquía de los objetivos del programa con objeto de determinar las poblaciones consideradas como objetivo, las actividades críticas y las tareas que han de seguirse comparadas con los objetivos convenidos.

- Identificación de prioridades: Después de este examen, el primer paso al diseñar un sistema de información consiste en identificar la prioridad de los usuarios (las personas encargadas de la gestión que realizarán el seguimiento y harán uso de ese sistema de información). La identificación de las necesidades de éstos requiere un marco para el diálogo que ha de sostenerse entre el usuario y el diseñador del sistema. La experiencia también indica que no debe utilizarse un marco conceptual elaborado por expertos externos con objeto de identificar necesidades de información. Los programas que no han incluido el diálogo necesario con los usuarios para identificar necesidades reales de su gestión diaria, o que han hecho meramente una estimación superficial de tales necesidades, han tendido a producir sistemas costosos que en gran parte no tienen conexión con las necesidades de los usuarios.

- Selección de prioridades: Habida cuenta de los limitados recursos de personal, dinero y tiempo, es improbable que el sistema de información satisfaga plena y eficazmente las necesidades de todos los usuarios. Esto demanda que se asigne la máxima prioridad a las necesidades de seguimiento del personal del programa, después vienen las demandas de los organismos que supervisan y controlan. Los responsables del seguimiento deben definir, sobre la base de las prioridades y de la capacidad, la estructura del sistema de seguimiento y el grado de detalle necesario para poder satisfacer las necesidades de los diferentes grupos.

Diseño de un sistema de indicadores

El diseño del sistema de información ha de concretarse en la identificación de un sistema de indicadores. Estos indicadores deben informar a los gestores de los efectos a corto y largo plazo de las acciones emprendidas y, además, hacer posible una medición de los progresos realizados con respecto a los objetivos globales del programa. Varios criterios se pueden emplear para la selección de indicadores de calidad (Comisión UE, 2004; Innes & Boother, 2000):

- Se puede cuantificar a intervalos regulares con una frecuencia adecuada al programa. Teniendo en cuenta que tener un número no significa necesariamente el tener un buen indicador. El problema no consiste solamente en completar o reducir el número de indicadores, sino en la dificultad de los sistemas de seguimiento para garantizar la cuantificación periódica de los indicadores acordados y que ya existen en los programas.

- Puede utilizarse poco tiempo después de la recogida de los datos sobre los cuales se ha construido.

- Es directo y no da pie a ambigüedades. Se puede comprobar su sensibilidad y fiabilidad en relación con los fenómenos a medir.

- Permite comparaciones entre las medidas del programa, y con otros programas o grupos de destinatarios.

- Es transparente y no puede ser manipulado para mostrar logros donde no existen.

- Su obtención. Los indicadores deben ser identificados por participación. Deben ser desarrollados con la participación de aquellos que los usarán y aprenderán de ellos, pues solo serán realmente útiles si se convierten en parte de su modo de pensar.

Un seguimiento eficaz exige la elaboración de indicadores de realizaciones en relación con todas o la mayor parte de las medidas. No obstante, en lo que se refiere a los indicadores de resultados y de impacto puede admitirse un enfoque algo más selectivo. Los indicadores han de ser escogidos de forma que al final podamos contar con un sistema en el que podamos identificar:

- Indicadores clave o marco: Unos pocos indicadores globales de medidas que reflejen los valores centrales de la intervención. Han de ser cuidadosamente diseñados, claramente visibles, participados y consensuados y deben ayudar a enmarcar la intervención y a señalar la dirección en la cual se quiere avanzar. Con la idea clara de que los indicadores no son respuestas sino el punto de partida para la discusión.

- Indicadores de gestión: Un número mayor de indicadores que reflejen las principales actividades y resultados para los encargados de la gestión y seguimiento. Han de ayudar al diseño y rediseño (en caso de que no avancen en la dirección deseada) de la intervención, al mantenimiento de la eficacia, a diagnosticar la causa de los problemas, a realizar ajustes, a fijar prioridades y a responder a los cambios que se produzcan. Dada la gran importancia de la distribución territorial en el desarrollo es conveniente el uso de los sistemas de información geográfica en los indicadores.

- Indicadores rápidos de retroalimentación para todos los implicados en la intervención de forma que supongan una ayuda en su toma de decisiones diaria sobre sus propias acciones y a hacer un mejor uso sobre los recursos disponibles. El acceso individual a mejor y más puntual información es crucial en el proceso de desarrollo. Se trata de actuar con la mayor información disponible y poder escoger lo más conveniente. Una de las principales tareas aquí es la exploración de las oportunidades que ofrecen las nuevas tecnologías de la información y tratar de utilizarlas en la medida de lo posible.

Una vez escogidos los indicadores, se recomiendan cuatro grandes criterios para comprobar la calidad del sistema de indicadores diseñado:

- Una buena cobertura del programa completo.

- Un buen equilibrio entre productos, resultados e impactos.

- Pragmatismo en lo relativo a las cifras.

- Pertinencia, es decir, una selección de indicadores que toman en cuenta la importancia estratégica y operativa de la información. El sistema de indicadores debe facilitar información dirigida a mejorar la calidad y la eficacia de la intervención.

Elaboración de una base de datos y recogida de información

Para el manejo y organización de esta información se hace necesaria la realización de una base de datos diseñada especialmente para cada programa y de fácil manejo para el personal que ha de operar con ella.

La recogida de la información en la base de datos ha de verse facilitada por la redacción de documentos: los cuestionarios para la petición de ayudas, las memorias de los trabajos para la selección de las subvenciones, los informes sobre las visitas de campo y la elaboración de fichas para el seguimiento de cada beneficiario. De una manera más informal – pero no por ello menos importante – está el continuo contacto con los beneficiarios en el día a día del programa.

Cuestionarios para la petición de ayudas

En el cuestionario para la petición de ayudas los beneficiarios potenciales del programa deben aportar sus datos personales, datos sobre la localización del proyecto, la descripción del mismo y sus objetivos, distribución de los gastos según medidas y el resto de ayudas públicas que se hubiesen solicitado. También ha de aportar la documentación y justificantes que sean precisos y el compromiso de cumplir los requisitos del programa para la concesión de una subvención. Se ha de aprovechar el cuestionario para la obtención de indicadores iniciales de tipo físico, económico y social y todo tipo de observaciones e información adicional para complementar la valoración del proyecto.

Memoria explicativa de los trabajos para la selección de subvenciones

Las herramientas utilizadas para la selección de las subvenciones han de evitar, en la medida de lo posible, apreciaciones subjetivas a la hora de conceder las ayudas, racionalizando y sistematizando el proceso de selección. También han de facilitar la función de control por las administraciones encargadas del programa y la autoevaluación del propio grupo.

El primer paso es la selección de unos criterios de decisión definidos y consensuados por todos los implicados en el programa de acuerdo con los objetivos y filosofía del programa. El segundo paso es la ponderación de los criterios en función de su grado de prioridad adjuntándoles un coeficiente de ponderación (normalmente tres, uno para prioridad muy alta, otro para la alta y otro para la prioridad normal).

Cada proyecto susceptible de recibir ayuda debe ser valorado con cada uno de los criterios establecidos. Esta valoración es definida según la repercusión del proyecto sobre cada uno de los criterios. Pueden establecerse cinco niveles de valoración: muy positivo, positivo, normal, negativo y muy negativo.

Es importante que el análisis de la subvencionabilidad se agilice haciéndolo de forma informatizada como puede ser una hoja de cálculo (Excel en entorno de Windows por ejemplo). Las únicas celdas a modificar serán las correspondientes a las valoraciones de cada criterio (y al máximo de subvención con cargo al programa establecido para el proyecto en caso de ser necesario). La hoja ha de estar diseñada para el cálculo automático de la valoración y subvención final para el proyecto.

Cada evaluación multicriterio realizada debe ser completada con una breve memoria explicativa con objeto de aclarar las valoraciones dadas a cada criterio.

Informes de las visitas de seguimiento

En las visitas de campo a los proyectos subvencionados se ha de constatar que las condiciones que llevaron a la selección del proyecto siguen siendo vigentes. Se ha de comprobar que el proyecto no ha cambiado de localización y se han mantenido las inversiones. Datos de interés son las posibles renovaciones, la ampliación o reducción de la inversión, horario de funcionamiento, mantenimiento de empleos, principales problemas o potencialidades detectadas y todo tipo de observación que se considere de interés.

Estas visitas han de dar lugar a un informe donde se ha de recoger toda esta información, junto con la fecha y lugar de la visita, título del proyecto y promotor junto con el nombre de las personas presentes en la visita. Es recomendable que el informe esté tipificado y el informe se realice con facilidad rellenando las casillas en blanco dejadas al efecto.

Fichas para el seguimiento de cada beneficiario

La sede administrativa del programa ha de contar con una ficha de seguimiento de cada uno de los beneficiarios del programa que vaya recogiendo las principales incidencias con cada uno de ellos. Es importante que esta información se informatice y pase a la base de datos del sistema de información.

Seguimiento informal

Aunque no se recoja en ningún tipo de informe de manera oficial, el seguimiento informal de los beneficiarios y del resto de la población afectada por parte del equipo de seguimiento se considerada esencial. Muchas veces constituye la fuente para una más adecuada valoración de los proyectos y de los beneficiarios. La fuente para detectar malestares entre la población o por el contrario una actitud de satisfacción hacia el programa.

Referencias citadas:

Comisión UE (2004). Indicadores comunes para el seguimiento de la programación de desarrollo rural 2000-2006. Dirección General VI de Agricultura, Bruselas.

Innes, J.E. & Boother, D.E. (2000). Indicators for sustainable communities. A strategy building on complexity theory and distributed intelligence. Planning Theory & Practice, 1(2), 173-186.

About Carlos Plaza

Contenido del seguimiento: La aplicación y gestión de los programas

El contenido del seguimiento de un programa ha de estar centrado en su aplicación y gestión. Ha de ir comprobando el cumplimiento de la programación prevista, que los resultados son aceptables y que lo que se previó era lo más adecuado.

Contenido de seguimiento en la etapa de ejecución

Contenido de seguimiento en la etapa de ejecución

Sin embargo, el estar centrado en este aspecto que conecta la lógica de intervención del programa con los resultados que se van obteniendo, le obliga a ir analizando estos resultados y volver sobre la lógica de intervención para analizar las causas de lo que pueda no estar funcionando. Esto supone un continuo aprendizaje que resulta de la puesta en práctica de lo que en un principio se conocía solamente en un plano teórico.

Aspectos concretos que son analizados de la aplicación del programa son la eficiencia y la eficacia, comprobando el logro sobre la marcha de unos niveles aceptables de ambos aspectos. Este examen es más riguroso en la evaluación intermedia, aunque las conclusiones finales sobre la eficiencia y eficacia del programa no se podrán dar hasta la etapa de terminación donde contaremos con la evaluación final.

Para el seguimiento de la aplicación y gestión, el seguimiento cuenta con dos contenidos fundamentales: la información física y financiera y las relaciones con los beneficiarios.

Seguimiento físico y financiero

El seguimiento coordinado de la información física y financiera es esencial para la ejecución y operación eficiente de todo programa. Esta parte del sistema de información y su uso debe reconocerse como la base para el desarrollo de la función completa del seguimiento.

Los datos físicos y financieros deben consistir principalmente en cantidades directas físicas y financieras para cada actividad. Los indicadores representativos apenas tienen lugar en este aspecto del seguimiento, aunque los porcentajes pueden ser útiles, en particular en lo que se refiere a fondos asignados de hecho gastados comparados con los totales presupuestados.

Ambos datos –físicos y financieros– han de estar relacionados, para asegurar el logro de los objetivos a costos reales aceptables.

Seguimiento del contacto con el beneficiario

Este seguimiento es la clave para que el seguimiento global del programa resulte un éxito. El seguimiento físico y financiero mide en general la provisión y suministro de servicios e insumos del programa. Pero los gestores de programas también necesitan saber si están aceptándose los servicios y cómo están integrándose en la zona de aplicación y en los diferentes sectores de población.

A medida que se va ejecutando un programa, las percepciones de sus futuros beneficiarios conducen a una creciente demanda de sus servicios o bien a que se vean fuera de propósito. Si los beneficiarios tienen incentivos diferentes de los que sustentan el programa, importa poco cuáles son los más sensatos desde el punto de vista financiero.

En el personal de seguimiento recae la responsabilidad primaria de iniciar y mantener contactos con los beneficiarios y de mantener bien organizados los registros del programa. Este personal también coteja y resume los datos derivados del seguimiento físico y financiero y más tarde integra esos datos a la información acerca de las reacciones de los beneficiarios.

En ambos seguimientos la elección de indicadores apropiados que se van a medir es crucial para establecer un seguimiento eficaz de las realizaciones del programa y las reacciones de los beneficiarios. Indicadores impropios pueden predestinar el fracaso a un sistema de información. Además, el fracaso se ratifica cuando los administradores eligen todos los indicadores que se les ocurren o aparecen en las listas de varios principios guía. A medida que se alarga la lista así también sucede con el número de indicadores impropios.

About Carlos Plaza

Lecciones de la experiencia sobre las características de un buen sistema de seguimiento y evaluación

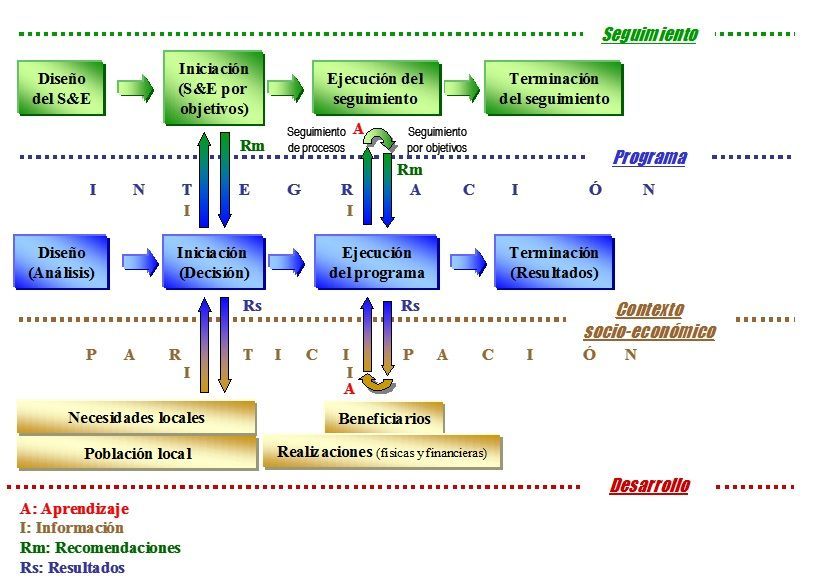

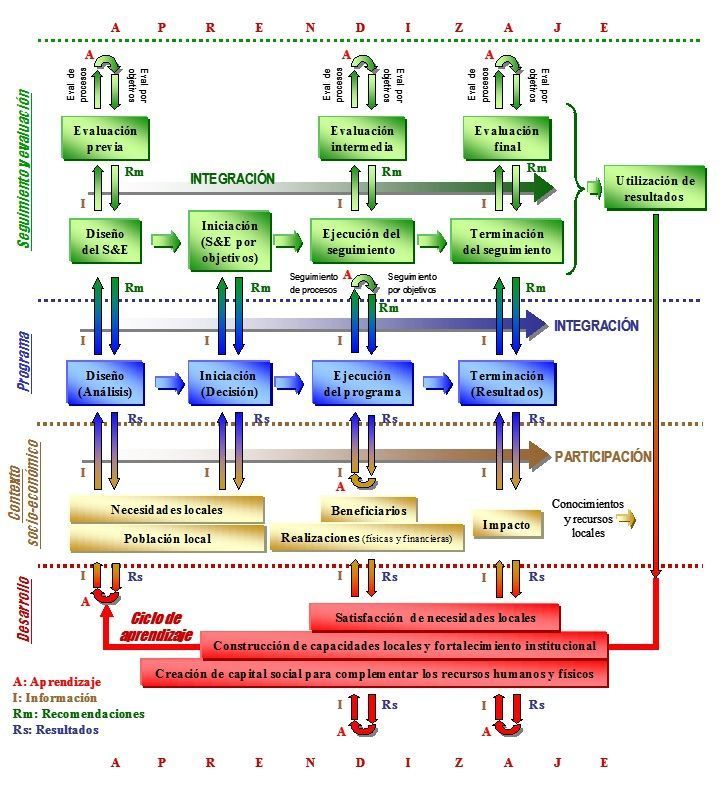

A continuación se exponen una serie de conclusiones concernientes a las características que son aconsejables a la hora de diseñar un buen sistema de seguimiento y evaluación (S&E): la integración, la participación y el aprendizaje, entre otras.

En relación con la integración…

El S&E debe ser concebido como un proceso integrado y continuo. La integración supone la unión entre actividades de seguimiento y evaluación, y el vínculo de éstas actividades con el programa y su contexto territorial, legislativo e institucional. La continuidad supone el encadenamiento de las distintas actividades de S&E de forma que ninguna de ellas sea entendida como una tarea puntual en la vida de la intervención.

La integración del S&E con las actividades de programación resulta imprescindible para una buena adaptación a las necesidades de las intervenciones con las que se trabaja y proporcionarles una continua y adecuada orientación.

La integración permite evitar el desfase entre el ciclo de programación y de evaluación y las consiguientes dificultades que este desfase produce en el proceso de aprendizaje.

La autoevaluación facilita la integración del proceso de evaluación en el propio sistema de seguimiento, con lo que los trabajos de S&E se ven favorecidos en el suministro de información.

En relación con la participación…

El S&E debe comenzar con reuniones con los beneficiarios, averiguar dónde están, en qué están interesados, sus aportaciones al proceso de S&E, para luego unir las perspectivas de la evaluación con las locales.

El proceso de participación ha de ayudar a conseguir un proceso de S&E útil, que incremente el conocimiento que los diversos agentes tienen del programa, enriqueciendo el proceso de reflexión en torno al mismo y la resolución de los problemas o necesidades para los que éste surgió.

La participación ha de dar como resultado un programa que tenga relación con la actividad diaria de los participantes y no se pierda en ideas abstractas sin conexión real con la masa social.

El énfasis del proceso participativo ha de estar en la creación de significado local, de objetivos compartidos, un clima de consenso y construcción de una comunidad que comparte un enfoque común.

El mecanismo de participación ha de ser diseñado de manera que se asegure que en alguna de sus fases los participantes sean influenciados por los demás y se produzca así un proceso de socialización que de pie a la discusión y al diálogo.

Los ejercicios especiales de evaluación suponen ejercicios especiales de participación y aprendizaje al ser trabajos más amplios y profundos que el seguimiento continuo de los programas.

La utilización de la información extraída de la participación permite en muchos casos, suplir el bajo nivel de desarrollo de las bases estadísticas existentes y dar mayor credibilidad a los indicadores utilizados al facilitar el contraste entre fuentes de información.

La activación de un proceso de participación permite evitar el peligro de la exaltación de la objetividad. Con la participación, la atención se centra en la obtención y superposición de distintos puntos de vista tanto del conocimiento experto como del conocimiento local con el objetivo de enriquecer los trabajos realizados.

En relación con el aprendizaje…

Es necesaria la activación de un mecanismo de aprendizaje distinto del activado por la participación. Este mecanismo permite no conformarse con un simple aprendizaje pasivo ─como si se tratara de una ósmosis─ sino que activa un aprendizaje activo que aprovecha al máximo las posibilidades de retroalimentación.

Las actividades de S&E tienen un gran protagonismo en el aprovechamiento del capital intangible para la generación del desarrollo. Parte importante de este capital es el capital social.

La gestión del conocimiento y la innovación es parte importante del S&E como realidad obligada por el progreso tecnológico y la necesidad de crear un verdadero desarrollo.

La gestión del conocimiento e innovación ha de abordarse desde una perspectiva claramente centrada en los aspectos humanos pues sólo las personas desarrollan, incorporan y usan conocimiento. Una perspectiva basada en las posibilidades tecnológicas anteponiéndose a cualquier otra consideración, es errónea.

En relación con otras características…

La continuidad con los procedimientos y herramientas clásicas utilizadas hasta ahora en el S&E permite una mayor participación y un mejor hacer de los implicados por estar ya familiarizados con algunos de estos procedimientos y herramientas.

Un modelo de S&E ha de ser flexible. La flexibilidad permite la adaptación a las diversas situaciones encontradas en el dinámico contexto del S&E del desarrollo (diseño a la medida). Para lograr esta flexibilidad la cultura de la evaluación debe acrecentarse y enriquecerse y se hace necesario establecer marcos comunes guía en la concepción general de los procesos evaluativos.

Un enfoque positivo del S&E, más centrado en el desarrollo de las capacidades que en el análisis de problemas, permite entrar en una positiva dinámica de aprendizaje que valorice los resultados obtenidos, de cara a la mejora del programa y su perfeccionamiento en fases posteriores.

Conceder la debida importancia a los aspectos específicos que las distintas intervenciones puedan presentar evita centrar todos los esfuerzos en el estudio del impacto y el llamado reduccionismo economicista que centra los trabajos de manera excesiva en los aspectos económicos y financieros.

La definición de preguntas clave de evaluación permite concretar los objetivos de los trabajos centrando desde un principio los esfuerzos realizados

Un modelo sencillo que no precise de unos elevados conocimientos financieros, económicos, estadísticos o de cualquier tipo facilita el aprendizaje y la adquisición de una capacidad evaluadora por parte de la población local.

La aplicación de nuevas tecnologías al S&E de los programas de desarrollo permite reducir el tiempo de análisis de la información y facilita la estandarización y homogeneización de procesos y formatos, el aumento de la calidad de la información y la reducción drástica de errores.

About Carlos Plaza

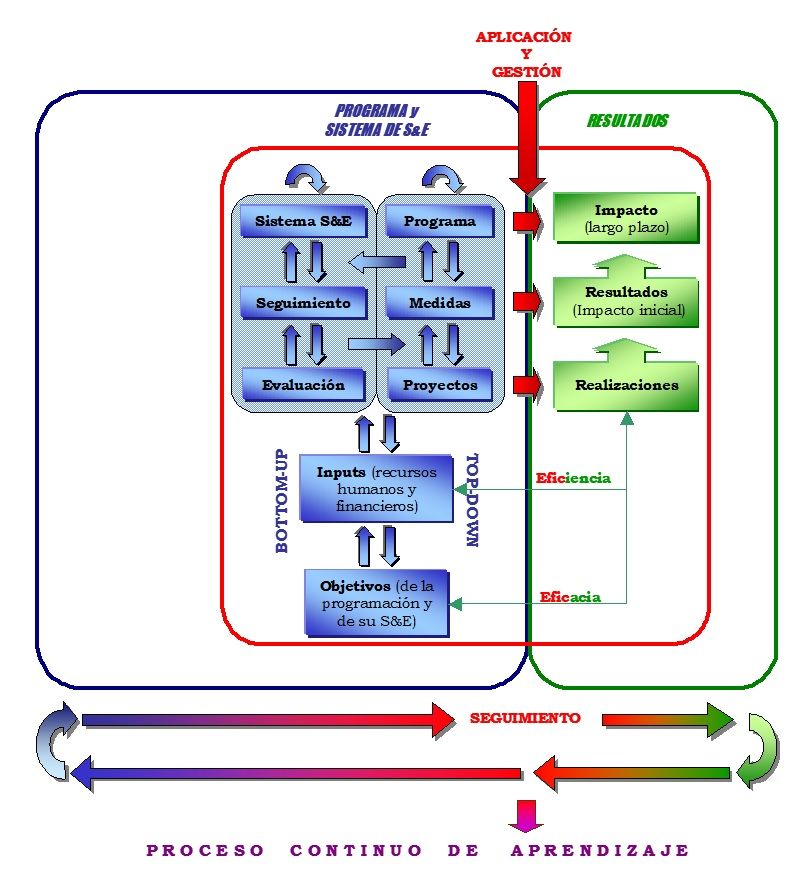

Un sistema completo de seguimiento y evaluación en pocas palabras

Exponemos ahora los aspectos fundamentales para el seguimiento y evaluación (S&E) de un programa de desarrollo a través de un modelo integrado y participativo basado en el aprendizaje, la gestión del conocimiento e innovación. Un modelo que busca la integración con los programas –su planificación y gestión– y su contexto, la participación activa de todos los implicados, y se fundamenta en el aprendizaje. Es por ello que, haciendo alusión a estos conceptos clave, denominamos al modelo como Modelo para el Seguimiento y Evaluación Integrado y Participativo basado en el Aprendizaje (SEIPA).

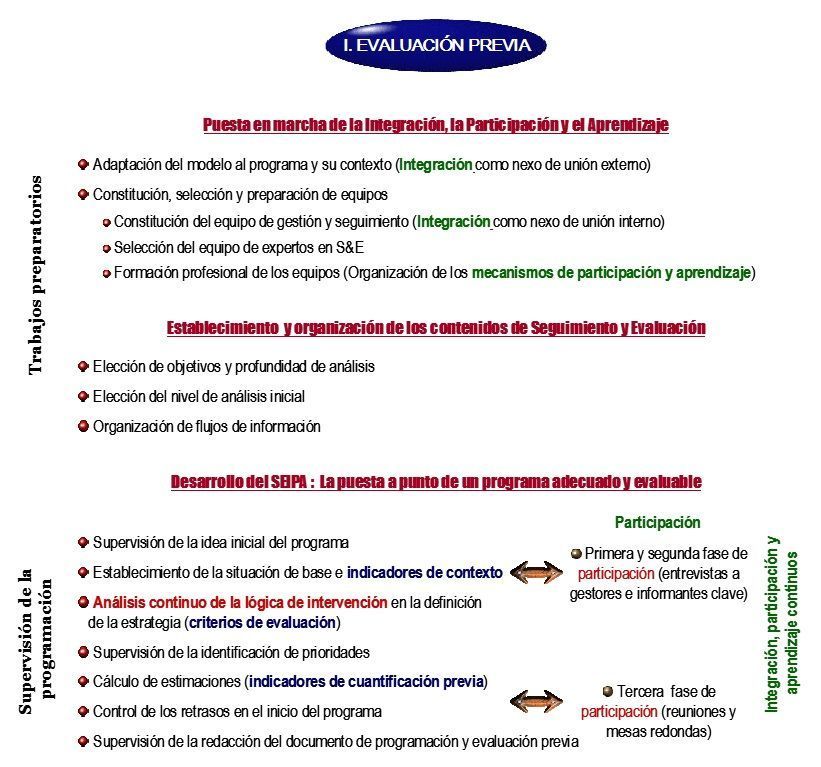

Este modelo es fruto de más de 20 años de experiencia, de una reflexión continua realizada a lo largo de años de trabajo en distintos ámbitos del S&E. Supone por tanto una labor de síntesis, ordenada y en forma de modelo, de las experiencias en distintos trabajos de “investigación-acción” que han dado lugar a procesos de aprendizaje que se han ido documentando y sistematizando. Lo que se expone a continuación es una guía resumida para la aplicación del modelo y un análisis práctico de las dificultades que en el contexto actual de los programas de desarrollo, podemos encontrar para aplicar el SEIPA en sus diferentes etapas. Esta guía está estructurada en tres grandes bloques correspondientes a la puesta en marcha de las características del modelo, el establecimiento y organización de los contenidos de S&E y desarrollo del SEIPA en cada una de sus etapas: la evaluación previa en la etapa de diseño, el seguimiento en la etapa de ejecución y los ejercicios especiales de evaluación (intermedia y final). En cada una de estas etapas es necesaria una adecuada puesta en marcha de las características del modelo y un apropiado establecimiento de los contenidos de S&E.

Etapa de diseño

En el caso de la evaluación previa distinguimos unos trabajos iniciales para la puesta en marcha de las características del modelo y el establecimiento y organización de los contenidos de S&E a través de: la adaptación del modelo al programa y contexto que se van a manejar, la constitución y formación de los equipos de gestión y evaluación, y la definición del ámbito del S&E con el establecimiento del nivel de análisis de éstas actividades y la organización de los flujos de información.

Desde los primeros pasos es importante tener en cuenta la necesidad de revisar de forma continua la lógica de intervención, el asegurar la adecuación y calidad de los mecanismos de ejecución y realizar una anticipación de los resultados y problemas de las estrategias que se vayan desarrollando. En definitiva, tener muy presente el contenido de evaluación definido para esta etapa.

Guía para la aplicación del SEIPA en la evaluación previa durante la etapa de diseño

Guía para la aplicación del SEIPA en la evaluación previa durante la etapa de diseño

Etapa de ejecución

En el caso de la aplicación del SEIPA al seguimiento, distinguimos tres pasos fundamentales: el establecimiento del sistema de información, del sistema de autoevaluación y el comienzo de las actividades de seguimiento con la verificación y utilización de las recomendaciones de la autoevaluación, la intervención y especificación de metas y la redacción de los informes de seguimiento que servirán de base al control y evaluación de la intervención.

La participación, reflejada en el seguimiento mediante un continuo contacto con los beneficiarios y con la población en general, es fuente de información en el establecimiento del sistema de información y fuente de aprendizaje en el sistema de autoevaluación.

Guía para la aplicación del SEIPA en el seguimiento durante la etapa de ejecución

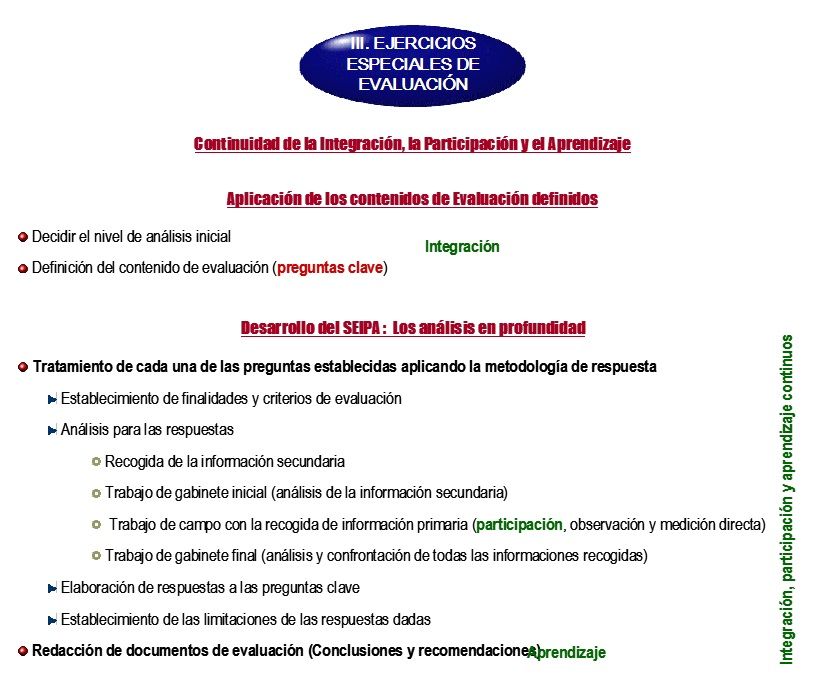

Ejercicios especiales de evaluación

Puestas en marcha las características del modelo, el primer paso en los ejercicios especiales de evaluación es definir el nivel de análisis inicial y el contenido de evaluación mediante las preguntas clave. Posteriormente se trata cada pregunta según la metodología de respuesta diseñada. Especial interés requiere el análisis donde un trabajo de gabinete inicial analiza la información secundaria recogida y un trabajo de gabinete final analiza y contrasta la información secundaria recogida al inicio y la obtenida en el trabajo de campo. Tras este análisis se procede a dar respuesta a cada una de las preguntas de evaluación, sacando conclusiones y recomendaciones precisas y claras.

El último paso consiste en plasmar los resultados obtenidos en el documento de evaluación intermedia o final, según el caso. Especial relieve ha de tener en ellos el conjunto de conclusiones y recomendaciones que sirvan al mecanismo de aprendizaje.

Guía para la aplicación del SEIPA en los ejercicios especiales de evaluación: intermedia (etapa de ejecución) y final (etapa de terminación)

Guía para la aplicación del SEIPA en los ejercicios especiales de evaluación: intermedia (etapa de ejecución) y final (etapa de terminación)

About Carlos Plaza

Sistema de indicadores para el seguimiento y evaluación

La existencia de un sistema de indicadores fiable y adecuado es un elemento indispensable de un sistema de seguimiento y evaluación. No existe receta sobre cómo desarrollar un sistema de indicadores. Cada comunidad y región deben desarrollar un sistema basado en sus propias circunstancias y necesidades. Lo que proponemos es el siguiente esquema como base para su elaboración:

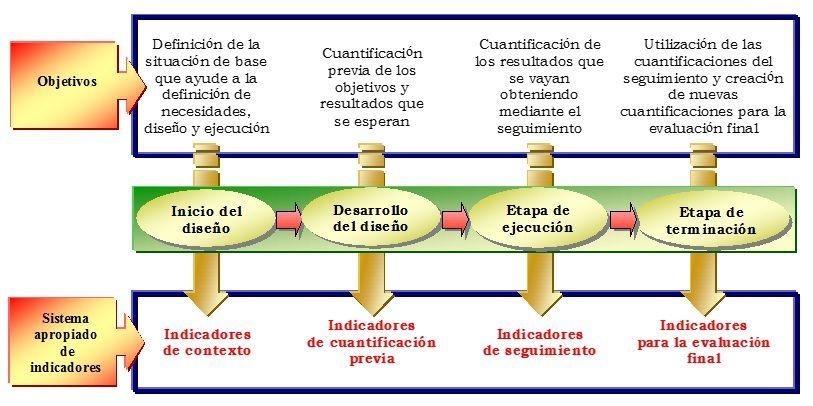

Diseño de un sistema apropiado de indicadores para el seguimiento y evaluación

Diseño de un sistema apropiado de indicadores para el seguimiento y evaluación

Tipos de indicadores empleados

El sistema cuenta con varios tipos de indicadores: de contexto, de programa, de aspectos concretos de evaluación y los indicadores clave para efectuar la comparación entre programas. Vemos cada uno de ellos:

- Indicadores de contexto aplicados a la totalidad de un territorio, población o categoría. Utilizados especialmente en la evaluación previa para situar el programa en perspectiva y describir una situación básica antes de la intervención y una situación deseada después de la intervención

- Indicadores del programa referidos a aquella parte de una población o un territorio a la que se aplica la intervención. Su finalidad es medir los efectos directos o indirectos del programa, pueden ser indicadores de recursos o financieros, de realizaciones, de resultados o de impacto. Cuando se utilizan para precisar los objetivos de una intervención reciben el nombre de indicadores de cuantificación previa.

- Indicadores de evaluación para tratar una serie de cuestiones específicas, como son la pertinencia, la eficiencia, la eficacia, la utilidad y la durabilidad. La eficacia y eficiencia permiten comparar los logros alcanzados con los previstos (eficacia) o con los recursos utilizados (eficiencia).

- Indicadores clave para realizar comparaciones entre programas o medidas similares y presentar una imagen general de los efectos de un programa o de una serie de programas. La diversidad de prácticas y definiciones existentes sugiere que pueden considerarse “clave” distintos tipos de indicadores en función de los diferentes grupos usuarios y de los objetivos perseguidos. Pueden hacer referencia a las realizaciones, a los resultados, al impacto…

Los indicadores clave pueden elegirse por tener una importancia estratégica, o bien los responsables de los programas pueden estar interesados, en función de sus necesidades, en definir indicadores sencillos que puedan calcularse y controlarse fácilmente. La utilización de indicadores clave puede contribuir a difundir las buenas prácticas de seguimiento.

El número de indicadores clave debe ser limitado para ser adecuados y manejables en lo que se refiere al seguimiento del programa y al análisis temático o comparativo. Los criterios que se proponen para la selección de estos indicadores son:

- Relevancia: para las prioridades.

- Cuantificación: capacidad de fijar objetivos y en su caso establecer situaciones de base.

- Fiabilidad: claridad de definición y facilidad de agregación.

- Disponibilidad: sobre el terreno para su incorporación al sistema de seguimiento.

Utilización de indicadores en las distintas etapas de un sistema de seguimiento y evaluación

En cada una de las etapas del modelo los indicadores representan una fuente fundamental de información. En la etapa de diseño se emplean indicadores de contexto para el establecimiento de la situación de base, e indicadores de cuantificación previa para precisar los objetivos de las intervenciones y facilitar así su posterior S&E. Para el resto de vida del programa contamos con los indicadores utilizados en el sistema de seguimiento y en los ejercicios especiales de evaluación.

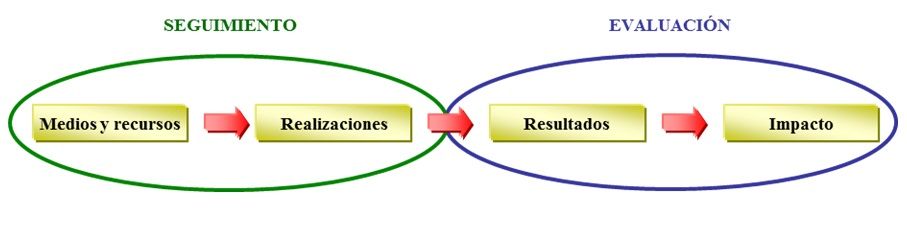

Es importante destacar la distinción entre los indicadores de seguimiento y los de evaluación. Los indicadores de seguimiento se utilizan para la construcción de un sistema de seguimiento que facilite la información sobre el consumo de recursos, la tasa de productividad y el número de beneficiarios…. Los indicadores de evaluación son fundamentalmente indicadores de resultados, impacto, eficacia y eficiencia. La información facilitada por los indicadores de seguimiento puede servir de base para la evaluación.

Límites entre el seguimiento y evaluación

Límites entre el seguimiento y evaluación

Indicadores de seguimiento

Los indicadores de seguimiento incluyen indicadores de contexto, programa y evaluación. Los primeros permiten facilitar la información contextual más reciente sobre las principales características de la zona cubierta. Los demás suministran información sobre la utilización física y financiera de las medidas para cada uno de los años del programa y permiten establecer comparaciones entre la utilización real y la prevista inicialmente en el diseño.

Los datos conviene darlos anualmente tanto en variaciones en comparación con el año anterior como en acumulaciones que agreguen todas las cifras de puesta en práctica desde el principio del programa. En todas las medidas habrá indicadores generales extensibles a todas ellas como los indicadores financieros, proyectos presentados…, y otros específicos de cada una de ellas.

Como se verá al hablar más específicamente del sistema de indicadores de seguimiento, todos los indicadores empleados en él se organizan en tres niveles: clave, de gestión y de rápida retroalimentación.

Indicadores de evaluación

El evaluador desempeñará un papel activo para mejorar la calidad de los sistemas de indicadores. Al mismo tiempo, los indicadores están sujetos a evaluaciones específicas en diferentes etapas. La evaluación previa debe analizar la existencia y pertinencia de indicadores de realización, resultados e impacto en relación con cada uno de los niveles de la intervención