Tipos de evaluación

Existen muchos tipos de evaluación. Muchas particularidades del proceso evaluativo vienen dadas por el momento en que la misma se implementa, es decir, en función del ámbito temporal que cubre la misma. Es así que tenemos evaluaciones previas (durante el diseño de la intervención), intermedias (durante la ejecución), finales (en el momento de finalizar la intervención) y posteriores (tiempo después de finalizada la intervención).

Siguiendo la Colección MEANS de la Comisión Europea (1999) otros tipos de evaluación surgen del distinto nivel de responsabilidad implicado con su nivel de análisis (evaluación de una política, un programa o proyecto lo que da lugar a evaluaciones locales, regionales, nacionales…), del contenido de la evaluación (evaluación de conjunto, temática o detallada) o la utilidad de los trabajos de seguimiento y evaluación (la formación, el aprendizaje, la capacitación…)

En los casos de sucesión de periodos de programación se impone la necesidad de crear una vinculación entre las evaluaciones previas, intermedias y finales. Es muy importante tener en cuenta la complementariedad de todos los trabajos de evaluación, de manera que cada evaluación pueda recurrir a las precedentes y contribuir a las que vengan en un futuro evitando la redundancia. De igual forma, los vínculos entre los diferentes niveles de responsabilidad (política, programa, proyecto) se traducen en que las evaluaciones realizadas a un nivel producen conclusiones de interés a otros niveles.

La misma complementariedad encontramos entre las evaluaciones con distinta temática o utilidad que centrándose en determinados aspectos u objetivos de evaluación han de ayudar a la buena marcha global de las intervenciones y el logro de un adecuado proceso de desarrollo.

Evaluaciones según momento de realización

La utilidad de las evaluaciones es necesario relacionarla con el ciclo de vida del programa. Cada etapa de evaluación tendrá una función y resultados que deben servir de punto de partida y ser incorporados en las posteriores etapas de evaluación. Cada evaluación debe aprovechar los resultados de evaluaciones anteriores, es decir, que la evaluación intermedia debe tener presentes los resultados de la previa, y la evaluación posterior las conclusiones de la evaluación intermedia (que incluyen la previa). Por otro lado, en todos estos ejercicios de evaluación se ha de tener en cuenta la información que del seguimiento esté disponible en cada caso.

Es necesario cubrir mediante las diferentes etapas de evaluación los distintos planos de evaluación: la situación de partida, la ejecución y los resultados del programa.

Evaluación previa (ex-ante o a priori)

Ex ante evaluation (Términos relacionados en inglés: prior appraisal, needs assessment)

Evaluation ex ante (Términos relacionados en francés: Appréciation ex ante, evaluation a priori, diagnostic)

Evaluación que se realiza antes de la implantación, durante el diseño de la programación, y sirve para preparar lo que se quiere hacer y facilitar su aplicación. Más en concreto, ayuda a definir los objetivos y su adecuación a las necesidades, así como a garantizar la pertinencia, el fundamento y la coherencia del programa, dejando para una fase posterior del proceso de evaluación el análisis exhaustivo de la eficiencia y la eficacia. Una buena evaluación previa facilita el trabajo del equipo evaluador a la hora de hacer una valoración de lo que se ha hecho una vez comenzada la ejecución o finalizada.

Evaluación continua y autoevaluación

On-going evaluation (Términos relacionados en inglés: rolling evaluation)

Evaluation chemin-faisant (Términos relacionados en francés: evaluation in itinere)

Evaluación que abarca todo el periodo de implantación de una intervención. Esta forma de evaluación es la propia del seguimiento o monitoreo y a menudo se identifica con él. La evaluación continua puede verse como una serie de estudios detallados, que comprenden análisis sucesivos de cuestiones de evaluación que han surgido durante la implantación. Para aclarar el término autoevaluación (self-evaluation, auto-évaluation) conviene primero esclarecer los términos de evaluación interna y externa:

- Por evaluación interna (internal evaluation, evaluation interne) se entiende la evaluación de una intervención pública por un equipo de evaluación perteneciente a la autoridad administrativa responsable del programa. Es independiente si el equipo de evaluación no tiene una relación jerárquica con los actores que implantan la intervención. De otra manera, sería una autoevaluación.

- Por evaluación externa (external evaluation, evaluation externe) se entiende la evaluación de una intervención pública por personas no pertenecientes a la administración responsable de su implantación. Por ejemplo, un equipo compuesto por consultores privados, investigadores o personas pertenecientes a organismos públicos no relacionados con aquellos responsables de la intervención.

Una vez definidos estos dos términos, se entiende por autoevaluación a la evaluación de una intervención pública por la organización que participa directamente en su implantación

Evaluación intermedia (mid-term)

Mid-term evaluation

Evaluation à mi-parcours, evaluation intermédiare

Aparte de la autoevaluación por el personal del programa, en muchas ocasiones se puede emprender una evaluación más formal durante la ejecución del mismo. La práctica común es realizar un ejercicio de evaluación en medio de la ejecución, cuando el programa ha superado sus problemas iniciales, ha comenzado el flujo de sus servicios e insumos a la población considerada como objetivo y se pueden observar sus reacciones iniciales.

Una evaluación intermedia se lleva a cabo típicamente dos, tres o cuatro años después de haber comenzado la ejecución. Es la primera mirada amplia al programa desde su comienzo. Lo que distingue a ésta de evaluaciones ulteriores es que las resultados de la evaluación todavía se pueden aplicar al programa evaluado e introducir mejoras en la ejecución, o, en algunos casos, revisar los objetivos o prioridades y las medidas adoptadas. La evaluación intermedia es así un medio para mejorar la calidad y pertinencia de los programas y su implementación y para identificar reorientaciones a la programación que pueden ser necesarias para el logro de los objetivos originales. También permite comprobar la pertinencia de las directrices dadas, los criterios e indicadores establecidos para el seguimiento y evaluación del programa.

La evaluación intermedia puede además proporcionar información valiosa a las autoridades responsables del programa. Al tiempo que cubre las preguntas de evaluación, examinaría en particular los logros iniciales, su pertinencia y coherencia con el documento de programación y en qué medida se han alcanzado los objetivos. También analizaría el uso de los recursos financieros, el seguimiento y la ejecución.

Evaluación final y posterior

Ex-post evaluation

Evaluation ex-post, evaluation a posteriori

Evaluación que recapitula y juzga una intervención una vez terminada. Su objetivo es justificar el empleo de recursos, el logro de los efectos previstos (efectividad) y de los efectos inesperados (utilidad), y la eficacia de las intervenciones. Pretende entender los factores de éxito o fracaso, además de la sostenibilidad de los resultados e impactos. También intenta sacar conclusiones que se puedan generalizar para otras intervenciones.

Para que los impactos tengan tiempo de materializarse deben transcurrir dos o tres años después de la implantación de una intervención. Algunos organismos recomiendan incluso el transcurso de diez años lo que está reñido con la urgencia para la obtención de los resultados obtenidos. Esto nos lleva a distinguir entre dos tipos de evaluación una vez finalizada la intervención: la que llamamos evaluación final propiamente dicha, una vez concluida la intervención, y la evaluación posterior, una vez transcurrido el tiempo que se estime necesario para la materialización de los impactos.

La principal diferencia entre la evaluación intermedia y la final y posterior es que la primera estará más enfocada hacia los logros iniciales, mientras que éstas se centrarán más en los impactos.

Evaluaciones según nivel de análisis

En los últimos años se ha favorecido la programación integrada de las intervenciones. Un plan se compone de numerosos programas, y éstos a su vez se componen de numerosos proyectos dentro del marco de unos objetivos específicos dirigidos a la consecución de unos objetivos más globales.

En cada nivel nos encontramos con un conjunto de necesidades distintas aunque complementarias, son distintas las necesidades en materia de información y la orientación que se da a la evaluación en cada uno de estos niveles. A un nivel local seguramente interese obtener, mediante una evaluación interna, un análisis de sus propias actividades con el fin de mejorar sus resultados futuros. También interesará disponer de una información seleccionada y sinóptica para ofrecerla a otros niveles y así rendir cuentas de sus acciones y gastos. Mientras en un nivel ya regional, nacional o continental se preferirá, sin duda, presentar los resultados de los diferentes programas (o regiones, o países dependiendo del nivel) y evaluar la asistencia técnica prestada a cada uno de ellos. Asimismo en este nivel, se querrá conocer las repercusiones de los programas y saber si la política aplicada sirve para que las acciones sean más eficaces que otros métodos y políticas que se puedan aplicar. En cualquier caso, los resultados obtenidos en la evaluación de un determinado nivel de análisis (local, regional…) deben servir de base para la realización de una síntesis a un nivel superior (nacional, continental…).

En definitiva, en la evaluación se ha de elegir un nivel de análisis apropiado. Los resultados de un programa pueden analizarse a un nivel macro (conjunto de la sociedad y de la economía), sectorial, o micro (empresa, familia, explotación agraria, etc.). Las ayudas recibidas pueden haber sido muy importantes para sacar una determinada empresa adelante, pero estas ayudas pueden haber sido totalmente irrelevantes en el desarrollo de un determinado sector en una zona concreta. Asimismo estas ayudas pueden no haber tenido repercusión alguna en el comportamiento de los indicadores de una comarca, mucho más afectados por el comportamiento del tipo de interés o por los vaivenes de la política laboral. Saber situar la evaluación en el nivel apropiado no siempre es evidente.

En este sentido es importante el concepto de metaevaluación (meta-evaluation, méta-évaluation) referido a la evaluación de otra evaluación o de una serie de evaluaciones. Los criterios de juicio generalmente son fiabilidad, credibilidad y utilidad. El término se aplica a veces a la auditoria de la función evaluadora de una organización (para verificar que las normas relacionadas con la evaluación se han aplicado de manera profesional), y otras veces se emplea el término metaevaluación para referirse a una síntesis basada en una serie de evaluaciones.

Evaluaciones según contenido

El mundo real es complejo, con múltiples variables en el entorno de los programas, y además puede ser abordado desde muy diversos puntos de vista. En este sentido conviene hablar de evaluación multicriterio, es decir juzgar una intervención desde una perspectiva múltiple y con un enfoque crítico pluridisciplinar. Podemos hablar de al menos cuatro perspectivas o enfoques que deben ser considerados en la evaluación de un proyecto o programa de desarrollo: económico, financiero, social y medioambiental. Según el contenido en el que nos centremos podemos tener distintos tipos de evaluación.

Evaluación global

Overall Evaluation

Evaluation d’ensemble

Es la evaluación de una intervención en su totalidad. La evaluación global se ocupa de todas las acciones financiadas dentro de una intervención. Engloba la totalidad de las herramientas empleadas, de los territorios aplicables, de los impactos previstos y de los temas relevantes. La evaluación global a menudo constituye el primer paso en la investigación de un terreno a evaluar, antes de una segunda fase de concentración en forma de evaluaciones temáticas o específicas.

Evaluación temática

Thematic evaluation

Evaluation thématique

Evaluación que analiza transversalmente un punto específico (un tema) en el contexto de diferentes intervenciones dentro de un único programa o de diferentes programas implantados en diferentes países o regiones. El tema puede tener relación con el impacto previsto o con un área de intervención. El concepto de la evaluación temática es muy similar al del estudio específico que veremos a continuación.

Cuando hablamos de evaluación de impacto, hablamos de una evaluación final realizada generalmente varios años después de haber concluido una intervención, que se concentra en el fin y el propósito de la intervención, así como en su “sostenibilidad” y efectos imprevistos. Está íntimamente relacionada con lo que hemos llamado anteriormente una evaluación posterior.

Los objetivos perseguidos en cada intervención son diferentes, por lo que la importancia de las evaluaciones será distinta. Si se evalúa una intervención desde la perspectiva de un agente de la economía, utilizando precios de mercado la evaluación principal será de tipo financiera.

Si nos encontramos con una intervención cuyos objetivos son además de los estrictamente financieros, los de eficiencia o eficacia de la economía de un país en su conjunto – estimando por ejemplo la contribución de la intervención al crecimiento del producto interior bruto (PIB) – se denomina económica.

Si además del objetivo de eficiencia se pretende la distribución funcional y territorial de la renta, la creación del empleo y la satisfacción de necesidades básicas, la evaluación se denomina social. En las intervenciones financiadas con fondos públicas las evaluaciones económica y social son básicas.

La evaluación que se centra en la variable ambiental es la EIA o Evaluación de Impacto Ambiental (Environmental Impact Assessment (EIA), Evaluation d’impact sur l’Environnement (EIE)) y estudia todas las repercusiones de un proyecto individual sobre el entorno natural. Se trata de una evaluación generalizada en todos los países industrializados para proteger la degradación continua del medio ambiente, siendo recomendada por los Organismos internacionales y en especial por la UE, donde desde 1985 la EIA queda dotada de una regulación específica reconociéndola como el instrumento más adecuado para la preservación de los recursos naturales y la defensa del medio ambiente.

La EIA tiene dos pasos: la investigación general, que consiste en un primer análisis para determinar el nivel de evaluación medioambiental necesaria para aprobar la implantación; y el estudio del ámbito, que determina qué impactos deben evaluarse en profundidad. La evaluación de impactos medioambientales examina los efectos previstos e imprevistos, a menudo, los imprevistos son más numerosos.

La EIA es obligatoria en ciertos países en grandes proyectos de infraestructura. Por contraste, la Evaluación Estratégica Medioambiental (EEM) o Evaluación Ambiental Estratégica (EAE) se refiere a la evaluación de programas y de políticas prioritarias.

También está el método de evaluación conocido como análisis del ciclo de la vida (life cycle assessment, LCA) formalizado a principios de los noventa como respuesta a la necesidad de conocer y valorar los efectos medioambientales de los productos, procesos y actividades generados por las intervenciones.

Evaluación específica

In-depth evaluation

Evaluation approfondie

Consiste en concentrar una evaluación o parte de ella en una categoría determinada de productos, en un grupo, o en una categoría de impactos. Esto permite un análisis más específico, al contrario de la evaluación global, que pretende ser exhaustiva.

La evaluación global de un programa puede acompañarse por el análisis específico de una o más cuestiones. Así mismo, puede optarse por realizar una evaluación dedicada exclusivamente al análisis específico de una única cuestión. La concentración en una cuestión específica permite emplear técnicas de evaluación más rigurosas y por lo tanto más fiables, sobre todo para observar la conducta de los destinatarios, estudiar un grupo de comparación, o analizar los efectos netos. El análisis específico, al concentrarse básicamente en la observación sobre el terreno de los efectos, tiene relación con la evaluación intermedia y final.

Evaluaciones según utilidad

La utilidad de una evaluación está en función de los protagonistas a los que se dirige y su finalidad. Antes de desarrollarla conviene aclarar algunos términos relacionados con ella:

- Retroalimentación (Feedback, Rétroaction): El feedback existe cuando la observación de resultados e impactos en el campo se utiliza para ajustar la implementación de una intervención, o para hacer cambios más radicales, incluso cuestionando la existencia de la intervención. La retroalimentación es el propósito principal de la evaluación cuando tiene una orientación de gestión, formativa o de aprendizaje.

- Aprendizaje organizacional (Organisational learning, Apprentissage organisationnel): Es el hecho de que las lecciones extraídas de la experiencia son aceptadas y retenidas por las instituciones u organizaciones responsables de la intervención. El aprendizaje va más allá del feedback, las lecciones son capitalizadas o pueden ser aplicadas a otras intervenciones.

- El aprendizaje directo (llamado aprendizaje de bucle simple) existe cuando los usuarios aprenden que la intervención ha sido un éxito o un fracaso. Esto puede llevarles, por ejemplo, a reducir los presupuestos asignados a las intervenciones menos importantes.

- El aprendizaje indirecto (llamado aprendizaje de bucle doble) existe cuando los usuarios se dan cuenta de que ellos deben cuestionar sus presuposiciones básicas (su teoría de acción). Esto puede causarles, por ejemplo, reorganizar la implementación de las intervenciones menos exitosas.

- Contabilidad (Accountability, Rendre des comptes): Es la obligación de los actores participantes en la introducción o implementación de un programa de desarrollo, de proporcionar a las autoridades y al público general la información y explicación de los resultados esperados y actuales de una intervención, respecto al uso notorio de recursos públicos.

Desde una perspectiva democrática, la contabilidad es una dimensión importante de la evaluación. Las organizaciones y autoridades públicas están aumentando de manera progresiva sus peticiones de transparencia cara a cara a sus contribuyentes. Con este espíritu, la evaluación debe ayudar a explicar simplemente dónde se gasta el dinero, que efectos produce y cómo se justifica el gasto.

Evaluación formativa

Formative evaluation

Evaluation endoformative

Es la evaluación que está dirigida a gerentes y protagonistas directos, para ayudarles a mejorar sus acciones (retroalimentación o feedback). La evaluación formativa se aplica principalmente durante la implementación (evaluación continua o intermedia). Se centra principalmente en los procedimientos de implementación y su efectividad y relevancia. La distinción entre evaluación formativa y de resumen ha sido definida de manera ingeniosa: Cuando el cocinero prueba la sopa, es formativa; cuando los invitados prueban la sopa, es de resumen

Evaluación de resumen

Summative evaluation

Evaluation récapitulative

Se llama a así a la evaluación realizada por actores que no están implicados directamente en la gestión de la intervención pública (instituciones políticas o profesionales, fundaciones, la prensa, etc.) para producir una valoración global y distante de una determinada intervención.

Se dice que la evaluación es de resumen o recapituladora cuando se dirige a la contabilidad de las acciones, y cuando sirve tanto para juzgar la intervención pública como para ayudar a las autoridades responsables a decidir sobre su lanzamiento, mantenimiento, aplazamiento, supresión y reproducción. En tales instancias, los usuarios son cuerpos financiadores externos y posiblemente otros actores sociales que puedan decidir para sus propios propósitos sobre la conveniencia de adoptar mejores prácticas identificadas durante la evaluación del programa

Evaluación participativa

Stakeholder evaluation, partnership evaluation, pluralistic evaluation

Evaluation participative, evaluation partenariale, evaluation pluraliste

El enfoque pluralista diseñado como un proceso de solución de problemas colectivo implicando a todas las partes a las que concierne. Sobre las bases de la información creíble aceptadas por todos, los juicios de valor son formulados mediante acuerdos de búsqueda dentro del ámbito de la autoridad de evaluación consistente en oficiales administrativos y políticos, así como en interlocutores para los grupos a los que concierne.

Evaluación como aprendizaje social

Evaluation as social learning

Évaluation comme apprentissage social

La evaluación concebida como un aprendizaje de todos los protagonistas implicados en su realización. No se trata tan sólo de un enfoque pluralista entre todas las partes implicadas, supone una predisposición de todos los participantes por aprender: los expertos de la población, y la población de los expertos, en un intercambio de conocimientos y experiencias que termina enriqueciendo los ejercicios de seguimiento y evaluación.

Es un tipo de evaluación que implica las tres anteriores, la evaluación formativa, la de resumen y la participativa. Implica abrir un proceso de participación cuyo objetivo es el aprendizaje de todos. Siguiendo con el símil anterior, el cocinero prueba la sopa, los invitados también y tratan de llegar a un consenso sobre los mejores modos de hacer.

Evaluación democrática

Democratic evaluation

Évaluation démocratique

Un enfoque evaluativo dirigido a mejorar la calidad y transparencia del debate democrático, tanto a través de la promoción de un conocimiento y entendimiento de la lógica y efectos de la intervención como a través de un juicio de su justificación y efectividad.

La evaluación se define como un “juicio sobre los valores de la intervención” por personalidades elegidas de manera democrática. Los profesionales de la evaluación están al servicio de esta autoridad y tienen un papel técnico exclusivo. El proceso es público. Este tipo de evaluación se aplica en el caso de una intervención experimental que, a la vista de los resultados obtenidos tras los primeros años, debe ser confirmada mediante votación.

Evaluación de gestión

Managerial evaluation

Evaluation managériale

Un enfoque evaluador integrado en la gestión de las intervenciones públicas, y dirigida hacia cambios recomendatorios relacionados tanto con la toma de decisiones (feedback) como con el comportamiento de los actores responsables de la implementación de la intervención.

La aproximación general de la evaluación de gestión es similar a la de la nueva gestión pública, y está dirigida a coordinar el problema del estancamiento de la renta pública. La cuestión subyacente puede formularse de la siguiente manera: ¿cómo puede justificarse la compensación entre las diferentes políticas sectoriales? El enfoque dominante aquí que sucede dentro del ámbito de la administración, es el de la “optimización” de los recursos presupuestarios.

La calidad de la evaluación de gestión se basa en dos principios: la independencia del evaluador y la objetividad del método. La objetividad debe garantizarse por la calidad del sistema de indicadores utilizado, la fiabilidad de la información y la neutralidad en la interpretación de los resultados.

Referencias citadas:

Comisión Europea (1999). MEANS collection: evaluating socio-economic programmes. Directorate-General for Regional Policy, & Cohesion. Office for Official Publications of the European Communities.

About Carlos Plaza

46. Complementación de enfoques: El enfoque top-down frente al enfoque bottom-up en la evaluación

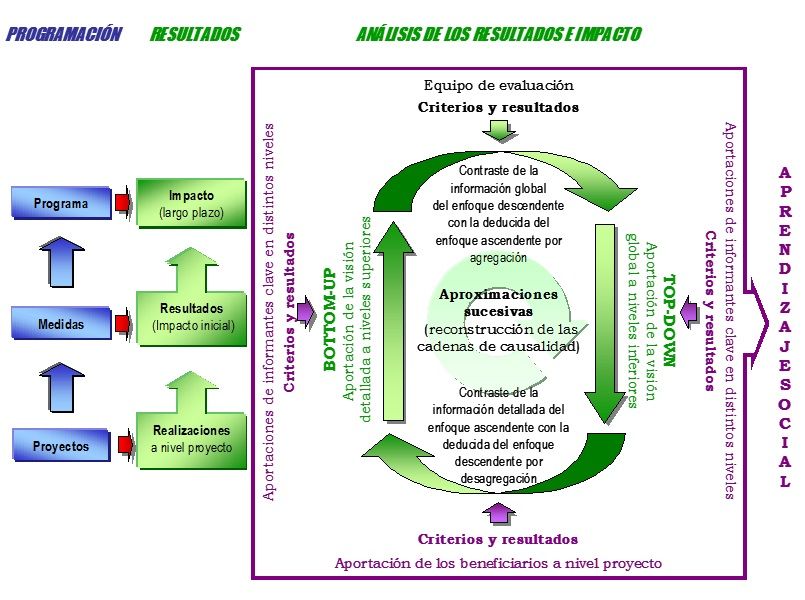

Tradicionalmente han existido dos enfoques de aproximación al desarrollo, a su planificación, seguimiento y evaluación: los enfoques descendente (top-down) y ascendente (bottom-up). Estos enfoques parten de la necesidad mutua que existe entre los planes y los proyectos. Planes a gran escala que ordenen y orienten los proyectos y unidades de inversión, y proyectos a pequeña escala que concreten los planes y grandes líneas de actuación. La diferencia entre ambos enfoques se relaciona con el dilema que con frecuencia se ha planteado sobre la primacía cronológica de unos u otros. Analicemos el papel que ambos enfoques han tenido dentro de campo de la evaluación.

En el enfoque descendente, característico de las grandes organizaciones internacionales, lo principal ha sido siempre el problema. Los modelos de evaluación creados bajo este enfoque se estructuran sobre la base de cuestiones básicas que se buscan resolver, estableciendo las propiedades de los programas y desarrollando en detalle las especificaciones, es decir, mirar la aplicación desde arriba, en forma general para luego ir a los niveles de detalle. Se trata de modelos centrados en las repercusiones globales de las intervenciones, en las interacciones de los diversos programas o medidas implementados y en los efectos directos a corto plazo.

Esta visión, predominante en la planificación hasta la segunda mitad de los años 70, ha tendido a identificar desarrollo con crecimiento económico. Esto hace que a la hora de evaluar prime la idea de eficacia frente a la de equidad, lo que unido a la ausencia de consideración del componente social y territorial resulten unos modelos de evaluación que no tienen en cuenta el incremento y consolidación de los desequilibrios.

El enfoque ascendente ha sido más característico de organizaciones no gubernamentales (ONG), que cooperan con entidades locales como universidades, empresas, hospitales, etc., con objeto de poner en marcha proyectos y programas en campos que afecten directamente a beneficiarios locales. Este enfoque se centra primero en los detalles de la aplicación para llegar luego al sistema global.

Se trata de un enfoque que surge en los trabajos de planificación de los años 80, bajo un punto de vista más integrado y una visión más amplia del desarrollo. El enfoque plantea un desarrollo desde abajo que en absoluto se cierra ante las políticas a otros niveles sino que complementa las actuaciones en el ámbito regional o nacional con la revalorización de lo local y que no sólo permite sino que exige una participación activa de las instituciones, agentes y valores socioculturales locales. Dentro de este modelo la identidad propia de lo local es el pilar fundamental y la participación es condición imprescindible.

Los modelos de evaluación surgidos de este enfoque tienen una clara vocación participativa donde los beneficiarios del desarrollo tienen un papel activo muy importante. El enfoque ascendente, al partir de una muestra de proyectos y medidas, puede traducir mejor los efectos a largo plazo que el enfoque descendente, efectos que resultan más estructuradores e indirectos. Por el contrario, el enfoque ascendente no permite agregar los efectos a escala de medidas y de programa, por lo que las consideraciones cualitativas sobre la eficacia de las medidas y el nivel de adicionalidad de las intervenciones han de corresponder al enfoque descendente.

En cuestiones de impacto, una combinación de los enfoques acendente y descendente puede aportar un valor añadido al análisis, en particular si se apoya en técnicas de modelización o de formalización. Pero falta todavía un lazo de unión importante entre ambos enfoques en la mayoría de los casos. Este puente lo puede constituir un modelo de evaluación que se inserte en la tradición del aprendizaje social (Friedmann, 2001) cuya creencia esencial es que la práctica y el aprendizaje están concebidos como procesos correlativos, de forma que un proceso implica otro.

Este modelo de evaluación de los resultados, al igual que en la planificación como aprendizaje social, tendría una doble dirección ya que, partiendo de las aportaciones de los agentes beneficiarios a nivel proyecto elabora criterios y resultados para la evaluación, y, de otro lado, refleja sus propios criterios y resultados conforme a la evaluación del programa que tiene en el horizonte.

La evaluación de un programa no es ni la suma ni la síntesis de las evaluaciones de sus proyectos. Algunas cuestiones de evaluación no tienen sentido al nivel de un proyecto individual pero sí resultan interesantes en la evaluación global del programa. Lo que es importante es que los resultados obtenidos en la evaluación de un determinado nivel de análisis sirvan de base para la realización de una síntesis a un nivel superior.

La evaluación de un proyecto debe ser realizada en relación con los objetivos del programa. Inversamente, en la evaluación global del programa, a menudo se ha de ir de los proyectos al programa en un proceso ascendente. En muchos casos el análisis inicial se puede centrar en los proyectos y medidas específicas para extenderse luego en el programa completo y poder estudiar la causalidad de los impactos. En este sentido la evaluación de los proyectos contribuye a la evaluación del programa.

La ventaja encontrada en esta articulación de proyecto a programa es la posibilidad de obtener una detallada explicación de la secuencia de impactos a corto y medio plazo. Los límites de este enfoque ascendente están en el hecho de que obliga al equipo evaluador a hacer un conjunto cada vez mayor de suposiciones a medida que los efectos a evaluar van siendo más distantes y complejos, los llamados efectos globales. La articulación con el enfoque descendente ayuda a estimar esta repercusión global de los impactos producidos por las intervenciones. Se trata de un ejercicio de contraste entre la información obtenida directamente en el enfoque descendente con la deducida a través de las suposiciones del enfoque ascendente.

El aprendizaje social como puente para una auténtica combinación de los enfoques descendente (top-down) y ascendente (bottom-up) en las evaluaciones.

El aprendizaje social como puente para una auténtica combinación de los enfoques descendente (top-down) y ascendente (bottom-up) en las evaluaciones.

El dilema sobre el uso de un enfoque u otro puede resolverse en la práctica conjugando los dos enfoques opuestos de tal forma que, por aproximaciones sucesivas, nos conduzca a la elaboración de una evaluación que englobe la información detallada obtenida directamente de los proyectos específicos, cuyos resultados finales coinciden con los resultados generales del plan. El análisis de proyectos específicos representa aquí el último acto de la evaluación global desde arriba y el primero de la evaluación desde abajo. En definitiva, ambos enfoques son necesarios y es importante que ambos enfoques puedan complementarse para aumentar las posibilidades de los trabajos de evaluación.

Referencias citadas:

Friedmann, J. (2001). Planificación en el ámbito público. Ministerio de las Administraciones públicas. Madrid (Original de 1991).

About Carlos Plaza

Complementación de enfoques: seguimiento detallado frente al seguimiento de procesos

Cuando se diseña un programa es necesario dictar disposiciones para la construcción, mantenimiento y uso de un sistema de información, uno de los elementos fundamentales de todo buen sistema de seguimiento. Entre los medios más comunes para diseñar un sistema de información están los enfoques detallado y de procesos.

Para el enfoque detallado, el equipo de planificación y evaluación previa formula planes minuciosos de trabajo antes de la ejecución del programa. En esos planes se especifican los objetivos del sistema, los datos que se precisan, los estudios que han de emprenderse y las necesidades de personal y presupuestarias.

Este enfoque no da al personal de seguimiento la flexibilidad suficiente para responder a necesidades inesperadas de información, que pueden presentarse durante la ejecución. Estos imprevistos surgen con frecuencia debido a que no se pueden prever todas las eventualidades. Los expertos preparan el plan detallado partiendo del supuesto de que todo lo relacionado con el programa, incluidos los riesgos y las dificultades, se llevará adelante como se había previsto. Y no siempre ocurre así. Además, este enfoque ofrece al personal del proyecto poca o ninguna aportación directa en la formulación del sistema de información y seguimiento. Los gestores no se identifican con esos sistemas, pues a menudo no responden a sus necesidades de gestión diarias, y los consideran como distintos de sus preocupaciones de gestión. Muy a menudo da lugar a un uso deficiente de esos sistemas.

El enfoque de procesos, por el contrario, asume un punto de vista evolutivo de las necesidades de información, de herramientas para su obtención y del sistema de autoevaluación. No se especifican planes y programas de trabajo: simplemente se esbozan. Las actividades específicas son determinadas a medida que van siendo necesarias. El enfoque de procesos hace que el sistema de seguimiento sea un instrumento eficaz para los gestores. Les permite utilizar sus recursos para recopilar y analizar datos sobre los temas y problemas que ellos consideran importantes para la ejecución y gestión diaria del programa.

Complementación del enfoque detallado con el enfoque por procesos del sistema de seguimiento

Complementación del enfoque detallado con el enfoque por procesos del sistema de seguimiento

La experiencia indica que el éxito del enfoque de procesos depende en gran medida de la iniciativa y la capacidad del personal de seguimiento. Este es el principal problema que se plantea con ese enfoque, ya que los programas de desarrollo se ubican en zonas que se enfrentan a la escasez de personal cualificado y con experiencia. Es difícil contratar profesionales locales con las aptitudes e iniciativa necesarias, y es complicado conservarlos en una función de seguimiento.

En estos casos, el enfoque detallado puede resultar más práctico, pero es importante estar abierto a la flexibilidad que da el enfoque de procesos y combinar ambos enfoques cuando se vea posible. De esta forma, en la etapa de evaluación previa puede detallarse un diseño amplio para el sistema, y durante la ejecución actuar con un grado considerable de flexibilidad que permita reaccionar ante nuevos problemas y oportunidades. Se puede dar cabida así a las necesidades de seguimiento a medida que se vaya desarrollando el programa.

About Carlos Plaza

Complementación de enfoques: La evaluación de objetivos frente a la evaluación de procesos

En la planificación y ejecución de políticas, programas o proyectos es común distinguir entre la gestión por objetivos y la gestión del proceso. En el primer concepto se hace hincapié en que la planificación se dirige hacia un objetivo predeterminado; en el segundo el acento se pone en ajustar el rumbo del programa según la experiencia adquirida en su transcurso. De igual forma, en el trabajo de evaluación podemos distinguir entre el enfoque por objetivos y el enfoque por procesos:

- Evaluación de objetivos: Análisis de los efectos de una intervención considerados en relación con los objetivos establecidos en la misma; es decir, en qué medida los impactos son causados por la intervención o se deben a factores externos.

- Evaluación de procesos: Análisis de una intervención y de cómo ésta funciona en un contexto social, a fin de comprender los procesos generados y sus consecuencias en el sentido más amplio.

Con el enfoque por objetivos el principio fundamental es formular hipótesis sobre la base de una teoría establecida, imaginando sus consecuencias, por ejemplo, en forma de objetivos; aquéllas son después contrastadas con la realidad observable en el momento de realizarse la evaluación. Una ventaja encontrada en este enfoque es que, en gran medida, toma como punto de partida la experiencia existente, lo que facilita la selección de datos y las posibilidades de interpretación.

La principal crítica a este enfoque es que puede fácilmente conducir a una situación en que tanto los temas como las áreas problema están tan estrictamente delimitadas que podrían pasarse por alto aspectos importantes. En ocasiones, los programas cuentan con objetivos poco claros o formulados inadecuadamente; además, las intervenciones normalmente dan lugar a impactos no previstos –tanto positivos como negativos– que pueden dejarse de lado si la evaluación se centra únicamente en lo que se ha identificado previamente como el objetivo de la intervención.

Por contraste el enfoque por procesos no se establece sobre un conjunto de teorías o hipótesis acerca del desarrollo. El investigador comienza con una actitud abierta e interrogante. A través de la observación y la investigación, surgen temas que sucesivamente demandan nuevos conocimientos, conduciendo de manera gradual a nuevas revelaciones. Este enfoque consume tiempo y demanda mucho esfuerzo. Una de las objeciones principales es que, a fin de evitar desviaciones subjetivas, es a menudo necesario conceder un énfasis especial a la selección de datos, perspectivas y métodos y explicar estos aspectos en detalle.

En la práctica los enfoques de evaluación por objetivos y por procesos pueden complementarse (NORAD-UD, 1997). En la planificación y ejecución esto puede hacerse analizando de nuevo y, si es necesario, redefiniendo la formulación de la intervención sobre la marcha, a medida que se adquiere nueva experiencia. Esto permite asegurar el grado de flexibilidad necesario en la gestión y dirección de programas. En ese caso, los estudios de proceso pueden ser de considerable valor.

En el trabajo de evaluación, esto se puede conseguir ampliando la perspectiva más allá del marco que fue inicialmente planificado –productividad y eficacia– para incorporar varios aspectos imprevistos o difícilmente predecibles como los impactos, pertinencia y viabilidad. En el fondo se trata de estar abiertos a las necesidades de evaluación que se puedan presentar y abordarlas de la forma que mejor se considere dentro del marco previsto de objetivos, tiempos y recursos inicialmente programados para la evaluación.

Complementación del enfoque por objetivos con el enfoque por procesos para la mejor adecuación a las necesidades de evaluación de los programas

Complementación del enfoque por objetivos con el enfoque por procesos para la mejor adecuación a las necesidades de evaluación de los programas

Referencias citadas:

NORAD-UD (1997). Evaluación de proyectos de ayuda al desarrollo. Manual para evaluadores y gestores. Agencia Noruega de Desarrollo-Unidad de Evaluación del Ministerio Noruego de Asuntos Exteriores. Instituto Universitario de Desarrollo y Cooperación (IUDC) – Universidad Complutense de Madrid – Fundación Centro Español de Estudios de América Latina (CEDEAL). Madrid.

About Carlos Plaza

Complementación de enfoques: Cuanti y Cuali

En la actualidad, es muy frecuente encontrarse con evaluaciones que combinan aspectos procedentes de varios enfoques y modelos, lo cual permite satisfacer necesidades de información de muy distinto signo y enriquecer los resultados obtenidos. Las fronteras entre los diferentes modelos son cada vez más difusas y es importante encontrar para cada ocasión un equilibrio entre las exigencias de rigor —fundamentalmente de tipo técnico (obtención de información fiable para la toma de decisiones) y financiero (control de fondos)— y las demandas de participación de la población local. Por otro lado, debido a la multiplicidad de los tipos de programas, disponibilidad de datos, restricciones de tiempo y circunstancias de las distintas regiones y países, cada evaluación es diferente y requiere cierta combinación de enfoques y prácticas adecuadas.

En esta línea, cada vez hay más aceptación sobre la necesidad de complementar los métodos cuantitativos y cualitativos. Existen significativas ventajas y desventajas en la selección de unos u otros. Los métodos cualitativos permiten estudiar cabalmente los temas, casos o hechos seleccionados y pueden proporcionar información decisiva sobre las perspectivas de los beneficiarios, la dinámica de una determinada reforma o los motivos de ciertos resultados observados en un análisis cuantitativo.

Al combinar los dos enfoques, los métodos cualitativos están capacitados para dar forma a las cuestiones principales de la evaluación, diseñar los cuestionarios empleados, estratificar la muestra cuantitativa y analizar el marco social, económico y político dentro del cual se llevaba a cabo un programa. A su vez, los métodos cuantitativos pueden apoyar con sus resultados las conclusiones de los métodos cualitativos.

Integración de los enfoques cuantitativo y cualitativo para la mejor satisfacción de las necesidades de seguimiento y evaluación de los programas de desarrollo

Integración de los enfoques cuantitativo y cualitativo para la mejor satisfacción de las necesidades de seguimiento y evaluación de los programas de desarrollo

Las ventajas de este enfoque integrado son claras:

- Se pueden incorporar controles de coherencia con la ayuda de procedimientos de triangulación que permiten realizar dos o más estimaciones independientes de las variables clave.

- Se pueden obtener diferentes perspectivas.

- Los análisis se pueden conducir en diferentes niveles. Logrando buenas estimaciones del bienestar individual, familiar y a nivel de la comunidad, así como un buen análisis de los procesos sociales.

Se pueden proporcionar oportunidades de retroalimentación para interpretar los resultados. Los métodos cualitativos permiten un seguimiento rápido en terreno para verificar aparentes incoherencias. En la mayoría de las investigaciones cuantitativas, una vez que finaliza la fase de recolección de datos no es posible regresar al terreno para verificar esos aspectos. La mayor flexibilidad de la investigación cualitativa significa que a menudo es posible regresar al terreno para reunir datos adicionales. Los investigadores de encuestas también utilizan métodos cualitativos para verificar los valores atípicos: respuestas que se desvían de los patrones generales.

About Carlos Plaza

Enfoque de evaluación realista

Referencias citadas:

Bamberger, M., Rugh, J. & Mabry, L. (2012). Real World Evaluation: Working under Budget, Time, Data, and Political Constraints (2nd ed.). Thousand Oaks, CA: Sage Publications.

About Carlos Plaza

Una clasificación de modelos de evaluación

Los enfoques y modelos de evaluación constituyen una filosofía de trabajo que definen lo que el evaluador busca en el fondo cuando realiza su trabajo, la razón y objetivos básicos con los que realiza la evaluación. Son numerosos los modelos y enfoques que enriquecen la práctica evaluadora (Christie & Fleischer, 2010; Patton, 2008; Stufflebeam & Shinkfield, 2007) y se aconseja ser pluralista en este aspecto, conocer bien los distintos modelos y aplicar los que más convengan en cada caso. Una tendencia muy común es incluso mezclar varios métodos (mix-methods) en una misma evaluación con el objetivo de sacar el máximo partido de las actividades de evaluación.

Tradicionalmente se ha venido hablando de la evaluación cuantitativa en situaciones en las que podemos cifrar los resultados y buscar patrones de comportamiento; por otro lado tenemos la evaluación cualitativa que captura más la diversidad y humaniza los números de la evaluación cuantitativa.

Pero ésta es una división clásica muy genérica. Otras clasificaciones más precisas (Stufflebeam, 2001; Stufflebeam & Shinkfield, 2007) pueden hacernos una idea de los numerosos modelos de evaluación existentes que compiten en el mercado de la evaluación. En esta clasificación podemos encontrar varios tipos de modelos: los orientados a preguntas, los que conllevan una agenda social, los orientados a la mejora y rendición de cuentas, y los eclécticos.

Modelos orientados a preguntas y métodos

Este tipo de modelos se caracterizan por estar enfocados a responder preguntas específicas —para lo que se suelen emplear multitud de métodos y herramientas de evaluación—; o por estar enfocados a utilizar un determinado método de evaluación. Si estas preguntas o métodos son los apropiados para valorar el mérito, valor o importancia de la intervención es otra cuestión. Lo que se determina en este caso son las preguntas o los métodos a utilizar, y lo que cabe desear es que sean las preguntas o métodos adecuados. En cualquier caso, ambos tipos de modelos son algo estrechos en sus miras y a menudo se quedan cortos a la hora de hacer una valoración del mérito, valor e importancia de lo que se evalúa.

Algunos modelos orientados a preguntas y métodos son: evaluaciones basadas en objetivos (goal-based/objectives-based evaluations) (Scriven, 1974), los estudios de coste–beneficio (costs-benefits studies) (Belfield, 2012; Shaffer, 2010), las evaluaciones basadas en la teoría (theory-based/theory-driven evaluation) (McMeekinga et al., 2012; Coryn et al., 2011; Weiss, 1997a; 1997b), las pruebas de control aleatorias (RCT, Randomized Controlled Trials) (Ong-Dean et al., 2011) como el grupo de control o de comparación, y los casos de estudio que analizan en profundidad algún fenómeno concreto.

Modelos que conllevan una agenda social

Los modelos que conllevan una agenda social se caracterizan por tratar de contribuir a la justicia social a través de la evaluación. Buscan asegurar que todos los estratos de la sociedad tienen igualdad de oportunidades y servicios, y parte de sus acciones se encaminan a dar un trato preferencial a los más desaventajados. Para ello favorecen enfoques constructivistas de la evaluación y el uso de métodos cualitativos.

Algunos modelos que conllevan una agenda social son: los modelos centrados en el cliente (responsive/client-centered evaluation) (Mertens & Wilson, 2012; Stake, 2004) que buscan satisfacer las necesidades de información del cliente; los modelos constructivistas (constructivist/4th generation evaluation) (Mertens & Wilson, 2012; Guba & Lincoln, 1989) que buscan entender los programas bajo el punto de vista de los que se han visto afectados por el programa e interpretar su experiencia; las evaluaciones deliberadamente democráticas (deliberative democratic evaluation) (Mertens & Wilson, 2012; House & Howe, 2000) que utilizan proceso democráticos (inclusión, diálogo, principios deliberativos…) para llegar a conclusiones válidas donde hay puntos de vista conflictivos; el empowerment evaluation (Fetterman, 2001; Fetterman & Wandersman, 2005; 2007; Fetterman, Kaftarian & Wandersman, 2014) que busca construir capacidades entre la población afectada por el programa que se evalúa; y la investigación apreciativa (appreciative inquiry) (Preskill & Catsambas, 2006) que busca analizar lo mejor de una organización para a partir de ahí crear un mejor futuro para ella.

Modelos orientados a la mejora y rendición de cuentas

Los modelos orientados a la mejora y rendición de cuentas se caracterizan por examinar por completo el mérito y valor de lo que se está evaluando, tratando de comprender las causas y considerando una batería completa de preguntas y criterios. En muchas ocasiones emplean un examen de necesidades como fuente de criterios básicos para la evaluación y buscan todo tipo de resultados relevantes, no solo aquellos señalados por los objetivos marcados por la intervención evaluada.

Algunos modelos dentro de esta categoría son: El modelo contexto, entrada, proceso, producto (context, input, process, product) (Stufflebeam, 1983) que utiliza la evaluación para mejorar aquello que se evalúa y retroactivamente para juzgar su valor; los estudios orientados al usuario (consumer-oriented studies) (Scriven, 1991) donde la principal justificación de la evaluación es la satisfacción del usuario de la evaluación, se basa en una visión profundamente razonada de la ética y el bien común, y donde se apuesta por la evaluación independiente y externa.

Modelos eclécticos

Los modelos eclécticos se caracterizan por no estar conectados a ninguna filosofía concreta de evaluación, ni a ningún enfoque metodológico, ni a ninguna misión social. Se trata de modelos donde prima el pragmatismo y utilizan lo que se cree más conveniente de cualquier otro enfoque de evaluación. Están diseñados para acomodarse a las necesidades y preferencias de un amplio espectro de clientes y trabajos de evaluación. Como modelo ecléctico destaca especialmente el enfoque centrado en el uso de la evaluación (Fleischer) (Patton, 2008), que busca fomentar el uso adecuado del proceso y resultados de evaluación.

Referencias citadas:

Belfield, C. (2012). Book Reviews: Multiple Account Benefit–Cost Analysis: A Practical Guide for the Systematic Evaluation of Project and Policy Alternatives. American Journal of Evaluation, 33(1), 141-142.

Christie, C. & Fleischer, D. (2010). Insight into Evaluation Practice: A Content Analysis of Designs and Methods Used in Evaluation Studies Published in North American Evaluation-Focused Journals. American Journal of Evaluation, 31(3), 326-346.

Coryn, C., Noakes, L. Westine, C. & Schröter, D. (2011). A Systematic Review of Theory-Driven Evaluation Practice from 1990 to 2009. American Journal of Evaluation, 32(2), 199-226.

Fetterman, D.M. (2001). Foundations of empowerment evaluation. Thousand Oaks, CA: Sage.

Fetterman, D.M. & Wandersman A. (2005). Empowerment evaluation: Principles in practice. New York: Guilford Publications.

Fetterman, D.M., & Wandersman A. (2007). Empowerment evaluation: Yesterday, today, and tomorrow. American Journal of Evaluation, 28(2), 179-198.

Fetterman, D.M., Kaftarian, S., & Wandersman, A. (2014). Empowerment Evaluation: Knowledge and Tools for Self-Assessment, Evaluation Capacity Building, and Accountability. Thounsand Oaks, CA: Sage Publications.

Guba, E.G. & Lincoln, Y.S. (1989). Fourth generation evaluation. Newbury Park, CA: Sage Publications.

House, E.R. & Howe, K.R. (2000). Deliberative Democratic Evaluation. En K.E. Ryan & L. DeStefano (Eds.), Evaluation as a Democratic Process: Promoting Inclusion, Dialogue, and Deliberation, New Directions for Evaluation 85. San Francisco, CA: Jossey-Bass.

McMeekinga, L., Basileb, C. & Cobb R. (2012). An organizational model to distinguish between and integrate research and evaluation activities in a theory based evaluation Evaluation and Program Planning, 35(4), 508–516.

Mertens, D. M. & Wilson A.T. (2012). Program Evaluation Theory and Practice: A Comprehensive Guide. New York: Guilford Press.

Ong-Dean, C., Hofstetter, C. & STrick, B. (2011). Challenges and Dilemmas in Implementing Random Assignment in Educational Research. American Journal of Evaluation, 32(1), 29-49.

Patton, M. Q. (2008). Utilization-Focused Evaluation (4ª Ed.). Thousand Oaks: Sage Publications.

Preskill, H., & Catsambas, T. (2006). Reframing evaluation through appreciative inquiry. Thousand Oaks, CA: Sage Publications.

Scriven, M. (1974). Evaluation perspectives and procedures. En J.W. Popham (Ed.), Evaluation in education: Current applications. Berkeley, California: McCutcheon Publishing Corporation.

Scriven, M. (1991). Evaluation Thesaurus (4ª Ed.). Newbury Park, California: Sage Publications.

Shaffer, M. (2010). Multiple Account Benefit–Cost Analysis: A Practical Guide for the Systematic Evaluation of Project and Policy Alternatives. Toronto: University of Toronto Press, Scholarly Publishing Division.

Stake, R.E. (2004). Standards-based and responsive evaluation. Thousand Oaks, California: Sage.

Stufflebeam, D.L. & Shinkfield, A.J. (2007). Evaluation theory, models, and applications. San Francisco: Jossey-Bass.

Stufflebeam, D.L. (1983). The CIPP Model for Program Evaluation. En G.F. Madaus, M. Scriven, & D.L. Stufflebeam (Eds.), Evaluation Models: Viewpoints on Educational and Human Services Evaluation. Boston: Kluwer Nijhof.

Stufflebeam, D.L. (2001). Evaluation models. New Directions for Evaluation, 89. San Francisco, CA: Jossey-Bass.

Weiss, C. (1997a). How can theory-based evaluation make greater headway? Evaluation Review, 21(4), 501–524.

Weiss, C. H. (1997b). Theory-based evaluation: past, present, and future. En D. Rog & D. Fournier (Eds.), Progress and Future Directions in Evaluation: Perspectives on Theory, Practice, and Methods. California: Jossey-Bass.

About Carlos Plaza

Limitaciones de modelos de evaluación inspirados en el EML y el ACB

Antes de comenzar con las limitaciones de ambos enfoques es bueno reconocer la enorme aportación histórica del EML y el ACB, como herramientas de planificación han contribuido a articular muchos esfuerzos dispersos de cooperación para el desarrollo. No obstante, su traslado y aplicación en el campo de la evaluación, a pesar de que cuenta con la defensa de numerosos profesionales, ofrece unos resultados mucho más pobres que en el campo de la planificación. Tanto el EML como el ACB, poseen importantes limitaciones, que merece la pena repasar:

Antes de comenzar con las limitaciones de ambos enfoques es bueno reconocer la enorme aportación histórica del EML y el ACB, como herramientas de planificación han contribuido a articular muchos esfuerzos dispersos de cooperación para el desarrollo. No obstante, su traslado y aplicación en el campo de la evaluación, a pesar de que cuenta con la defensa de numerosos profesionales, ofrece unos resultados mucho más pobres que en el campo de la planificación. Tanto el EML como el ACB, poseen importantes limitaciones, que merece la pena repasar:

- El EML adolece de rigidez para inspirar modelos de evaluación, ya que depende de indicadores predeterminados. Lo que da lugar a un modelo poco preparado para el gran grado de incertidumbre que se suele encontrar en el dinámico contexto de las evaluaciones. Supone también un enfoque negativo al estar centrado en el análisis de problemas coartando el posible desarrollo de las capacidades. Además, se trata de una metodología cuyos propios fundamentos y presupuestos impiden y restringen la participación local en las evaluaciones.

- Por su lado, el ACB se muestra en gran medida incapaz de evaluar intervenciones de desarrollo social en los que predominan los beneficios intangibles (educación, integración y fortalecimiento institucional, entre otros). Requiere además de elevados conocimientos financieros y económicos, lo que deja en manos de los consultores economistas externos a la comunidad que se pretende desarrollar los secretos para su aplicación, no contribuyendo al aprendizaje local.

- La imposición de procedimientos complejos de evaluación puede conducir a la desaparición de las organizaciones pequeñas y a la pérdida de su identidad asociativa, en favor de organizaciones grandes o transnacionales.

- Ambas metodologías poseen un sesgo hacia los resultados, en detrimento de una reflexión cualitativa sobre los procesos. Algunos evaluadores experimentados han cuestionado ese vínculo automático que se suele hacer entre evaluación e impacto, aduciendo que existen criterios alternativos a la hora de evaluar un programa, como es su potencial de replicación, su capacidad innovadora, el nivel de participación local o su contribución al fortalecimiento de la sociedad civil. Algunos de los principales argumentos aducidos para criticar estos enfoques son:

- Las enormes dificultades para aislar los resultados directos de los programas y para ligar los insumos con los outputs motivan que un número considerable de evaluaciones de impacto carezca de valor. En la práctica es más fácil identificar los factores externos que influyen de forma adversa en las intervenciones que precisar todas las conexiones causales.

- La utilización de las evaluaciones de impacto para distribuir los fondos de desarrollo desencadena el abandono de muchas líneas de trabajo como las actividades orientadas a los sectores más pobres, debido al aumento de los costes y las pobres perspectivas de alcanzar sostenibilidad financiera, o las actividades innovadoras, debido a la incertidumbre de sus resultados. También sufren bajo esta visión los proyectos que buscan resultados intangibles.

Esto no implica la descalificación automática del EML o de los procedimientos clásicos de evaluación (ACB, ACE), sino la necesidad de utilizar estos modelos con precaución y con espíritu abierto para facilitar la percepción de los potenciales aspectos cualitativos —muchas veces no esperados— de los programas.

About Carlos Plaza

El Análisis de Coste-Beneficio

Otra metodología aludida con frecuencia, aunque menos empleada en el campo de los programas de desarrollo, es el Análisis Coste-Beneficio (ACB) o, en su defecto, el Análisis Coste-Eficacia (ACE). Métodos de gran utilización a nivel de los proyectos de inversión pero que extienden su influencia al nivel de planes y programas.

El origen de la idea de esta contabilidad económica la podemos encontrar en Jules Dupuit (1844), un ingeniero francés del siglo XIX cuyo artículo de 1844 titulado on the measurement of the utility of public works constituye hoy en día una buena lectura, y en Alfred Marshall (1920), un economista inglés que formuló algunos de los conceptos sobre los que se fundamenta el ACB. Pero el desarrollo práctico del ACB tuvo lugar en norteamérica como resultado del impulso dado por la Federal Navigation Act en 1936 que exigió al cuerpo de ingenieros norteamericano (U.S Corps of Engineers) llevar a cabo proyectos cuyos beneficios fueran mayores que los costes. El cuerpo de ingenieros diseñó así los primeros métodos para la estimación de los costes y los beneficios. Pero no fue hasta veinte años más tarde, en la década de los 50, cuando los economistas comenzaron a proporcionar métodos consistentes de análisis de costes y beneficios (Gittinger, 1987; Adler, 1971; Mishra & Beyer, 1976 entre otros).

De acuerdo con estos métodos, la evaluación se concibe también como la búsqueda de resultados de las intervenciones, pero expresados en términos de rentabilidad económica, a través de un proceso normalizado de estimación de costes y beneficios. El ACB goza de prestigio técnico en el mundo de los consultores y evaluadores del desarrollo, inspirando los modelos de evaluación de proyectos de inversión de algunas agencias multilaterales como el Banco Mundial. Su complejidad técnica ha impedido su expansión a pequeñas organizaciones, si bien figura en la oferta educativa de muchos cursos para la evaluación del desarrollo y gestión de las intervenciones.

La estimación de los efectos económicos de una intervención debe realizarse en unidades que permitan comparar los beneficios con sus costes. Si queremos obtener un resultado absoluto sobre el interés social de un programa, todos los efectos deben estar calculados en unidades homogéneas, lo que permite sumarlos y operar con ellas para determinar el resultado neto de cada alternativa.

El Análisis Coste-Beneficio pretende valorar en unidades monetarias tanto los costes como los beneficios que de alguna manera se derivan de cada programa. Se distingue del Análisis Coste-Eficacia por sus objetivos además de sus instrumentos. El ACE tiene como objetivo proporcionar elementos de decisión para determinar cómo obtener unos objetivos especificados de antemano, y en este caso la identificación de los objetivos es el objetivo prioritario.

En el ACB todos los efectos intangibles relevantes han sido valorados en términos de unidades monetarias, lo que implica que la valoración monetaria ha de ser posible. Muchos estudios, que se limitan a estimar los efectos de cualquier intervención, sobre los costes son trabajos que ni siquiera pueden denominarse parciales, debido a que el objetivo del análisis no se plantea medir los beneficios. Un estudio parcial de ACB sería aquel que, si bien tiene en cuenta los beneficios, no contempla todos los beneficios posibles y susceptibles de valoración.

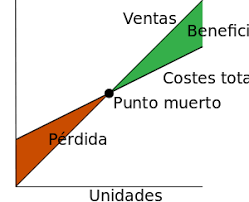

El principio inherente a este análisis es el de excedente económico, es decir, un programa se realizará en tanto los beneficios sociales compensen a los costes sociales. Así, es coherente con los principios económicos de bienestar social y eficiencia.

Los principales pasos del análisis de beneficios y eficacia en función de los costes son la identificación de todos los costes y beneficios del programa y luego calcular una razón coste-eficacia. Al calcular los costes, se debe incluir el valor de la intervención misma, al igual que todos los demás costes, como costes administrativos, de entrega, inversión (actualizados al valor actual neto), el valor monetario de los bienes o servicios proporcionados en forma gratuita, los costes sociales como el deterioro ambiental y los riesgos para la salud. Los beneficios pueden ser monetarios, como el aumento en el ingreso, o bien el número de unidades entregadas, valoraciones de las pruebas o mejoramientos de salud. Cuando no se puedan cuantificar los beneficios, será posible usar indicadores subjetivos, como sistemas de clasificación o ponderación. Sin embargo, este enfoque puede ser complicado para interpretar valoraciones subjetivas.

Una vez determinados los costos y beneficios, la razón eficacia en función de los costes (R) es entonces R = coste/unidad (o beneficio). Esta razón se puede comparar en todas las intervenciones para medir la eficiencia. En teoría, esta técnica es bastante directa. En la práctica, sin embargo, hay muchos riesgos involucrados en la identificación y cuantificación de los costes y beneficios. Es importante asegurar que se seleccionan los indicadores adecuados, que las metodologías y supuestos económicos usados son coherentes en todas las razones y que las razones de hecho son comparables.

En definitiva, el ACB es una técnica de evaluación económica extendida en numerosos campos además del desarrollo, que permite valorar todos los efectos en unidades monetarias, reduciéndolas a un valor actual a través de la aplicación de una tasa de descuento. No obstante, a veces no es fácil distinguir entre lo que son costes y beneficios, especialmente desde el punto de vista social. Por ejemplo, cuando no existe mercado deben buscarse mecanismos alternativos de valoración.

Referencias citadas:

Adler, H.A. (1971). Economic appraisal of transport projects: a manual with case studies. Indiana University Press. Bloomington.

Dupuit, J. (1844). On the Measurement of the Utility of Public Works. Annales des Ponts et Chaussés, 2, 332-75.

Gittinger J.; (1987). Análisis económico de proyectos agrícolas. Banco Mundial. Washington, D.C.

Marshall, A. (1920). Principles of Economics. Macmillan. New York.

Mishra, S.N. & Beyer, J.; 1976. Cost-Benefit Analysis: A Case Study of the Ratnagiri Fisheries Project. Hindustan Publishing Corporation. New Delhi.

About Carlos Plaza

El Enfoque del Marco Lógico

El Enfoque del Marco Lógico (EML) es una herramienta de planificación que fue formalmente adoptada por primera vez por Agencia para el Desarrollo Internacional de Estados Unidos (USAID) para la cooperación al desarrollo a comienzos de los 70. Sus orígenes se pueden situar en las teorías de gestión del sector privado dentro del enfoque de la gestión por objetivos que tuvo gran popularidad en los años 60.

El Enfoque del Marco Lógico (EML) (NORAD, 1993) fue diseñado como técnica para identificar y analizar una situación dada, y definir objetivos y acciones que serán llevadas a cabo para mejorar esa situación. Después de la preparación de un programa o proyecto, el EML vino a constituir en muchas ocasiones una herramienta clave de gestión, seguimiento y evaluación, proporcionando la base para la programación de las actividades y para el desarrollo del sistema de seguimiento y un marco para la evaluación.

Como resultado de la colaboración entre la Unidad de Evaluación del Ministerio Noruego de Asuntos Exteriores y Knut Samset de Scanteam International A.S. salió publicado en 1997 un manual de evaluación basado en el EML (NORAD-UD, 1997), que en aquellos momentos era sin duda el manual más utilizado para el diseño de proyectos de cooperación al desarrollo.

En los últimos años, el enfoque de Marco Lógico (EML) se ha consolidado, no sólo como metodología de planificación y formulación de programas, sino que también inspira los esfuerzos de evaluación de estos programas. Es generalmente adaptado mediante la utilización de matrices de planificación para la evaluación de programas considerándose que éstas aportan rigor a la planificación y a la evaluación.

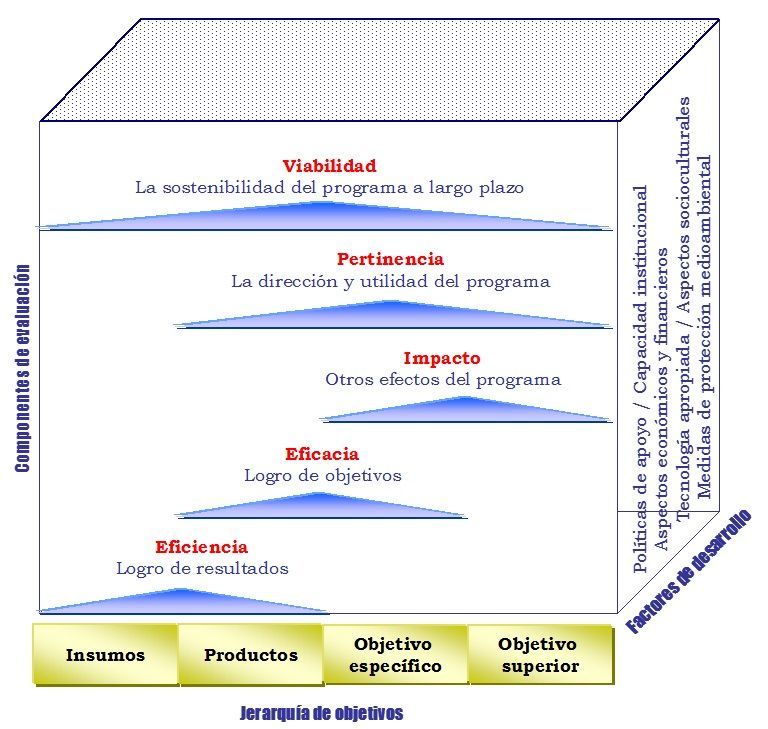

Desde la perspectiva del EML, los programas de desarrollo se articulan en función de una jerarquía de objetivos, de acuerdo a una cadena causa-efecto de cuatro niveles: insumos, resultados, objetivos específicos y objetivo general. La función de la evaluación lógica consiste, por tanto, en un proceso orientado a contrastar resultados con objetivos, lo esperado con lo real.

El principal instrumento de evaluación es la propia matriz de planificación, que traduce los objetivos y resultados esperados en indicadores cuantitativos. El objetivo central del EML es asegurar la gestión eficaz del programa, mediante la revisión periódica del grado de cumplimiento de los indicadores, la revisión del presupuesto, así como la identificación y análisis de problemas como fuente de aprendizaje institucional. El resultado final del proceso continuo de evaluación es una colección de informes de seguimiento, normalizados, homogéneos, tal y como exigen los organismos financiadores. En este sentido, el EML, más que una metodología de evaluación, constituye, en el fondo, un proceso de normalización de los procedimientos de gestión de los programas.

El principal instrumento de evaluación es la propia matriz de planificación, que traduce los objetivos y resultados esperados en indicadores cuantitativos. El objetivo central del EML es asegurar la gestión eficaz del programa, mediante la revisión periódica del grado de cumplimiento de los indicadores, la revisión del presupuesto, así como la identificación y análisis de problemas como fuente de aprendizaje institucional. El resultado final del proceso continuo de evaluación es una colección de informes de seguimiento, normalizados, homogéneos, tal y como exigen los organismos financiadores. En este sentido, el EML, más que una metodología de evaluación, constituye, en el fondo, un proceso de normalización de los procedimientos de gestión de los programas.

La matriz del diseño del EML describe la jerarquía de objetivos y los principales supuestos.

Fuente: Elaboración propia a partir de NORAD, 1993

Como componentes generales de la evaluación se consideran la eficiencia, eficacia, impacto, pertinencia y viabilidad. En conjunto, el modelo pretende proporcionar un marco común tanto para la evaluación, como para el establecimiento de sistemas de información. Se establece según un esquema tridimensional, en el nivel inferior organiza la información sobre el programa en cuestión, tal y como está definida en la jerarquía de objetivos, describe los elementos principales del programa y qué se espera lograr en el corto y largo plazo. Esto es también conocido como el “formato EML”, en el que la jerarquía de objetivos es considerada particularmente importante para la planificación y gestión del programa.

Al ser el propósito de las evaluaciones realizar análisis a un nivel agregado, se concentran sobre unos pocos criterios centrales denominados componentes de la evaluación, que es la segunda dimensión. Se construye directamente sobre los elementos de la jerarquía de objetivos y proporciona conocimiento agregado a un nivel superior, útil para la toma de decisiones.

La tercera dimensión viene definida al existir la necesidad de analizar los factores de desarrollo que afectan a la viabilidad del programa. Objeto de atención por ser considerados como problemáticos o sensibles para el éxito de la intervención. En la figura siguiente queda esquemáticamente desarrollado este proceso:

Modelo de evaluación del EML estructurado en las tres dimensiones: la jerarquía de objetivos, el conjunto de componentes de la evaluación y los factores de desarrollo

Modelo de evaluación del EML estructurado en las tres dimensiones: la jerarquía de objetivos, el conjunto de componentes de la evaluación y los factores de desarrollo

Fuente: Elaboración propia a partir de NORAD, 1993

Las ventajas que permite este modelo de evaluación son:

- Una utilización sistemática del conocimiento sobre el programa en cuestión.

- La agregación de conocimiento, de forma que aquellos que toman las decisiones pueden evitar una información excesivamente detallada.

- Un énfasis sobre seguimiento profesional, de especial importancia para lograr un desarrollo sostenible.

- La utilización de otros enfoques además de la evaluación de objetivos, como la evaluación de procesos.

Referencias citadas:

NORAD (1993). El enfoque del marco lógico (EML). Manual para la planificación de proyectos orientada mediante objetivos. Agencia Noruega de Desarrollo; Instituto Universitario de Desarrollo y Cooperación (IUDC). Universidad Complutense de Madrid-Fundación Centro Español de Estudios de América Latina (CEDEAL). Madrid.

NORAD-UD (1997). Evaluación de proyectos de ayuda al desarrollo. Manual para evaluadores y gestores. Agencia Noruega de Desarrollo-Unidad de Evaluación del Ministerio Noruego de Asuntos Exteriores. Instituto Universitario de Desarrollo y Cooperación (IUDC) – Universidad Complutense de Madrid – Fundación Centro Español de Estudios de América Latina (CEDEAL). Madrid.