Inicio » Entradas etiquetadas como «evaluación de proyectos» (Página 2)

Archivos de la etiqueta: evaluación de proyectos

Limitaciones de modelos de evaluación inspirados en el EML y el ACB

Antes de comenzar con las limitaciones de ambos enfoques es bueno reconocer la enorme aportación histórica del EML y el ACB, como herramientas de planificación han contribuido a articular muchos esfuerzos dispersos de cooperación para el desarrollo. No obstante, su traslado y aplicación en el campo de la evaluación, a pesar de que cuenta con la defensa de numerosos profesionales, ofrece unos resultados mucho más pobres que en el campo de la planificación. Tanto el EML como el ACB, poseen importantes limitaciones, que merece la pena repasar:

Antes de comenzar con las limitaciones de ambos enfoques es bueno reconocer la enorme aportación histórica del EML y el ACB, como herramientas de planificación han contribuido a articular muchos esfuerzos dispersos de cooperación para el desarrollo. No obstante, su traslado y aplicación en el campo de la evaluación, a pesar de que cuenta con la defensa de numerosos profesionales, ofrece unos resultados mucho más pobres que en el campo de la planificación. Tanto el EML como el ACB, poseen importantes limitaciones, que merece la pena repasar:

- El EML adolece de rigidez para inspirar modelos de evaluación, ya que depende de indicadores predeterminados. Lo que da lugar a un modelo poco preparado para el gran grado de incertidumbre que se suele encontrar en el dinámico contexto de las evaluaciones. Supone también un enfoque negativo al estar centrado en el análisis de problemas coartando el posible desarrollo de las capacidades. Además, se trata de una metodología cuyos propios fundamentos y presupuestos impiden y restringen la participación local en las evaluaciones.

- Por su lado, el ACB se muestra en gran medida incapaz de evaluar intervenciones de desarrollo social en los que predominan los beneficios intangibles (educación, integración y fortalecimiento institucional, entre otros). Requiere además de elevados conocimientos financieros y económicos, lo que deja en manos de los consultores economistas externos a la comunidad que se pretende desarrollar los secretos para su aplicación, no contribuyendo al aprendizaje local.

- La imposición de procedimientos complejos de evaluación puede conducir a la desaparición de las organizaciones pequeñas y a la pérdida de su identidad asociativa, en favor de organizaciones grandes o transnacionales.

- Ambas metodologías poseen un sesgo hacia los resultados, en detrimento de una reflexión cualitativa sobre los procesos. Algunos evaluadores experimentados han cuestionado ese vínculo automático que se suele hacer entre evaluación e impacto, aduciendo que existen criterios alternativos a la hora de evaluar un programa, como es su potencial de replicación, su capacidad innovadora, el nivel de participación local o su contribución al fortalecimiento de la sociedad civil. Algunos de los principales argumentos aducidos para criticar estos enfoques son:

- Las enormes dificultades para aislar los resultados directos de los programas y para ligar los insumos con los outputs motivan que un número considerable de evaluaciones de impacto carezca de valor. En la práctica es más fácil identificar los factores externos que influyen de forma adversa en las intervenciones que precisar todas las conexiones causales.

- La utilización de las evaluaciones de impacto para distribuir los fondos de desarrollo desencadena el abandono de muchas líneas de trabajo como las actividades orientadas a los sectores más pobres, debido al aumento de los costes y las pobres perspectivas de alcanzar sostenibilidad financiera, o las actividades innovadoras, debido a la incertidumbre de sus resultados. También sufren bajo esta visión los proyectos que buscan resultados intangibles.

Esto no implica la descalificación automática del EML o de los procedimientos clásicos de evaluación (ACB, ACE), sino la necesidad de utilizar estos modelos con precaución y con espíritu abierto para facilitar la percepción de los potenciales aspectos cualitativos —muchas veces no esperados— de los programas.

About Carlos Plaza

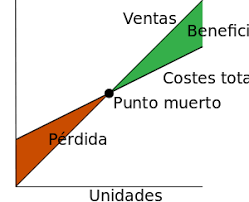

El Análisis de Coste-Beneficio

Otra metodología aludida con frecuencia, aunque menos empleada en el campo de los programas de desarrollo, es el Análisis Coste-Beneficio (ACB) o, en su defecto, el Análisis Coste-Eficacia (ACE). Métodos de gran utilización a nivel de los proyectos de inversión pero que extienden su influencia al nivel de planes y programas.

El origen de la idea de esta contabilidad económica la podemos encontrar en Jules Dupuit (1844), un ingeniero francés del siglo XIX cuyo artículo de 1844 titulado on the measurement of the utility of public works constituye hoy en día una buena lectura, y en Alfred Marshall (1920), un economista inglés que formuló algunos de los conceptos sobre los que se fundamenta el ACB. Pero el desarrollo práctico del ACB tuvo lugar en norteamérica como resultado del impulso dado por la Federal Navigation Act en 1936 que exigió al cuerpo de ingenieros norteamericano (U.S Corps of Engineers) llevar a cabo proyectos cuyos beneficios fueran mayores que los costes. El cuerpo de ingenieros diseñó así los primeros métodos para la estimación de los costes y los beneficios. Pero no fue hasta veinte años más tarde, en la década de los 50, cuando los economistas comenzaron a proporcionar métodos consistentes de análisis de costes y beneficios (Gittinger, 1987; Adler, 1971; Mishra & Beyer, 1976 entre otros).

De acuerdo con estos métodos, la evaluación se concibe también como la búsqueda de resultados de las intervenciones, pero expresados en términos de rentabilidad económica, a través de un proceso normalizado de estimación de costes y beneficios. El ACB goza de prestigio técnico en el mundo de los consultores y evaluadores del desarrollo, inspirando los modelos de evaluación de proyectos de inversión de algunas agencias multilaterales como el Banco Mundial. Su complejidad técnica ha impedido su expansión a pequeñas organizaciones, si bien figura en la oferta educativa de muchos cursos para la evaluación del desarrollo y gestión de las intervenciones.

La estimación de los efectos económicos de una intervención debe realizarse en unidades que permitan comparar los beneficios con sus costes. Si queremos obtener un resultado absoluto sobre el interés social de un programa, todos los efectos deben estar calculados en unidades homogéneas, lo que permite sumarlos y operar con ellas para determinar el resultado neto de cada alternativa.

El Análisis Coste-Beneficio pretende valorar en unidades monetarias tanto los costes como los beneficios que de alguna manera se derivan de cada programa. Se distingue del Análisis Coste-Eficacia por sus objetivos además de sus instrumentos. El ACE tiene como objetivo proporcionar elementos de decisión para determinar cómo obtener unos objetivos especificados de antemano, y en este caso la identificación de los objetivos es el objetivo prioritario.

En el ACB todos los efectos intangibles relevantes han sido valorados en términos de unidades monetarias, lo que implica que la valoración monetaria ha de ser posible. Muchos estudios, que se limitan a estimar los efectos de cualquier intervención, sobre los costes son trabajos que ni siquiera pueden denominarse parciales, debido a que el objetivo del análisis no se plantea medir los beneficios. Un estudio parcial de ACB sería aquel que, si bien tiene en cuenta los beneficios, no contempla todos los beneficios posibles y susceptibles de valoración.

El principio inherente a este análisis es el de excedente económico, es decir, un programa se realizará en tanto los beneficios sociales compensen a los costes sociales. Así, es coherente con los principios económicos de bienestar social y eficiencia.

Los principales pasos del análisis de beneficios y eficacia en función de los costes son la identificación de todos los costes y beneficios del programa y luego calcular una razón coste-eficacia. Al calcular los costes, se debe incluir el valor de la intervención misma, al igual que todos los demás costes, como costes administrativos, de entrega, inversión (actualizados al valor actual neto), el valor monetario de los bienes o servicios proporcionados en forma gratuita, los costes sociales como el deterioro ambiental y los riesgos para la salud. Los beneficios pueden ser monetarios, como el aumento en el ingreso, o bien el número de unidades entregadas, valoraciones de las pruebas o mejoramientos de salud. Cuando no se puedan cuantificar los beneficios, será posible usar indicadores subjetivos, como sistemas de clasificación o ponderación. Sin embargo, este enfoque puede ser complicado para interpretar valoraciones subjetivas.

Una vez determinados los costos y beneficios, la razón eficacia en función de los costes (R) es entonces R = coste/unidad (o beneficio). Esta razón se puede comparar en todas las intervenciones para medir la eficiencia. En teoría, esta técnica es bastante directa. En la práctica, sin embargo, hay muchos riesgos involucrados en la identificación y cuantificación de los costes y beneficios. Es importante asegurar que se seleccionan los indicadores adecuados, que las metodologías y supuestos económicos usados son coherentes en todas las razones y que las razones de hecho son comparables.

En definitiva, el ACB es una técnica de evaluación económica extendida en numerosos campos además del desarrollo, que permite valorar todos los efectos en unidades monetarias, reduciéndolas a un valor actual a través de la aplicación de una tasa de descuento. No obstante, a veces no es fácil distinguir entre lo que son costes y beneficios, especialmente desde el punto de vista social. Por ejemplo, cuando no existe mercado deben buscarse mecanismos alternativos de valoración.

Referencias citadas:

Adler, H.A. (1971). Economic appraisal of transport projects: a manual with case studies. Indiana University Press. Bloomington.

Dupuit, J. (1844). On the Measurement of the Utility of Public Works. Annales des Ponts et Chaussés, 2, 332-75.

Gittinger J.; (1987). Análisis económico de proyectos agrícolas. Banco Mundial. Washington, D.C.

Marshall, A. (1920). Principles of Economics. Macmillan. New York.

Mishra, S.N. & Beyer, J.; 1976. Cost-Benefit Analysis: A Case Study of the Ratnagiri Fisheries Project. Hindustan Publishing Corporation. New Delhi.

About Carlos Plaza

Enfoques y Modelos Metodológicos

Uno de los aspectos más importantes al emprender una actividad de evaluación es la de definir un modelo metodológico adecuado. En el ámbito de las evaluaciones de programas de desarrollo han dominado los enfoques metodológicos inspirados en el Enfoque de Marco Lógico (EML) y el Análisis Coste Beneficio (ACB), orientados a los resultados y a la rendición de cuentas. Este predominio parece estar relacionado con la satisfacción de los intereses de las instituciones financiadoras y el reparto de roles establecidos entre los diferentes actores. Son los organismos de control los que han venido exigiendo la utilización del EML en los procesos de solicitud de subvenciones públicas, a través de formularios cada vez más estandarizados. El EML, en tanto que proceso normalizado de gestión, encaja muy bien con los propios intereses del cuerpo funcionarial de los organismos financiadores, preocupado por el control de los fondos públicos. Por otro lado, estos organismos han ido reiterando las exigencias de realizar Análisis Coste Beneficio (ACB) de las intervenciones, lo que también tiene que ver con sus intereses: comparar los resultados de diferentes intervenciones y asesorar la toma futura de decisiones de financiación.

Ante las limitaciones de estos enfoques surgieron en los años 90 con fuerza, desde diferentes organizaciones y grupos de trabajo, numerosas propuestas metodológicas de evaluación participativa, que parten de la necesidad de superar las relaciones verticales de la cadena y construir visiones compartidas. La dificultad estriba muchas veces en la identificación de herramientas que permitan una buena participación entre el equipo de expertos y los beneficiarios del desarrollo.

La mayor y mejor participación de las partes involucradas es uno de los mayores avances en los procesos de evaluación, y ha dado lugar enfoques de evaluación donde cobra importancia el aprendizaje y capacitación de todos los participantes. En otros tiempos, la evaluación era el trabajo de un grupo de especialistas. Un trabajo sin mayor interacción —o con muchas dificultades de aceptación— por su entorno institucional, político o social. En la actualidad, las evaluaciones tienden a constituirse como actividades integradas al trabajo cotidiano de los gestores y agentes de campo.

About Carlos Plaza

Dificultades a la hora de abordar una evaluación

La experiencia de estos últimos años nos que lleva a destacar muchos de los aspectos positivos por los que atraviesan las actividades de evaluación: los avances logrados en el uso de los procesos y resultados, los beneficios del actual intercambio general de lecciones extraídas y técnicas innovadoras, la mayor y mejor participación de las partes involucradas y la evolución positiva de la evaluación que, saliendo del ámbito técnico, se ha convertido hoy en día en un instrumento de apoyo y mejora de la toma de decisiones.

Sin embargo, las actividades de evaluación siguen encontrando numerosas dificultades. Unas son fruto de concepciones erróneas o modos de hacer equivocados, y otras suponen obstáculos objetivos que ponen de manifiesto que las tareas de evaluación no son siempre de fácil ejecución. Las primeras tienen una solución conceptual y teórica a través del diseño de modelos y herramientas apropiados, las segundas se han de afrontar con experiencia y estudios detallados.

Las dificultades derivadas de la mala programación de las intervenciones como la falta de precisión, coherencia y adaptación al programa, tienen como resultado una evaluación poco concreta y con poca capacidad real para la mejora de los programas de desarrollo.

Las dificultades derivadas de la mala programación del seguimiento y evaluación como la falta de definición y concepciones erróneas, ponen de manifiesto la necesidad de un mayor consenso en la obtención de dispositivos adecuados para el seguimiento y evaluación de los programas.

Las dificultades en la ejecución de las actividades de evaluación son especialmente acuciantes cuando no se cuenta con unas buenas orientaciones para llevarlas a cabo. Algunas de estas dificultades están relacionadas con la medición del impacto, pues la excesiva aplicación del método científico a la evaluación ha dejado herencias como el criterio de causalidad. Este criterio no tiene muchas veces buena aplicación en la evaluación de los programas porque demanda rigurosos criterios científicos. A menudo las pruebas necesarias para demostrar la causalidad no pueden ser conseguidas en el mundo real. En su lugar debe aplicarse un criterio de racionalidad, buscando posibles causas basadas en la comprensión de los datos conseguidos.

Otras dificultades en la ejecución están relacionadas con la elección del sistema de indicadores, donde muchas veces los problemas se encuentran a la hora de disponer de información homogénea y construir un sistema de indicadores integral cuando existen diversos gestores que suministran información al sistema de seguimiento y evaluación. Se han identificado también otras dificultades de ejecución como:

- La definición inadecuada del contenido de evaluación.

- La elección poco apropiada del momento de evaluación.

- La elección desacertada del nivel de análisis inicial.

- La excesiva rigidez de algunos modelos de evaluación.

- El reduccionismo economicista.

- La excesiva valoración de la objetividad.

- La contratación inadecuada de las evaluaciones.

- El bajo nivel de desarrollo de las estadísticas.

- La medición de la eficacia cuando se encuentran objetivos excesivamente genéricos.

Por último se han identificado dificultades que obstaculizan el proceso de aprendizaje y su papel dentro del proceso de toma de decisiones. Estas dificultades pueden ser:

- Indirectas: Los retrasos y la escasa calidad de los informes, el desfase entre el ciclo de programación y el ciclo de evaluación, y la falta de análisis a nivel macroeconómico o por el contrario en el ámbito de subprogramas, medidas y proyectos.

- Directas: Escasa utilización de los resultados generados por la evaluación para la reformulación de las intervenciones o la ausencia, muchas veces detectada, de mecanismos para el aprendizaje y la retroalimentación.

About Carlos Plaza

Complementación de fuentes de información

En las actividades de evaluación se suele poner de relieve la necesidad de combinar distintas fuentes de información para asegurar la solidez de los trabajos. Es conveniente utilizar todos los instrumentos de recolección de información que estén a nuestro alcance, teniendo en cuenta que algunos de estos instrumentos ─en especial los utilizados en la participación social─ introducen opiniones subjetivas. Se puede así comparar distintos puntos de vista, complementar distintas fuentes de información y analizar la validez de los argumentos que sostengan las opiniones encontradas.

Fuentes de información

Es necesaria la utilización de fuentes complementarias de información: una primaria (generados y recogidos ex profeso para la evaluación) y otra secundaria (datos ya disponibles), una cuantitativa (información claramente cuantificable) y otra cualitativa (información de difícil cuantificación).

Los trabajos de evaluación suelen comenzar con una descripción clara de lo que se pretende realizar y una revisión detallada de la documentación disponible: literatura relevante, evaluaciones previas, documentos de programación, informes de seguimiento y control, datos estadísticos y bases de datos existentes, etc. En la medida de lo posible, es importante acudir al origen de estas fuentes de información ya existentes (información secundaria), de manera que se eviten intermediarios, incorrecciones o malas interpretaciones.

Gran parte de la información cualitativa resulta de la activación de procesos de participación (a través encuestas, entrevistas, discusiones, talleres…) para aprovechar las aportaciones de la población afectada. Se trata de una información primaria fundamental para comprender la realidad evaluada, completar datos secundarios insuficientes, e interpretar y matizar los datos obtenidos de otro tipo de informaciones. Otro tipo de información primaria es la observación directa de uno o unos pocos casos seleccionados (puede hacerse participativa o no) a través de observaciones cualitativas y mediciones directas que registran datos cuantificables por medio de instrumentos analíticos.

Trabajo de gabinete y trabajo de campo

Según Thirion (2000) el número, la diversidad y la representatividad de las personas que participan en la evaluación, por una parte, y el nivel de profundización del análisis, por otra parte, son los dos principales factores de fiabilidad de los resultados obtenidos. Dentro del primer factor toma especial protagonismo la participación del trabajo de campo y dentro del segundo el trabajo de gabinete.

La experiencia indica que estos dos factores no son siempre compatibles, ya que es en general difícil movilizar a un gran número de personas durante un plazo suficientemente amplio para realizar un análisis profundo. Esta es la razón por la que son posibles tres tipos de vías para obtener una mejor fiabilidad de los resultados. Estos tres tipos de vías están representados en el gráfico siguiente donde las curvas de nivel de fiabilidad van del 1 (nivel muy bajo) a 8 (nivel muy elevado). Como se ve, son posibles distintas vías para la búsqueda de mayor fiabilidad de los resultados.

Distintas vías posibles para la búsqueda de mayor fiabilidad de los resultados.

Distintas vías posibles para la búsqueda de mayor fiabilidad de los resultados.

Fuente: Elaboración propia a partir de Thirion, 2000

Vía A: Un primer trabajo es realizado por un pequeño grupo de técnicos y expertos que basan su valoración personal en un trabajo minucioso y en la búsqueda de indicadores pertinentes, antes de pasar a la participación ampliada a otros agentes, a quienes proporcionan las informaciones que recogieron pero sin aportar su valoración personal.

Vía B: Inicialmente se hace una valoración individual en la que interviene un gran número de participantes representativos de los distintos sectores de la sociedad local, pero sin utilización de indicadores (valoración global rápida); luego, en una segunda fase, la valoración media obtenida se compara con el trabajo de análisis más profundo y con la búsqueda de indicadores.

Vía C: Sería la vía ideal donde el trabajo de gabinete y la participación interaccionan de continuo en todo el proceso evaluación. Esto en la realidad es difícil pues no se puede estar movilizando de continuo a un gran número de personas. Es por ello que la mayor aproximación a esta vía está en buscar que la propia población local aprenda a evaluar por sí misma los programas con un modelo de evaluación que facilite la adquisición de estas capacidades.

En cualquier caso es necesaria la obtención y análisis de la información secundaria a través de un trabajo de gabinete inicial. Primeramente se consultan estos datos que ya están disponibles para luego ir en busca de los datos primarios que hagan falta durante el trabajo de campo (participación social, observaciones y mediciones directas). Una vez obtenidos, estos datos del trabajo de campo sirven para completar, verificar, interpretar, resolver posibles conflictos y contrastar las conclusiones que se obtuviesen del análisis de los datos secundarios durante el trabajo de gabinete inicial.

Complementación de fuentes de información

Complementación de fuentes de información

Esta complementación de fuentes de información ─que normalmente se realiza en un trabajo de gabinete final─ permite integrar los conocimientos analizados y evaluar cuantitativamente la aplicación y resultados de los programas de desarrollo, a la vez que permite un enfoque más cualitativo de los factores específicos que los caracterizan y suponen muchas veces su mayor beneficio. También suministra diferentes opciones de información que no obliguen a forzar la causalidad, al tiempo que permite disponer de indicadores que ilustren suficientemente las variables a considerar.

No se puede excluir un objetivo de su campo de análisis sólo porque sea difícil de medir cuantitativamente y definir para él un indicador cuantitativo. Cuando los trabajos de evaluación tropiezan con un objetivo difícil o incluso imposible de cuantificar, se puede proponer un tratamiento cualitativo. La información cualitativa bien estructurada puede resultar muy útil y es claramente preferible a una ausencia de información.

La información del seguimiento como base de la evaluación

La recopilación de datos debe hacerse teniendo en cuenta los análisis que puedan hacerse posteriormente y vuelvan a necesitar de ellos. La evaluación debe dotarse de medios apropiados y completar los resultados del seguimiento, cuando sea necesario, con una recopilación de información adicional. De esta forma, conseguimos que la evaluación sea parte de un seguimiento continuo que tiene lugar a través de los proyectos.

Los trabajos de evaluación han de hacer un uso óptimo de los denominados datos secundarios ya disponibles, como los obtenidos a través del sistema de seguimiento. A veces, resultan suficientes para responder a aspectos específicos de evaluación o una parte de ellos. Al tratarse de datos ya disponibles pueden recopilarse a un coste moderado y facilitan mucho los trabajos de evaluación. Por ello, es importante disponer de un buen sistema de seguimiento.

Estos datos se hacen especialmente importantes en las evaluaciones intermedias, donde suelen aportar información financiera (medios) e información sobre las realizaciones. Una información que complementa a la obtenida de las evaluaciones anteriores y los documentos de programación, que aportan datos sobre la lógica de intervención, coherencia y pertinencia de la programación diseñada.

Referencias citadas:

Thirion, S. (2000). El método SAP en Portugal (Sistematización de la Autoevaluación Participativa). I.N.D.E. Lisboa. Descargado de internet el 27 de julio de 2015 en http://ec.europa.eu/agriculture/rur/leader2/forum/docs_evaluation/thirion_es.pdf

About Carlos Plaza

Recursos para la evaluación: Bueno, bonito, barato. ¡Escoge dos!

Bueno, Bonito, Barato: ¡Escoge dos! Este conocido dicho, proveniente de la industria de restauración, nos recuerda que en la sociedad actual se demanda que los productos ─en nuestro caso las evaluaciones─ sean:

- Buenos (aumentar la calidad de las evaluaciones lo máximo posible)

- Rápidos (disminuir el tiempo de evaluación lo máximo posible)

- Baratos (disminuir el presupuesto de evaluación lo máximo posible)

Pero es imposible maximizar los tres criterios a la vez, por lo que hemos de conformarnos con un equilibrio cuyas reglas se reflejan a continuación.

↑ Calidad → ↑Tiempo ↑ Presupuesto

↓ Presupuesto → ↓Calidad ↑ Tiempo

↓ Tiempo → ↓Calidad → Presupuesto

Para aumentar la calidad suele ser necesario aumentar los recursos invertidos (tiempo y presupuesto), pero para disminuir el presupuesto o el tiempo puede ser necesario disminuir la calidad. Es importante estudiar y negociar la mejor opción a la hora de establecer los términos de referencia.

Conseguir un buen balance entre el bueno-bonito-barato en evaluaciones que presentan escasos recursos económicos requiere en ocasiones trabajar de modo colaborativo con el personal implicado en la gestión del programa, de modo que el programa pueda permitirse una buena evaluación que sea sostenible internamente a lo largo del tiempo. Se trata de hacer un uso adecuado del proceso de evaluación sin que ello derive en una falta de independencia u objetividad a la hora de hacer la evaluación. Un uso del proceso de evaluación que derive en la creación de capacidades de evaluación entre el personal que gestiona el programa y con el que trabajamos a la hora de hacer la evaluación. Esa creación de capacidades puede llevar a una gran ayuda a la hora de sacar adenlante una evaluación de calidad y que no emplee excesivos recursos de dinero y tiempo.

About Carlos Plaza

Preguntas clave que ayuden a definir los contenidos de evaluación

El primer paso para definir los contenidos de una evaluación está en decidir el nivel de análisis inicial entre local, regional, nacional… Una vez delimitado este nivel, conviene formular un conjunto de preguntas clave que dejen claro el propósito de la evaluación que se emprende. Se trata de establecer qué puedo evaluar para luego determinar qué quiero evaluar. En un modelo de evaluación basado en un conjunto de preguntas, es fundamental contar con una buena metodología de respuesta que permita tratar adecuadamente las cuestiones planteadas y sacar todo el provecho posible de cada una de ellas.

Se han de establecer para cada pregunta un conjunto de criterios e indicadores en perfecta adaptación con el programa, que permitan recopilar de forma coherente la información obtenida y evaluar los resultados conseguidos. También facilitan la agregación y comparación de los resultados. Se ha de intentar, en la medida de lo posible, aportar respuestas cuantitativas a las preguntas de evaluación, usando los indicadores apropiados. En cualquier caso siempre se proporcionará una respuesta cualitativa bien justificada. Unos posibles pasos a seguir para el tratamiento de cada pregunta se señalan a continuación.

Finalidad y comprensión de la pregunta

Explicación de la pregunta haciendo una pequeña descripción de lo que se estudiará en ella. Es un punto donde se matiza, dentro de la amplitud de cada pregunta, lo que se va a estudiar en concreto y los aspectos en que se hará más hincapié. También se centra la aportación de la respuesta en el contexto global de la evaluación dando razón de su importancia.

Criterio para la evaluación

En este punto se especifican criterios que ayuden a formular un juicio de valor sobre el éxito de los objetivos planteados a la vista de los resultados arrojados por los indicadores y demás información obtenida. Se trata de constatar los aspectos en los que nos vamos a fijar y el grado de exigencia con el que vamos a medirlos, para dar una respuesta a la pregunta.

El criterio sirve para evaluar el éxito, al poner en relación el indicador con el resultado o impacto previsto. Dentro del criterio podemos distinguir lo que propiamente se llama criterio (aumento, disminución…) y el llamado nivel de objetivo, esto es, el nivel que ha de alcanzarse para satisfacer el criterio y concluir que la ayuda ha tenido éxito. Habitualmente, ese nivel se corresponderá con un objetivo cuantificado. Ante la escasa cuantificación de los objetivos programados, en muchas ocasiones es necesario acudir a un nivel de objetivo expresado en forma más bien genérica dando una línea de base con un punto de referencia. En estos casos, el equipo evaluador, cuando se vea conveniente y atendiendo a las características del programa o a las circunstancias locales, delimitará el objetivo con la mayor precisión posible.

Análisis para la respuesta

Se realiza aquí el análisis de toda la información obtenida para buscar que la respuesta a la pregunta planteada sea lo más precisa posible. Son varias las tareas a realizar dependiendo de cada caso, pero tras la recopilación y análisis de los datos y la posible necesidad de tener que reconstruir la situación de referencia será necesario tratar de definir algunos indicadores que permitan extraer algunas conclusiones para responder a la pregunta.

La recopilación de datos ha de tener en cuenta el posterior análisis, a través de medios apropiados y completando los resultados del seguimiento con la recopilación de información adicional. Una vez recopilados los datos, se ha de efectuar la evaluación, analizándolos y determinando los efectos del programa concernientes a la pregunta que se esté respondiendo.

El análisis de los datos se ha de realizar de modo que sea posible efectuar comparaciones y llegar a conclusiones, de tal manera que la evaluación sirva para determinar si los efectos que el programa ha producido son suficientes frente a los objetivos marcados. Se trata de analizar así la situación de referencia o hipotética, es decir, qué hubiese sucedido sin la intervención, definiéndose habitualmente como “la situación sin programa”. No se trata por tanto de la situación inicial sino de la situación que viviría el sector si el programa no hubiera existido.

Es importante concluir el análisis con la búsqueda de indicadores que ofrezcan la información cuantitativa que mejor recoja el análisis de la información realizado y mejor prepare la respuesta a la pregunta. Como norma general, elegir indicadores que puedan medir los progresos de la consecución de los objetivos del programa, y no perderse en interminables baterías de indicadores, sino que hay que centrarse en los indicadores más significativos y pertinentes.

Respuesta: Conclusiones y recomendaciones

Basándose en toda la información recogida y analizada, tanto cuantitativa como cualitativa, se ha de dar una respuesta concisa fundamentada en los apartados anteriores. Como la evaluación es considerada esencialmente un análisis de lo que se ha hecho, estas respuestas deben permitir saber cómo ocurrieron las cosas y por qué.

Por otro lado se considera que la evaluación ha de estudiar especialmente los impactos logrados tanto a corto como a largo plazo, deteniéndose en los aspectos sociales, culturales, medioambientales… según corresponda a la pregunta en cuestión. Además se han de tratar aspectos como la utilidad y sostenibilidad de los impactos conseguidos, para sacar finalmente unas conclusiones y recomendaciones.

Limitaciones de la respuesta

Se indican aquí las posibles limitaciones de la respuesta dada en el apartado anterior, de manera que ésta se pueda valorar adecuadamente. Como limitaciones se pueden entender informaciones que hubieran sido valiosas pero no pudieron conseguirse, la relativa fiabilidad de algunos datos, la imposibilidad de resolver determinadas situaciones, la poca colaboración obtenida, la mala programación realizada con anterioridad… y en definitiva todo lo que constituya un obstáculo a la buena realización de la evaluación.

About Carlos Plaza

La importancia de incluir una estrategia de comunicación en el plan temporal

Finalmente, un plan de evaluación suele tener entre los productos finales un informe de evaluación, cuyo esquema de redacción suele incluir un resumen, una introducción, una descripción del enfoque metodológico, una presentación y análisis de la información recopilada, conclusiones (y recomendaciones), y los anexos que se consideren necesarios. Pero de cara a la utilidad de la evaluación y asegurar que sus resultados se usen es importante diseñar una estrategia para la diseminación y comunicación de resultados que quede incluida en el plan temporal de la evaluación. Este diseño ha de responder principalmente a cuatro preguntas:

- ¿Quién?: Se trata de tener claro a quién va dirigida la estrategia de comunicación, quiénes son los potenciales usuarios de la evaluación. Hablamos aquí de una posible audiencia primaria, secundaria, interna o externa al programa…

- ¿Qué?: Es importante saber qué es lo que se quiere diseminar y comunicar, qué contenidos, qué le importa a nuestra potencial audiencia definida en el punto anterior, qué tipo de información fácil de entender satisface sus necesidades y les puede ayudar a mejorar.

- ¿Cuándo?: Un elemento importante de esa estrategia es definir cuándo se va a comunicar información procedente de la evaluación. Puede ser cada cierto periodo acordado desde el principio, cuando la audiencia potencial lo requiera o cuando se vea que más interesa.

- ¿Cómo?: Se trata de definir el formato en función de la audiencia. En la mayoría de los casos se suelen tener distintos tipos de audiencia, donde los distintos implicados ven la información de forma diferente y con interés diferente. Es por ello importante diseñar diferentes productos de comunicación para cada tipo de audiencia. Entre estos productos podemos tener informes de evaluación (con toda la información), resúmenes ejecutivos (con la información más relevante), artículos en prensa local o boletines, informes de diapositivas, presentaciones orales, discusiones personales, formatos electrónicos (noticias, foros, pdfs interactivos, vídeos colgados en la red…), exhibición de fotos o posters, pequeñas representaciones teatrales…

Se trata en definitiva de asegurar un uso apropiado de la evaluación y ayudar a crear futuros escenarios que se mejores a través de la información, conclusiones y recomendaciones generadas con la evaluación.

About Carlos Plaza

Diseño del plan temporal de evaluación en cada una de sus etapas

El plan temporal de una evaluación sirve para guiar posteriormente las actividades de evaluación. Sin necesidad de emplear mucho tiempo en su diseño sirve para propósitos de gran importancia:

- En primer lugar, provee de un enfoque coherente para llevar a cabo la evaluación y hacer uso de los resultados. Ayuda a que los recursos se empleen adecuadamente y los resultados de evaluación sean usados para su intención original.

- Guía las actividades de evaluación al explicitar sus objetivos, cuándo han de realizarse, cómo, y asignando responsables de llevarlas a buen fin.

- Ayuda a la transparencia de la evaluación al documentar el proceso de evaluación para todas las partes implicadas.

- Asegura la fidelidad a la implementación de la evaluación al explicitar con claridad el proceso de evaluación en sus diferentes actividades.

En definitiva, al crear un plan de evaluación se facilita que los recursos no se malgasten a la hora de llevar a cabo la evaluación y se produzcan resultados que ayuden a la mejora de los programas.

Todo plan de evaluación ha de recorrer varias etapas con diferentes actividades cada una. Michael Scriven en 1980 dio el primer paso hacia la conceptualización de estas etapas a través del análisis de un gran número de evaluaciones de programas. Estas etapas principales por las que discurre una evaluación son:

- Estructurar como se desarrollarán los trabajos de evaluación.

- Observar los datos disponibles y los cambios que se producen en el programa acorde a la estructuración de la evaluación realizada anteriormente.

- Analizar los datos recogidos.

- Emitir un juicio sobre el programa evaluado.

En la figura se representan las cuatro etapas junto con los pasos que implica cada una de ellas.

Etapas principales del proceso de evaluación.

Fuente: Elaboración propia a partir de Scriven (1980)

El gráfico de diamante que aparece en la parte derecha de la figura es obra de Michael Scriven, y refleja como desde la etapa de estructuración hasta la de observación la información se va “acumulando”; se parte de la definición de lo que se va a medir con la evaluación para llegar a una gran cantidad de información recopilada sobre aquello que se va a medir en el programa, ya dentro de la etapa de observación. Tras ello, la cantidad de información vuelve a disminuir al sintetizarse en unos juicios sobre el mérito, valor e importancia del programa evaluado.

A continuación se detallan los contenidos de cada una de las etapas:

Estructurar

La primera etapa, aunque es previa al propio ejercicio de evaluación, se incluye dentro de las fases de una evaluación. Es importante planificar cualquier acción que se lleve a cabo y todo lo referente a esta planificación y estructuración constituye la primera tarea a realizar. En esta fase es necesario:

- Analizar cuáles son los agentes implicados en la evaluación, conectar con ellos, involucrarlos y asegurar su participación a lo largo de la evaluación. Para ello es importante considerar sus necesidades en el diseño de la evaluación.

- Describir el programa, las necesidades que venía a cubrir, objetivos y expectativas, actividades realizadas, recursos implementados, contexto actual y principales influencias que lo afectan…

- Diseñar la evaluación a través de dos pasos esenciales: (1) Análisis y clasificación de los efectos a evaluar definiendo criterios y estándares; y (2) elección de los instrumentos de observación.

Observar

La siguiente etapa ―observar― comprende los siguientes dos pasos:

- Definición del campo de observación: Consiste en definir un campo de observación suficientemente limitado como para que la extracción de datos no genere costes excesivos, y suficientemente grande como para producir información fiable, contrastada y suficiente como para poder medir los efectos del programa que serán evaluados. Por tanto, es una decisión que condicionará la evaluabilidad del programa.

- Recopilación de datos: Consiste en la recopilación de datos primarios a través de las diversas herramientas diseñadas para esta función. Este paso resulta esencial si la evaluación no puede basarse exclusivamente en datos secundarios (que son fundamentalmente aquellos generados por la evaluación previa o por otros documentos y los datos estadísticos existentes). Las herramientas que se aplican en este paso permiten la recolección de hechos y opiniones y la reconstrucción de lo sucedido de una forma cualitativa o cuantitativa.

Es importante obtener datos que permitan dar evidencias que permitan gozar a la evaluación de una buena credibilidad cuando el evaluador tenga que elaborar sus juicios de valor.

Analizar

La tercera etapa comprende los siguientes dos pasos:

- Comparación de datos: Consiste en la presentación de los datos primarios y/o secundarios de tal manera que se puedan extraer conclusiones.

- Estimación de los efectos: Estimar los efectos del programa requiere un análisis de la causalidad que casi siempre sigue un enfoque deductivo, es decir, un enfoque basado en la verificación de las hipótesis de causa y efecto. La bibliografía científica sobre evaluación propone mayoritariamente herramientas de tipo cuantitativo para realizar este análisis.

Juzgar

La última etapa comprende los siguientes dos pasos:

- Análisis en los términos de los diferentes criterios: La evaluación debe ser capaz de juzgar si los resultados obtenidos del programa son suficientes o insuficientes. Hay varias herramientas que pueden ser utilizadas en la etapa de análisis, las más relevantes en la evaluación de programas socioeconómicos son los análisis coste-eficacia y la evaluación comparativa.

- Formulación de un análisis sintético: El octavo y último paso en una evaluación consistirá en la formulación de las conclusiones a partir de la síntesis final de los análisis parciales sobre diferentes criterios. Queda a elección del usuario de la evaluación y el equipo evaluador la necesidad o no de que el equipo emita recomendaciones en base a los resultados del proceso de evaluación.

En la actualidad se discute si los evaluadores deben dar recomendaciones a la luz del juicio del programa. Muchos autores sostienen que la labor de la evaluación acaba al proporcionar un juicio —con la máxima objetividad posible— sobre el programa. Este juicio debe estar argumentado sobre un proceso con la suficiente claridad como para permitir a los gestores del programa emprender las acciones correctoras necesarias para la mejora del mismo. Bajo esta concepción de la evaluación, el análisis de las posibles medidas correctoras del programa es competencia exclusiva de los gestores del mismo. Otros autores sostienen, en cambio, que el evaluador, al cabo del proceso de evaluación posee suficientes argumentos y conocimiento del programa como para emitir una serie de recomendaciones que permitan a los gestores reorientar el programa en caso de que sea necesario.

Es importante asegurar el uso de los resultados de evaluación, para lo que consideramos que es importante incluir una última etapa dentro del plan temporal: el diseño de una estrategia de diseminación y comunicación de resultados que permita compartir los resultados obtenidos.

Referencias citadas:

Scriven, M. (1980). The Logic of Evaluation. Inverness CA: Edgepress.

About Carlos Plaza

Conceptos y definiciones relacionados con el diseño de una evaluación

Los evaluadores y equipos de evaluación suelen utilizar varios términos para describir sus instrumentos o modos de proceder: técnicas, herramientas, procedimientos, métodos, diseños… En este proyecto docente se adoptan una serie de definiciones para poder desarrollar con claridad este tema. Tres son los términos considerados básicos a definir: herramienta, método y metodología.

Herramienta (Tool, Outil)

Procedimiento estándar utilizado para cumplir una función de la evaluación. El término herramienta se emplea en el caso de aplicación de un tratamiento estándar que puede ser aplicado a cualquier evaluación que requiera dicho tratamiento. Es el caso de los cuestionarios de las encuestas para recoger opiniones o los análisis de coste-eficacia para calcular los fondos públicos empleados en la obtención de un determinado efecto. El término de técnica (technique, technique) es considerado un sinónimo.

Las herramientas de evaluación sirven para recoger datos cuantitativos o cualitativos, sintetizar criterios de juicio, explicar objetivos, estimar impactos, etc. Una herramienta tiene un nombre específico, está descrito en un manual, y puede enseñarse. Su uso puede ser libre, o puede implicar el pago de una tasa si la herramienta está protegida por una marca registrada. La evaluación puede utilizar una o más herramientas.

Método (Method, Méthode)

Plan completo del trabajo del equipo de evaluación. Un método es un procedimiento ad hoc, construido especialmente en un contexto determinado para contestar una o más preguntas de evaluación. Algunos métodos de evaluación son de baja complejidad técnica, mientras que otros conllevan el uso de varias herramientas encadenadas en un diseño predeterminado. Esta definición convierte el término método en sinónimo de diseño (design), modelo (model), procedimiento (procedure)… de manera que se refieren a un determinado método y al espíritu en el cual este método ha sido creado.

El método diseñado para llevar a cabo una determinada evaluación puede siempre dividirse en varios pasos. Cada uno de estos pasos consiste en una tarea y da cumplimiento a una función elemental. En la mayoría de las evaluaciones podemos encontrar las mismas funciones elementales.

Metodología (Methodology, Méthodologie)

En el sentido estricto, es la ciencia de la construcción de métodos de evaluación. Sin embargo, el diseño técnico de una evaluación es más una cuestión de conocimientos y experiencia especializados que un procedimiento puramente científico. En la práctica, el término metodología se emplea a menudo para significar método, definido anteriormente.

Diseño de evaluación (Evaluation design, Protocole d’evaluation)

Plan completo del trabajo del equipo de evaluación. A veces se utiliza para referirse a la parte técnica del plan de evaluación. Se trata de los parámetros que definen una evaluación y cómo esta se va a realizar, incluyendo: plan temporal (etapas), los temas críticos a tratar (contenidos), recursos (presupuesto, personal), metodología general, y herramientas.

Protocolo de evaluación (Evaluation design, Protocole d’evaluation)

Parte técnica del plan de evaluación, diseñada para la colección y análisis de datos.

Sesgo (Slanting, Tendance)

El grado hasta el cual un intento de medición o un método subestima o sobreestima sistemáticamente un valor.