Inicio » Artículos publicados por Antonio Barrientos

Archivo del Autor: Antonio Barrientos

Búsqueda inteligente de víctimas con robots

¿Puede un robot buscar víctimas en un entorno hostil como lo haría un humano?

Uno de los últimos avances desarrollados en el marco del proyecto TASAR, que tiene como objetivo el desarrollo de flotas de robots de distintas características para tareas de búsqueda y rescate de forma colaborativa, ha sido el TFM de Jorge F. García-Samartín –actualmente integrado en el grupo como estudiante de doctorado–, codirigido por Christyan Cruz Ulloa y Antonio Barrientos.

Haciendo uso de ARTU-R, un robot cuadrúpedo de elevada velocidad y alta capacidad de movimiento en entornos desestructurados, como lo son los escenarios posdesastre, se ha desarrollado un algoritmo inteligente de búsqueda de víctimas en regiones desconocidas, como pueden ser una casa en la que se ha producido una catástrofe natural o un laboratorio en que ha sufrido, por ejemplo, un escape de gases. La idea del mismo es conseguir, al llegar al entorno donde se necesita la intervención de los equipos de rescate, que ARTU-R lo recorra de forma similar a como lo haría un operador humano, priorizando la exploración de aquellas regiones en las que es más probable la presencia de una víctima.

Para ello, ARTU-R mapea el entorno haciendo uso de sus sensores láser y lídar. En paralelo, el sistema procesa las imágenes capturadas por medio de la cámara frontal, identificando en ella diversos objetos cotidianos (mesas, sillas, plantas…), y devuelve un valor que indica la probabilidad de que un humano se encuentre en un punto cercano. La información de ambas vías se fusiona y permite determinar el siguiente punto al que se dirigirá ARTU-R para continuar con su exploración.

Los diversos ensayos realizados, tanto en escenarios ad-hoc como reales (la planta baja del edificio del Centro de Automática y Robótica) muestran que el algoritmo alcanza velocidades de exploración similares a las mejores metodologías existentes en la literatura. En todas las pruebas, todas las víctimas fueron correctamente localizadas y en poco tiempo –lo que es fundamental en su supervivencia– lo que demuestra la validez del método y la riqueza que supone la colaboración humano-robot en tareas de búsqueda y rescate, puesto que permite alcanzar rendimientos similares –o incluso mejores– a los actuales minimizando considerablemente el riesgo de vidas humanas que estas actividades actualmente implican.

Un vídeo del sistema en funcionamiento puede verse en:

El pasado 25 de noviembre, el trabajo fue objeto del premio al mejor TFM en la séptima edición de los Premios Cátedra Ingeniero General D. Antonio Remón y Zarco del Valle. El galardón, una de las actividades de la cátedra UPM-CESEDEN, busca reconocer el trabajo realizado por profesores, investigadores y estudiantes en el ámbito de la defensa y la seguridad nacionales.

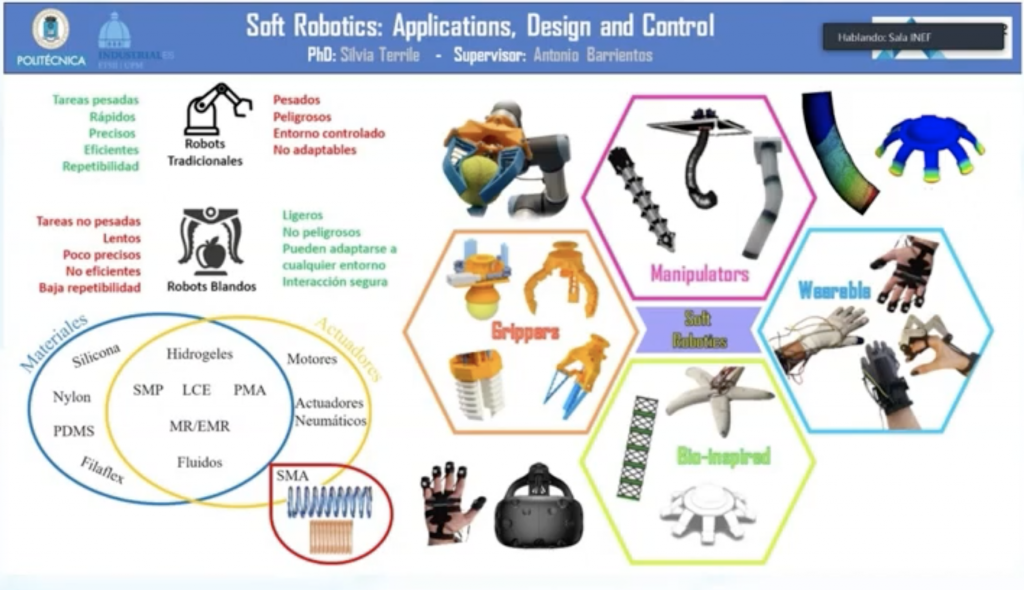

Avances en Robótica Blanda

La robótica blanda (Soft Robotics), es un área que ha emergido con mucha fuerza e interés por sus potenciales aplicaciones, a la vez de por los retos que suponen su desarrollo que implica la investigación en el uso de nuevos materiales para la estructura del robot, de actuadores y sensores “blandos” y el empleo de técnicas avanzadas de control, que precisan mayor complejidad por la dificultad del modelado de la estructura blanda , a la vez que simplicidad para poder ser embebidos en el propio robot (¿Cómo ablandar a un robot?)

¿Retos complicados? ¡Pues a por ello! En el Robcib comenzamos hace tiempo a trabajar en los diferentes aspectos implicados en la robótica blanda.

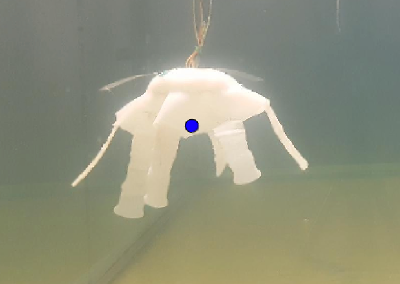

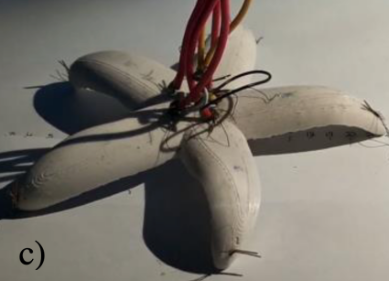

Inicialmente (2015) hicimos algunos robots caminantes de silicona con accionamiento neumático, primero con un control en cadena abierta y luego en cadena cerrada

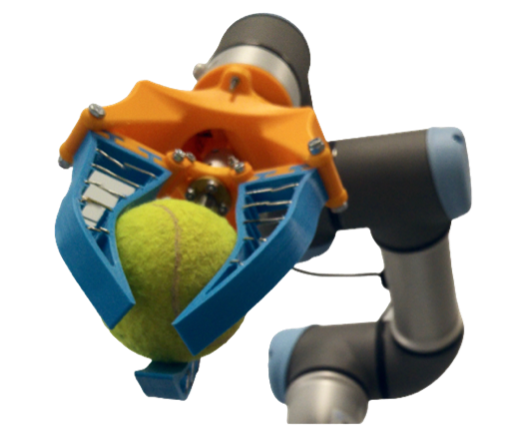

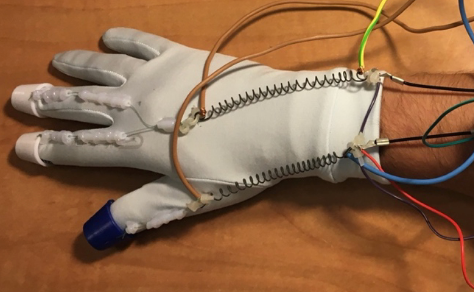

Mas adelante comenzamos a experimentar con las SMA (Aleaciones con memoria de forma) para hacer robots blandos de cables y también con motores convencionales, para mover diferentes tipos de robots, desde manipuladores hasta garras o exoesqueletos

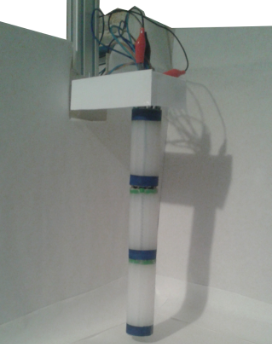

A continuación, se incluye una relación de desarrollos realizados en diferentes Trabajos de Fin de Titulación en los últimos años. Estos incluyen robots biomiométicos (medusas, estrellas de mar), guantes hápticos, exoesqueletos para rehabilitación de la mano, manipuladores formados por varios segmentos, etc.

La tesis de Silvia Terrile da una cobertura bastante amplia a la investigación en Robótica blanda, mostrando varias realizaciones prácticas en particular con SMA (si no estas por leerte la tesis, puedes ver un super-resumen en este video)

Nuestros últimos trabajos se orientan a los Manipuladores neumáticos (Trabajo de Adrian Rieker), los Sensores integrados en la propia estructura (Trabajo de Jaime Bravo) o los robots Origami (Trabajo de Victoria Goncalves)

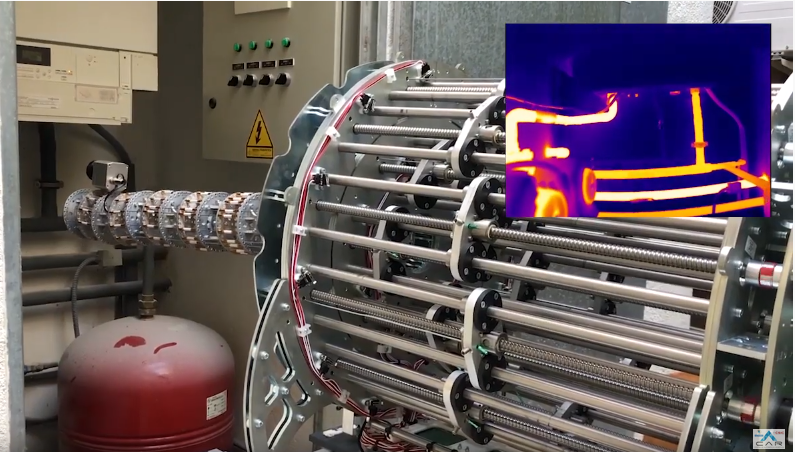

Localización de víctimas enterradas mediante imagen térmica

Ciertos desastres, naturales o provocados, originan el colapso de edificaciones con el consecuente enterramiento de personas.

Las brigadas de rescate tratan de localizar a las víctimas atrapadas entre escombros en el menor tiempo posible, pues el paso del tiempo disminuye las posibilidades de que las victimas sean encontradas con vida

Para ello se ayudan, entre otras cosas, de recursos técnicos, capturando información de tipo imagen en diferentes espectros (visual, térmico, etc.) , señales acústica y presencia de determinados gases.

En nuestro empeño de contribuir a estas misiones con el uso de robots, dentro del proyecto TASAR (Equipo de robots para misiones de búsqueda y rescate) , estamos trabajando en dotar a estos de determinados sensores y de algoritmos para que, con la información suministrada por estos, se localicen, de manera autónoma, las posibles víctimas enterradas parcial o totalmente.

En los trabajos realizados por Christyan, Guillermo y Guido (los podeis consultar aquí y aquí) , se utiliza la imagen térmica obtenida por una cámara térmica junto con las medidas de una cámara 3D infrarroja, ambas montada sobre nuestro robot Unitree A1, para construir mapas térmicos sobre los cuales, se identifican posibles victimas mediante redes neuronales

El trabajo de Guillermo Prieto (“Detección de víctimas mediante redes neuronales e imágenes térmicas”) , ha sido objeto de reconocimento por parte de la UPM-CESEDEN , que en la sexta edición de los premios “Cátedra Ingeniero General D. Antonio Remón y Zarco del Valle” le ha otorgado el premio al mejor Trabajo Fin de Grado para reconocer el trabajo realizado por profesores, investigadores y estudiantes de la UPM en temas tecnológicos relacionados con la defensa y la seguridad.

Simulador de robots con patas de tipo C

Un robot co patas de tipo C (CLEGS) tiene un modo de caminar que auna propiedades de la marcha con patas con la simplicidad de un solo actuador rotativo por cada una de ellas.

Hace unos años se hizo muy popular (al menos entre los foros robóticos) el robot RHEX desarrollado por varias universidades de EEUU con financiación del DARPA y finalmente trasvasado a Boston Dynamics.

En el ROBCIB tenemos nuestra propia versión: el CLHERO.

Dentro de los desarrollos que hemos realizado con él para conseguir su navegación autónoma, nos ha resultado imprescindible el poder utilizar las medidas de la Odometría dentro de los algoritmos de navegación. Debe tenerse en cuenta que la odometria de un robot con este tipo de patas, es muy diferente a la de un robot de ruedas diferenciales convencional.

Por ello, Jorge junto a Raúl, han tenido que desarrollar un simulador para robots con patas en forma de “C” en el entorno ROS+Gazebo y, casi seguro, que podemos confirmar que es el primero de estas características que puede usar cualquier desarrollador de forma abierta y gratuita.

Lo puedes ver aqui

y aquí

Este desarrollo se ha publicado en el volumen del ROS Book de agosto 2020 y esta accesible en github

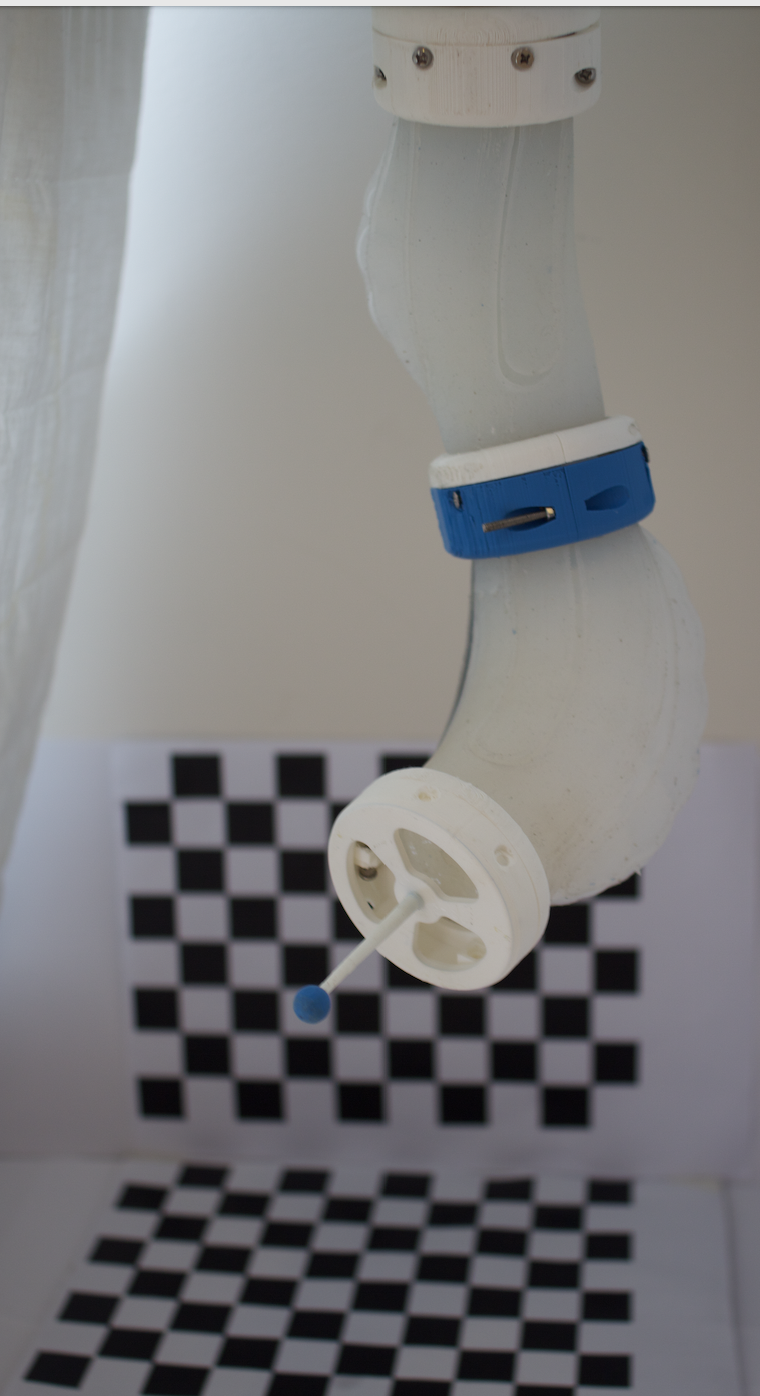

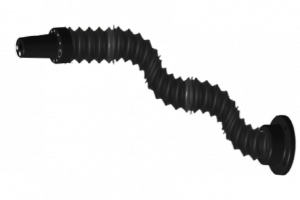

MACH-I . Un Robot como una trompa de elefante

La trompa de un elefante es su apendice diestro. Con una capidad de maniobra increible es capaz de introducrise por lugares confinados y manipular objetos de diferentes formas.

Hacer un robot similar a la trompa de un elefante es tarea de la Robótica Bioinspirada basada en elementos y actuadores blandos (“Soft Robotics”).

Aún lejos de igualar sus prestaciones, los robots manipuladores hiperredundantes pueden lograr capacidades de movilidad que, cuanto menos, recuerdan a la referida trompa.

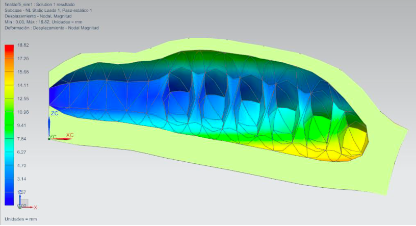

MACH I es el resultado de un Trabajo de fin de máster (de súper Ivan Rodríguez) realizado en el grupo de investigación de Robótica y Cibernética, dentro del proyecto del plan nacional PRIC (DPI2014-56985-R Protección robotizada de infraestructuras críticas). Entre los objetivos del mismo, se incluía el construir un robot hiper redundante funcional, adecuado para inspeccionar lugares muy confinados y realizar en ellos ciertas tareas de manipulación.

21 motores mueven, mediante cables, 7 segmentos conectados mediante juntas cardan. Al no tratarse de un robot serie, los movimentos de los motores deben estar sincronizados con mucha precisión. Tirar de un cable implica soltar de otros en la medida adecuada.

https://youtu.be/XbLFA1m5bRo

Tras la construcción del robot , el uso de la teleoperación y de la realidad aumentada aportada por Juan Jesús y Andrés , junto con algoritmos de cálculo de la cinematica inversa para robots hiper-redundantes y planificación de trayectorias ideados por Andrés, permiten sacar todo el partido al robot.

En la actualidad seguimos mejorando las prestaciones (David Marquez) e ideando nuevas soluciones constructivas (Elena Muñoz y Jaime Bravo)

Tratamiento y visualizacion de datos urbanos obtenidos por un enjambre de drones

¿Ya visteis el episodio 3×06 de Black Mirror ("Odio Nacional") donde un enjambre de Autonomous Drone Insects (ADI) hacen de las suyas?

|

|

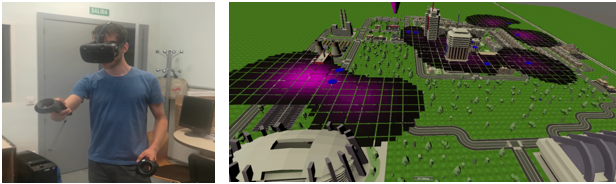

No temais, "aún" es ciencia ficción, pero en el Robcib llevamos tiempo trabajando en como gestionar estos enjambres y la información que podrían capturar sobre el estado de la ciudad. Monitorización de tráfico, gases, partículas en supensión, concentraciones de personas, acumulación de basuras,… todos estos datos podrian ser recogidos por montones de drones con comportamientos muy simples (acudir al lugar de mayor concetración de polen, alejarse de los puntos mas calientes, seguir objetos en movimiento de un color determinado,..). Cada uno de ellos daría poca información, pero la suma de lo que dan todos, adecuadamente tratada y visualizada, permitiría monitorizar el estado de la ciudad de una manera detallada.

No existen aún esos ADI de Black Mirror. Ni siquiera drones con el tamaño y autonomía de vuelo necesarios. Pero podemos construir una ciudad virtual , con sus horarios y rutinas diarias, clima, tráfico, etc. y hacer volar sobre ella un enjambre virtual que capta y transmite información básica.

Eso es SWARM CITY (la ciudad enjambre) sobre la que trabajan varios de los TFG, TFM y tesis del Robcib

Javier Real, en concreto, ha presentado su TFG "Tratamiento y visualización de datos urbanos obtenidos por un enjambre de drones" en el que se desarrollan los algoritmos para agrupar la abundante información procedente de todos los drones a lo largo del tiempo, sintetizarla (mediante Procesos Gaussianos), descubrir aquellas situaciones que pueden ser de especial interés para el control de la ciudad (mediante Redes Neuronales) y localizarlas en el mapa de esta y mostrar todo ello al usuario mediante un Entorno inmersivo 3D de Realidad Virtual.

SISTEMA DE ADIESTRAMIENTO EN TAREAS DE ENSAMBLADO MEDIANTE REALIDAD VIRTUAL Y MINERÍA DE PROCESOS

Elena Crespo ha finalizado su TFG titulado "Sistema de Adiestramieto en Tareas de Ensamblado Mediante Realidad Virtual y Minería de Procesos

|

|

En el se da una efeciente solución al problema de la gestión y transmisión del conocimiento relativo a las labores de ensamblado

Imaginemos una cadena de montaje en la que operadores con experiencia realizan de manera eficiente el ensamblado de conjuntos a partir de piezas mas simples u otros subconjuntos. Cada uno de estos operadores ha llegado a optimizar la secuencia en la que efectúa el montaje en base a muchas horas de trabajo en la línea.

Si un nuevo trabajador se incorpora a la línea debe ser adiestrado por los antiguos, cada uno con sus propias preferencias, consumiendo tiempo de ambos y relentizando la cadena de montaje.

Además, si alguno de los trabajadores expertos dejase ese puesrto de trabajo, se llevaría con él una experiencia que sería dificil de extraer y documentar

El trabajo desarrollado por Elena aborda esta situación mediante el uso de 2 herramientas: La Minería de Procesos y la Realidad Virtual

En concreto: los trabajadores expertos transfieren su experiencia a un sistema informático de manera automática. Para ello realizan sus tareas sobre un sistema de Realidad Virtual (hacerlo con el sistema real implicaría la captación de sus acciones mediante visión por computador, por ejemplo, y una interpretación de las acciones mediante alguna técnica de IA. Ambos problemas son complejos y pueden ser obviados con el uso de la RV).

El sistema registra las acciones que realizan los operarios expertos para, mediante técnicas de Minería de Procesos, inferir la secuencia de acciones y optimizar estas .

Tras ello, el conocimiento del experto adquirido en base a la experiencia, es sintetizado, optimizado y transferido al sistema. Esta listo entonces para ser usado en el entrenamiento del operador aprendiz.

Este hace de nuevo uso de la Realidad Virtual para entrenarse en la tarea. El sistema le da para ello diferentes niveles de ayuda, que van desde guiarle paso a paso hasta solo monitorizarle e indicarle los posibles errores.

El sistema ha sido evaluado con 64 experimentos tanto mediante medidas objetivas para medir su eficacia, como con test como el NASA TLX para evaluar la carga mental del trabajador aprendiz con este tipo de sistemas.

En estos vídeos podeis ver ambas fases, la captación del conocimiento del operario experto y la guia en el proceso de aprendizaje del operador aprendiz.

Un resumen de su trabajo se puede leer en http://oa.upm.es/49247/

Y en breve estará accesible la memoria de su trabajo y esperamos algo mas…..

Elena ha obtenido un 9,9 en su TFG, para nosotros tiene la MH

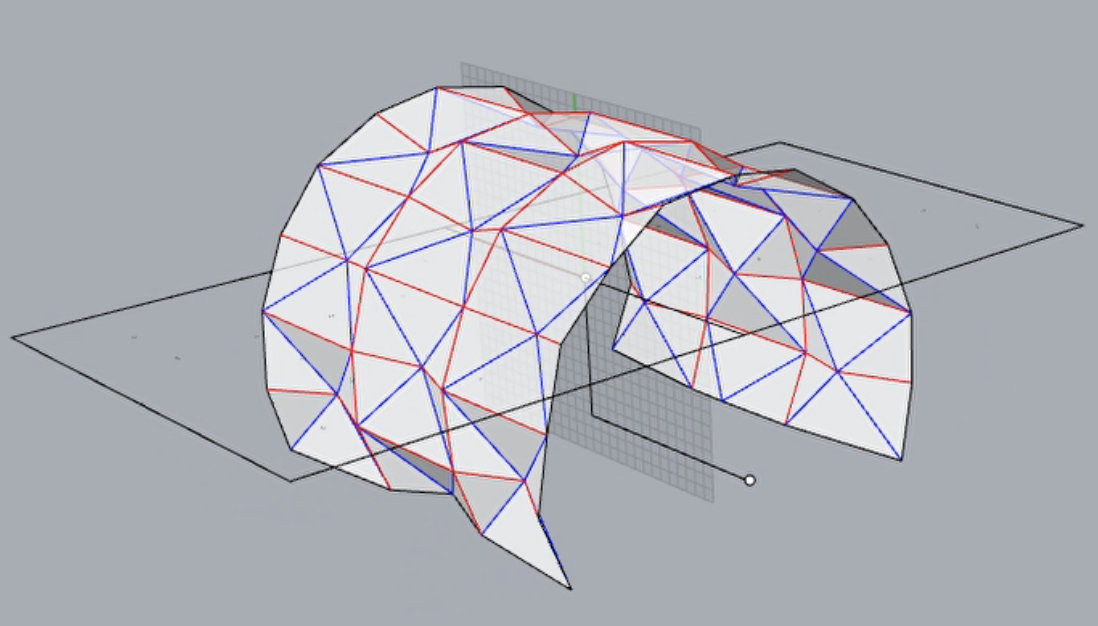

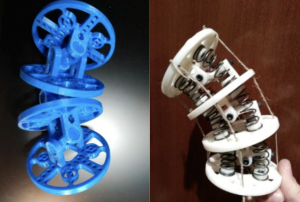

A soft and continuum manipulator robot

The concept of degree-of-freedom (DOF) is very important in all types of robots. It is the number of movements or independent parameters that define the pose of a robot. The word redundant is commonly used to mean “exceeding what is necessary or normal”. Robotic manipulators which have more independent DOFs than are required to perform a particular task are called hyper-redundant robots.

Some advantages of hyper-redundant robots against conventional ones are the fault tolerance in some of their joints, better skills to perform in complex environments and greater mechanical and kinematic capacities (such as lower energy consumption, greater transmissibility of force, joint range availability, dexterity or rigidity). In fact, there are a large number of applications for which they can be very useful such as service for underground tanks, supervision in nuclear core reactors, support in surgical systems or as an accessory in aeronautics and space exploration.

However, although hyper-redundant robots have been studied for more than three decades, its use is mostly limited to the experimental field. This is due to two main reasons. First, because a high number of degrees of freedom means a high cost of design and production. And secondly, because classical kinematic modeling techniques have not been particularly efficient or have not been adapted to the needs of hyper-redundant robots. This is why we have developed a novel algorithm called Natural-CCD to solve the kinematics of this robots in an efficient and precise way. Its name comes as a result of producing end-effector movements that are frequently found in nature such as the Fibonacci spiral.

In the context of hyper-redundant robots, two new concepts arise: Continuum robots and Soft robots. Continuum robots are continuously curving manipulators with an infinite number of virtual DOFs, much like the arm of an octopus. On the other hand, this kind of robots are closely related to another field called Soft Robotics. This robots are bio-inspired and try to make all of their components soft and flexible with the intention to move in a safe and versatile way. Currently, several concepts for soft and continuum manipulator robots are being designed and constructed. Its purpose is to be attached to a mobile robot and controlled by our new bio-inspired algorithms, being able to perform in activities such as supervising agriculture or detecting anomalies in critical infrastructures.

Different construction options are presently under evaluation

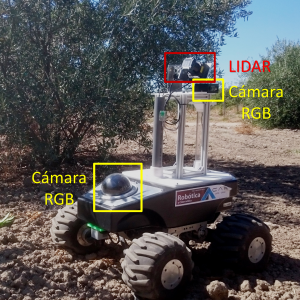

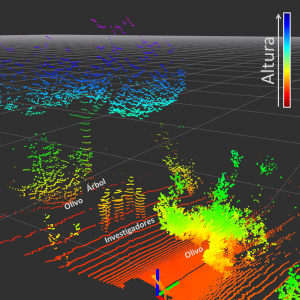

Estimación de la densidad foliar del olivo

|

Esta semana se ha iniciado un trabajo de cooperación con nuestos compañeros expertos en la gestión del olivar de la Escuela Técnica Superior de Ingeniería Agronómica, Alimentaria y de Biosistemas de la UPM . En él, haciendo uso de nuestros UGV’s (Unnamed Ground Vehicles) se pretende la reconstrucción tridimensional de olivos y así determinar la influencia de la densidad de su follaje en la cantidad de aceitunas que produce. |

|

Como un primer acercamiento, nos hemos trasladado a los campos de prácticas de Agrónomos para evaluar metodologías que puedan ser empleadas para el desarrollo de la tarea: emplear sensores LIDAR para determinar la presencia de elementos tales como hojas, ramas y frutos dentro del árbol y, posteriormente, usar dicha información para realizar la reconstrucción tridimensional del olivo; así como la implementación de técnicas de visión por computador para obtener información sobre la posición de las aceitunas en el árbol. La reconstrucción tridimensional se ha realizado con gran éxito, representando a los árboles como una nube de puntos que señala posiciones ocupadas en el espacio. Se ha encontrado que la configuración del sensor LIDAR diseñada para la práctica, permite obtener una gran densidad de puntos en las zonas medias del árbol debido a que en esta zona existe una menor dispersión de los haces de luz del sensor. |

|

|

También, mediante cámaras RGB se han recogido imágenes que permitirán evaluar la viabilidad de implementación de técnicas de visión por computador para diferenciar las aceitunas dentro del olivo. Este último objetivo presenta a priori grandes dificultades debido a la variabilidad de las condiciones ambientales en la toma de los datos, además de la similitud de características visuales entre hojas y aceitunas.

|

|

| El paso siguiente en este trabajo es realizar un post procesamiento de la información recogida con el fin de proponer estrategias que permitan mejorar la captura de los datos, y posteriormente, construir el modelo tridimensional que se ajuste a las necesidades de los investigadores en Ingeniería Agronómica. Pronto realizaremos una nueva entrada en el blog con los avances obtenidos en esta tarea. | |

Agro-robótica

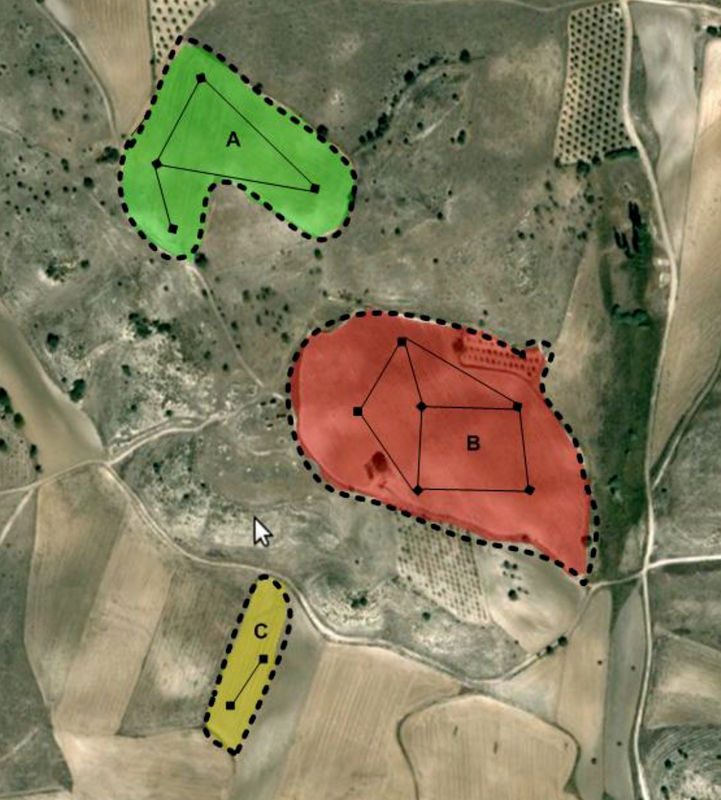

El término "Agrorobótica" está empezando a usar para hacer referencia a las disciplinas encaminadas al uso de sistemas robotizados en la agricultura. Estos incluyen maquinaria agrícola robotizada, robos móviles específicamente diseñados para tareas agrícolas en experiores o bajo cubierta, Robots aéreos o "Drones" (actualmente denominados RPAS)

Incluso, en algunas universidades europeas, están apareciendo cátedras en Agro-robótica, buscando dar una formación específica en esta disciplina

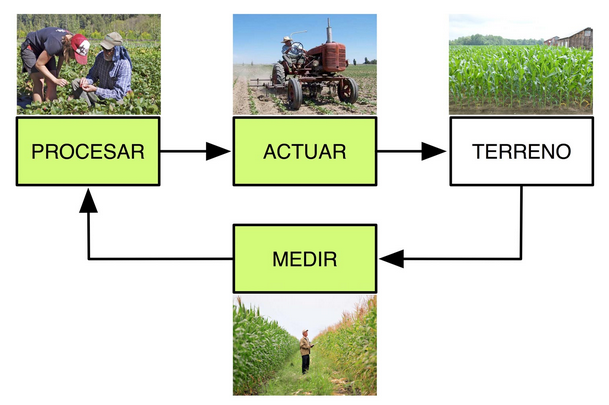

Desde el enfoque de la ingeniería de control , la Agro-robótica es una herramienta para aplicar el ciclo básico de control a la producción agrícola

En el Grupo de Robótica y Cibernética, trabajamos en Robótica Agrícola de exteriores e invernaderos desde hace 10 años, tanto con desarrollos basados en robótica aérea como en robótica móvil o combinando ambas

Estos son algunos ejemplos:

-

Heterogeneous Multi-Robot System for Mapping Environmental Variables of Greenhouses

-

Mini-UAV Based Sensory System for Measuring Environmental Variables in Greenhouses

Comentarios recientes