Estimación de la densidad foliar del olivo

|

Esta semana se ha iniciado un trabajo de cooperación con nuestos compañeros expertos en la gestión del olivar de la Escuela Técnica Superior de Ingeniería Agronómica, Alimentaria y de Biosistemas de la UPM . En él, haciendo uso de nuestros UGV’s (Unnamed Ground Vehicles) se pretende la reconstrucción tridimensional de olivos y así determinar la influencia de la densidad de su follaje en la cantidad de aceitunas que produce. |

|

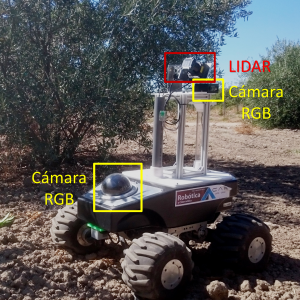

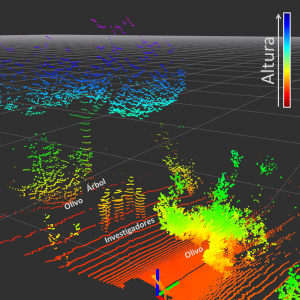

Como un primer acercamiento, nos hemos trasladado a los campos de prácticas de Agrónomos para evaluar metodologías que puedan ser empleadas para el desarrollo de la tarea: emplear sensores LIDAR para determinar la presencia de elementos tales como hojas, ramas y frutos dentro del árbol y, posteriormente, usar dicha información para realizar la reconstrucción tridimensional del olivo; así como la implementación de técnicas de visión por computador para obtener información sobre la posición de las aceitunas en el árbol. La reconstrucción tridimensional se ha realizado con gran éxito, representando a los árboles como una nube de puntos que señala posiciones ocupadas en el espacio. Se ha encontrado que la configuración del sensor LIDAR diseñada para la práctica, permite obtener una gran densidad de puntos en las zonas medias del árbol debido a que en esta zona existe una menor dispersión de los haces de luz del sensor. |

|

|

También, mediante cámaras RGB se han recogido imágenes que permitirán evaluar la viabilidad de implementación de técnicas de visión por computador para diferenciar las aceitunas dentro del olivo. Este último objetivo presenta a priori grandes dificultades debido a la variabilidad de las condiciones ambientales en la toma de los datos, además de la similitud de características visuales entre hojas y aceitunas.

|

|

| El paso siguiente en este trabajo es realizar un post procesamiento de la información recogida con el fin de proponer estrategias que permitan mejorar la captura de los datos, y posteriormente, construir el modelo tridimensional que se ajuste a las necesidades de los investigadores en Ingeniería Agronómica. Pronto realizaremos una nueva entrada en el blog con los avances obtenidos en esta tarea. | |

Landing on UGV

In our department we have been investigating in the last years how to deploy and use Unmanned Ground Vehicles (UGVs) in disaster scenarios, in which a human being, searching for survivors, might be at risk [1]. Frequently, the orography is complex (take as example a city after an earthquake), there are obstacles on the terrain or an aerial point of view is required. In those cases an Unmanned Aerial Vehicle (UAV) is probably needed, although its lack of range, endurance and payload capability are important drawbacks.

This is why teams of heterogeneous robots (a UGV and a UAV) might be a suitable solution [2], taking advantage of the properties of both robots. To improve the endurance of the UAV, the UGV can carry it and supply energy, whereas the UAV takes-off to overcome terrain obstacles and to provide a point of view from above.

One of our degree student coworkers, Pablo Rodriguez Palafox, has been working on developing an autonomous system to take-off from the UGV, track and follow it, and finally land on it. His work was based on previous investigations carried out also in our department [3].He presented his work as Bachelor Thesis. His work is a first stage to develop a more complex and autonomous system, that our group will use not only in disaster scenarios, but also in other tasks we are working on, such as in environmental variables monitoring in greenhouses [4].

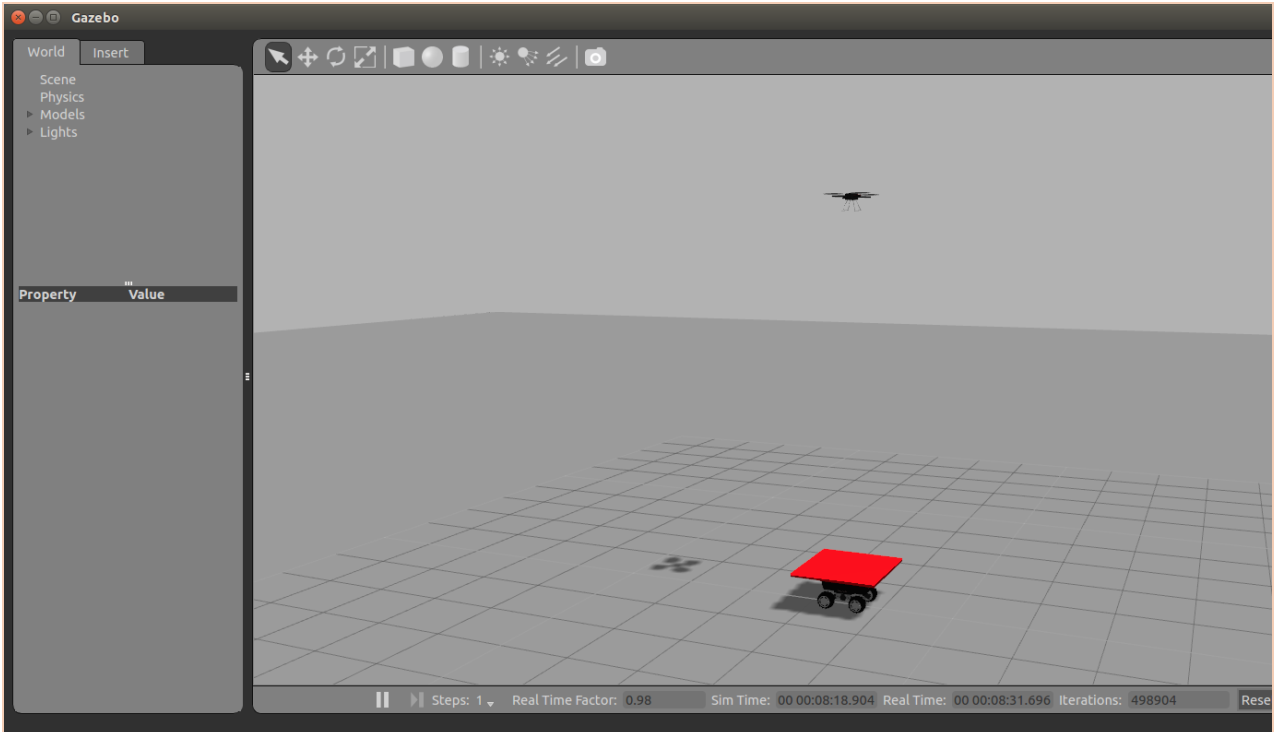

He used an AR. Drone 2.0 as UAV and a Robotnik Summit XL as UGV, on which he placed a red landing platform. Using Open CV libraries, we was able to detect that red platform and locate its centroid. To control the following and landing process, he used firstly an adaptive PID controller, and afterwards he improved it using a Kalman filter to predict the future position of the UGV. He also included a recobery mode, in which if the quadcopter fails to land or loses the platform, flies up and tries to locate again the UGV.

The algorithms were tested in Gazebo and finally in the real platforms. He achieved remarkable results, with a very low failure rate.

As future lines of development, we consider using a more advanced UAV available in the department, such as the AscTec Pelican, equipped with a camera with better resolution. We will be then able to use different visual markers for the landing platform, in order to achieve a more accurate relative positioning.

This video shows the results of the test carried out:

[1] – Murphy, R. R. (2014). Disaster robotics. MIT press.

[2] – Balakirsky, S., Carpin, S., Kleiner, A., Lewis, M., Visser, A., Wang, J., & Ziparo, V. A. (2007). Towards heterogeneous robot teams for disaster mitigation: Results and performance metrics from robocup rescue. Journal of Field Robotics, 24(11‐12), 943-967.

[3] – M. Garzon I. Baira and A. Barrientos. Detecting, Localizing and Following Dynamic Objects with a Mini-UAV. RoboCity16 Open Conference on Future Trends in Robotics, May 2016. III, 2.

[4] – Roldán, J. J., Garcia-Aunon, P., Garzón, M., de León, J., del Cerro, J., & Barrientos, A. (2016). Heterogeneous Multi-Robot System for Mapping Environmental Variables of Greenhouses. Sensors, 16(7), 1018.

Comentarios recientes