Inicio » 2016

Archivos anuales: 2016

Robótica en invernaderos

Una de nuestras líneas de investigación es la utilización de robots para la monitorización ambiental de los invernaderos. Nuestro objetivo es desarrollar un sistema formado por varios robots terrestres y aéreos capaz de medir de forma continuada variables como la temperatura, la humedad, la iluminación o la concentración de CO2. Este sistema ha de ser robusto, puesto que debe cubrir todo el invernadero con una cierta periodicidad y operar 24 horas al día y 365 días al año, pero también flexible, ya que debe ser capaz de reaccionar a las medidas anómalas y buscar el origen de las mismas. En esta entrada vamos a hacer un repaso cronológico a esta línea de investigación destacando los principales resultados que hemos alcanzado.

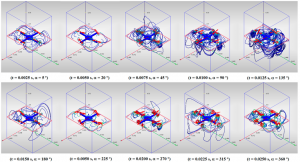

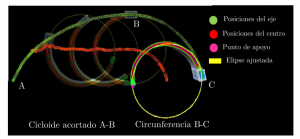

Esta línea comenzó en 2014 con el Trabajo Final de Máster titulado "Sistema sensorial embarcado en un mini-UAV para la medida de las variables ambientales de un invernadero" (desarrollado por el que os escribe y disponible aquí). Este trabajo exploraba la posibilidad de equipar un pequeño quadrotor con sensores de temperatura, humedad, iluminación y concentración de CO2 para tomar medidas en invernaderos. El trabajo se centró en dos objetivos: por un lado, desarrollar el sistema sensorial y, por el otro, plantear el sistema de navegación. En cuanto al primero, se determinó la posición idónea para los sensores, aquella donde la influencia de los flujos de aire de los rotores es mínima, mediante una serie de simulaciones CFD y experimentos con el quadrotor. En cuanto al segundo, se planteó un sistema de navegación autónoma basada en la visión de marcas en el suelo: una línea para seguir la ruta y unos cuadrados para detenerse y tomar medidas.

En febrero de 2015 publicamos en la revista Sensors la parte de este trabajo relativa al diseño del sistema sensorial y los experimentos realizados en un invernadero:

J.J. Roldán, G. Joossen, D. Sanz, J. del Cerro and A. Barrientos. “Mini-UAV Based Sensory System for Measuring Environmental Variables in Greenhouses”. Sensors, 15(2), 3334-3350. 2015. Artículo

Este trabajo tuvo una cierta repercusión en los medios y, entre otros sitios, apareció en RTVE, madri+d, sinc, El Economista o ABC.

La línea de investigación continuó durante el curso 2014-2015 con un Trabajo Final de Grado titulado "Sistema sensorial sobre un robot móvil para la medida de las propiedades del suelo de un invernadero" y desarrollado por Alberto Ruiz-Larrea Guillén. En este trabajo se empleaba un robot terrestre de mediano tamaño, en lugar del pequeño robot aéreo, con el objetivo de medir la temperatura y la humedad del suelo. Este trabajo sirvió para consolidar la idea de que un equipo de robots podía ser más eficiente que un solo robot en un invernadero, ya que cada robot puede realizar las tareas que se le dan mejor.

En los últimos meses de 2015 estuvimos en la conferencia ROBOT2015 en Lisboa presentando los resultados de este trabajo:

A. Ruiz-Larrea, J.J. Roldán, M. Garzón, J. del Cerro and A. Barrientos. "A UGV approach to measure the ground properties of greenhouses". ROBOT2015: Second Iberian Robotics Conference. 2015. Artículo

Y también participamos en la Noche de los Investigadores 2015 con un póster que resumía el estado de la línea de investigación:

Ya en 2016 dimos el salto de utilizar robots aéreos o terrestres por separado a emplear un equipo de robots. El planteamiento era aprovechar las cualidades de cada robot para que desempeñe las tareas que se le dan mejor. El UGV puede aprovechar su autonomía y robustez para recorrer el invernadero cargando con su compañero y tomando medidas, mientras que el UAV puede aprovechar su velocidad y agilidad para intervenir cuando su compañero encuentra obstáculos o surge la necesidad de medir a diferentes alturas. En el vídeo se puede ver la estrategia del equipo: primero el UGV es teleoperado para realizar un mapa del invernadero, luego este robot navega de forma autónoma tomando medidas y, cuando se detecta un obstáculo en el camino o una anomalía en las medidas, el UAV interviene para continuar con la monitorización.

En junio de 2016 publicamos en la revista Sensors estos últimos trabajos y unos experimentos realizados en un invernadero de prácticas de la E.T.S.I. Agrónomos de la Universidad Politécnica de Madrid:

J.J. Roldán, P. Garcia-Aunon, M. Garzón, J. de León, J del Cerro and A. Barrientos. “Heterogeneous Multi-Robot System for Mapping Environmental Variables of Greenhouses”. Sensors, 16(7), 1018. 2016. Artículo

Nuestros próximos pasos van a ir encaminados hacia el funcionamiento continuo del equipo en un invernadero productivo y la comparación de su rendimiento con el de otras alternativas como las redes de sensores. Por su parte, los principales retos a los que nos enfrentamos tienen que ver con la autonomía del sistema multi-robot y la navegación autónoma del robot aéreo en el invernadero.

About Juan Jesús Roldán Gómez

- Web |

- More Posts(1)

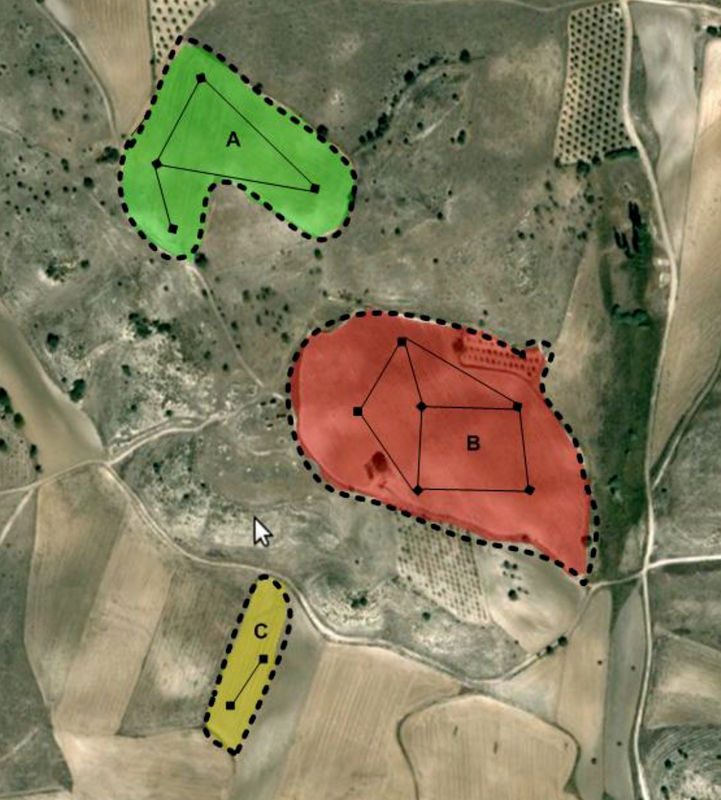

Estimación de la densidad foliar del olivo

|

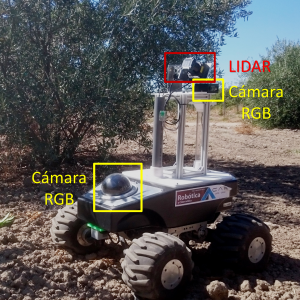

Esta semana se ha iniciado un trabajo de cooperación con nuestos compañeros expertos en la gestión del olivar de la Escuela Técnica Superior de Ingeniería Agronómica, Alimentaria y de Biosistemas de la UPM . En él, haciendo uso de nuestros UGV’s (Unnamed Ground Vehicles) se pretende la reconstrucción tridimensional de olivos y así determinar la influencia de la densidad de su follaje en la cantidad de aceitunas que produce. |

|

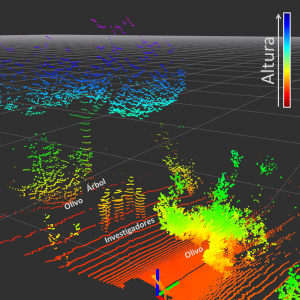

Como un primer acercamiento, nos hemos trasladado a los campos de prácticas de Agrónomos para evaluar metodologías que puedan ser empleadas para el desarrollo de la tarea: emplear sensores LIDAR para determinar la presencia de elementos tales como hojas, ramas y frutos dentro del árbol y, posteriormente, usar dicha información para realizar la reconstrucción tridimensional del olivo; así como la implementación de técnicas de visión por computador para obtener información sobre la posición de las aceitunas en el árbol. La reconstrucción tridimensional se ha realizado con gran éxito, representando a los árboles como una nube de puntos que señala posiciones ocupadas en el espacio. Se ha encontrado que la configuración del sensor LIDAR diseñada para la práctica, permite obtener una gran densidad de puntos en las zonas medias del árbol debido a que en esta zona existe una menor dispersión de los haces de luz del sensor. |

|

|

También, mediante cámaras RGB se han recogido imágenes que permitirán evaluar la viabilidad de implementación de técnicas de visión por computador para diferenciar las aceitunas dentro del olivo. Este último objetivo presenta a priori grandes dificultades debido a la variabilidad de las condiciones ambientales en la toma de los datos, además de la similitud de características visuales entre hojas y aceitunas.

|

|

| El paso siguiente en este trabajo es realizar un post procesamiento de la información recogida con el fin de proponer estrategias que permitan mejorar la captura de los datos, y posteriormente, construir el modelo tridimensional que se ajuste a las necesidades de los investigadores en Ingeniería Agronómica. Pronto realizaremos una nueva entrada en el blog con los avances obtenidos en esta tarea. | |

Landing on UGV

In our department we have been investigating in the last years how to deploy and use Unmanned Ground Vehicles (UGVs) in disaster scenarios, in which a human being, searching for survivors, might be at risk [1]. Frequently, the orography is complex (take as example a city after an earthquake), there are obstacles on the terrain or an aerial point of view is required. In those cases an Unmanned Aerial Vehicle (UAV) is probably needed, although its lack of range, endurance and payload capability are important drawbacks.

This is why teams of heterogeneous robots (a UGV and a UAV) might be a suitable solution [2], taking advantage of the properties of both robots. To improve the endurance of the UAV, the UGV can carry it and supply energy, whereas the UAV takes-off to overcome terrain obstacles and to provide a point of view from above.

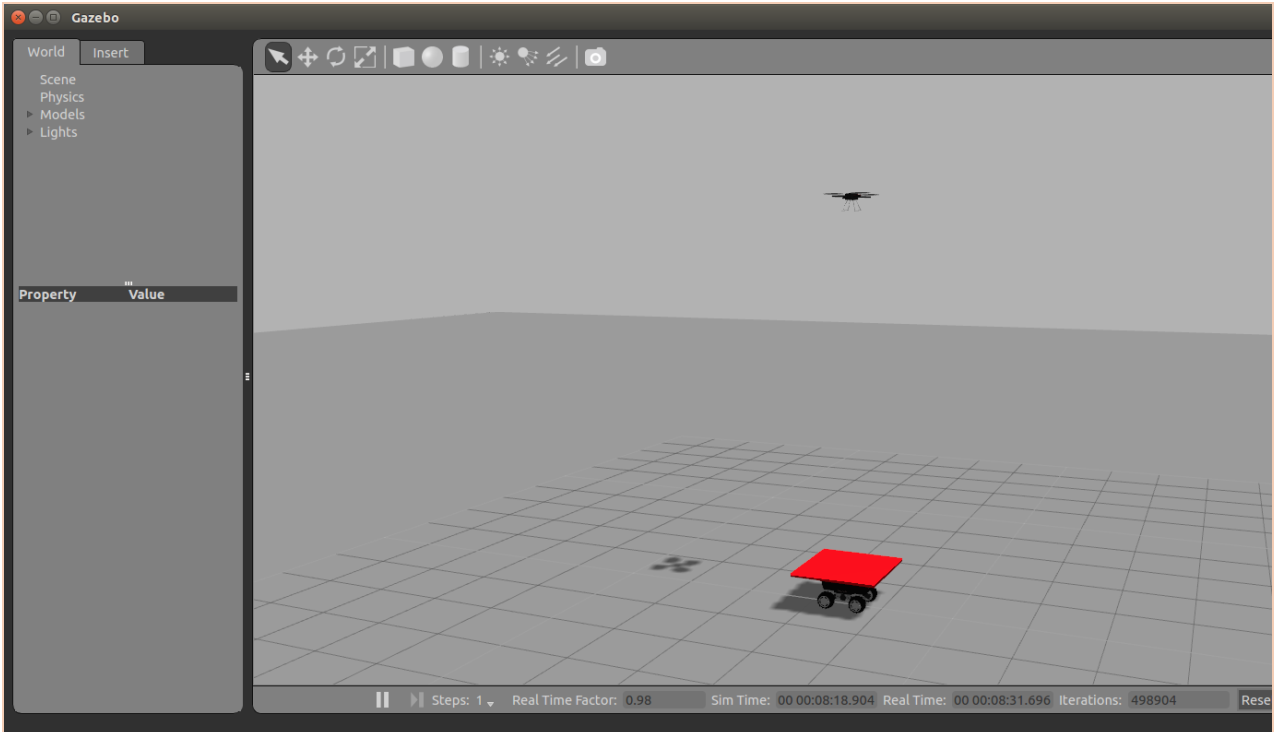

One of our degree student coworkers, Pablo Rodriguez Palafox, has been working on developing an autonomous system to take-off from the UGV, track and follow it, and finally land on it. His work was based on previous investigations carried out also in our department [3].He presented his work as Bachelor Thesis. His work is a first stage to develop a more complex and autonomous system, that our group will use not only in disaster scenarios, but also in other tasks we are working on, such as in environmental variables monitoring in greenhouses [4].

He used an AR. Drone 2.0 as UAV and a Robotnik Summit XL as UGV, on which he placed a red landing platform. Using Open CV libraries, we was able to detect that red platform and locate its centroid. To control the following and landing process, he used firstly an adaptive PID controller, and afterwards he improved it using a Kalman filter to predict the future position of the UGV. He also included a recobery mode, in which if the quadcopter fails to land or loses the platform, flies up and tries to locate again the UGV.

The algorithms were tested in Gazebo and finally in the real platforms. He achieved remarkable results, with a very low failure rate.

As future lines of development, we consider using a more advanced UAV available in the department, such as the AscTec Pelican, equipped with a camera with better resolution. We will be then able to use different visual markers for the landing platform, in order to achieve a more accurate relative positioning.

This video shows the results of the test carried out:

[1] – Murphy, R. R. (2014). Disaster robotics. MIT press.

[2] – Balakirsky, S., Carpin, S., Kleiner, A., Lewis, M., Visser, A., Wang, J., & Ziparo, V. A. (2007). Towards heterogeneous robot teams for disaster mitigation: Results and performance metrics from robocup rescue. Journal of Field Robotics, 24(11‐12), 943-967.

[3] – M. Garzon I. Baira and A. Barrientos. Detecting, Localizing and Following Dynamic Objects with a Mini-UAV. RoboCity16 Open Conference on Future Trends in Robotics, May 2016. III, 2.

[4] – Roldán, J. J., Garcia-Aunon, P., Garzón, M., de León, J., del Cerro, J., & Barrientos, A. (2016). Heterogeneous Multi-Robot System for Mapping Environmental Variables of Greenhouses. Sensors, 16(7), 1018.

About Jaime Del Cerro

Agro-robótica

El término "Agrorobótica" está empezando a usar para hacer referencia a las disciplinas encaminadas al uso de sistemas robotizados en la agricultura. Estos incluyen maquinaria agrícola robotizada, robos móviles específicamente diseñados para tareas agrícolas en experiores o bajo cubierta, Robots aéreos o "Drones" (actualmente denominados RPAS)

Incluso, en algunas universidades europeas, están apareciendo cátedras en Agro-robótica, buscando dar una formación específica en esta disciplina

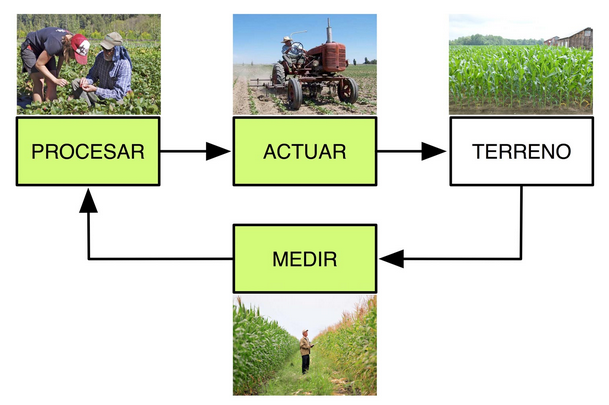

Desde el enfoque de la ingeniería de control , la Agro-robótica es una herramienta para aplicar el ciclo básico de control a la producción agrícola

En el Grupo de Robótica y Cibernética, trabajamos en Robótica Agrícola de exteriores e invernaderos desde hace 10 años, tanto con desarrollos basados en robótica aérea como en robótica móvil o combinando ambas

Estos son algunos ejemplos:

-

Heterogeneous Multi-Robot System for Mapping Environmental Variables of Greenhouses

-

Mini-UAV Based Sensory System for Measuring Environmental Variables in Greenhouses

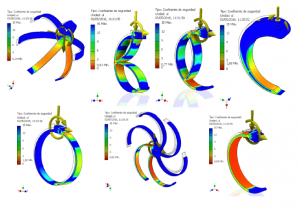

Hexápodo con patas “Clegs”

Nuestros trabajos en el desarrollo de robots hexápodos con Clegs siguen avanzando

En paralelo al estudio de esfuerzos en las diferentes geometrías de rueda y el análisis cinemático y dinámico , contrastado experimentalmente en el banco de pruebas, continuamos con la integración de los accionamientos bajo ROS y el mecanizado del chasis

Jesús Tordesillas ha trabajado a fondo este tema en su Trabajo fin de grado , donde se revisan aspectos relativos a los diferentes modos de marcha, el modelado cinemático y dinámico de las patas y la selección de la geometría y materiales de ésta según requisitos

Puedes encontrar mas información en el Archivo Digital de la UPM

Sistema posicionamiento en interiores

Ya casi tenemos terminado el sistema de posicionamiento indoor con un optitrack. Los últimos soportes están listos para ser instalados.

Pronto podremos volar varios drones a la vez en una pequeña habitación.

Comentarios recientes