Autor: Aitor Alcázar Fernández

Tutor: Nicolás Sáenz Lechón

Fecha de lectura: 25 de julio de 2019

Actualmente, las personas con discapacidades auditivas y del habla recurren al lenguaje de signos para comunicarse entre sí, pero es una actividad que únicamente se puede realizar de forma presencial y entre personas que conozcan dicha lengua.

Para poder establecer la comunicación con el resto de las personas, es necesario recurrir a un intermediario o traductor, que haga las veces de emisor y receptor entre ambos. Esto resulta poco práctico y, en la mayoría de las ocasiones, costoso.

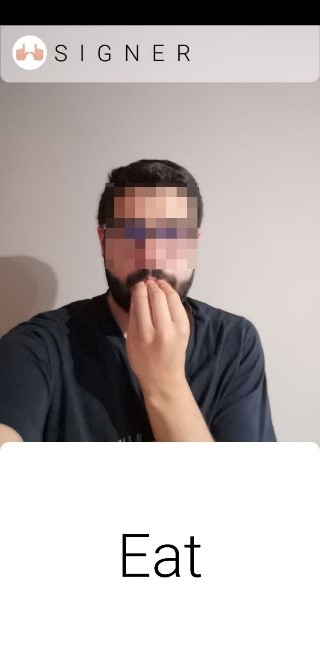

Se pretende con este proyecto desarrollar un sistema capaz de traducir en tiempo real la detección de signos aislados de la lengua de signos americana (American Sign Language – ASL). El software consistirá en una inteligencia artificial entrenada para monitorizar los movimientos de las manos de la persona situada frente a la cámara de un terminal móvil, y mostrar por pantalla el signo traducido en ese momento sobre la imagen captada.

Para ello, se han seguido dos líneas de investigación: con la primera, se ha desarrollado un traductor del alfabeto de la ASL recogiendo imágenes desde una cámara IP en un terminal móvil, procesando los datos y mostrando los resultados en el ordenador. La segunda línea de investigación ha llegado más lejos, pues se ha conseguido traducir cuatro signos dinámicos aislados, y desplegar el sistema creado en un terminal móvil Android, el cual ejecuta una aplicación autónoma de traducción de estos signos en tiempo real.

Gracias al desarrollo de este sistema, el grado de adaptación para las personas con dichas dificultades comunicativas puede lograr un crecimiento de gran magnitud en distintos aspectos: de manera social, dando pie a una comunicación más amplia y acercando la ASL a todos; cultural, educando a las personas que carecen de los conocimientos necesarios para comunicarse con ellos; y económica, pues supone abaratar los costes relacionados con traductores personales y cursos formativos.